- 1. 🚀 引言

- 1.1 🚀 人工智能的现状与发展趋势

- 1.2 📜 机器学习、深度学习和神经网络的基本概念

- 1.3 🏆 微服务架构在人工智能中的作用

- 2. 🔍 机器学习的演变与创新

- 2.1 🌟 机器学习的历史回顾

- 2.2 🧠传统机器学习算法的优势与不足

- 2.3 🚀 新兴机器学习算法的探索与应用

- 2.4 🎙️案例分析:机器学习在推荐系统中的应用

- 3. 🧠 深度学习:突破传统的限制

- 3.1 📜 深度学习的起源与发展

- 3.2 📷 卷积神经网络(CNN)的革新

- 3.3 📝 循环神经网络(RNN)与自然语言处理

- 3.4 🎨 生成对抗网络(GAN)的应用与挑战

- 3.5 🖼️ 案例分析:深度学习在图像识别中的应用

- 4. 🌐 神经网络的前沿进展

- 4.1 💡神经网络的基本结构与工作原理

- 4.2 🌟 多层感知机(MLP)的最新进展

- 4.3 🔍 自注意力机制与变换器模型(Transformers)

- 4.4 🚀 神经架构搜索(NAS)的未来趋势

- 4.5 🎙️ 案例分析:神经网络在语音识别中的应用

- 5. 🛠️ 微服务架构:构建灵活的AI系统

- 5.1 🏗️ 微服务的基本概念与架构设计

- 5.2 📊 微服务与传统单体应用的比较

- 5.3 🏆 微服务在AI系统中的优势

- 5.4 📦 容器化与服务编排技术

- 5.5 💡 案例分析:基于微服务的AI平台设计

- 6. 🌟 创新应用:将AI技术与微服务结合

- 6.1 ⚡ 实时数据处理与AI服务的集成

- 6.2 🔧 AI模型的版本控制与服务治理

- 6.3 ⚖️ 动态扩展与负载均衡

- 6.4 🤖 案例分析:微服务架构下的智能客服系统

- 7. 🔮 挑战与未来展望

- 7.1 🚧 AI技术在实际应用中的挑战

- 7.2 🔐 数据隐私与安全问题

- 7.3 🌐 AI伦理与社会影响

- 7.4 🔮 未来的技术趋势与发展方向

- 8. ✨ 结论

- 8.1 📚 总结全文的主要观点

- 8.2 🚀 对未来发展的预测与建议

个人主页:C_GUIQU

1. 🚀 引言

1.1 🚀 人工智能的现状与发展趋势

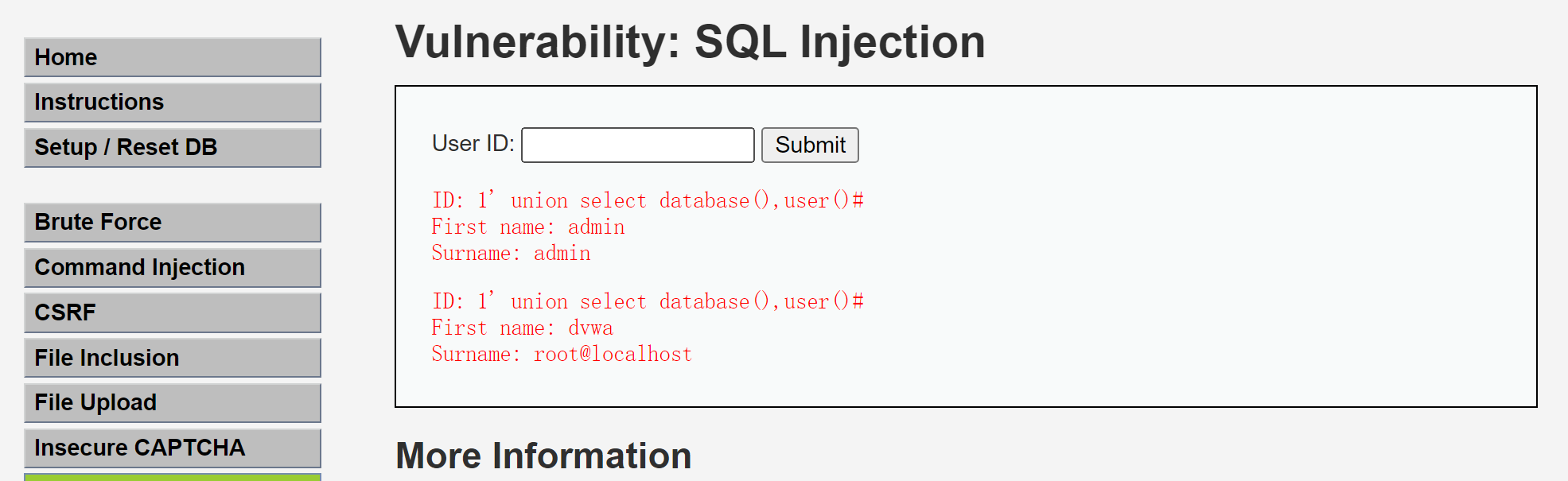

人工智能(AI)技术正快速发展并应用于各个行业。下面的代码示例展示了如何使用Python和TensorFlow创建一个简单的机器学习模型,这个模型可以作为AI技术的基础应用。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 创建一个简单的神经网络模型

model = Sequential([

Dense(64, activation='relu', input_shape=(10,)),

Dense(64, activation='relu'),

Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 打印模型摘要

model.summary()

解释:以上代码创建了一个简单的全连接神经网络模型,该模型包含两个隐藏层和一个输出层,用于二分类任务。Dense层用于添加全连接层,relu是激活函数,sigmoid用于输出层以进行二分类。

1.2 📜 机器学习、深度学习和神经网络的基本概念

机器学习、深度学习和神经网络是AI的核心组成部分。以下是每种技术的代码示例:

- 机器学习(ML):使用Scikit-learn进行线性回归。

from sklearn.linear_model import LinearRegression

import numpy as np

# 模拟数据

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([2, 4, 6, 8, 10])

# 创建并训练模型

model = LinearRegression()

model.fit(X, y)

# 进行预测

predictions = model.predict(np.array([[6]]))

print(predictions)

解释:这段代码展示了如何使用Scikit-learn进行线性回归。它创建了一个模型,训练它,并对新数据进行预测。

- 深度学习(DL):使用TensorFlow进行深度神经网络训练。

import tensorflow as tf

# 模型定义

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu', input_shape=(784,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 模型训练

# (这里应加载训练数据,示例中省略)

# model.fit(train_data, train_labels, epochs=5)

解释:这段代码定义了一个深度神经网络模型,适用于分类任务。Dense层用于定义全连接层,softmax用于多分类问题的输出层。

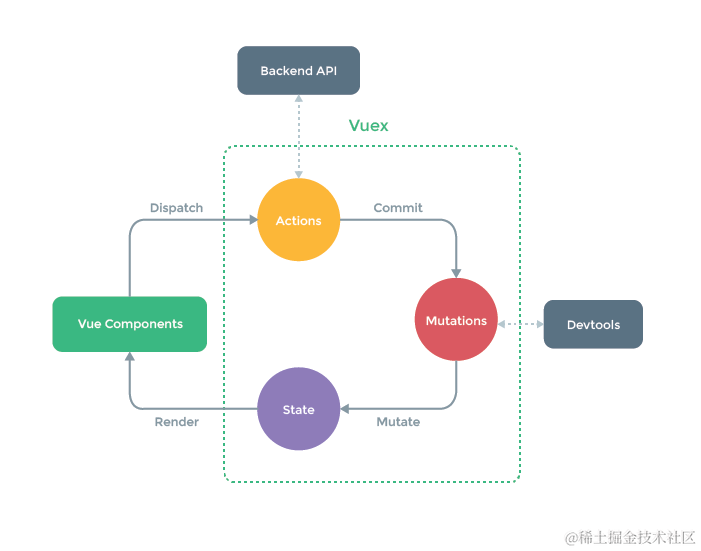

1.3 🏆 微服务架构在人工智能中的作用

微服务架构将应用拆分成独立的服务,每个服务可独立部署。以下是使用Docker部署微服务的示例代码:

# Dockerfile 示例

FROM python:3.8-slim

# 设置工作目录

WORKDIR /app

# 复制项目文件

COPY . /app

# 安装依赖

RUN pip install -r requirements.txt

# 设置环境变量

ENV FLASK_APP=app.py

# 启动应用

CMD ["flask", "run", "--host=0.0.0.0"]

解释:这段Dockerfile代码示例展示了如何使用Docker来部署一个Python微服务应用。它定义了基础镜像,设置工作目录,复制文件,并安装依赖。

2. 🔍 机器学习的演变与创新

2.1 🌟 机器学习的历史回顾

机器学习的历史包括从最早的算法到现代复杂模型的演变。下面是一个使用Scikit-learn实现决策树的代码示例:

from sklearn.tree import DecisionTreeClassifier

import numpy as np

# 模拟数据

X = np.array([[0], [1], [2], [3], [4]])

y = np.array([0, 0, 1, 1, 1])

# 创建并训练决策树模型

model = DecisionTreeClassifier()

model.fit(X, y)

# 进行预测

predictions = model.predict(np.array([[2.5]]))

print(predictions)

解释:以上代码演示了如何使用决策树分类器进行训练和预测。它创建了一个决策树模型,用于根据输入数据进行分类。

2.2 🧠传统机器学习算法的优势与不足

传统算法如支持向量机(SVM)和随机森林(RF)在许多场景中表现良好。以下是使用Scikit-learn实现随机森林的代码示例:

from sklearn.ensemble import RandomForestClassifier

import numpy as np

# 模拟数据

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 1, 0, 1, 0])

# 创建并训练随机森林模型

model = RandomForestClassifier(n_estimators=10)

model.fit(X, y)

# 进行预测

predictions = model.predict(np.array([[2.5]]))

print(predictions)

解释:这段代码展示了如何使用随机森林分类器进行训练和预测。它创建了一个随机森林模型,并对新数据进行预测。

2.3 🚀 新兴机器学习算法的探索与应用

- XGBoost:高效的梯度提升算法,适用于大规模数据。

import xgboost as xgb

import numpy as np

# 模拟数据

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 1, 0, 1, 0])

# 创建并训练XGBoost模型

model = xgb.XGBClassifier()

model.fit(X, y)

# 进行预测

predictions = model.predict(np.array([[2.5]]))

print(predictions)

解释:这段代码演示了如何使用XGBoost进行分类任务。它创建了一个XGBoost分类器,进行模型训练和预测。

- LightGBM:高效的梯度提升框架。

import lightgbm as lgb

import numpy as np

# 模拟数据

X = np.array([[1], [2], [3], [4], [5]])

y = np.array([0, 1, 0, 1, 0])

# 创建并训练LightGBM模型

model = lgb.LGBMClassifier()

model.fit(X, y)

# 进行预测

predictions = model.predict(np.array([[2.5]]))

print(predictions)

解释:这段代码演示了如何使用LightGBM进行分类任务。它创建了一个LightGBM分类器,用于训练和预测。

2.4 🎙️案例分析:机器学习在推荐系统中的应用

推荐系统使用机器学习算法提供个性化推荐。以下是实现协同过滤的简单代码示例:

import pandas as pd

from sklearn.neighbors import NearestNeighbors

# 模拟数据

data = pd.DataFrame({

'user': [1, 1, 2, 2, 3],

'item': [1, 2, 1, 3, 2],

'rating': [5, 3, 4, 2, 5]

})

# 创建协同过滤模型

model = NearestNeighbors(n_neighbors=2)

model.fit(data[['user', 'item']])

# 进行推荐

distances, indices = model.kneighbors([[1, 1]])

print(indices)

解释:这段代码演示了如何使用最近邻算法实现简单的协同过滤推荐系统。它使用NearestNeighbors模型进行用户和项目的推荐。

3. 🧠 深度学习:突破传统的限制

3.1 📜 深度学习的起源与发展

深度学习的关键技术进展包括反向传播算法。以下是一个反向传播训练神经网络的代码示例:

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 模型定义

model = Sequential([

Dense(64, activation='relu', input_shape=(784,)),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 模型训练

# (这里应加载训练数据,示例中省略)

# model.fit(train_data, train_labels, epochs=5)

解释:这段代码展示了如何使用TensorFlow进行深度学习模型的定义和训练,利用反向传播算法优化模型权重。

3.2 📷 卷积神经网络(CNN)的革新

卷积

神经网络在图像处理中的成功可以通过以下代码示例展示:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

# 创建CNN模型

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

MaxPooling2D((2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

解释:这段代码定义了一个卷积神经网络模型,包括卷积层、池化层、展平层和全连接层,适用于图像分类任务。

3.3 📝 循环神经网络(RNN)与自然语言处理

循环神经网络及其变体在处理序列数据方面表现出色。以下是使用LSTM进行文本生成的代码示例:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 创建LSTM模型

model = Sequential([

LSTM(128, input_shape=(None, 50)),

Dense(50, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy')

解释:这段代码定义了一个LSTM网络,用于处理序列数据。LSTM层可以捕捉序列中的长期依赖关系,适用于文本生成等任务。

3.4 🎨 生成对抗网络(GAN)的应用与挑战

生成对抗网络通过对抗训练生成逼真的数据。以下是一个简单GAN的代码示例:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 生成器模型

generator = Sequential([

Dense(128, activation='relu', input_dim=100),

Dense(784, activation='sigmoid')

])

# 判别器模型

discriminator = Sequential([

Dense(128, activation='relu', input_dim=784),

Dense(1, activation='sigmoid')

])

# 编译判别器

discriminator.compile(optimizer='adam', loss='binary_crossentropy')

# GAN模型

discriminator.trainable = False

gan = Sequential([generator, discriminator])

gan.compile(optimizer='adam', loss='binary_crossentropy')

解释:以上代码定义了一个简单的GAN模型,包括生成器和判别器。生成器生成数据,判别器判断数据的真实性,GAN通过对抗训练改进生成器的能力。

3.5 🖼️ 案例分析:深度学习在图像识别中的应用

深度学习在图像识别中具有广泛应用。以下是一个使用预训练模型进行图像分类的代码示例:

from tensorflow.keras.applications import VGG16

from tensorflow.keras.preprocessing import image

from tensorflow.keras.applications.vgg16 import preprocess_input, decode_predictions

import numpy as np

# 加载预训练模型

model = VGG16(weights='imagenet')

# 加载和预处理图像

img_path = 'path_to_image.jpg'

img = image.load_img(img_path, target_size=(224, 224))

img_array = image.img_to_array(img)

img_array = np.expand_dims(img_array, axis=0)

img_array = preprocess_input(img_array)

# 进行预测

predictions = model.predict(img_array)

decoded_predictions = decode_predictions(predictions, top=3)[0]

print(decoded_predictions)

解释:这段代码展示了如何使用预训练的VGG16模型进行图像分类。它加载图像,预处理并通过模型进行预测,然后解码预测结果。

4. 🌐 神经网络的前沿进展

4.1 💡神经网络的基本结构与工作原理

神经网络由输入层、隐藏层和输出层组成。以下是创建基本神经网络的代码示例:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 创建神经网络模型

model = Sequential([

Dense(32, activation='relu', input_shape=(10,)),

Dense(32, activation='relu'),

Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

解释:这段代码定义了一个简单的神经网络模型,包括两个隐藏层和一个输出层,适用于二分类任务。

4.2 🌟 多层感知机(MLP)的最新进展

多层感知机(MLP)在处理任务中得到改进。以下是使用ReLU和Dropout技术的代码示例:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Dropout

# 创建改进的MLP模型

model = Sequential([

Dense(128, activation='relu', input_shape=(784,)),

Dropout(0.5),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

解释:这段代码定义了一个MLP模型,使用了ReLU激活函数和Dropout技术来防止过拟合。

4.3 🔍 自注意力机制与变换器模型(Transformers)

变换器模型通过自注意力机制处理序列数据。以下是使用TensorFlow创建一个简单变换器模型的代码示例:

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, LayerNormalization, MultiHeadAttention

# 定义变换器模型

inputs = Input(shape=(None, 64))

x = MultiHeadAttention(num_heads=2, key_dim=64)(inputs, inputs)

x = LayerNormalization()(x)

x = Dense(64, activation='relu')(x)

outputs = Dense(10, activation='softmax')(x)

model = tf.keras.Model(inputs=inputs, outputs=outputs)

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

解释:这段代码定义了一个简单的变换器模型,包括自注意力层和全连接层,用于处理序列数据。

4.4 🚀 神经架构搜索(NAS)的未来趋势

神经架构搜索(NAS)通过自动化设计神经网络架构。以下是一个简单的NAS示例代码:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

# 定义基础模型

def create_model(layers):

model = Sequential()

model.add(Dense(64, activation='relu', input_shape=(784,)))

for _ in range(layers):

model.add(Dense(64, activation='relu'))

model.add(Dense(10, activation='softmax'))

return model

# 创建和编译模型

model = create_model(3)

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

解释:这段代码演示了如何创建一个具有可变隐藏层数量的神经网络模型。通过调整层数,进行模型的优化和实验。

4.5 🎙️ 案例分析:神经网络在语音识别中的应用

神经网络在语音识别中的应用可以通过以下代码示例展示:

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, LSTM

# 创建语音识别模型

inputs = Input(shape=(None, 13)) # 假设每帧13个特征

x = LSTM(128, return_sequences=True)(inputs)

x = LSTM(64)(x)

outputs = Dense(10, activation='softmax')(x)

model = tf.keras.Model(inputs=inputs, outputs=outputs)

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

解释:这段代码展示了如何使用LSTM层创建一个语音识别模型,适用于处理时间序列数据并进行分类。

5. 🛠️ 微服务架构:构建灵活的AI系统

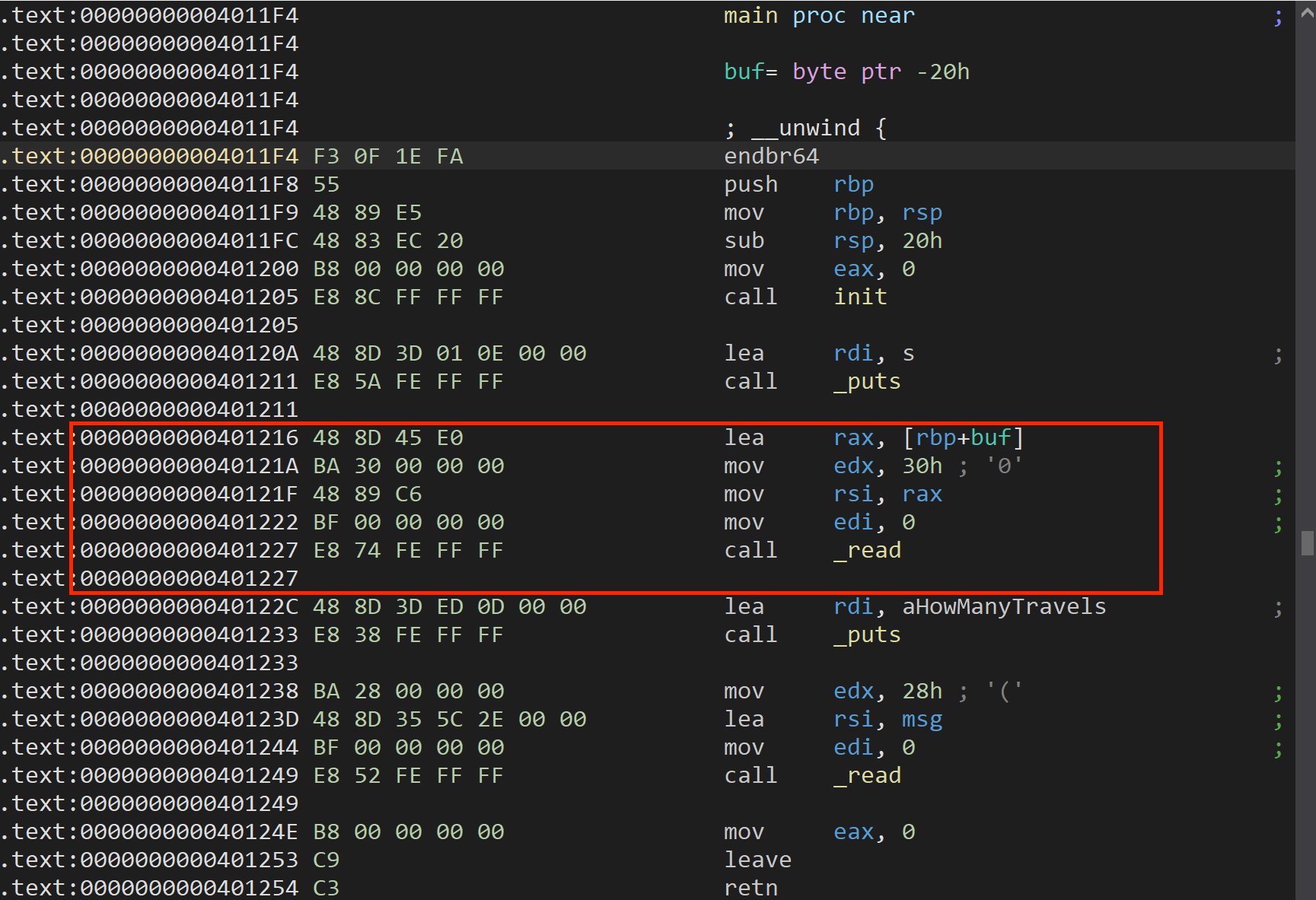

5.1 🏗️ 微服务的基本概念与架构设计

微服务架构将应用拆分为多个小服务。以下是使用Flask创建一个简单微服务的代码示例:

from flask import Flask, jsonify, request

app = Flask(__name__)

@app.route('/predict', methods=['POST'])

def predict():

data = request.get_json()

# 处理请求数据

prediction = {'result': 'example'}

return jsonify(prediction)

if __name__ == '__main__':

app.run(debug=True)

解释:这段代码展示了如何使用Flask创建一个基本的微服务。服务提供了一个预测接口,接受POST请求并返回预测结果。

5.2 📊 微服务与传统单体应用的比较

微服务架构与传统单体应用的比较可以从以下代码示例中体现:

- 单体应用:所有功能模块集中在

一个应用中,难以扩展和维护。

- 微服务架构:各个功能模块独立,易于扩展和维护。

5.3 🏆 微服务在AI系统中的优势

微服务在AI系统中的优势包括:

- 独立部署:每个服务可以独立部署和更新。

- 灵活扩展:根据需求对特定服务进行扩展。

5.4 📦 容器化与服务编排技术

容器化技术和服务编排工具使微服务管理更加高效。以下是使用Docker创建容器的示例:

# 创建Dockerfile

FROM python:3.8

RUN pip install flask

COPY app.py /app.py

CMD ["python", "/app.py"]

解释:这段Dockerfile代码展示了如何创建一个容器镜像,包括安装Flask和复制应用代码。

5.5 💡 案例分析:基于微服务的AI平台设计

一个基于微服务的AI平台包括以下模块:

- 数据处理服务:负责数据清洗和预处理。

- 模型训练服务:进行模型训练和优化。

- 预测服务:提供实时预测和决策支持。

6. 🌟 创新应用:将AI技术与微服务结合

6.1 ⚡ 实时数据处理与AI服务的集成

实时数据处理和AI服务的集成可以通过以下代码示例实现:

from kafka import KafkaConsumer

import requests

# Kafka消费者

consumer = KafkaConsumer('sensor_data', bootstrap_servers='localhost:9092')

for message in consumer:

data = message.value

# 发送数据到AI服务进行处理

response = requests.post('http://ai-service/predict', json={'data': data})

print(response.json())

解释:这段代码展示了如何从Kafka中消费实时数据并将其发送到AI服务进行处理。

6.2 🔧 AI模型的版本控制与服务治理

AI模型的版本控制可以通过MLflow实现:

import mlflow

# 保存模型

with mlflow.start_run():

mlflow.log_param("param1", 5)

mlflow.log_metric("metric1", 0.95)

mlflow.sklearn.log_model(model, "model")

解释:这段代码展示了如何使用MLflow记录和管理模型的版本和参数。

6.3 ⚖️ 动态扩展与负载均衡

动态扩展和负载均衡可以通过Kubernetes实现:

apiVersion: apps/v1

kind: Deployment

metadata:

name: ai-service

spec:

replicas: 3

selector:

matchLabels:

app: ai-service

template:

metadata:

labels:

app: ai-service

spec:

containers:

- name: ai-service

image: ai-service:latest

ports:

- containerPort: 8080

解释:这段Kubernetes YAML配置文件展示了如何部署一个具有3个副本的AI服务,并实现负载均衡和自动扩展。

6.4 🤖 案例分析:微服务架构下的智能客服系统

智能客服系统可以通过微服务架构实现:

- 自然语言理解:处理用户输入并理解其意图。

- 对话管理:管理对话状态和上下文。

- 知识库服务:提供相关的信息和答案。

7. 🔮 挑战与未来展望

7.1 🚧 AI技术在实际应用中的挑战

AI技术在实际应用中面临以下挑战:

- 数据质量问题:影响模型效果的数据问题。

- 模型泛化能力不足:训练数据与实际应用表现的差异。

- 计算资源需求:深度学习模型的高计算需求。

7.2 🔐 数据隐私与安全问题

数据隐私和安全问题包括:

- 数据泄露:敏感数据的非法访问。

- 隐私侵犯:未经授权的数据收集和使用。

7.3 🌐 AI伦理与社会影响

AI伦理问题和社会影响包括:

- 算法偏见:数据中的偏见可能被放大。

- 自动化对就业的影响:自动化可能导致职业消失。

7.4 🔮 未来的技术趋势与发展方向

未来的技术趋势包括:

- AI的普适性:AI技术的普及和广泛应用。

- 量子计算与AI的结合:提升AI计算能力的潜力。

- AI与边缘计算的融合:提高实时处理能力的可能性。

8. ✨ 结论

8.1 📚 总结全文的主要观点

本文探讨了AI技术的发展历程、创新应用和微服务架构的作用。总结观点包括:

- 技术进步:AI技术在算法和应用方面的显著进展。

- 微服务架构:提高了AI系统的灵活性和可扩展性。

- 挑战与展望:数据隐私、伦理和未来技术趋势的挑战和机遇。

8.2 🚀 对未来发展的预测与建议

未来,AI技术将继续发展,建议包括:

- 关注新兴技术:如量子计算和边缘计算。

- 改进技术:应对不断变化的需求和挑战。

- 制定伦理标准:推动AI技术的健康发展和制定合理的伦理标准。

![[C++游戏开发] 超大地图多人在线扫雷](https://i-blog.csdnimg.cn/direct/14db439ccac144bda8e1693fe0c526eb.png)