SparkSQL中的JSON函数快速入门

目录

- SparkSQL中的JSON函数快速入门

- 为什么需要JSON函数?

- SparkSQL JSON函数概览

- get_json_object: JSON字段提取利器

- json_tuple: 多字段提取神器

- from_json: JSON转结构化数据的桥梁

- to_json: 结构化数据转JSON的便捷工具

- schema_of_json: JSON Schema推断神器

- SparkSQL JSON函数进阶:性能优化与实战技巧

- JSON数组处理:size和explode函数

- size函数:获取数组长度

- explode函数:展开JSON数组

- 性能优化技巧

- 1. 使用Parquet文件格式

- 2. 合理使用分区

- 3. 预先解析JSON

- 实战案例:日志分析

- 注意事项

- 结语

- SparkSQL JSON函数实战:电商用户行为分析

- 数据样例

- 步骤1: 创建Spark会话

- 步骤2: 加载JSON数据

- 步骤3: 数据处理和分析

- 步骤4: 执行查询并查看结果

- 步骤5: 进一步分析

- 结语

- 总结 SparkSQL JSON函数从基础到实战

- 核心 JSON 函数概览

- 进阶技巧

- 实战案例:电商用户行为分析

- 核心要点

你是否曾经为处理JSON数据而头疼?SparkSQL为我们提供了强大的内置JSON函数,让JSON处理变得轻而易举。本文将带你深入了解这些函数,助你成为JSON处理高手!

为什么需要JSON函数?

在大数据处理中,JSON格式数据随处可见。无论是Web日志、API响应还是IoT设备数据,都可能以JSON形式存在。高效处理JSON数据成为每个数据工程师的必备技能。

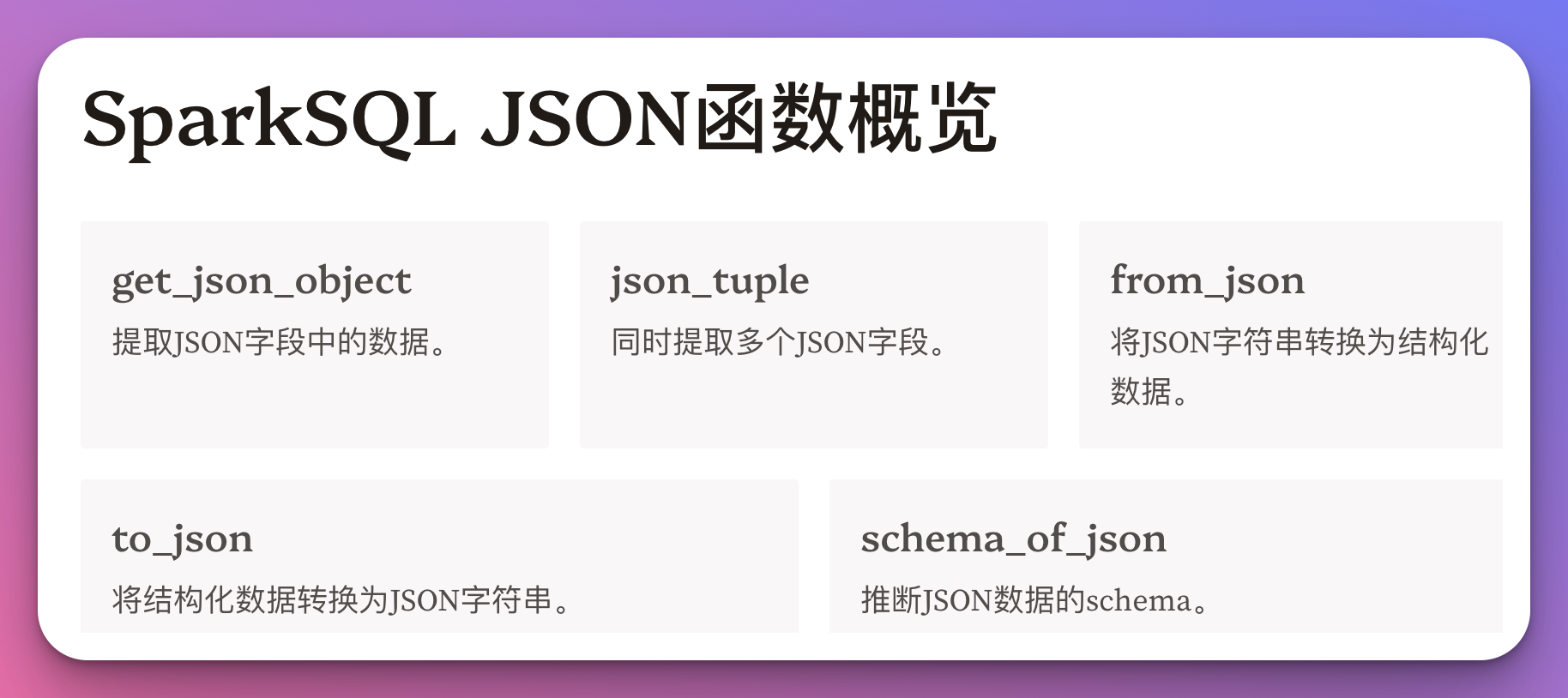

SparkSQL JSON函数概览

SparkSQL提供了丰富的JSON处理函数,主要包括:

get_json_object: 提取JSON字段json_tuple: 同时提取多个JSON字段from_json: JSON字符串转结构化数据to_json: 结构化数据转JSON字符串schema_of_json: 推断JSON schema

接下来,我们将逐一深入探讨这些函数的使用方法和技巧。

get_json_object: JSON字段提取利器

get_json_object函数允许我们使用JSONPath表达式从JSON字符串中提取特定字段。

语法:

get_json_object(json_str, path)

示例:

SELECT get_json_object('{"name":"John", "age":30}', '$.name') AS name;

-- 输出: John

这个函数特别适合从复杂JSON中提取单个字段。

json_tuple: 多字段提取神器

当需要同时提取多个JSON字段时,json_tuple函数是你的最佳选择。

语法:

json_tuple(json_str, key1, key2, ...)

示例:

SELECT json_tuple('{"name":"John", "age":30, "city":"New York"}', 'name', 'age') AS (name, age);

-- 输出: John, 30

json_tuple能显著提高多字段提取的效率,减少重复解析。

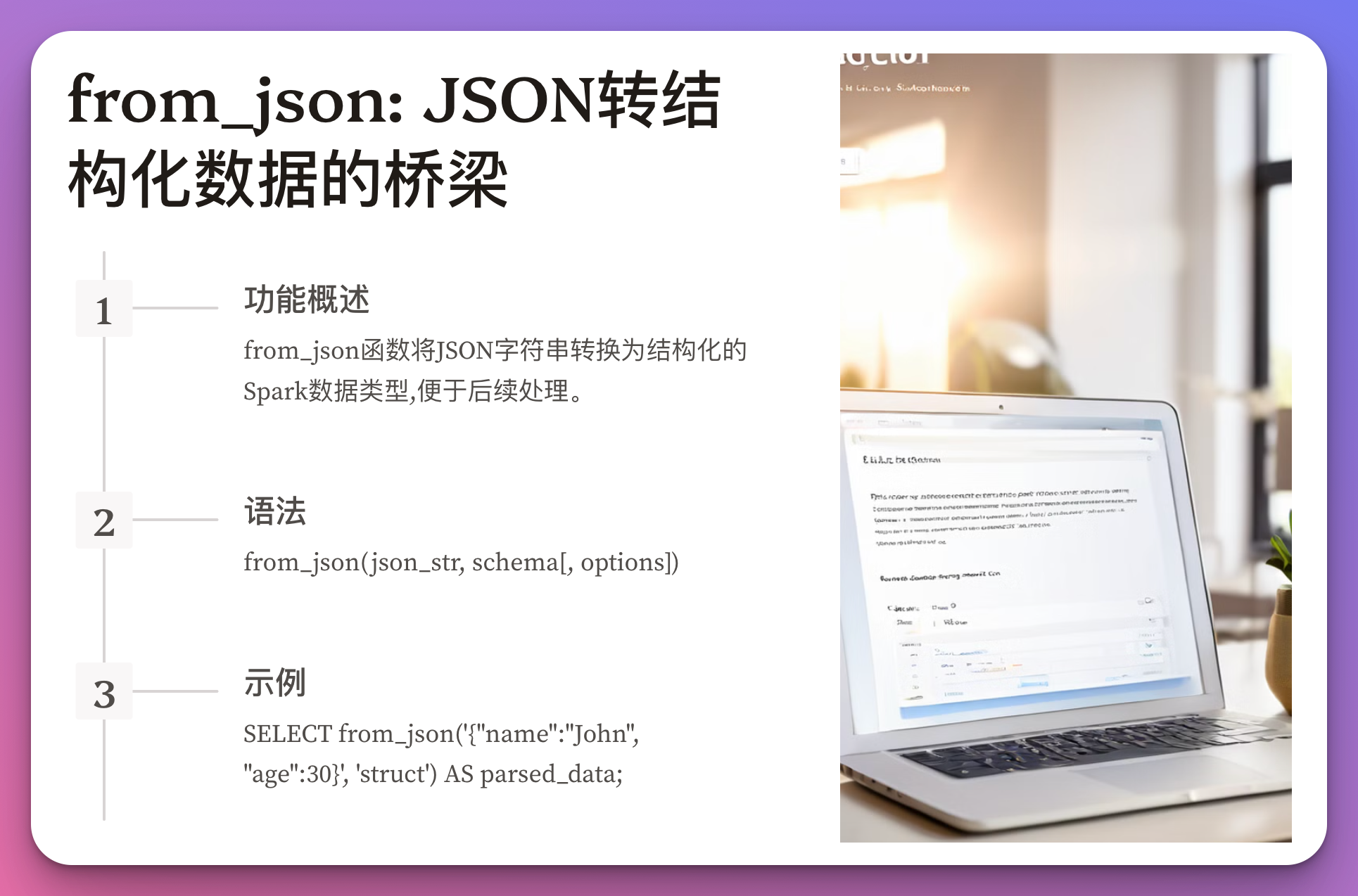

from_json: JSON转结构化数据的桥梁

from_json函数将JSON字符串转换为结构化的Spark数据类型,便于后续处理。

语法:

from_json(json_str, schema[, options])

示例:

SELECT from_json('{"name":"John", "age":30}', 'struct<name:string, age:int>') AS parsed_data;

这个函数在处理嵌套JSON数据时特别有用。

to_json: 结构化数据转JSON的便捷工具

与from_json相反,to_json函数将结构化数据转换回JSON字符串。

语法:

to_json(expr[, options])

示例:

SELECT to_json(struct("John" AS name, 30 AS age)) AS json_data;

-- 输出: {"name":"John","age":30}

在数据导出或API响应生成时,这个函数尤为实用。

schema_of_json: JSON Schema推断神器

schema_of_json函数能自动推断JSON字符串的schema,省去手动定义的麻烦。

语法:

schema_of_json(json_str)

示例:

SELECT schema_of_json('{"name":"John", "age":30, "scores":[85, 90, 92]}') AS json_schema;

这个函数在处理未知结构的JSON数据时特别有价值。

非常好,我们来继续深入探讨SparkSQL中的JSON函数,为读者提供更多实用的知识和技巧。

SparkSQL JSON函数进阶:性能优化与实战技巧

在上一篇文章中,我们介绍了SparkSQL中的基本JSON函数。今天,我们将更进一步,探讨如何优化这些函数的使用,以及在实际场景中的应用技巧。

JSON数组处理:size和explode函数

处理JSON数组是一个常见需求,SparkSQL为此提供了强大的支持。

size函数:获取数组长度

size函数可以用来获取JSON数组的长度。

语法:

size(json_array)

示例:

SELECT size(from_json('{"scores":[85, 90, 92]}', 'struct<scores:array<int>>').scores) AS array_size;

-- 输出: 3

explode函数:展开JSON数组

explode函数能将JSON数组展开为多行,方便进行后续分析。

语法:

explode(array)

示例:

SELECT explode(from_json('{"scores":[85, 90, 92]}', 'struct<scores:array<int>>').scores) AS score;

-- 输出:

-- 85

-- 90

-- 92

性能优化技巧

1. 使用Parquet文件格式

将JSON数据转换为Parquet格式可以显著提高查询性能。Parquet是一种列式存储格式,特别适合于大数据分析。

-- 将JSON数据保存为Parquet格式

CREATE TABLE parquet_table

USING PARQUET

AS SELECT * FROM json_table;

2. 合理使用分区

对于大型JSON数据集,合理使用分区可以提高查询效率。

-- 按日期分区存储JSON数据

CREATE TABLE partitioned_json_table (

id INT,

data STRING,

date STRING

)

USING JSON

PARTITIONED BY (date);

3. 预先解析JSON

如果某些JSON字段经常被查询,可以考虑在ETL阶段预先解析这些字段,避免重复解析。

CREATE TABLE parsed_json_table AS

SELECT

id,

get_json_object(data, '$.name') AS name,

get_json_object(data, '$.age') AS age,

data

FROM json_table;

实战案例:日志分析

假设我们有一个包含用户行为日志的JSON数据集,格式如下:

{

"user_id": 1001,

"timestamp": "2024-08-01T10:30:00Z",

"actions": [

{"type": "click", "target": "button1"},

{"type": "view", "target": "page2"}

]

}

我们要分析每个用户的点击次数。以下是实现这一需求的SparkSQL查询:

WITH parsed_logs AS (

SELECT

get_json_object(log, '$.user_id') AS user_id,

explode(from_json(get_json_object(log, '$.actions'), 'array<struct<type:string,target:string>>')) AS action

FROM log_table

)

SELECT

user_id,

COUNT(*) AS click_count

FROM parsed_logs

WHERE action.type = 'click'

GROUP BY user_id

ORDER BY click_count DESC

LIMIT 10;

这个查询展示了如何结合使用get_json_object、from_json和explode函数来处理复杂的嵌套JSON数据。

注意事项

-

Schema推断: 虽然

schema_of_json很方便,但在处理大数据集时可能影响性能。对于已知结构的数据,最好手动定义schema。 -

NULL值处理: JSON函数在处理NULL值时可能产生意外结果。始终做好NULL值检查和处理。

-

版本兼容性: SparkSQL的JSON函数在不同版本间可能有细微差异。升级Spark版本时要注意测试兼容性。

结语

掌握这些高级技巧后,你将能够更加高效地处理SparkSQL中的JSON数据。记住,性能优化是一个持续的过程,要根据实际数据和查询模式不断调整你的策略。

现在,是时候将这些知识应用到你的实际项目中了。你会发现,即使是最复杂的JSON数据处理任务,也变得轻而易举!

当然,让我们通过一个详细的示例来展示如何在实际场景中运用SparkSQL的JSON函数。这个例子将涵盖数据加载、处理和分析的整个流程。

SparkSQL JSON函数实战:电商用户行为分析

假设我们是一家电商平台的数据分析师,需要分析用户的购物行为。我们有一个包含用户行为日志的JSON数据集,记录了用户的浏览、加入购物车和购买行为。

数据样例

{

"user_id": 1001,

"session_id": "a1b2c3d4",

"timestamp": "2024-08-01T10:30:00Z",

"events": [

{"type": "view", "product_id": "P001", "category": "Electronics"},

{"type": "add_to_cart", "product_id": "P001", "quantity": 1},

{"type": "purchase", "product_id": "P001", "price": 599.99}

]

}

步骤1: 创建Spark会话

首先,我们需要创建一个Spark会话:

from pyspark.sql import SparkSession

spark = SparkSession.builder \

.appName("E-commerce User Behavior Analysis") \

.getOrCreate()

步骤2: 加载JSON数据

接下来,我们加载JSON数据并创建一个临时视图:

df = spark.read.json("path/to/user_logs.json")

df.createOrReplaceTempView("user_logs")

步骤3: 数据处理和分析

现在,让我们使用SparkSQL的JSON函数来分析这些数据:

-- 1. 提取用户ID和会话ID

WITH parsed_logs AS (

SELECT

get_json_object(value, '$.user_id') AS user_id,

get_json_object(value, '$.session_id') AS session_id,

get_json_object(value, '$.timestamp') AS event_time,

explode(from_json(get_json_object(value, '$.events'), 'array<struct<type:string,product_id:string,category:string,quantity:int,price:double>>')) AS event

FROM user_logs

),

-- 2. 分析用户行为

user_behavior AS (

SELECT

user_id,

session_id,

COUNT(CASE WHEN event.type = 'view' THEN 1 END) AS view_count,

COUNT(CASE WHEN event.type = 'add_to_cart' THEN 1 END) AS cart_add_count,

COUNT(CASE WHEN event.type = 'purchase' THEN 1 END) AS purchase_count,

SUM(CASE WHEN event.type = 'purchase' THEN event.price ELSE 0 END) AS total_purchase_amount

FROM parsed_logs

GROUP BY user_id, session_id

),

-- 3. 计算转化率

conversion_rates AS (

SELECT

COUNT(DISTINCT CASE WHEN view_count > 0 THEN user_id END) AS users_with_views,

COUNT(DISTINCT CASE WHEN cart_add_count > 0 THEN user_id END) AS users_with_cart_adds,

COUNT(DISTINCT CASE WHEN purchase_count > 0 THEN user_id END) AS users_with_purchases

FROM user_behavior

)

-- 4. 输出分析结果

SELECT

users_with_views AS total_active_users,

users_with_cart_adds AS users_adding_to_cart,

users_with_purchases AS users_making_purchase,

ROUND(users_with_cart_adds / users_with_views * 100, 2) AS view_to_cart_rate,

ROUND(users_with_purchases / users_with_cart_adds * 100, 2) AS cart_to_purchase_rate,

ROUND(users_with_purchases / users_with_views * 100, 2) AS overall_conversion_rate

FROM conversion_rates;

让我们逐步解释这个查询:

parsed_logs: 使用get_json_object提取顶层字段,并用explode和from_json展开嵌套的事件数组。user_behavior: 统计每个用户会话的各类行为次数和总购买金额。conversion_rates: 计算不同行为的用户数量。- 最后计算并输出各种转化率。

步骤4: 执行查询并查看结果

result = spark.sql("""

-- 在这里粘贴上面的SQL查询

""")

result.show()

输出可能如下所示:

+------------------+---------------------+----------------------+-----------------+----------------------+------------------------+

|total_active_users|users_adding_to_cart|users_making_purchase|view_to_cart_rate|cart_to_purchase_rate|overall_conversion_rate|

+------------------+---------------------+----------------------+-----------------+----------------------+------------------------+

| 10000| 6000| 3000| 60.00| 50.00| 30.00|

+------------------+---------------------+----------------------+-----------------+----------------------+------------------------+

步骤5: 进一步分析

我们还可以深入分析最受欢迎的产品类别:

SELECT

event.category,

COUNT(*) AS view_count,

SUM(CASE WHEN event.type = 'purchase' THEN 1 ELSE 0 END) AS purchase_count,

ROUND(SUM(CASE WHEN event.type = 'purchase' THEN 1 ELSE 0 END) / COUNT(*) * 100, 2) AS conversion_rate

FROM parsed_logs

WHERE event.category IS NOT NULL

GROUP BY event.category

ORDER BY view_count DESC

LIMIT 5;

结语

通过这个实例,我们展示了如何使用SparkSQL的JSON函数来处理复杂的嵌套JSON数据,并进行有意义的商业分析。这种方法可以轻松扩展到处理更大规模的数据集,帮助我们从海量的用户行为数据中提取有价值的洞察。

记住,在处理大规模数据时,可能需要进一步优化查询性能,例如使用适当的分区策略,或者预先解析和存储常用的JSON字段。

总结 SparkSQL JSON函数从基础到实战

在大数据时代,JSON 格式因其灵活性和广泛应用而成为数据处理的重要一环。SparkSQL 提供了强大的内置 JSON 函数,让我们能够高效地处理复杂的 JSON 数据。本文全面总结了这些函数的使用方法、优化技巧及实战应用。

核心 JSON 函数概览

get_json_object: 提取单个 JSON 字段json_tuple: 同时提取多个 JSON 字段from_json: JSON 字符串转结构化数据to_json: 结构化数据转 JSON 字符串schema_of_json: 推断 JSON schema

进阶技巧

-

JSON 数组处理

size: 获取数组长度explode: 展开 JSON 数组为多行

-

性能优化

- 使用 Parquet 文件格式

- 合理设置分区

- 预先解析常用 JSON 字段

-

注意事项

- Schema 推断可能影响性能

- 注意 NULL 值处理

- 关注版本兼容性

实战案例:电商用户行为分析

我们通过一个电商平台用户行为分析的案例,展示了如何在实际场景中应用这些 JSON 函数:

- 创建 Spark 会话

- 加载 JSON 数据

- 使用 SQL 查询处理数据

- 解析嵌套 JSON 结构

- 统计用户行为

- 计算转化率

- 执行查询并分析结果

关键代码片段:

WITH parsed_logs AS (

SELECT

get_json_object(value, '$.user_id') AS user_id,

get_json_object(value, '$.session_id') AS session_id,

explode(from_json(get_json_object(value, '$.events'), 'array<struct<type:string,...>>')) AS event

FROM user_logs

),

-- 后续数据处理和分析...

核心要点

- 灵活运用函数组合:如

get_json_object与explode配合使用 - 性能优先:合理使用 schema 定义,避免过度依赖自动推断

- 数据层次化处理:使用 CTE (Common Table Expression) 使查询更清晰

- 商业洞察导向:从原始数据中提取有价值的业务指标

通过掌握这些 SparkSQL JSON 函数及其应用技巧,数据工程师和分析师可以更加高效地处理复杂的 JSON 数据,从海量信息中挖掘有价值的商业洞察。

记住,实践是掌握这些技能的关键。不断在实际项目中应用这些知识,你将成为 JSON 数据处理的专家!

![C语言程序设计-[8] while语句循环结构](https://i-blog.csdnimg.cn/direct/d22822d5998e4e21a873908cc2bd6589.png)