【ML】 自监督学习

- 1. 自监督学习 bert 为例子

- 1.1 BERT 的特点:

- 1.2 BERT 的模型结构:

- 1.3 训练 BERT 的步骤:

- 2. how to use BERT

- 2. multi-lingual BERT

- 3. GPTs

- bert 应用到 图像

1. 自监督学习 bert 为例子

BERT(Bidirectional Encoder Representations from Transformers)是一种预训练语言表示的方法,由 Google 在 2018 年提出。它是基于 Transformer 架构的模型,主要用于自然语言处理(NLP)任务。BERT 的核心特点和结构如下:

1.1 BERT 的特点:

-

双向编码器:

- BERT 使用 Transformer 的编码器部分,并且是第一个成功应用双向训练的语言模型,即在预训练阶段同时考虑了左右两侧的上下文信息。

-

深层和广泛层连接:

- BERT 模型通常包含多层 Transformer 编码器堆叠,每层都包含自注意力机制和前馈网络。

-

大规模预训练:

- BERT 在大量文本数据上进行预训练,这些数据可以是书籍、网页等,从而学习到丰富的语言表示。

-

任务灵活性:

- 预训练完成后,BERT 可以用于各种下游 NLP 任务,如文本分类、问答、命名实体识别等,通常通过在预训练模型上添加少量任务特定层来实现。

-

微调能力:

- BERT 支持微调(Fine-tuning),即在下游任务上进一步训练预训练模型,以学习特定于任务的信息。

1.2 BERT 的模型结构:

-

嵌入层:

- 包括词嵌入、位置嵌入和段嵌入,用于将输入文本转换为模型可以处理的数值向量。

-

多头自注意力机制:

- 允许模型在编码单词时同时考虑不同位置的上下文信息。

-

前馈网络:

- 在每个 Transformer 层中,自注意力层的输出会通过一个前馈网络进一步处理。

-

层归一化:

- 在每个子层的输入和输出上应用层归一化,以稳定训练过程。

-

残差连接:

- 每个子层的输出通过残差连接与输入相加,以帮助梯度流动。

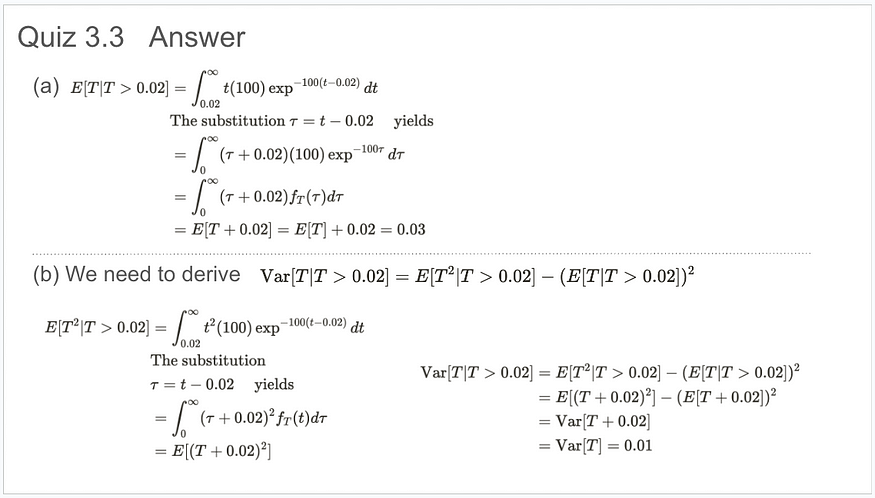

1.3 训练 BERT 的步骤:

-

预训练:

- 使用大量无标签文本数据进行预训练,主要通过以下两个任务:

- 遮蔽语言模型(Masked Language Model, MLM):随机遮蔽输入句子中的一些单词,然后预测这些单词。

- 下一句预测(Next Sentence Prediction, NSP):预测两个句子是否是连续的句子。

- 使用大量无标签文本数据进行预训练,主要通过以下两个任务:

-

微调:

- 在特定的下游任务上进一步训练预训练得到的 BERT 模型。这通常涉及到在模型顶部添加任务特定的层,并使用带标签的数据进行训练。

-

数据准备:

- 对于下游任务,准备并预处理数据,包括分词、构建词汇表、编码文本等。

-

模型配置:

- 根据任务需求选择合适的 BERT 模型配置,如层数、隐藏层大小等。

-

损失函数和优化器:

- 定义适合下游任务的损失函数,并选择合适的优化器进行模型训练。

-

训练和验证:

- 执行模型训练,并在验证集上评估性能,调整超参数。

-

保存和加载模型:

- 在训练过程中保存模型的检查点,并在需要时加载模型进行进一步的训练或测试。

-

评估:

- 在测试集上评估模型的最终性能,使用适当的评估指标。

-

部署:

- 将训练好的模型部署到生产环境中,用于实际的 NLP 任务。

BERT 模型由于其强大的语言表示能力,在 NLP 领域取得了显著的成果,并激发了一系列基于 Transformer 的预训练语言模型的发展。

GLUE数据集是一中对机器学习小任务的能力评估模型,这里可以看出随着算法的发展,在多个子任务上机器的能力已经超过人类,部分子任务机器的能力自逼近人类的能力

2. how to use BERT

在这里插入图片描述

2. multi-lingual BERT

multi-lingual bert 200k 训练 loss 有点大, 但是当数据量达到1000k 的时候 LOss 在训练一周后 开始下降

分别计算训练后 BERT 在不同语言下的中心 在翻译的过程中 减去中心后 就会得到不同语言下的对齐的结果

3. GPTs

GPT实现一个假新闻: 安第斯山脉发现以恶搞独角兽

bert 的模型是基于各种已有问题的训练, 但是GPT的模型作者的脑洞更大,并且实现了,以下三种模式,就是给出要做的事情,给出几个样例,然后给出问题,采用提示词大的方式来与模型交互,可能也是大经历过 非常大的规模的数据训练出来的模型才有的一种“智能”的形式吧,也即探索的本质——压缩

bert 应用到 图像