生成式AI推理的性价比是GPU的140倍。

大模型时代,全球算力短缺,买来铲屎的Nvidia市值被推上天。

如今,终于有一家公司拿出了自己的AI芯片来挑战。

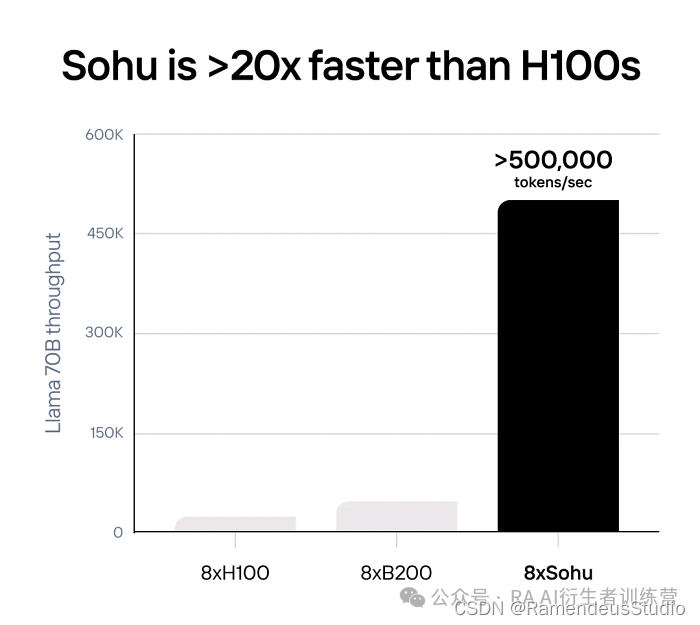

今天早上,科技圈迎来一则重磅消息,美国芯片初创公司Etched推出了旗下首款AI芯片搜狐,其运行大型模型的速度比Nvidia的H100快20倍,比今年3月推出的顶级芯片B200快10倍以上。

运行Llama 70B的搜狐服务器每秒可以输出50多万个代币,是H100服务器(2.3万个代币/秒)的20倍,是B200服务器(约4.5万个代币/秒)的10倍。

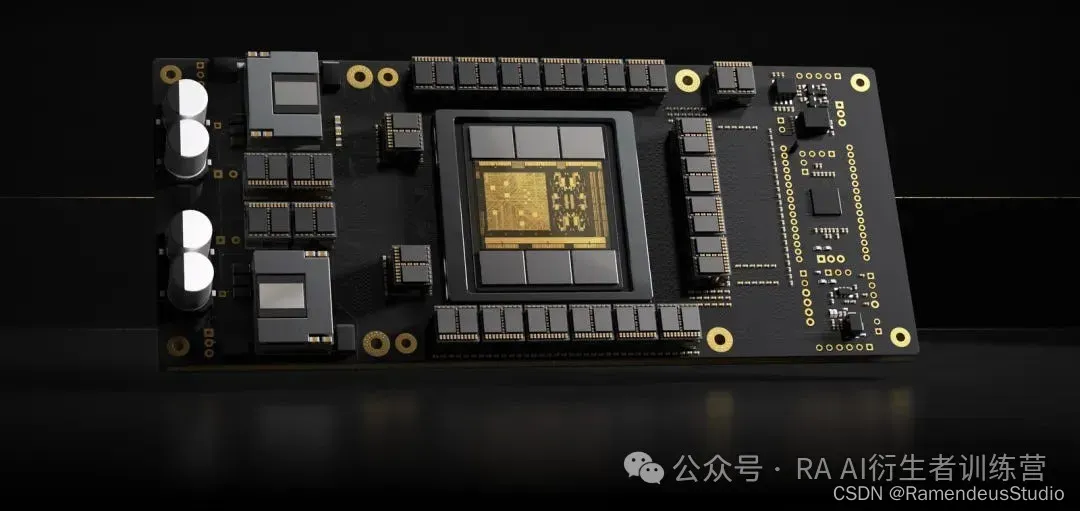

搜狐公司研发了全球首款Transformer计算专用芯片,耗时两年打造。

作为一款 ASIC(专用集成电路),搜狐对 Transformer 架构进行了优化,并将其固化在芯片中,无法运行大多数“传统”AI 模型:支持 Instagram 广告的 DLRM、AlphaFold 2 等蛋白质折叠模型,或 Stable Diffusion 2 等较旧的图像生成模型。我们也无法运行 CNN、RNN 或 LSTM。

但另一方面,对于 transformer 来说,搜狐是有史以来最快的芯片,它与其他产品的差距是一个数量级。如今每一款主流的 AI 产品,如 ChatGPT、Claude、Gemini、Sora 等,都是由 transformer 驱动的。

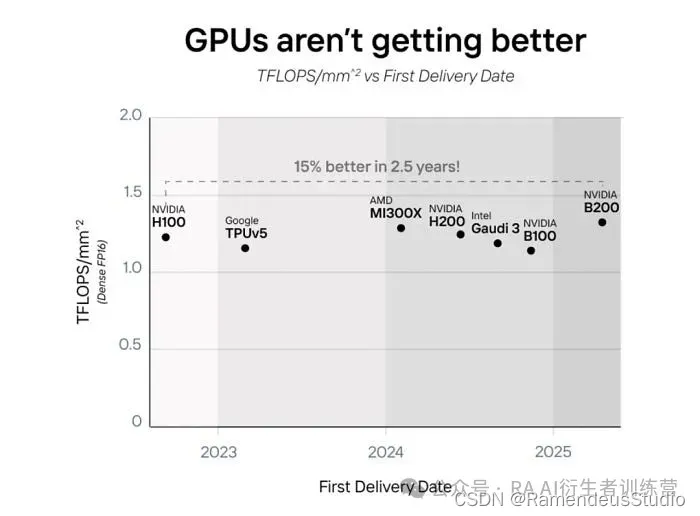

近期受摩尔定律放缓影响,GPU性能的提升很大程度上依赖增加芯片面积和功耗,无论是Nvidia B200、AMD MI300X还是Intel Gaudi 3,均采用“二合一”的方式提升性能,功耗也随之翻倍。

从 2022 年到 2025 年,AI 芯片并没有真正变得更好,只是变得更大了。

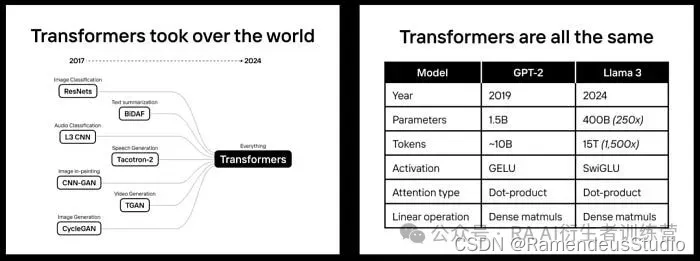

但如果大型模型广泛使用Transformer架构,追求专业化或许是提高性能的一个很好的方向。

作为一个新兴领域,AI模型的架构在过去经历了很大的变化。但从GPT-2开始,几乎所有最先进的模型都使用了Transformer,从OpenAI的GPT系列,谷歌的PaLM,Facebook的LLaMa,到特斯拉FSD自动驾驶所需的模型。

Etched 为我们算了一笔账:芯片项目的成本在 5000 万到 1 亿美元之间,而且需要数年时间才能投入生产。另一方面,当模型训练成本超过 10 亿美元、推理成本超过 100 亿美元时,使用专用芯片是不可避免的。在这种工业规模下,1% 的改进可以利用硬件架构的更新。

比H100快20倍,FLOPS利用率超过90%

作为全球首款Transformer ASIC芯片,一台服务器搭载8颗搜狐芯片,性能可以媲美160块H100 GPU,也就是说,搜狐的运行速度是H100的20倍以上。

具体来说,通过专业化,搜狐拥有了前所未有的性能,一台搭载8个搜狐芯片的服务器,每秒可以处理50万个Llama 7B代币。

Llama 3 70B 在 FP8 精度下的基准测试显示:无稀疏性、8 倍模型并行性、2048 输入或 128 输出长度。

另外,搜狐仅支持Llama和Stable Diffusion 3的Transformer推理,目前搜狐支持Google、Meta、Microsoft、OpenAI、Anthropic等现有模型,后续会适配模型调整。

由于搜狐只能运行一种算法,因此可以删除绝大多数控制流逻辑,从而允许使用更多数学块。因此,搜狐的 FLOPS 利用率超过 90%,而使用 TRT-LLM 的 GPU 的利用率约为 30%。

搜狐为什么能输出更多的FLOPS?

NVIDIA H200在不稀疏的情况下支持989 TFLOPS的FP16/BF16算力,这是目前最先进的芯片,而2025年推出的GB200将算力提升25%,支持1250 TFLOPS。

由于 GPU 的大部分区域都是可编程的,因此专注于 Transformer 将容纳更多的计算。这可以从第一原理中证明:

构建单个 FP16/BF16/FP8 乘加电路需要 10,000 个晶体管,这是所有矩阵数学的基石。H100 SXM 有 528 个张量核心,每个核心都有 4× 8 × 16 FMA 电路。乘法告诉我们:H100 有 27 亿个晶体管专用于张量核心。

然而,H100 拥有 800 亿个晶体管。这意味着 H100 GPU 上只有 3.3% 的晶体管用于矩阵乘法。这是 NVIDIA 和其他芯片制造商经过深思熟虑的设计决定。如果要支持所有类型的模型(CNN、LSTM、SSM 等),没有比这更好的了。

通过仅运行变压器,Etched 允许搜狐芯片输出更多的 FLOPS,但却以精度或稀疏性为代价。

内存带宽不是瓶颈

事实上,对于像 Llama 3 这样的车型来说,情况并非如此。

我们以 NVIDIA 和 AMD 的标准基准为例:2048 个输入 token 和 128 个输出 token。大多数 AI 产品的提示都比较长,比如最新的 Claude 聊天机器人的系统提示就有 1000+ 个 token。

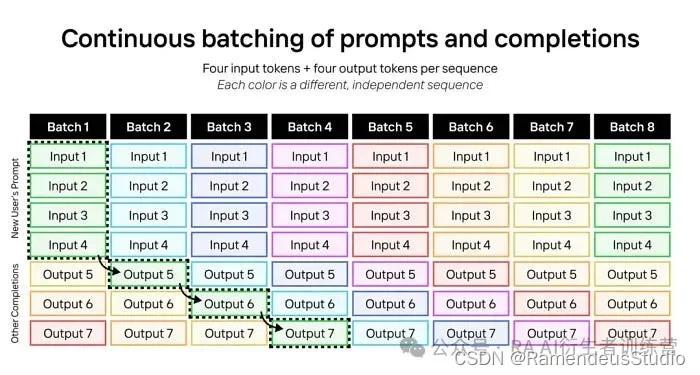

在搜狐上,推理是分批进行的。每个批次都需要加载一次所有模型权重,并在批次的每个标记中重复使用。一般来说,LLM 输入是计算密集型的,而 LLM 输出是内存密集型的。当我们将输入和输出标记与连续批次相结合时,工作负载会变得高度计算密集。

下面是 LLM 连续批处理的示例,运行具有四个输入标记和四个输出标记的序列。每种颜色代表不同的序列。

我们可以扩展同样的技巧来运行具有 2048 个输入标记和 128 个输出标记的 Llama 3 70B。每个批次包含一个序列的 2048 个输入标记和 127 个不同序列的 127 个输出标记。

如果这样做,每个batch大约需要 (2048+127)×70B 参数×2bytes perparameter = 304 TFLOPs,而只需要加载 70B 参数×2bytes perparameter = 140GB 的模型权重,以及大约 127×64×8×128×(2048+127)×2×2 = 72GB 的 KV cache 权重。这比内存带宽所需的计算量要大得多:H200 需要 6.8PFLOPS 的计算量才能最大化其内存带宽。在 100% 利用率的情况下仍然如此。如果利用率只有 30%,则需要 3 倍以上的内存。

搜狐拥有更强的计算能力,而且利用率很高,因此可以运行巨大的吞吐量,而不会遇到内存带宽瓶颈。

软件的工作原理

在 GPU 和 TPU 上,软件是一场噩梦。处理任意 CUDA 和 PyTorch 代码需要极其复杂的编译器。第三方 AI 芯片(如 AMD、英特尔、AWS 等)在软件上总共花费了数十亿美元,但收效甚微。

搜狐只运行 transformers,因此你只需要为 transformer 编写软件。

大多数运行开源或内部模型的公司都使用变压器特定的推理库,例如 TensorRT-LLM、vLLM 或 HuggingFace 的 TGI。

这些框架非常死板,虽然你可以进行模型超参数调整,但它们不支持更改底层模型代码。但这没关系,因为所有 Transformer 模型都非常相似(甚至文本/图像/视频模型也是如此),所以超参数调整就是你所需要的。

虽然 95% 的 AI 公司都是如此,但一些最大的 AI 实验室采用了定制方法。他们拥有工程师团队,手动调整 GPU 核心以提高利用率,并进行逆向工程以最大限度地减少寄存器到每个张量核心的延迟。

Etched 消除了逆向工程的需要,并且其所有软件(从驱动程序、内核到服务堆栈)都将是开源的。如果您想实现自定义转换层,内核向导可以自由地做到这一点。

创业团队:由哈佛辍学生领导

Etched 首席执行官 Gavin Uberti 告诉记者:“如果 Transformer 将来不再是主流,我们就会倒闭。但如果它继续存在,我们就会成为历史上最大的公司。”

打造搜狐芯片的 Etched 位于加州库比蒂诺。该公司成立仅两年,目前团队只有 35 人。其创始人是一对哈佛辍学生,Gavin Uberti(前 OctoML 和 Xnor.ai 员工)和 Chris Zhu。他们与 Robert Wachen 和前赛普拉斯半导体首席技术官 Mark Ross 一起,一直致力于打造专用于大型 AI 模型的芯片。

在搜狐芯片发布的同时,Etched 还宣布完成 1.2 亿美元 A 轮融资,由 Primary Venture Partners 和 Positive Sum Ventures 领投。Etched 的总融资额已达 1.2536 亿美元。本轮融资的重要投资者包括 Peter Thiel、GitHub CEO Thomas Dohmke、Cruise 联合创始人 Kyle Vogt、Quora 联合创始人 Charlie Cheever。

然而,对于占据AI芯片市场80%以上份额的英伟达来说,1.2亿美元只相当于半天的收益。

“我们之所以如此兴奋,之所以辍学,之所以组建团队从事这个芯片项目,是因为这是最重要的工作,”Etched 运营主管罗伯特·瓦肯 (Robert Wachen) 表示。“整个技术的未来将取决于计算基础设施是否能够扩展。”

Uberti 称,迄今为止,匿名客户预订了“价值数千万美元”的硬件,预计搜狐将于今年第三季度推出。

是不是未来真的像乌贝蒂所说的那样,视频生成、音频生成、具身智能等技术只有在搜狐这样的芯片上才能真正实现呢?

欢迎前往我们的公众号,资讯

欢迎前往我们的公众号,资讯

创作不易,觉得不错的话,点个赞吧!!!

![[MRCTF2020]Ezpop1](https://i-blog.csdnimg.cn/direct/0b0af77b610b403e8a0cd5df094500ef.png)