文章目录

- Autoregressive Image Generation without Vector Quantization

-

- 一. 简介

-

- 1.1 摘要

- 1.1 引言

- 二.相关工作

-

- 2.1 Sequence Models for Image Generation

- 2.2 Diffusion for Representation Learning

- 2.3 Diffusion for Policy Learning

- 三.方法

-

- 3.1 重新思考离散值的tokens

- 3.2 Diffusion Loss

-

- 损失函数

- 采样器

- 3.2 Diffusion Loss for Autoregressive Models

- 3.3 Unifying Autoregressive and Masked Generative Models

- 四.实现

-

- 4.1 Diffusion Loss

- 4.2 Autoregressive and Masked Autoregressive Image Generation

- 五.实验

-

- 5.1 Properties of Diffusion Loss

- 5.2 Properties of Generalized Autoregressive Models

- 5.3 与现有系统的基准测试

- 六.讨论与结论

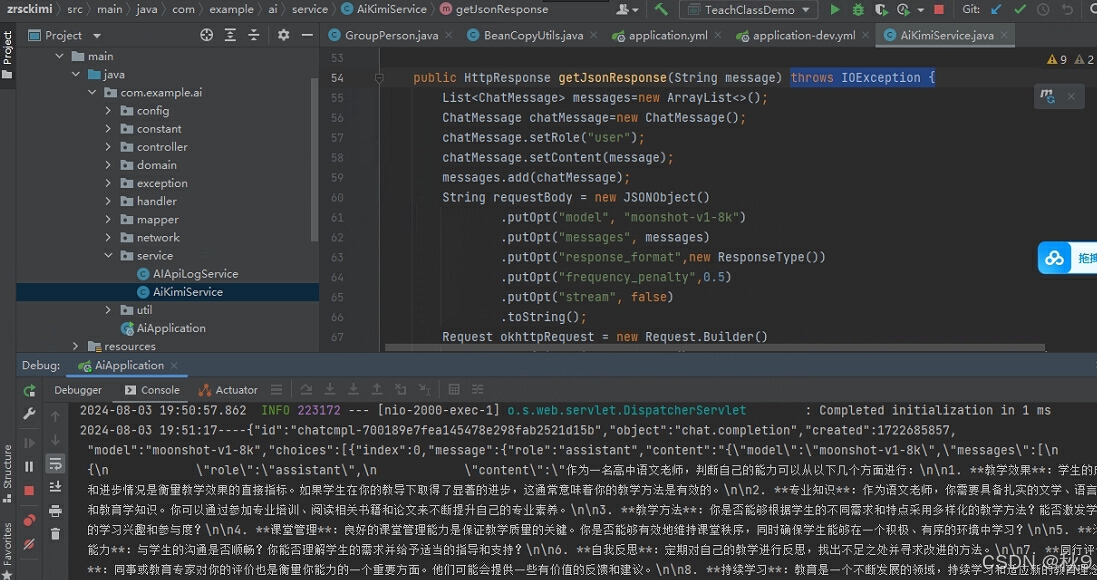

Autoregressive Image Generation without Vector Quantization

一. 简介

机构:MIT,DeepMind,清华

代码:https://github.com/LTH14/mar

任务: 自回归图像生成

特点: 自回归建模tokens之间的相互依赖 + Diffusion Loss建模每个token的分布,能够不被约束在向量量化(vector-quantized)的表示内,而在continuous-valued tokens框架下实现

方法: Diffusion Loss,MAR

1.1 摘要

常规观点认为,用于图像生成的自回归模型通常伴随着向量量化(vector-quantized)的token。我们观察到,虽然使用离散值空间能够帮助表示类别分布,但这并不是自回归建模的必要条件。在这项工作中,我们提出使用扩散过程来建模每个token的概率分布,这使得我们能够在连续值空间中应用自回归模型。我们没有使用传统的分类交叉熵损失函数,而是定义了一种扩散损失函数来建模每个token的概率。这个

![[CR]厚云填补_SEGDNet](https://i-blog.csdnimg.cn/direct/77c2f2ca52f34d1287fcec9ad3177a5c.png)