Ollama0.3.0 + llama3.1本地部署

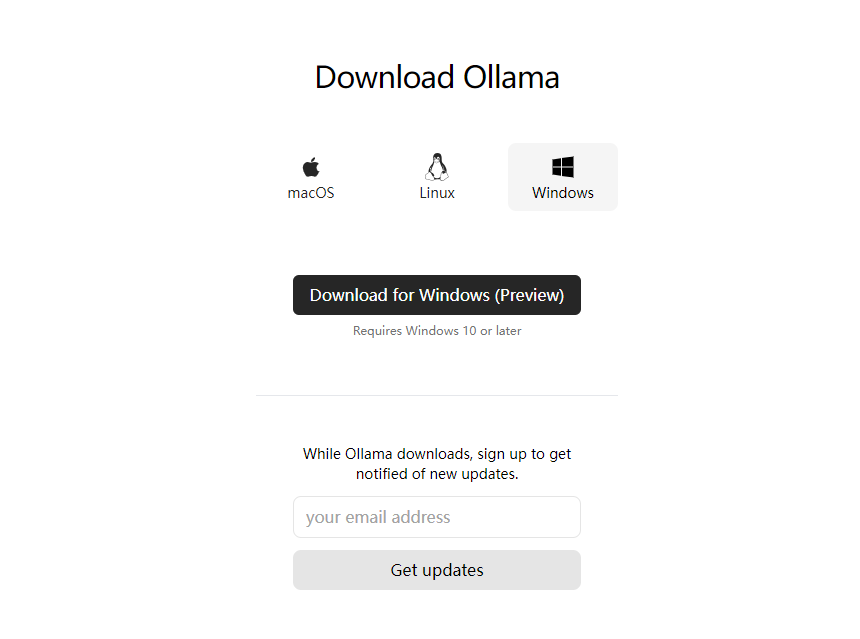

安装Ollama

官网下载安装包

https://ollama.com/download

根据系统选择对应版本

安装完成后,电脑右下角会出现ollama程序图标,表示ollama正在运行。

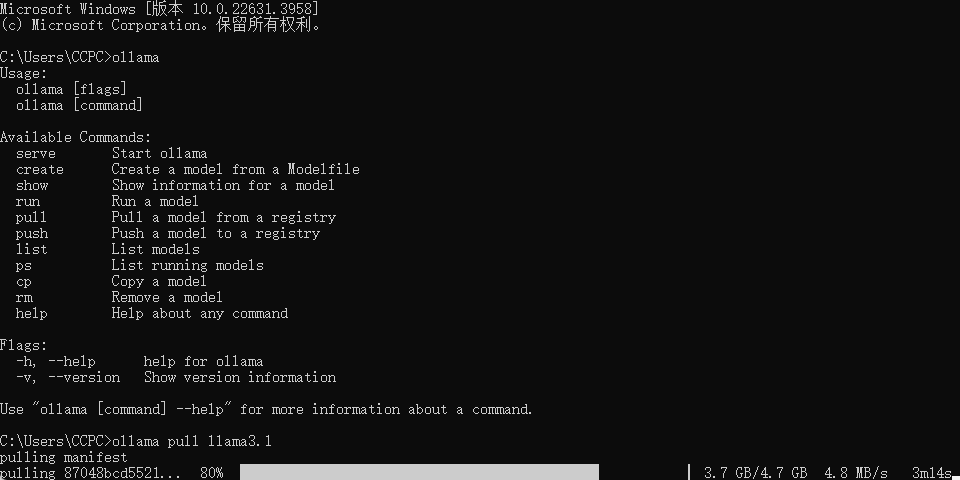

打开cmd命令

下载Llama3.1

输入ollama,如果出现下图表示安装没问题,然后输入ollama pull llama3.1命令,安装最新的llama3.1版本模型,程序有4.7GB,需要下载一段时间

运行

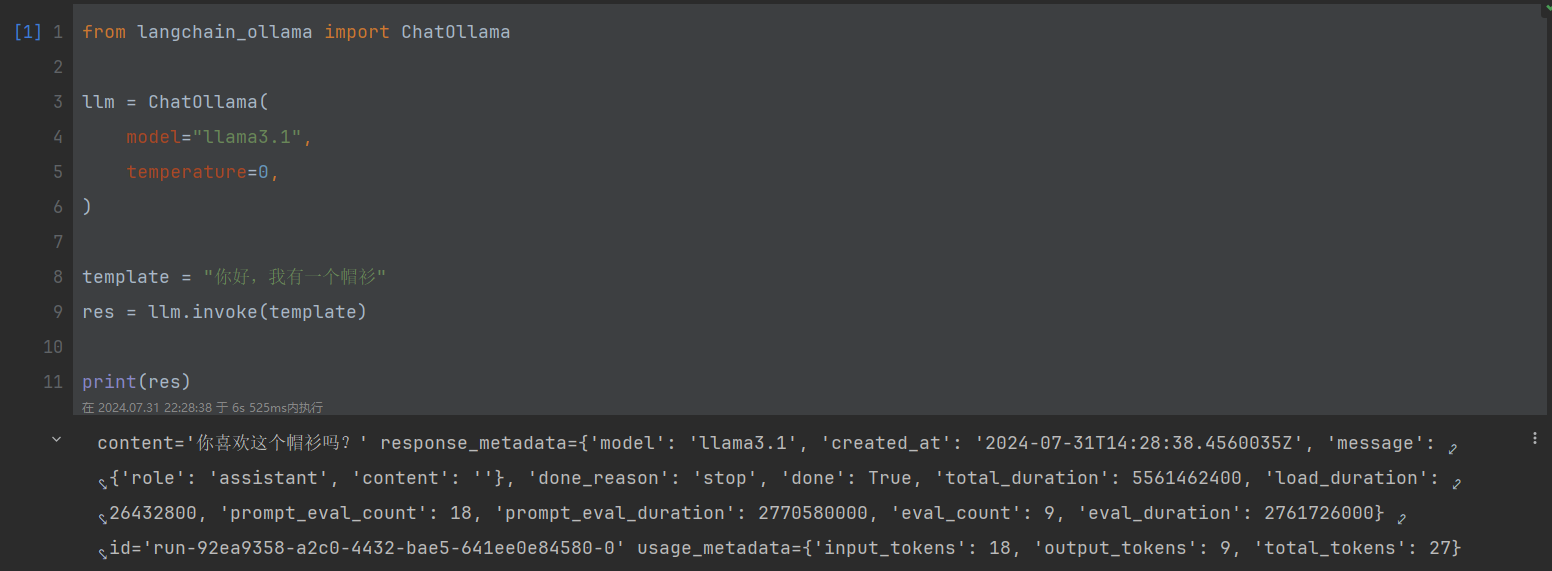

打开jupyter notebook,输入代码进行测试

from langchain_ollama import ChatOllama

llm = ChatOllama(

model="llama3.1",

temperature=0,

)

template = "你好,我有一个帽衫"

res = llm.invoke(template)

print(res)

可以看到,刚才下载的本地模型已经成功运行了。

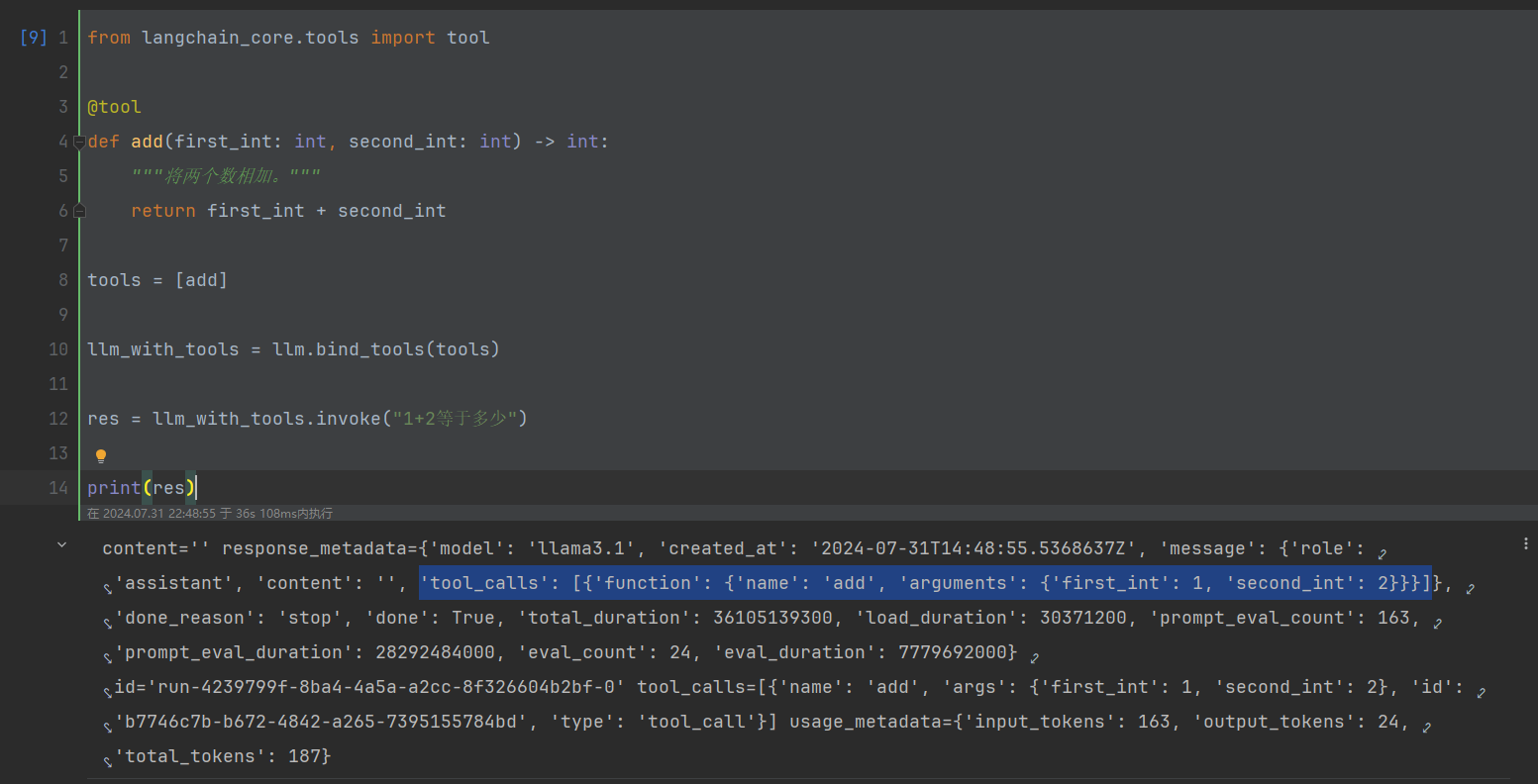

Function Calling

2024年7月25号,Ollama发布0.3.0版本,该版本正式支持了Function Calling,我们测试下

from langchain_core.tools import tool

@tool

def add(first_int: int, second_int: int) -> int:

"""将两个数相加。"""

return first_int + second_int

tools = [add]

llm_with_tools = llm.bind_tools(tools)

res = llm_with_tools.invoke("1+2等于多少")

print(res)

可以看到,模型已经成功识别了自定义的add工具,并返回了工具调用的Schema