发表于:PMLR24

推荐指数: #paper/⭐⭐⭐

总结做了什么:

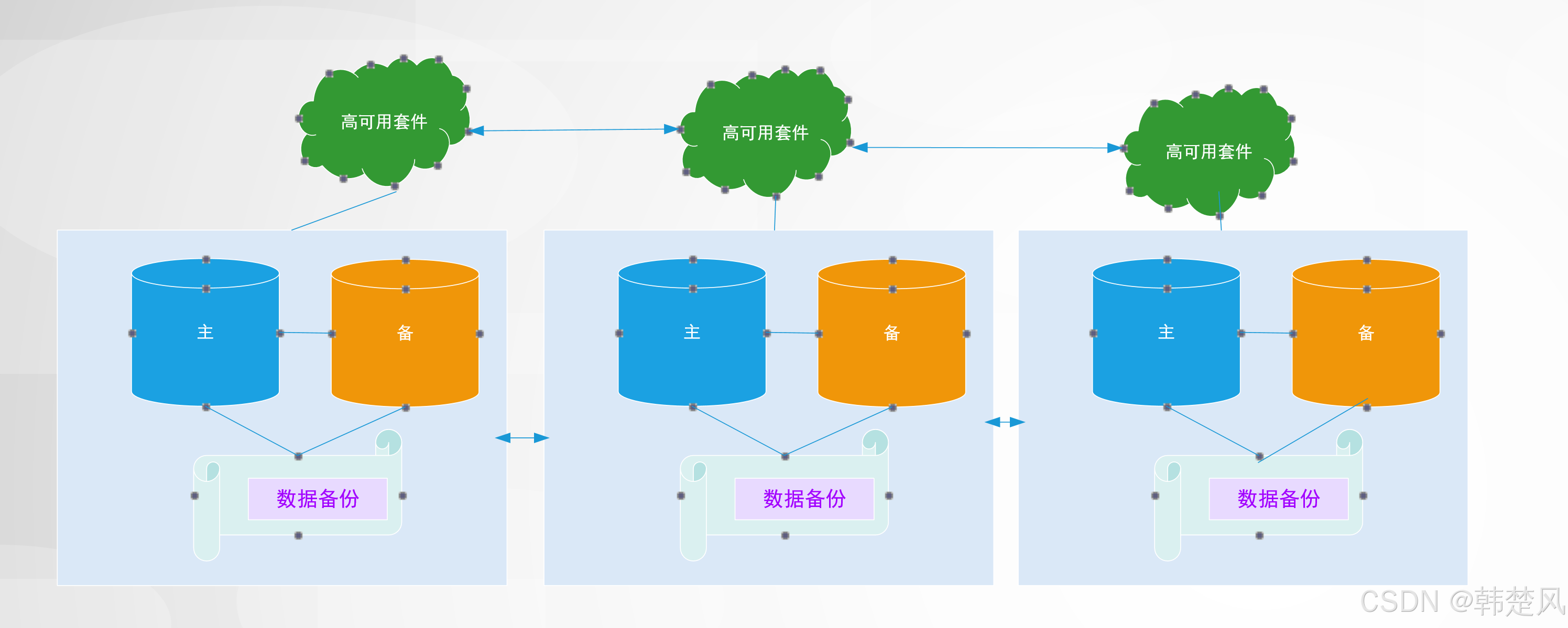

利用gcn+对比学习训练mlp来提取特征嵌入,使得训练完毕使用的时候,可以更快的得到嵌入(类似于师生蒸馏的加速).其中,结合了异配图的chebnet2,以及高通低通过滤,和非对称对比学习等

看图解释:作者将全通的MLP训练得到的嵌入和低通过滤器和高通过滤器生成的嵌入进行对比,来训练MLP的嵌入.这个思想特别巧妙,角度切入很好

方法

切比雪夫多项式:

∑

k

=

0

K

w

k

T

k

(

L

~

)

X

\sum_{k=0}^Kw_kT_k(\tilde{\mathbf{L}})\mathbf{X}

∑k=0KwkTk(L~)X其中,

L

^

=

2

L

/

λ

m

a

x

−

I

\hat{\mathbf{L}}=2\mathbf{L}/\lambda_{max}-\mathbf{I}

L^=2L/λmax−I.

T

k

(

x

)

=

2

x

T

k

−

1

(

x

)

−

T

k

−

2

(

x

)

T_{\boldsymbol{k}}(x) = 2xT_{\boldsymbol{k}-1}(x) -T_{\boldsymbol{k}-2}(x)

Tk(x)=2xTk−1(x)−Tk−2(x),其中

T

0

(

x

)

=

1

,

T

1

(

x

)

=

x

T_0(x) = 1 \mathrm , T_1(x) = x

T0(x)=1,T1(x)=x

在切比雪夫差值中,将参数w重新参数化:

w

k

=

2

K

+

1

∑

j

=

0

K

γ

j

T

k

(

x

j

)

w_k=\frac2{K+1}\sum_{j=0}^K\gamma_jT_k(x_j)

wk=K+12∑j=0KγjTk(xj)

由于在无监督学习中,难以用标签来促进参数化.我们提出以下两个要求:1.参数

γ

\gamma

γ在0-2之间.2.低通过滤器的

γ

\gamma

γ随着j的增加逐渐减小(2->0),而高通的

γ

\gamma

γ随着j的增加逐渐增大(0->2).我们因此提出了余弦相似度相初始化参数.

γ

j

h

=

σ

(

β

a

h

)

+

1

2

σ

(

β

b

h

)

(

1

+

cos

(

(

1

+

j

/

K

)

π

)

)

\gamma_j^h=\sigma(\beta_a^h)+\frac12\sigma(\beta_b^h)(1+\cos\left((1+j/K)\pi\right))

γjh=σ(βah)+21σ(βbh)(1+cos((1+j/K)π))

γ

j

l

=

σ

(

β

a

l

)

−

1

2

σ

(

β

b

l

)

(

1

+

cos

(

(

1

+

j

/

K

)

π

)

)

\gamma_j^l=\sigma(\beta_a^l)-\frac12\sigma(\beta_b^l)(1+\cos\left((1+j/K)\pi\right))

γjl=σ(βal)−21σ(βbl)(1+cos((1+j/K)π))

其中,

σ

\sigma

σ是relu函数,保证

γ

\gamma

γ的非负性以及

γ

j

h

≤

γ

j

+

1

h

\gamma_{j}^{h}\leq\gamma_{j+1}^{h}

γjh≤γj+1h,

γ

j

l

≥

γ

j

+

1

l

\gamma_{j}^{l}\geq\gamma_{j+1}^{l}

γjl≥γj+1l.我们初始化

β

a

h

,

β

a

l

\beta_{a}^h,\beta_{a}^l

βah,βal 0和2,设置

β

b

h

,

β

b

l

\beta_{b}^h,\beta_{b}^l

βbh,βbl 2.之后,

β

\beta

β可训练在对比训练中.由于余弦相似度强调了相关频率,因此促进了更稳定的频率分布.

在我的理解中,切比雪夫光谱过滤器的符号为正时,应该是高通过滤器.现在举前4项为例. T 1 ( L ) = x , T 2 ( L ) = 2 x 2 − 1 , T 3 ( x ) = 4 x 3 − 3 x T_{1}(L)=x,T_{2}(L)=2x^2-1,T_{3}(x)=4x^3-3x T1(L)=x,T2(L)=2x2−1,T3(x)=4x3−3x,这三个都是显著的高通过滤器.因此,我个人认为作者生成的两个多项式都是高通过滤器.

这样,高通视图和低通视图可得:

Z h = ∑ k = 0 K w k h T k ( L ~ ) f θ h ( X ) , Z l = ∑ k = 0 K w k l T k ( L ~ ) f θ l ( X ) . \mathbf{Z}^h=\sum_{k=0}^Kw_k^hT_k(\tilde{\mathbf{L}})f_\theta^h(\mathbf{X}),\quad\mathbf{Z}^l=\sum_{k=0}^Kw_k^lT_k(\tilde{\mathbf{L}})f_\theta^l(\mathbf{X}). Zh=k=0∑KwkhTk(L~)fθh(X),Zl=k=0∑KwklTk(L~)fθl(X).

其中, f θ f_{\theta} fθ是MLP.

MLP编码器和交叉通道目标

我们定义交叉通道目标为:

L

c

p

=

−

1

2

∣

V

∣

∑

v

i

∈

V

(

log

s

(

z

p

f

,

z

p

l

)

∑

p

≠

q

s

(

z

p

f

,

z

q

l

)

+

log

s

(

z

p

f

,

z

p

h

)

∑

p

≠

q

s

(

z

p

f

,

z

q

h

)

)

.

(4)

\begin{aligned}\mathcal{L}_{cp}&=\frac{-1}{2|\mathcal{V}|}\sum_{v_i\in\mathcal{V}}\left(\log\frac{\mathrm{s}\left(z_p^f,z_p^l\right)}{\sum_{p\neq q}\mathrm{s}\left(z_p^f,z_q^l\right)}\right.+\log\frac{\mathrm{s}\left(z_p^f,z_p^h\right)}{\sum_{p\neq q}\mathrm{s}\left(z_p^f,z_q^h\right)}\Big).\end{aligned}\tag{4}

Lcp=2∣V∣−1vi∈V∑

log∑p=qs(zpf,zql)s(zpf,zpl)+log∑p=qs(zpf,zqh)s(zpf,zph)).(4)

s

(

z

n

f

,

z

n

h

)

=

exp

(

ω

(

z

n

f

,

z

n

h

)

/

τ

)

\mathrm{s}(z_n^f,z_n^h) = \exp(\omega(z_n^f,z_n^h)/\tau)

s(znf,znh)=exp(ω(znf,znh)/τ),其中w是余弦相似度.

z

p

f

z_{p}^f

zpf是通过mlp得到的.

z

p

h

z_{p}^h

zph是通过高通过滤器得到的.

z

p

l

z^l_{p}

zpl是通过低通过滤器得到的.

但是,由于mlp匮乏的捕获图信息的能力,因此这个学习到的结果不是最优的

光谱:邻居正样本\

低通过滤器

由graph ecl,ugcn等可以得到:在异配图上,2阶邻居可以表现出同配性.因此,我们将公式4的左侧(mlp嵌入与低通嵌入的对比)改造为:

L

f

l

=

−

1

2

∣

V

∣

∑

v

i

∈

V

1

∣

N

i

′

∣

∑

v

p

∈

N

i

′

log

s

(

z

i

f

,

z

p

l

)

∑

v

q

∈

V

∖

v

i

s

(

z

i

f

,

z

q

l

)

.

\mathcal{L}_{fl}=-\frac1{2|\mathcal{V}|}\sum_{v_i\in\mathcal{V}}\frac1{|\mathcal{N}_i^{\prime}|}\sum_{v_p\in\mathcal{N}_i^{\prime}}\log\frac{\mathrm{s}\left(z_i^f,z_p^l\right)}{\sum_{v_q\in\mathcal{V}\setminus v_i}\mathrm{s}\left(z_i^f,z_q^l\right)}.

Lfl=−2∣V∣1vi∈V∑∣Ni′∣1vp∈Ni′∑log∑vq∈V∖vis(zif,zql)s(zif,zpl).

其中,

N

i

′

{\mathcal{N}_i^{\prime}}

Ni′表示

v

i

v_{i}

vi的本地邻居正样本.如图所示,由于节点p是节点i的邻居,因此,上式子实质上是聚合节点的2阶及以上的邻居.

高通过滤器

L

f

h

=

−

1

2

∣

V

∣

∑

v

i

∈

V

1

∣

N

i

′

′

∣

∑

v

p

∈

N

i

′

′

log

s

(

z

i

f

,

z

p

h

)

∑

v

q

∈

V

∖

v

i

s

(

z

i

f

,

z

q

h

)

\mathcal{L}_{fh}=-\frac1{2|\mathcal{V}|}\sum_{v_i\in\mathcal{V}}\frac1{|\mathcal{N}_i^{\prime\prime}|}\sum_{v_p\in\mathcal{N}_i^{\prime\prime}}\log\frac{\mathrm{s}\left(z_i^f,z_p^h\right)}{\sum_{v_q\in\mathcal{V}\setminus v_i}\mathrm{s}\left(z_i^f,z_q^h\right)}

Lfh=−2∣V∣1vi∈V∑∣Ni′′∣1vp∈Ni′′∑log∑vq∈V∖vis(zif,zqh)s(zif,zph)其中,

N

i

′

′

=

k

N

N

(

v

i

,

k

)

{\mathcal{N}_i^{\prime\prime}}=kNN(v_i,k)

Ni′′=kNN(vi,k).

knn是k近邻,只与节点特征相关.

最终损失:

L = α L f l + ( 1 − α ) L f h , \mathcal{L}=\alpha\mathcal{L}_{fl}+(1-\alpha)\mathcal{L}_{fh}, L=αLfl+(1−α)Lfh,

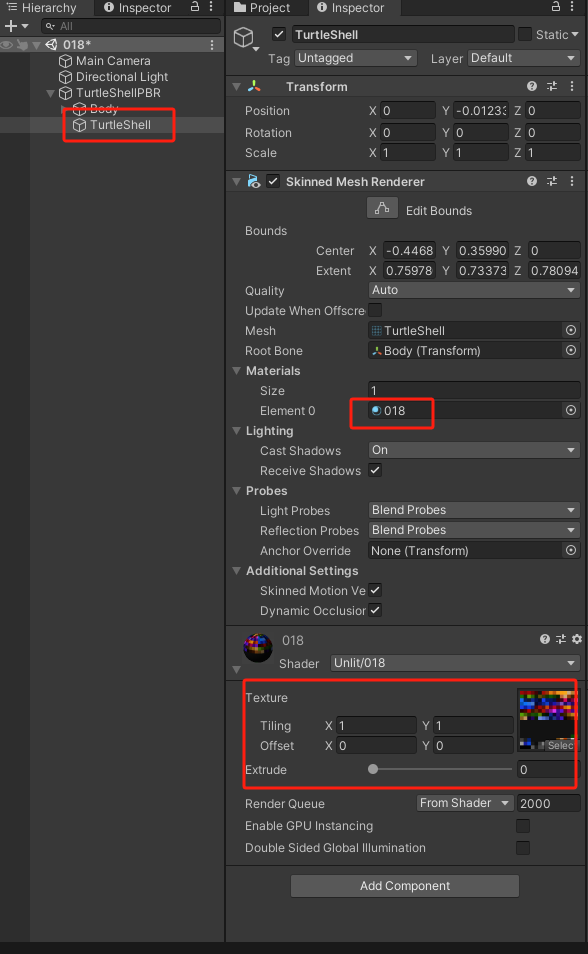

实验结果即消融:

实验结果

貌似很不错,但是有几个23,24年的最新对比学习的正确率没有比较.并且,比较常见的chameleon和Squirrel也没有跑实验.

实验理论仍然有改进的空间

消融:

上面是件简单的GCN-MLP,发现效果还行

下面则是提出的完整的模型,正确率提高了一点.

总结:

总的来说,一个很好的idea.但是,我个人感觉,整个论文还有提升的空间(其是在UGCL的基础上改造的对比学习模块)

相关公式:

平滑性判断

f

(

x

)

=

x

⊤

L

x

2

=

∑

(

u

,

v

)

∈

E

(

x

u

−

x

v

)

2

2

.

\mathbf{f}(x)=\frac{x^\top\mathbf{L}x}2=\sum_{(u,v)\in\mathcal{E}}\frac{(x_u-x_v)^2}2.

f(x)=2x⊤Lx=∑(u,v)∈E2(xu−xv)2.

越低表示越平滑

定理: Δ D ( x ) = E [ ∑ ( u , v ) ∈ E ( x u − x v ) 2 − ∑ ( u , v ) ∈ E ( x u − x v ) 2 ] = 2 E [ ( p i n t r a − p i n t e r ) f ( x ) ] . \begin{aligned}\Delta D(x)&=\mathbb{E}\bigg[\sum_{(\boldsymbol{u},\boldsymbol{v})\in\boldsymbol{E}}(x_u-x_v)^2-\sum_{(\boldsymbol{u},\boldsymbol{v})\in\boldsymbol{E}}(x_u-x_v)^2\bigg]\\&=2\mathbb{E}\bigg[(p_{\boldsymbol{intra}}-p_{\boldsymbol{inter}})\mathbf{f}(x)\bigg].\end{aligned} ΔD(x)=E[(u,v)∈E∑(xu−xv)2−(u,v)∈E∑(xu−xv)2]=2E[(pintra−pinter)f(x)].

越低的Dx表示越高的内聚性