本文介绍了一种名为YotoR(You Only Transform One Representation)的新型深度学习目标检测模型。该模型将Swin Transformers与YoloR架构相结合。在自然语言处理领域引起革命的Transformer技术,如今同样对计算机视觉产生了深远影响,展现出显著提升准确性和计算效率的潜力。

YotoR将健壮的Swin Transformer主干网与YoloR的 Neck 和 Head 结合在一起。实验证明了两种模型结合的有效性。

感兴趣的小伙伴可以去看看原文:https://arxiv.org/pdf/2405.19629

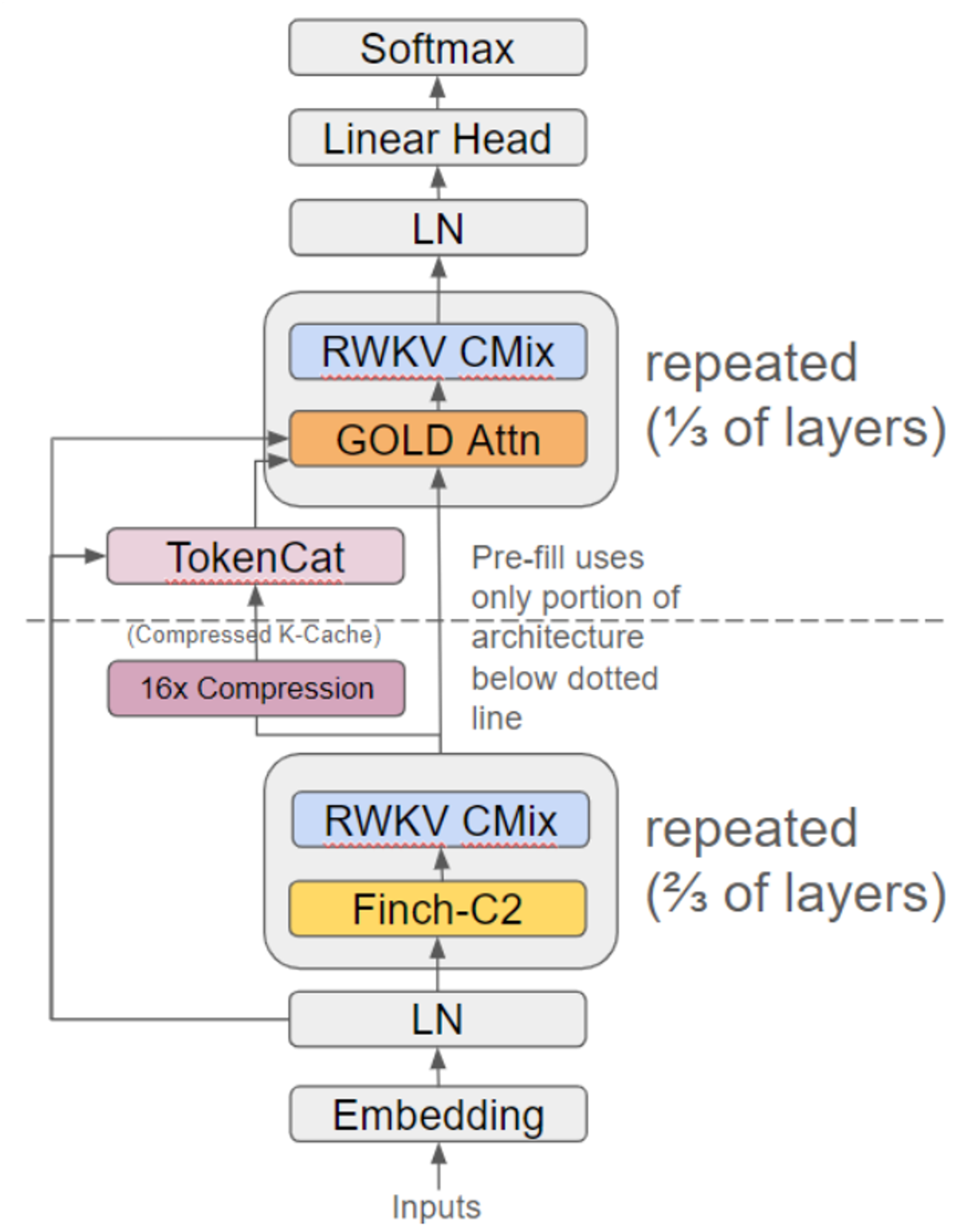

一、模型BackBone

上图展示了用于主干网的Swin Transformer简化架构,特别是被称为Swin T的小型(Tiny)版本。该架构主要分为四个阶段:

-

图像被划分为小块,然后这些小块被转换为标记。通过线性嵌入层,这些标记被转换成特定大小的标记

-

输入到第一阶段的第一组Swin Transformer块中

-

三个阶段由一个块合并模块组成,该模块通过组的方式合并块,将特征图的宽度和高度分辨率减半

-

传递给相应的Swin Transformer块数组

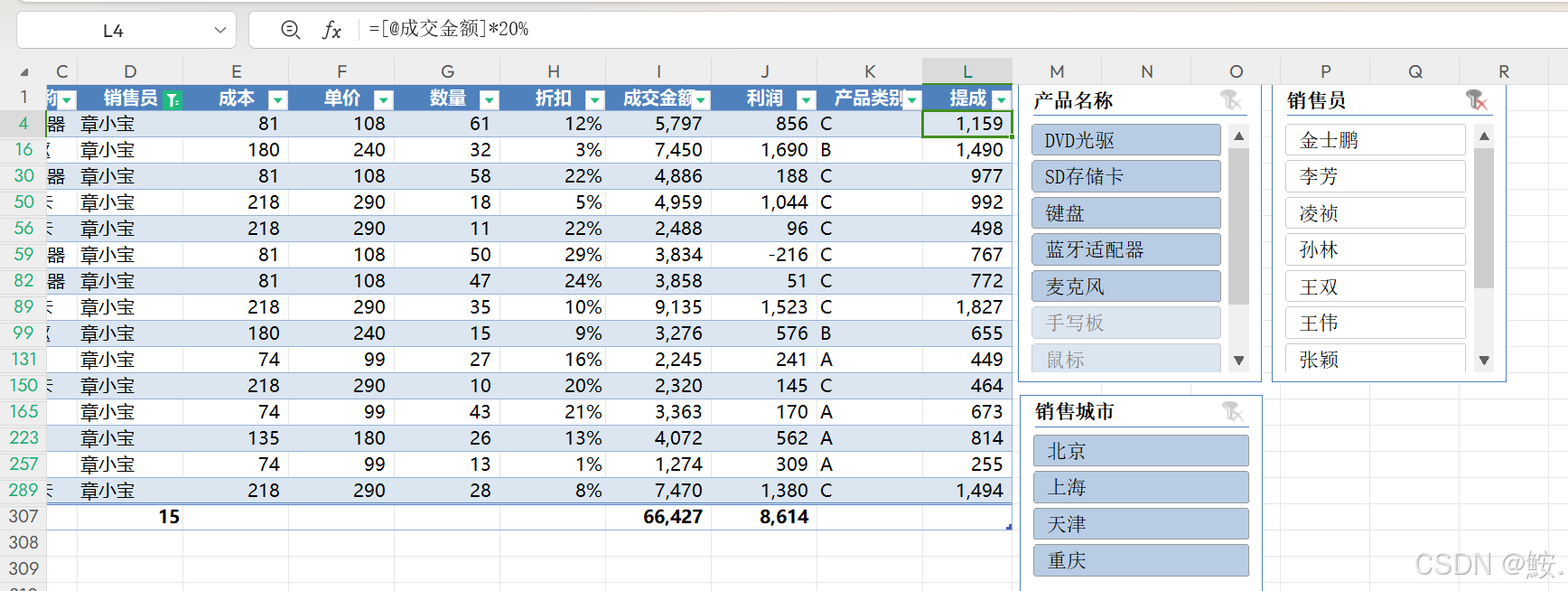

二、模型 Head

如上图所示,为了构建YoloR模型,作者选择了基于Scaled YoloV4的架构,特别是以YoloV4-P6-light为基础,并对其进行了逐步修改,以创建不同版本的YoloR:P6、W6、E6和D6。具体的修改如下:

-

Yolo-P6:将YoloV4-P6-light的Mish激活函数替换为SiLU

-

Yolo-W6:增加了Backbone块输出的通道数

-

Yolo-E6:将W6的通道数增加至原来的1.25倍,并将下采样卷积替换为CSP卷积

-

Yolo-D6:增加了Backbone网络的深度

三、模型效果

-

如上展示了四个YotoR模型在val2017数据集上的mAP(平均精度均值)结果。TP5和BP4模型的表现超越了所有基准模型,即使是作为参照的YoloR P6,其mAP表现也非常出色。唯一没有超越的模型是BB4。

-

然而,考虑到BB4完全基于Swin B构建,并且没有使用YoloR P6的Head,这一结果是可以理解的。尽管如此,BB4的性能仍然优于Swin B,这表明探索更大模型(如Swin L)的潜力,且Swin L的性能优于YoloR D6。

![[Windows] 简单易用的图片去水印工具,Inpaint 9.1 单文件版](https://i-blog.csdnimg.cn/direct/6d77c4ee535441f2a1d3c91fe66bfefe.png)