目录

拟合与插值的区别

常用的拟合算法

应用实例

总结

最小二乘法在不同数据分布下的性能表现如何?

傅里叶级数拟合在图像处理中的应用案例有哪些?

贝叶斯估计法与最大似然估计法在参数估计中的优缺点分别是什么?

最大似然估计法(MLE)

优点:

缺点:

贝叶斯估计法(Bayesian Estimation)

优点:

缺点:

Gauss-Newton方法在非线性拟合中的具体实现步骤和效果评估。

具体实现步骤

初始化:

计算残差向量:

构建误差平方和(SSE):

计算雅可比矩阵:

更新参数:

终止条件:

最终结果:

效果评估

最小化 SSE:

收敛速度:

比较其他方法:

实际应用案例:

三次样条拟合与其他曲线拟合方法相比的优势和局限性。

优势

局限性

拟合算法是数学建模和数据分析中的一种重要方法,其目标是找到一个函数或曲线,使得该函数或曲线在某种准则下与给定的数据点最为接近。拟合算法可以用于数据预处理、模型选择和预测等多个领域。

拟合与插值的区别

拟合和插值是两种不同的概念。插值要求所求的函数必须经过所有给定的数据点,而拟合则不需要经过所有数据点,只要误差足够小即可。例如,在线性回归中,我们通常希望找到一条直线 y=kx+by=kx+b,使得这条直线到各个数据点之间的误差最小。

常用的拟合算法

最小二乘法:这是最常用的拟合算法之一,通过最小化误差的平方和来寻找最佳拟合曲线。最小二乘法可以应用于线性回归、多项式回归等场景。

- 线性回归:设一条直线 y=kx+by=kx+b,通过最小化误差的平方和来确定 kk 和 bb 的值。

- 多项式回归:使用高阶多项式函数来逼近数据点,基本思想是通过不断增加多项式的阶数来提高拟合精度。

傅里叶级数拟合:将复杂的函数拆解成多个简单的正弦和余弦函数的和,通过求解系数来实现拟合。这种方法广泛应用于信号处理、图像处理等领域。

贝叶斯估计法:基于概率论的方法,通过先验知识和观测数据来估计参数的后验分布。

最大似然估计法:根据观测数据的概率分布函数来估计模型参数,使似然函数最大化。

非线性拟合:对于非线性模型,可以通过迭代方法如Gauss-Newton方法来寻找全局最优解。

样条拟合:如三次样条拟合,通过局部调整节点来优化拟合过程,具有较高的精度和收敛性。

应用实例

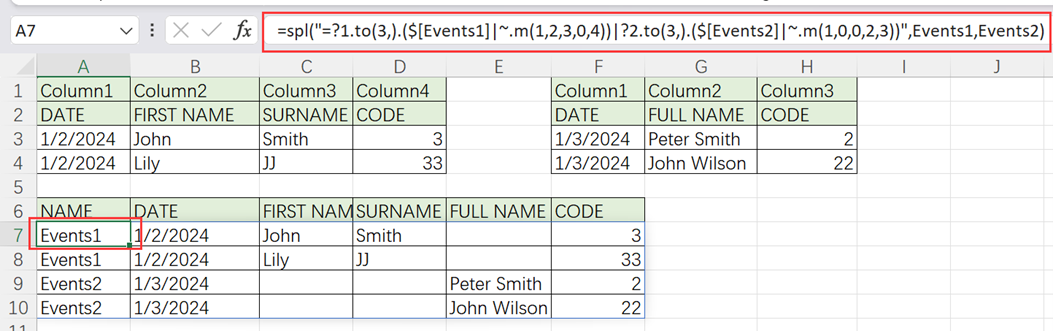

在实际应用中,MATLAB提供了丰富的函数库来支持各种拟合算法。例如:

polyfit:用于多项式拟合。fitlm:用于线性回归模型的拟合。spline:用于三次样条插值。

Python也有相应的库,如NumPy和SciPy,提供线性拟合、多项式拟合和对数拟合等功能。

代码示例:

线性回归

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

# 示例数据

x = np.array([1, 2, 3, 4, 5]).reshape(-1, 1) # 将x转换为列向量

y = np.array([1, 3, 2, 5, 4])

# 创建并训练模型

model = LinearRegression()

model.fit(x, y)

# 预测

y_pred = model.predict(x)

# 可视化

plt.scatter(x, y, color='red', label='Data points')

plt.plot(x, y_pred, label='Linear regression')

plt.legend()

plt.show()

print("线性回归系数:", model.coef_)

print("线性回归截距:", model.intercept_)

多项式回归

import numpy as np

import matplotlib.pyplot as plt

from sklearn.preprocessing import PolynomialFeatures

from sklearn.linear_model import LinearRegression

# 示例数据

x = np.array([1, 2, 3, 4, 5]).reshape(-1, 1)

y = np.array([1, 3, 2, 5, 4])

# 创建多项式特征

poly = PolynomialFeatures(degree=2)

x_poly = poly.fit_transform(x)

# 创建并训练模型

model = LinearRegression()

model.fit(x_poly, y)

# 预测

y_pred = model.predict(x_poly)

# 可视化

plt.scatter(x, y, color='red', label='Data points')

plt.plot(x, y_pred, label='Polynomial regression')

plt.legend()

plt.show()

print("多项式回归系数:", model.coef_)

print("多项式回归截距:", model.intercept_)

指数回归

import numpy as np

import matplotlib.pyplot as plt

from scipy.optimize import curve_fit

# 指数函数

def exp_func(x, a, b):

return a * np.exp(b * x)

# 示例数据

x = np.array([1, 2, 3, 4, 5])

y = np.array([2.7, 7.4, 20.1, 54.6, 148.4])

# 拟合

popt, pcov = curve_fit(exp_func, x, y)

a, b = popt

# 预测

y_pred = exp_func(x, a, b)

# 可视化

plt.scatter(x, y, color='red', label='Data points')

plt.plot(x, y_pred, label='Exponential regression')

plt.legend()

plt.show()

print("指数回归参数: a =", a, ", b =", b)

对数回归

import numpy as np

import matplotlib.pyplot as plt

from scipy.optimize import curve_fit

# 对数函数

def log_func(x, a, b):

return a * np.log(b * x)

# 示例数据

x = np.array([1, 2, 3, 4, 5])

y = np.array([0.5, 1.0, 1.5, 2.0, 2.5])

# 拟合

popt, pcov = curve_fit(log_func, x, y)

a, b = popt

# 预测

y_pred = log_func(x, a, b)

# 可视化

plt.scatter(x, y, color='red', label='Data points')

plt.plot(x, y_pred, label='Logarithmic regression')

plt.legend()

plt.show()

print("对数回归参数: a =", a, ", b =", b)

幂回归

import numpy as np

import matplotlib.pyplot as plt

from scipy.optimize import curve_fit

# 幂函数

def power_func(x, a, b):

return a * np.power(x, b)

# 示例数据

x = np.array([1, 2, 3, 4, 5])

y = np.array([1, 4, 9, 16, 25])

# 拟合

popt, pcov = curve_fit(power_func, x, y)

a, b = popt

# 预测

y_pred = power_func(x, a, b)

# 可视化

plt.scatter(x, y, color='red', label='Data points')

plt.plot(x, y_pred, label='Power regression')

plt.legend()

plt.show()

print("幂回归参数: a =", a, ", b =", b)

总结

拟合算法在数据分析和科学计算中扮演着关键角色。不同的拟合算法适用于不同类型的模型和数据集,选择合适的拟合方法可以显著提高模型的准确性和可靠性。理解拟合与插值的区别,并掌握常用的拟合算法及其应用场景,对于进行有效的数据建模和分析至关重要。

最小二乘法在不同数据分布下的性能表现如何?

最小二乘法(Least Squares Method)是一种常用的统计方法,用于估计线性回归模型中的参数。其基本思想是通过最小化误差的平方和来找到最佳拟合曲线或表面。在不同的数据分布下,最小二乘法的表现可能会有所不同。

最小二乘法在处理正态分布数据时表现最佳。这是因为最小二乘法假设误差项服从正态分布,并且具有恒定的方差。在这种情况下,最小二乘估计是最优的,因为它们提供无偏估计并具有最小方差。

尽管最小二乘法主要用于正态分布数据,但它也可以应用于其他类型的数据分布,如指数分布、对数正态分布和威布尔分布。然而,对于这些非正态分布的数据,最小二乘法可能需要进行适当的转换或使用加权最小二乘法以提高其性能。

在帕累托分布中,最小二乘法可能不那么有效,因为它偏向于取值较大的数据点。在这种情况下,广义中位数(GM)等其他方法可能更稳健。

当数据受到有色噪声干扰时,传统的最小二乘法可能不再适用。在这种情况下,递推最小二乘法(RLS)等方法可以提供更快的辨识速度和更好的性能。

在处理多分辨率数据时,多分辨率最小二乘配置法可以有效地提高计算速度和精度。

最小二乘法还可以用于混合数据集的分类问题。例如,在支持向量机(SVM)和决策树(DLSSVDD)的研究中,双最小二乘支持向量数据描述方法被用来提取样本的最小包围超球,并验证了其在不同数据集上的分类精度和效率。

总之,最小二乘法在不同数据分布下的性能表现因数据的具体特性而异。在正态分布数据上表现最佳,在非正态分布数据上可能需要调整或结合其他方法以达到更好的效果。

傅里叶级数拟合在图像处理中的应用案例有哪些?

傅里叶级数拟合在图像处理中的应用案例非常广泛,涵盖了图像分析、增强、压缩等多个方面。以下是一些具体的应用实例:

傅里叶变换可以用于分析图像的频域特性,并通过调整频域中的某些频率成分来改善图像质量。例如,可以通过增加低频成分来使图像变得模糊,或者通过减少高频成分来去除噪声。

在JPEG图像压缩技术中,傅里叶变换被用来将图像分解为不同频率的成分,然后只保留重要的频率成分,从而达到压缩图像的目的。这不仅减少了存储空间,还能够在一定程度上保持图像的质量。

利用傅里叶变换,可以对图像进行频域滤波,以去除特定频率范围内的噪声或干扰信号。例如,低通滤波器可以用来去除高频噪声,而高通滤波器则可以用来突出图像的边缘细节。

傅里叶变换在模式识别中也有重要应用。通过对图像进行傅里叶变换并分析其频谱图,可以提取出图像的特征信息,从而实现自动分类和识别。

在医学影像处理中,傅里叶变换被用于图像重建和增强。例如,在CT扫描和MRI成像中,通过傅里叶变换可以将采集到的数据转换到频域,进而进行图像重建和增强处理。

傅里叶变换还可以应用于物质的电子衍射实验中。通过傅里叶变换,可以将实空间的图像转换到倒易空间,从而捕捉到物质的微观结构信息。

贝叶斯估计法与最大似然估计法在参数估计中的优缺点分别是什么?

贝叶斯估计法和最大似然估计法在参数估计中各有优缺点,具体如下:

最大似然估计法(MLE)

优点:

- 解释性好:最大似然估计通常更易于解释,因为它返回了设计者提供的最佳模型集中的单一最佳模型。

- 收敛性好:即使样本量增加,其计算复杂度相对较低,具有良好的收敛性。

- 简单直接:通过最大化观察到的训练样本的概率来确定最佳参数,方法相对直接。

缺点:

- 对概率模型依赖性强:受概率模型的影响较大,类条件概率模型的选择显得尤为重要。如果假设的类条件概率模型不正确,则可能导致非常差的估计结果。

- 对先验信息的利用不足:最大似然估计只拟合观测到的样本,而没有充分利用先验知识。

- 在有限数据情况下表现不佳:在实际模式识别问题中,由于通常具有有限的训练数据,最大似然估计可能不如贝叶斯估计有效。

贝叶斯估计法(Bayesian Estimation)

优点:

- 利用先验知识:贝叶斯估计假设参数符合某种已知先验概率分布,并通过贝叶斯规则将先验概率密度转化为后验概率密度来估计参数。

- 完整的分布表示:贝叶斯方法给出的是参数的加权平均值,反映了对可能的模型的不确定性,从而提供了更全面的结果。

- 灵活性高:可以灵活运用先验知识,适用于先验信息可靠的场景。

- 减少方差:贝叶斯方法利用了完整的θ|D分布,能够明确偏见和方差权衡的问题,从而提高准确性并减少方差。

缺点:

- 计算复杂度高:由于需要对参数进行积分以估计后验密度,计算复杂度较高。

- 对先验分布的依赖性:当先验分布不均匀或宽泛时,可能导致不同的p(x|D)分布,这需要谨慎选择合适的先验分布。

- 难以理解:贝叶斯方法往往导致更复杂且更难理解的解,尤其是对于初学者来说。

最大似然估计法在解释性和计算复杂度方面有优势,但在处理有限数据和先验信息方面表现不佳;

Gauss-Newton方法在非线性拟合中的具体实现步骤和效果评估。

Gauss-Newton方法在非线性拟合中的具体实现步骤和效果评估如下:

具体实现步骤

-

初始化:

选择一个初始参数值 x0x0,这通常基于对问题的初步了解或经验。

-

计算残差向量:

对于每个数据点,计算模型函数 f(x,θ)f(x,θ) 的残差 ri=yi−f(xi,θ)ri=yi−f(xi,θ),其中 θθ 是待估计的参数。

-

构建误差平方和(SSE):

计算所有残差的平方和,即总误差:SSE=∑i=1nri2SSE=∑i=1nri2。这个值用于衡量模型与实际数据之间的差异。

-

计算雅可比矩阵:

计算雅可比矩阵 J(x,θ)J(x,θ),它是一个 n×pn×p 的矩阵,其中 nn 是观测值的数量,pp 是参数的数量。雅可比矩阵的元素是模型函数对每个参数的偏导数:Jij=∂ri∂θjJij=∂θj∂ri。

-

更新参数:

使用高斯-牛顿迭代公式来更新参数 θθ:Δθ=(JTJ)−1JTrΔθ=(JTJ)−1JTr.然后将新的参数值 θk+Δθθk+Δθ 应用到模型中。

终止条件:

- 迭代直到满足某个收敛条件,例如当连续两次迭代之间的 SSE 差异小于预设的容许误差时停止迭代。

最终结果:

- 输出最终的参数值和对应的 SSE 值,这些值表示了最佳拟合模型。

效果评估

-

最小化 SSE:

最小化 SSE 是评估模型拟合效果的主要指标。较小的 SSE 表示模型更好地拟合了数据。

-

收敛速度:

高斯-牛顿方法通常具有较快的收敛速度,尤其是在问题不是高度非线性的情况下。然而,在某些情况下,可能需要引入阻尼因子以提高收敛性。

-

比较其他方法:

与其他非线性最小二乘法相比,如 Levenberg-Marquardt 方法,高斯-牛顿方法在简单性和计算效率上具有优势,但在处理高度非线性问题时可能不如后者有效。

-

实际应用案例:

在实际应用中,例如VP垂直摆倾斜仪的传递函数拟合中,高斯-牛顿法被证明是有效的,并且能够提供与实际数据非常接近的模型。

三次样条拟合与其他曲线拟合方法相比的优势和局限性。

三次样条拟合在曲线拟合中具有显著的优势和一些局限性。以下是详细的分析:

优势

三次样条曲线能够保证在每个数据点处的平滑连接,使得生成的拟合曲线非常光滑。此外,构造的曲线是二次连续的,这意味着在每两个相邻数据点之间插入一段三次函数,并且这些函数满足一定的数学条件,从而确保整体曲线的平滑性。

通过调整插值点的位置,可以精确地控制拟合曲线的形状。这使得三次样条曲线在需要精细调整的情况下特别有用。

在处理非线性校准曲线时,样条函数表现出色,广泛应用于气相色谱、免疫分析等多种分析方法中。自然三次样条与多项式相比,在边界处表现更好,避免了多项式在某些情况下产生的不良结果。

局限性

现有的三次样条拟合法需要运用矩阵解联立方程组,当数据量大时,矩阵阶数大增,计算和编程的工作量显著增加。此外,时间成本较高,仅适用于小噪声的数据集。

尽管三次样条插值可以保证平滑连接,但在整体拟合时可能会出现振荡现象,特别是在数据点比较稀疏的情况下。

在任何局部的修改都将影响到整条样条函数,这使得对单个数据点的微调变得困难。

当曲线中有直线时,拟合效果不佳,因为三次样条曲线在直线段上无法保持其自然的平滑特性。

![[BJDCTF2020]EasySearch (SSI注入漏洞)](https://i-blog.csdnimg.cn/direct/12de0930c9f348ff99b7195781fce497.png)