每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

点击下面视频观看在B站本周AI更新:

B 站 链接 观看:

本周AI新闻: 开源AI王者归来的一周_哔哩哔哩_bilibili想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅: https://rengongzhineng.io/1) Meta Llama 3.1:https://huggingface.co/collections/meta-l, 视频播放量 3、弹幕量 0、点赞数 0、投硬币枚数 0、收藏人数 0、转发人数 0, 视频作者 内哥谈技术, 作者简介 N哥,新加坡。订阅中文简报,成为AI领域的领跑者。https://rengongzhineng.io/,相关视频:llama3.1国内可直接使用教程,405B堪称最强开源大模型,API无限调用,迪哥带你怎么玩,手把手教你打造自己的大模型!-人工智能、大模型、深度学习、NLP,【2024年7月最新chatgpt】GPT4.0免费使用教程来了,免登录就可以直接使用。,用SD生成的纳雅AI图,本周AI新闻:小型模型井喷,狂暴宇宙【泰坦电视的升级模型】公开,(超爽中英!) 2024公认最全的【吴恩达大模型LLM】系列教程!附代码_LangChain_微调ChatGPT提示词_RAG模型应用_agent_生成式AI,【乐高轨道】豪宅乐高轨道列车事故合集,本周AI新闻:一封前OpenAI研发人员关于AGI的公开信,[AI视频]随手拍的一张医院走廊的照片让ai走出去,结果ai最终迷失在了自己创造的空间里,这可能是B站最新的MATLAB教程了!花3小时就能从入门到精通,能听懂人话就行,包教包会!![]() https://www.bilibili.com/video/BV1Xw4m1k7eB/?vd_source=a981b02467f9b48eb47a3843e6a9ca16

https://www.bilibili.com/video/BV1Xw4m1k7eB/?vd_source=a981b02467f9b48eb47a3843e6a9ca16

1) Meta Llama 3.1:https://huggingface.co/collections/meta-llama/llama-31-669fc079a0c406a149a5738f

2) https://www.meta.ai/

3) Mistral large 2: https://huggingface.co/mistralai/Mistral-Large-Instruct-2407

4) https://mistral.ai/news/la-plateforme/

5) Apple: https://huggingface.co/apple/DCLM-7B 6) Google Flash 1.5 https://deepmind.google/technologies/gemini/flash/

Meta Llama 3.1

Meta 发布了 Llama 3.1,这是有史以来最大的开源 AI 模型 ( 下载:https://huggingface.co/collections/meta-llama/llama-31-669fc079a0c406a149a5738f)。公司声称,其性能在多个基准测试中超越了 GPT-4o 和 Anthropic 的 Claude 3.5 Sonnet。Llama 3.1 还将 Meta 的 AI 助手扩展到更多国家和语言,并增加了一个可以基于个人相貌生成图像的功能。Meta CEO 马克·扎克伯格预测,到今年年底,Meta AI 将成为最广泛使用的助手,超越 ChatGPT。

Llama 3.1 比几个月前发布的较小版本复杂得多。最大的版本有 4050 亿个参数,训练过程使用了超过 16000 台昂贵的 Nvidia H100 GPU。尽管 Meta 没有公开 Llama 3.1 的开发成本,但根据这些 Nvidia 芯片的价格,可以推测成本高达数亿美元。

那么,考虑到高昂的成本,Meta 为什么继续以只需公司拥有数亿用户批准的许可证免费发布 Llama 呢?在 Meta 公司博客上发布的一封信中,扎克伯格认为,开源 AI 模型将超过并且已经比私有模型进步得更快,就像 Linux 成为主导大多数手机、服务器和设备的开源操作系统一样。

扎克伯格将 Meta 在开源 AI 上的投资比作早期的开放计算项目,他表示,通过让 HP 等外部公司帮助改进和标准化数据中心设计,Meta 节省了“数十亿”美元。他展望未来,预期 AI 领域也会出现同样的动态,他写道,“Llama 3.1 的发布将成为行业的一个拐点,届时大多数开发者将主要使用开源。”

为了推广 Llama 3.1,Meta 正与包括微软、亚马逊、谷歌、Nvidia 和 Databricks 在内的二十多家公司合作,帮助开发者部署自己的版本。Meta 声称,Llama 3.1 的运行成本大约是 OpenAI GPT-4o 的一半。公司还发布了模型权重,允许企业根据自定义数据进行训练和调优。

令人意外的是,Meta 对用于训练 Llama 3.1 的数据守口如瓶。AI 公司表示不披露此信息是因为它是商业秘密,而批评者则认为这是为了拖延不可避免的版权诉讼。Meta 透露的是,它使用了合成数据,即由模型生成而非人类生成的数据,以提高 4050 亿参数的 Llama 3.1 和较小的 700 亿和 80 亿版本。Meta 的生成 AI 副总裁 Ahmad Al-Dahle 预测,Llama 3.1 将成为开发者的热门选择,作为“部署较小模型的教师”以更具成本效益的方式运作。

关于行业是否将面临高质量训练数据短缺的问题,Al-Dahle 认为可能会达到天花板,但这可能比一些人预测的要晚。他表示,“我们肯定认为还可以再进行几次 [训练]。”但具体情况难以预测。

Meta 的红队测试首次包括了 Llama 3.1 的潜在网络安全和生物化学应用。Meta 还对模型进行了更严格的测试,因其表现出一些“自主”行为。比如,Llama 3.1 可以结合搜索引擎 API,根据复杂查询从互联网上检索信息,并连续调用多个工具完成任务。另一个例子是它可以根据要求检索并生成美国过去五年售出的房屋数量的 Python 代码并执行。

Llama 3.1 将首先通过 WhatsApp 和 Meta AI 网站在美国上线,接下来是 Instagram 和 Facebook,并增加对法语、德语、印地语、意大利语和西班牙语的支持。

Llama 3.1 最先进的 4050 亿参数模型在 Meta AI 中可免费使用,但在达到一周内未指明的提示次数后,会切换到缩减版的 700 亿模型。Meta 表示,将在评估早期使用情况后提供更多信息。

Meta AI 的图像生成功能还包括一个新功能“Imagine Me”,通过手机摄像头扫描面部,以生成包含用户相貌的图像。这样,Meta 希望避免创建深度伪造机器。公司认为用户希望创建更多类型的 AI 媒体并分享,即使这模糊了真实与否的界限。

Meta AI 也将在未来几周内登录 Quest 头显,取代其语音命令界面。用户可以使用 Meta AI 在头显的透视模式中识别和了解现实世界中的物体。

尽管扎克伯格预测 Meta AI 将成为今年年底前使用最广泛的聊天机器人,但 Meta 尚未公布其助手的使用数据。Al-Dahle 表示,“整个行业在产品市场契合度上仍处于早期阶段”。尽管 AI 已经显得过度炒作,但显然 Meta 和其他公司认为这场竞赛才刚刚开始。

Mistral Large 2

Mistral Large 2拥有128k的上下文窗口,支持包括法语、德语、西班牙语、意大利语、葡萄牙语、阿拉伯语、印地语、俄语、中文、日语和韩语在内的多种语言,还支持超过80种编程语言,包括Python、Java、C、C++、JavaScript和Bash。

Mistral Large 2专为单节点推理和长上下文应用设计,具备1230亿参数,能够在单节点上实现大吞吐量。Mistral Large 2在Mistral Research License下发布,允许研究和非商业用途的使用和修改。商业用途需获取Mistral Commercial License,通过联系我们获取。

综合性能

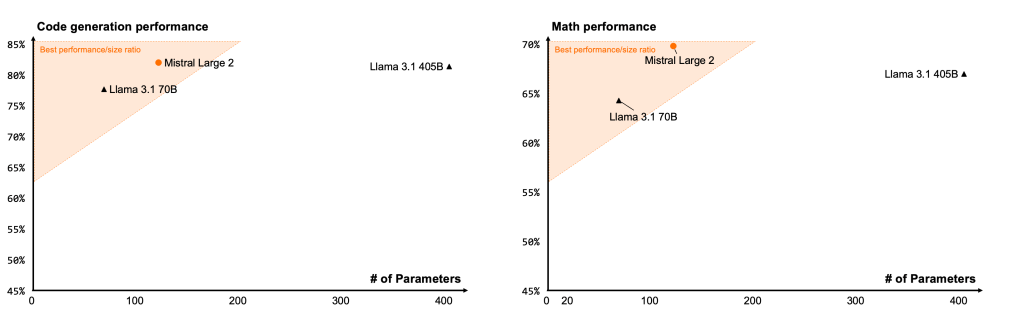

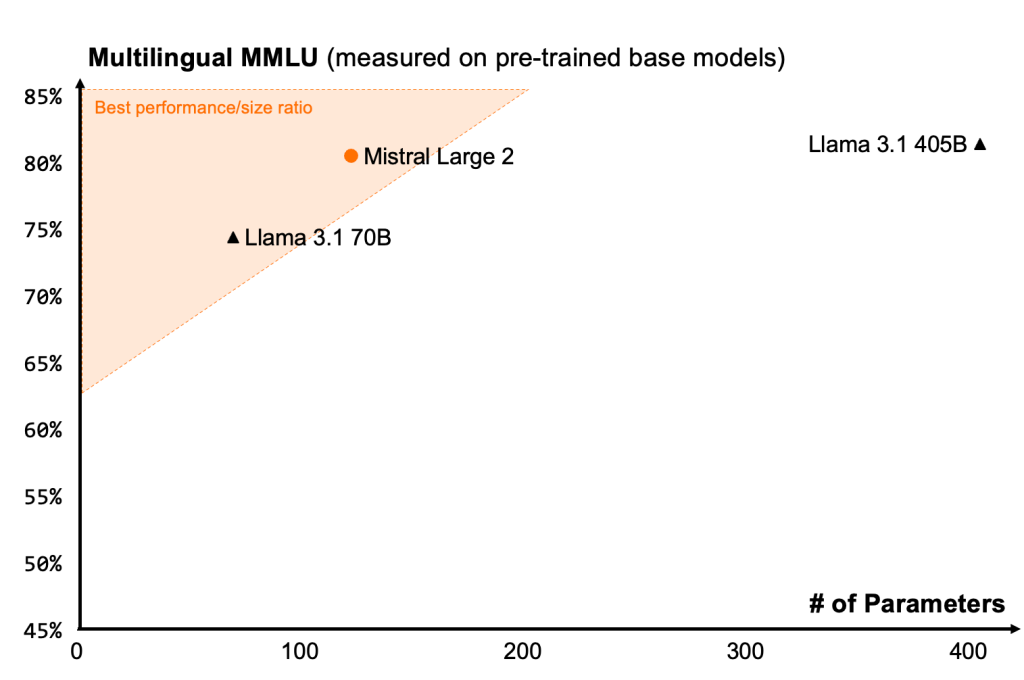

Mistral Large 2在性能和成本方面设立了新的标准。特别是在MMLU评估中,预训练版本达到了84.0%的准确率,刷新了开源模型在性能/成本比上的记录。

代码和推理能力

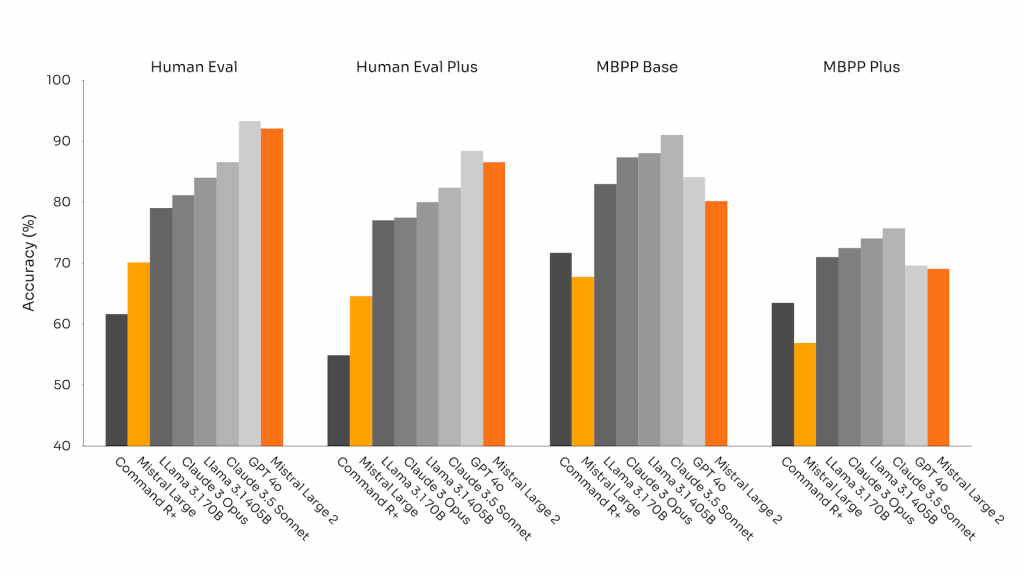

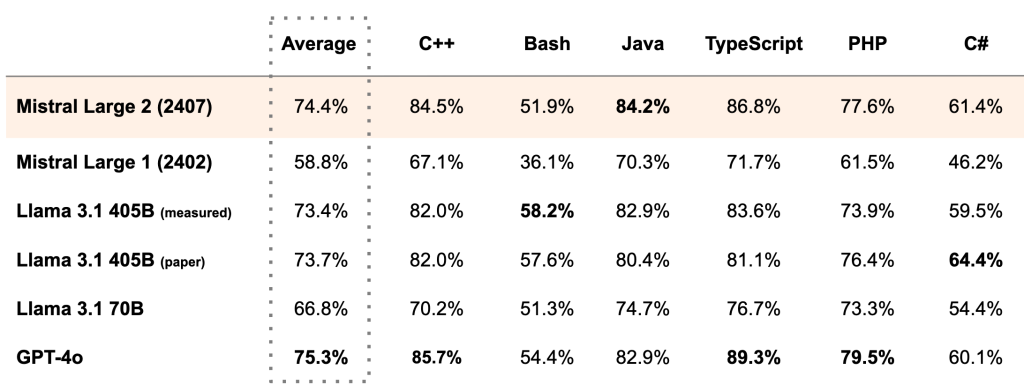

借鉴Codestral 22B和Codestral Mamba的经验,Mistral Large 2在大量代码数据上进行训练,表现远超之前的Mistral Large,并且与领先的模型如GPT-4o、Claude 3 Opus和Llama 3 405B表现相当。

详细基准测试

大量精力也用于提升模型的推理能力,重点减少模型“幻觉”生成错误信息的倾向,通过细致的调整使模型在回应时更加谨慎和可靠。此外,Mistral Large 2能够在无法找到解决方案或没有足够信息时,主动承认这一点。这种对准确性的承诺在数学基准测试中表现得尤为明显,展示了其增强的推理和解决问题的能力。

指令执行和对齐

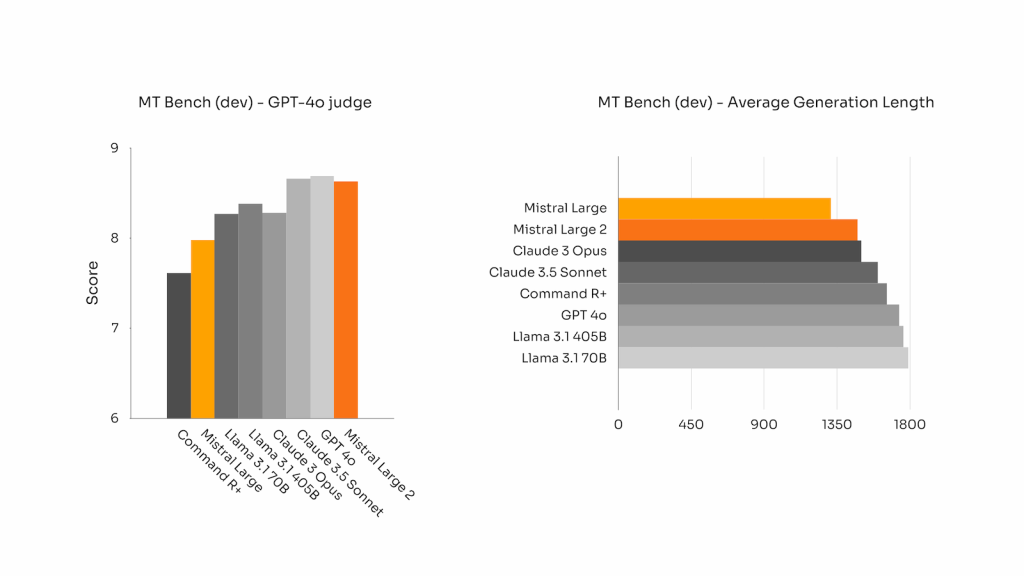

Mistral Large 2的大幅改进在于其指令执行和对话能力,尤其在精确指令的遵循和长对话处理上表现优异。下图展示了MT-Bench、Wild Bench和Arena Hard基准测试中的表现:

语言多样性

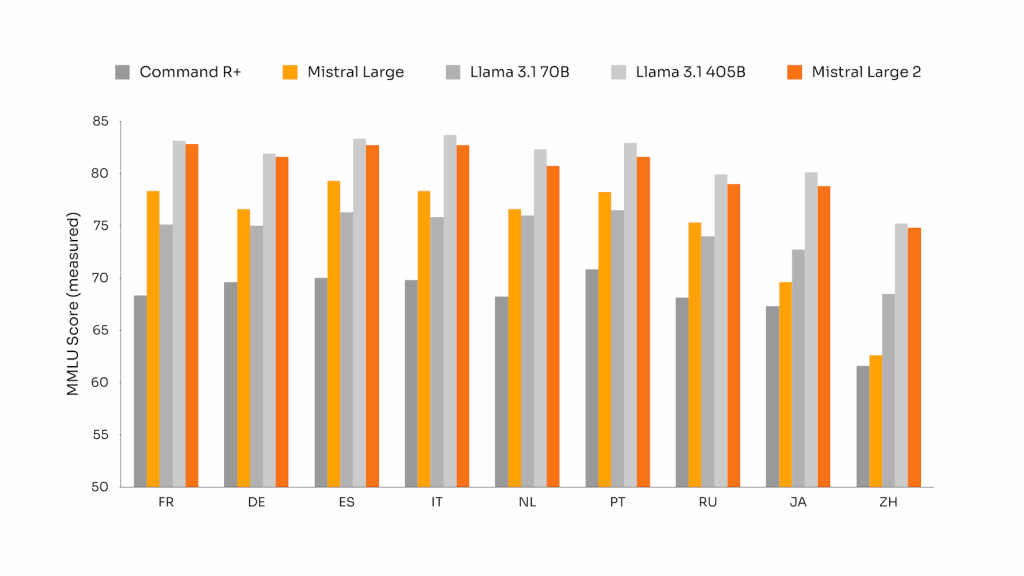

如今,许多商业用例涉及多语言文档处理。虽然大多数模型以英语为主,新版Mistral Large 2在多语言数据上进行了大量训练,特别擅长处理英语、法语、德语、西班牙语、意大利语、葡萄牙语、荷兰语、俄语、中文、日语、韩语、阿拉伯语和印地语。下图展示了Mistral Large 2在多语言MMLU基准测试中的表现,与之前的Mistral Large、Llama 3.1模型和Cohere’s Command R+进行了对比。

工具使用和函数调用

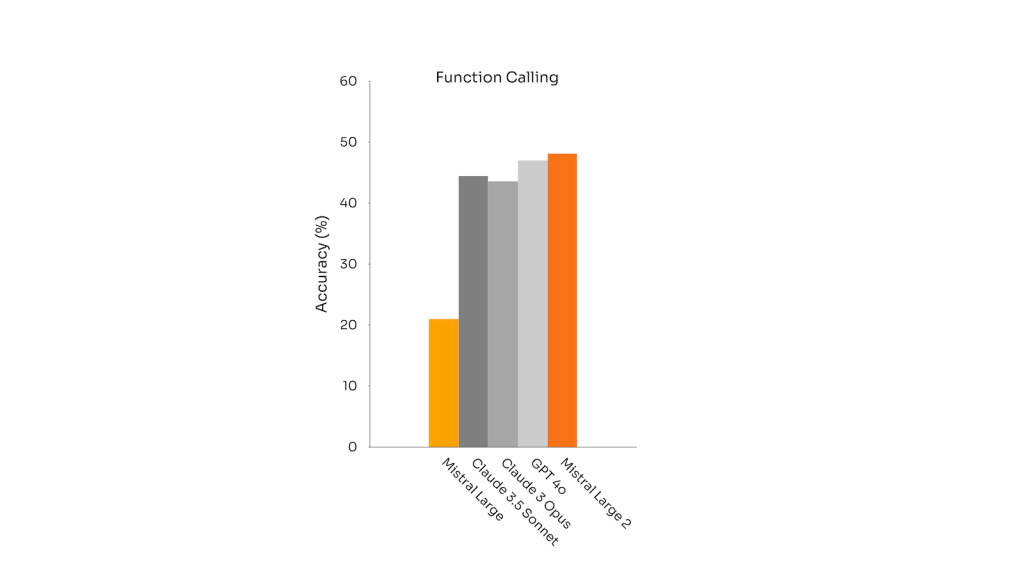

Mistral Large 2具备增强的函数调用和检索技能,经过训练可以高效执行并行和顺序函数调用,使其成为复杂业务应用的强大引擎。

试用Mistral Large 2

今天起,用户可以在la Plateforme平台上使用名称为mistral-large-2407的Mistral Large 2,并在le Chat上测试 (https://console.mistral.ai/)。它在24.07版本(我们对所有模型采用的YY.MM版本系统)下可用,API名称为mistral-large-2407。指令模型的权重也可在HuggingFace上获取。(https://huggingface.co/mistralai/Mistral-Large-Instruct-2407)

在la Plateforme平台上整合了两种通用模型:Mistral Nemo和Mistral Large,以及两种专业模型:Codestral和Embed。随着旧模型逐步淘汰,所有Apache模型(如Mistral 7B、Mixtral 8x7B和8x22B、Codestral Mamba、Mathstral)仍可通过mistral-inference和mistral-finetune SDK进行部署和微调。从今天起,la Plateforme平台上将扩展微调能力,现在可用于Mistral Large、Mistral Nemo和Codestral模型。