目录

1 ChatGLM-6B模型简介:

2 LLaMA模型简介:

3 BLOOM模型简介

4 Baichuan-7B模型

随着ChatGPT迅速火爆,引发了大模型的时代变革,国内外各大公司也快速跟进生成式AI市场,近百款大模型发布及应用。开源语言大模型种类有以下4个:

1 ChatGLM-6B模型简介:

ChatGLM-6B 是清华大学提出的一个开源、支持中英双语的对话语言模型,基于General LanguageModel (GLM) 架构,具有 62 亿参数.该模型使用了和 ChatGPT 相似的技术,经过约 1T 标识符的中英双语训练(中英文比例为1:1),辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答(目前中文支持最好).

GLM是一种基于自回归空白填充目标的通用预训练框架. GLM 将 NLU 任务转化为包含任务描述的完形填空问题,可以通过自回归生成的方式来回答.

原理:在输入文本中随机挖去一些连续的文本片段,然后训练模型按照任意顺序重建这些片段.

完形填空问题是指在输入文本中用一个特殊的符号(如[MASK])替换掉一个或多个词,然后训练模型预测被替换掉的词.

优点:较低的部署门槛: INT4 精度下,只 需6GB显存,使得 ChatGLM-6B 可 以部署在消费级显卡上进行推理. 更长的序列长度: 相比 GLM-10B (序列长度1024),ChatGLM2-6B 序列长度达32K,支持更长对话和应 用。 人类类意图对齐训练。

缺点:模型容量小,相对较弱的模型记忆和语言能力。 多轮对话能力较弱。

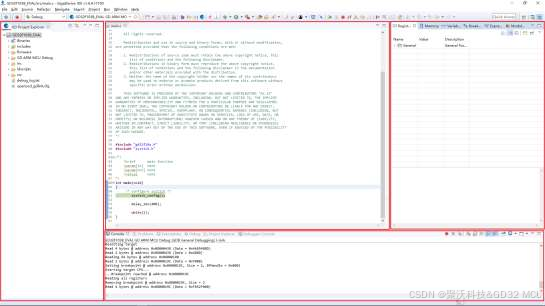

模型配置(6B)与硬件要求:

2 LLaMA模型简介:

LLaMA(Large Language Model Meta AI),由 Meta AI 于2023年发布的一个开放且高效的大型基础语言模型,共有 7B、13B、33B、65B(650 亿)四种版本. LLaMA训练数据是以英语为主的拉丁语系,另外还包含了来自 GitHub 的代码数据。训练数据以英文为主,不包含中韩日文,所有训练数据都是开源的。其中LLaMA-65B 和 LLaMA-33B 是在 1.4万亿 (1.4T) 个token上训练的,而最小的模型 LLaMA-7B 和LLaMA-13B 是在 1万亿 (1T) 个 token 上训练的.

LLaMA 的训练目标是语言模型,即根据已有的上文去预测下一个词

优点 : 具有 130 亿参数的 LLaMA 模型 「在大多数基准上」可以胜过 GPT-3( 参数量达 1750 亿). 可以在单块 V100 GPU 上运行; 而最大的 650 亿参数的 LLaMA 模型可以媲美谷歌的 Chinchilla70B 和 PaLM-540B.

缺点:会产生偏见性、有毒或者虚假的内容. 在中文上效果差,训练语料不包含中文或者一个汉字切分为多个token,编码效率低,模型学习难度大.

模型配置(7B)与硬件要求:

3 BLOOM模型简介

BLOOM系列模型是由 Hugging Face公司训练的大语言模型. 训练数据包含了英语、中文、法语、西班牙语、葡萄牙语等共 46 种语言,另外还包含 13 种编程语言. 1.5TB 经过去重和清洗的文本,其中中文语料占比为16.2%. 按照模型参数量,BLOOM 模型有 560M、1.1B、1.7B、3B、7.1B 和 176B 这几个不同参数规模的模型.

BLOOM 的训练目标是语言模型,即根据已有的上文去预测下一个词

优点:具有良好的多语言适 应性,能够在多种语 言间进行切换,且无 需重新训练.

缺点:会产生偏见性、有毒或者虚假的内容.

模型配置(176B)与硬件要求

4 Baichuan-7B模型

Baichuan-7B由百川智能于2023年6月发布的一个开放且可商用的大型预训练语言模型,其支持中英双语,是在约 1.2万亿 (1.2T) 个 token上训练的70亿参数模型.

Baichuan-7B 的训练目标也是语言模型,即根据已有的上文去预测下一个词。

模型配置(7B)与模型特点: