一、需求描述

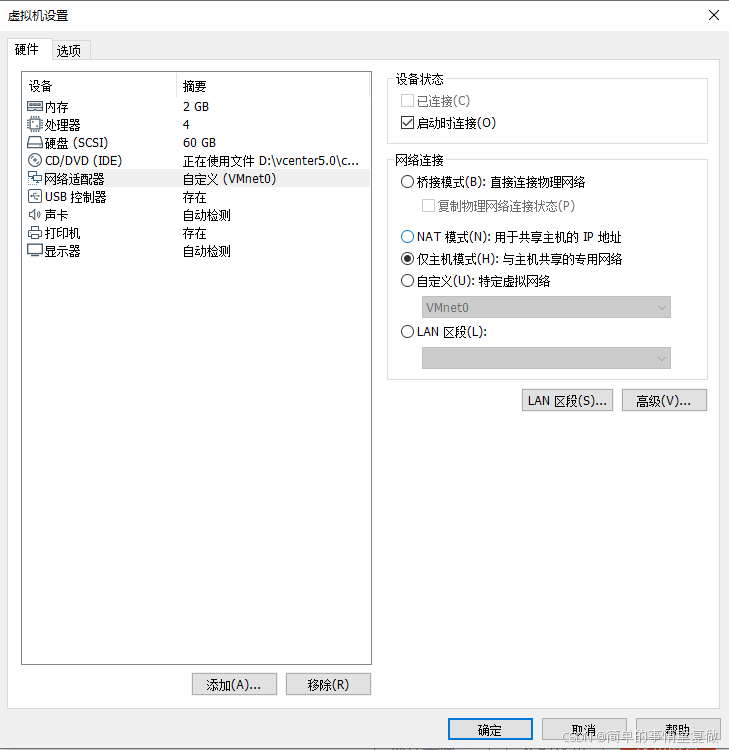

给Hadoop集群动态扩容一个节点

那么,这个节点是全新的,我们需要做哪些准备工作,才能将它融入集群了?

二、初始化配置

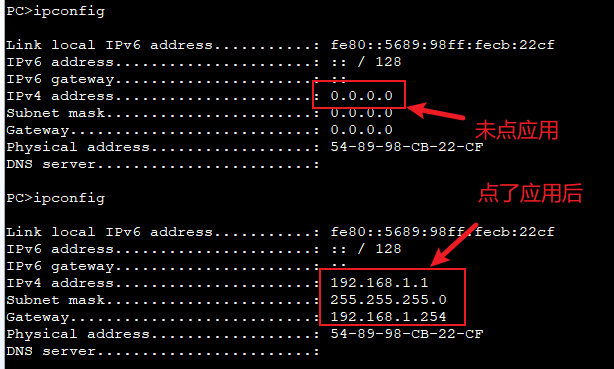

1、修改IP和hostname

vim /etc/sysconfig/network-scripts/ifcfg-ens33

vim /etc/hostname

2、复制102的hadoop、jdk安装包和环境变量文件

复制安装包,可以用普通账号进行复制

scp -r module/* atguigu@hadoop105:/opt/module/

复制环境变量文件,必须用root权限进行复制

sudo scp /etc/profile.d/my_env.sh root@hadoop105:/etc/profile.d/my_env.sh

新节点上

source /etc/profile

3、新节点上删除data和logs目录

cd /opt/module/hadoop-3.1.3

rm -rf data/ logs/

4、配置各个节点到新增节点的免密登陆

102、103、104到新节点的免密登陆

cd /home/atguigu/.ssh

ssh-copy-id hadoop105

ssh atguigu@hadoop105 验证免密登陆

5、修改Hadoop集群配置文件

在workers文件中,加入新节点域名

在whitelist文件中,加入新节点域名

在blacklist文件中,确保没有新节点域名

cd /opt/module/hadoop-3.1.3/etc/hadoop

vim workers

vim whitelist

vim blacklist

6、修改常用的集群工具文件

这里主要是修改jpsall、xsync文件

加入新节点的域名

cd /home/atguigu/bin/