目录

前言

一、Ollama 简介

1、什么是Ollama

2、特点:

二、Windows部署

1.下载

2.安装

3.测试安装

4.模型部署:

5.注意

三、 Docker部署

1.docker安装

2.ollama镜像拉取

3.ollama运行容器

4.模型部署:

5.注意:

总结

前言

最近,自己在学习一些大模型的相关知识,所以近期会不定时更新大模型的实操指南,这里为LLM系列第一篇文章,主要内容是在本地搭建自己的LLM服务。

随着AI的发展,越来越多的开软软件供我们选择,如:Hugging Face 、Transformers、LangChain、Ollama、vllm等,本篇以O llama为例,在本地搭建自己的大模型服务。话不多说,正文开始。

一、Ollama 简介

官网地址:ollama官网

1、什么是Ollama

Ollama 是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计,极大地简化了大模型在本地运行的过程。对用户来说,只需要通过执行几条命令就能在本地运行开源大模型,如qwen、llama等。

2、特点:

- 简化部署:Ollama 目标在于简化在 Docker 容器中部署大型语言模型的过程,使得非专业用户也能方便地管理和运行这些复杂的模型。

- 轻量级与可扩展:作为轻量级框架,Ollama 保持了较小的资源占用,同时具备良好的可扩展性,允许用户根据需要调整配置以适应不同规模的项目和硬件条件。

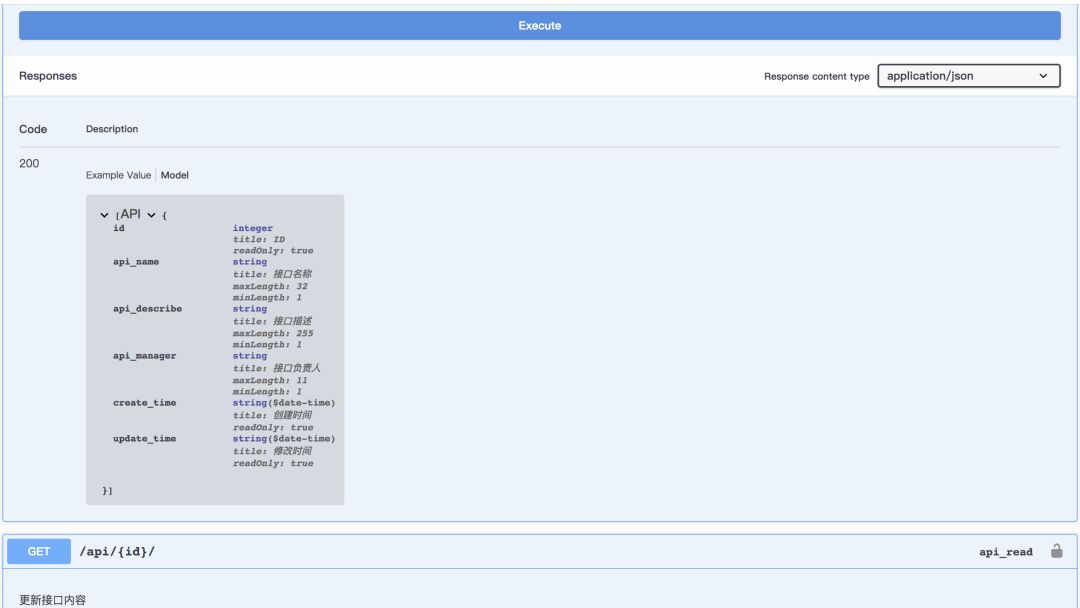

- API支持:提供了一个简洁的 API,使得开发者能够轻松创建、运行和管理大型语言模型实例,降低了与模型交互的技术门槛。

- 预构建模型库:包含一系列预先训练好的大型语言模型,用户可以直接选用这些模型应用于自己的应用程序,无需从头训练或自行寻找模型源。

- 跨平台支持:提供针对 macOS、Windows(预览版)、Linux 以及 Docker 的安装指南,确保用户能在多种操作系统环境下顺利部署和使用 Ollama。

二、Windows部署

1.下载

进入目录一中给出的ollama的官网,然后选择你安装的版本即可:

Windows下应该是

![]()

2.安装

windows下双击上边的exe文件,选择install安装即可.

3.测试安装

进入到cmd下,输入Ollama,出现下列内容则证明安装成功,安装成功后,该服务会开机自启,不需要每次手动运行

4.模型部署:

直接cmd命令行里输入ollama run xxx(xxx为你要部署的模型名字,如)即可。同时,大家也可以前往ollama官网查看支持的模型,如下:

在红框中搜索你想要部署的模型,如qwen2

选择模型大小,然后复制右侧命令到cmd中即可,运行成功的界面如下:

5.注意

- Windows下模型默认下载到 C:\Users\%username%\.ollama\models下,如果你要更改,需要在电脑“高级环境变量”中创建一个新的变量OLLAMA_MODELS,如下:

模型将会保存在D:\ollama\models下

- 监听端口默认为11434,如果你要更改默认端口,同上,在环境变量中新增OLLAMA_HOST,如下:

这样修改之后,你本地请求ip:1006即可。

- 如果按照以上方式修改了环境变量,记得重启ollama服务,否则不会生效。

三、 Docker部署

1.docker安装

这部部分自行百度下,网上很多教程,需要注意的是,如果你电脑有gpu的话记得去安装docker的gpu版本。

2.ollama镜像拉取

docker pull ollama/ollama3.ollama运行容器

CPU 下:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollamaGPU下:

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama其中, -v ollama:/root/.ollama表示你要将本地的ollama目录挂载到容器中,该目录可自己指定,是用来存放模型的。最好自己创建下。--name. ollama为容器名,也可以自己指定

4.模型部署:

部署方式同二.4中,即直接ollama run xxx即可,x x x是你要部署的模型型号。

5.注意:

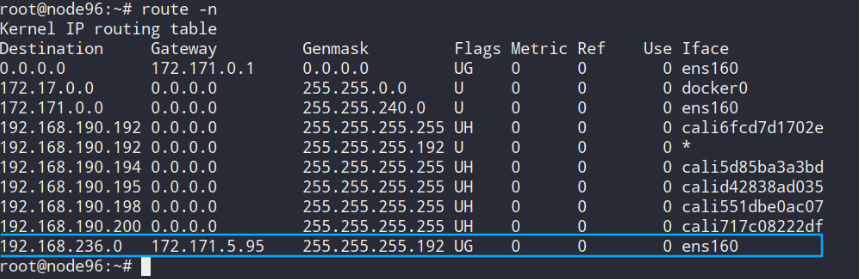

- 当你想使用所有的gpu时,则执行3中的命令即可,如果要指定gpu,执行下列命令:

-

docker run -d --gpus "device=7" -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama - 如果你更改监听端口,则执行下列命令:

-

docker run -d --gpus=all -v ollama:/root/.ollama -p xxx:11434 --name ollama ollama/ollama

其中,x x x即为你要监听的本机端口号

总结

以上就是本篇全部内容,后续会不定时更新该系列文章,如果觉的有用的话,别忘了三连🐶