在机器学习中,评估分类模型的性能是至关重要的环节。选择合适的评估指标能够帮助我们全面了解模型的表现,尤其是在不同的数据分布和应用场景下。下面详细介绍一些常用的分类模型评估指标。

混淆矩阵(confusion matrix)是模式识别领域中一种常用的表达形式。它描绘样本数据的真实属性与识别类型之间的关系,是评价分类器性能的一种常用方法。

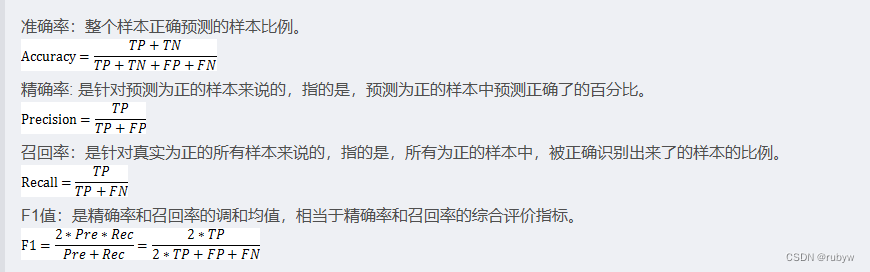

分类模型对测试集进行预测而得出的准确率并不能很好地反映模型的性能,为了有效判断一个预测模型的性能表现,需要结合真实值,计算出准确率,精确率,召回率,F1值等指标来衡量。

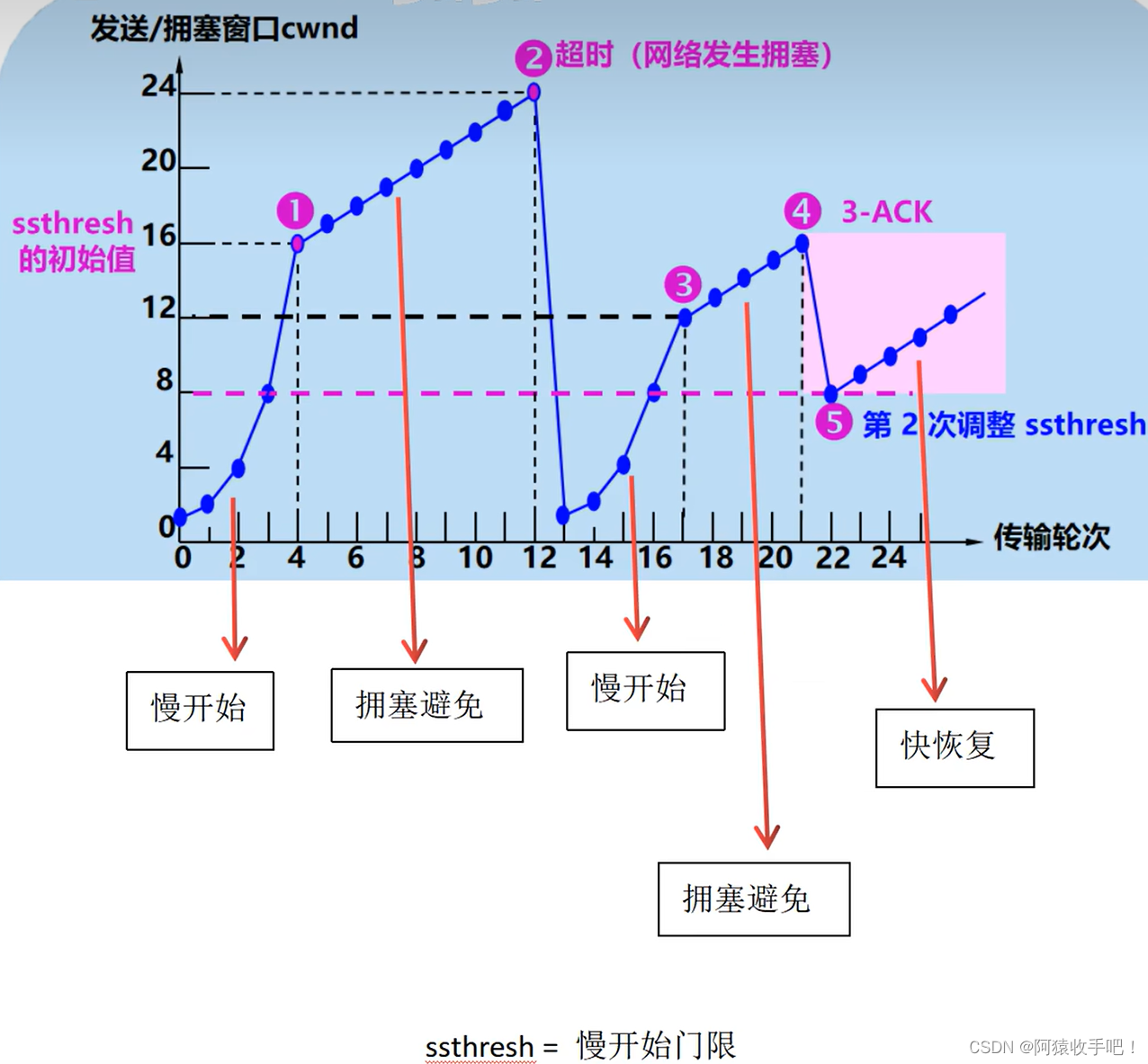

ROC图像同样是一种比较常见的用于数据挖掘的模型评估图,它指受试者工作特征曲线,在ROC中,真正率(TPR)沿y轴绘制,而假正率(FPR)显示在x轴上,ROC曲线下的面积值在1.0和0.5之间。在AUC>0.5的情况下,AUC越接近于1,说明诊断效果越好。AUC<0.5不符合真实情况,在实际中极少出现。

1. 准确率 (Accuracy)

准确率是最简单和直观的评估指标,表示分类正确的样本占总样本的比例。

- 优点:简单易懂。

- 缺点:在类别不平衡的情况下,容易产生误导。例如,当正负样本比例极度不平衡时,模型即使预测所有样本为多数类,也可能得到较高的准确率。

2. 精确率 (Precision)

精确率表示模型预测为正类的样本中,实际为正类的比例。

- 优点:在关注预测结果为正类时的正确性(如垃圾邮件检测)时,精确率是一个重要指标。

- 缺点:忽略了实际正类样本中有多少被正确预测。

3. 召回率 (Recall)

召回率表示实际为正类的样本中,模型正确预测为正类的比例。

- 优点:在关注所有正类样本都被正确识别时(如疾病检测),召回率是一个重要指标。

- 缺点:忽略了预测为正类的样本中有多少是错误的。

4. F1-score

F1-score 是精确率和召回率的调和平均,综合考虑了二者的表现。

- 优点:在类别不平衡的情况下,比单独使用精确率或召回率更能全面反映模型性能。

- 缺点:无法同时优化精确率和召回率的具体值。

5. ROC曲线和AUC值

ROC曲线(Receiver Operating Characteristic Curve)绘制了不同阈值下,真正率(TPR)与假正率(FPR)的关系。AUC(Area Under the ROC Curve)表示ROC曲线下的面积,是一个综合评价指标。

-

TPR (True Positive Rate):即召回率。

-

FPR (False Positive Rate):

[ \text{FPR} = \frac{FP}{FP + TN} ]

-

优点:不受类别不平衡影响,全面反映模型在不同阈值下的性能。

-

缺点:计算复杂度较高,解释起来可能不直观。

6. 精确率-召回率曲线 (Precision-Recall Curve) 和 AP值

精确率-召回率曲线绘制了不同阈值下,精确率与召回率的关系。AP(Average Precision)是精确率-召回率曲线下的面积。

- 优点:在类别不平衡情况下,比ROC曲线更能反映模型性能。

- 缺点:主要适用于二分类问题,多分类问题需扩展应用。

7. 分类报告 (Classification Report)

分类报告汇总了准确率、精确率、召回率、F1-score等指标,通常用于多分类问题的评估。

from sklearn.metrics import classification_report

# 假设 y_true 是真实标签,y_pred 是预测标签

print(classification_report(y_true, y_pred))

8. Log-Loss (对数损失)

对数损失衡量模型输出的概率分布与实际标签的差异,是评估概率预测模型的指标。

- 优点:考虑了预测的概率值,比单纯的分类结果更细致。

- 缺点:对极值敏感,可能受到异常值的影响。

10. Matthews 相关系数 (MCC)

MCC 是综合考虑TP、TN、FP、FN的评估指标,适用于类别不平衡问题。

- 优点:在类别不平衡情况下,提供更全面的评估。

- 缺点:计算较为复杂,解释起来不直观。

选择合适的评估指标

选择评估指标时,应根据具体应用场景和任务目标考虑:

- 如果关注整体分类效果,准确率是一个简单的指标。

- 在类别不平衡情况下,F1-score、ROC-AUC 和 PR-AUC 更能反映模型性能。

- 需要详细了解分类结果分布时,混淆矩阵和分类报告是有效工具。

- 在概率预测任务中,Log-Loss 提供了更细致的评估。

通过结合使用多个评估指标,可以更全面地了解分类模型的性能,进而指导模型的优化和改进。