上一篇文章,我们详细讲解了Py-Spy这个性能分析和优化工具的使用流程;今天,我们将深入探讨另一个性能分析和优化工具——scalene。

什么是scalene?

scalene是一个高精度的Python性能分析工具,可以对CPU和内存使用情况进行详细分析,并生成性能报告和可视化图表;它提供了许多强大的功能,包括:

- 高精度的CPU和内存分析

- 支持采样和分析Python代码的内存分配

- 提供详细的性能报告和可视化图表

- 能够区分Python和本地代码的时间消耗

- 支持多线程和多进程应用程序

这些特性使得scalene成为开发者进行性能调优的利器。

安装scalene

首先,我们需要安装scalene。可以通过pip进行安装:

pip3 install scalene

安装完成后,可以通过命令行工具scalene进行使用。

使用scalene进行性能分析

假设我们有一个名为scalene_demo.py的Python脚本:

import time

import numpy as np

def process_data(data):

result = []

for item in data:

result.append(item * 2)

return result

def main():

data = np.random.rand(1000000)

start_time = time.time()

process_data(data)

print(f"Processing took {time.time() - start_time} seconds")

if __name__ == "__main__":

main()

我们可以使用scalene对其进行分析:

scalene example.py

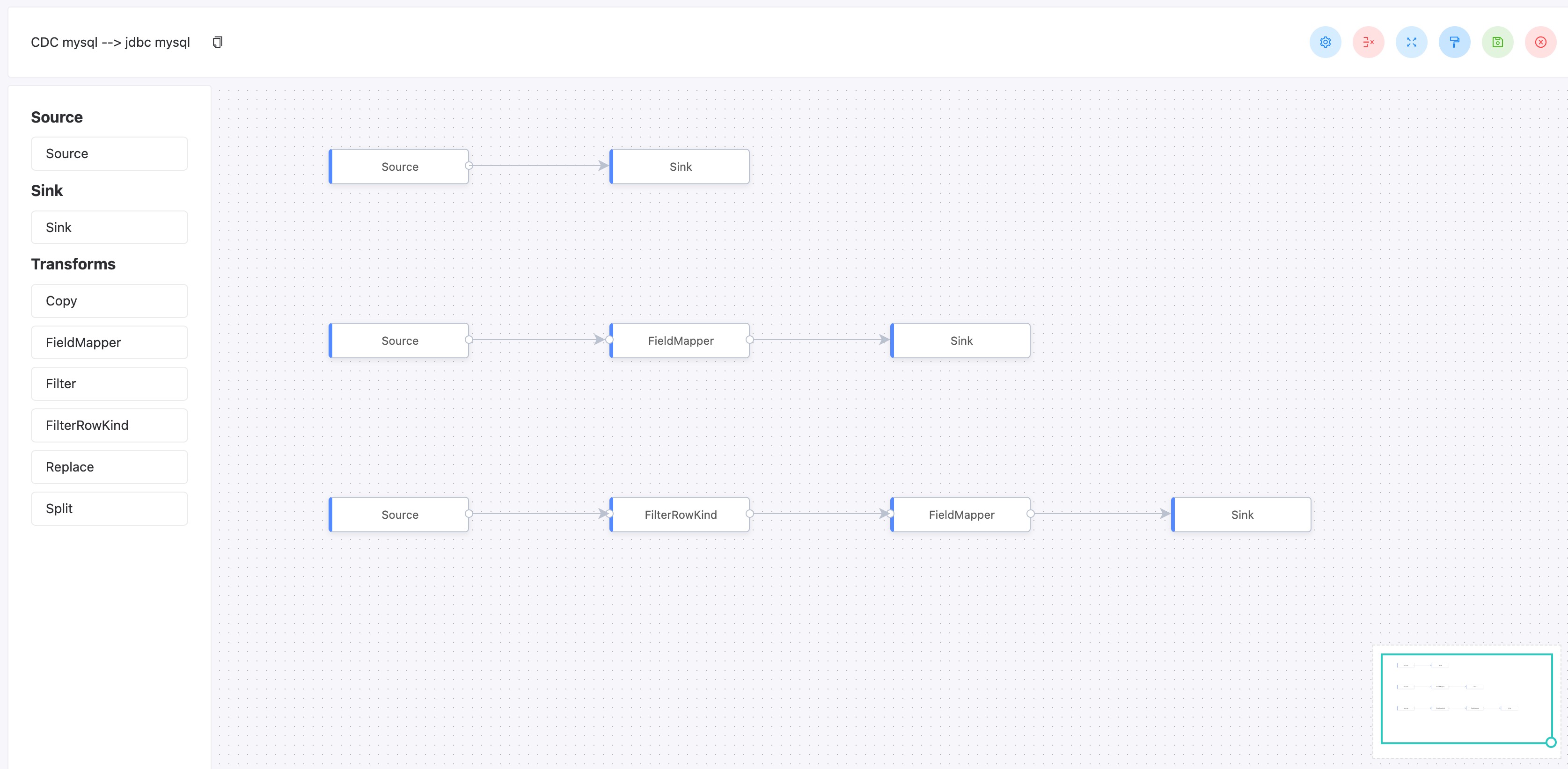

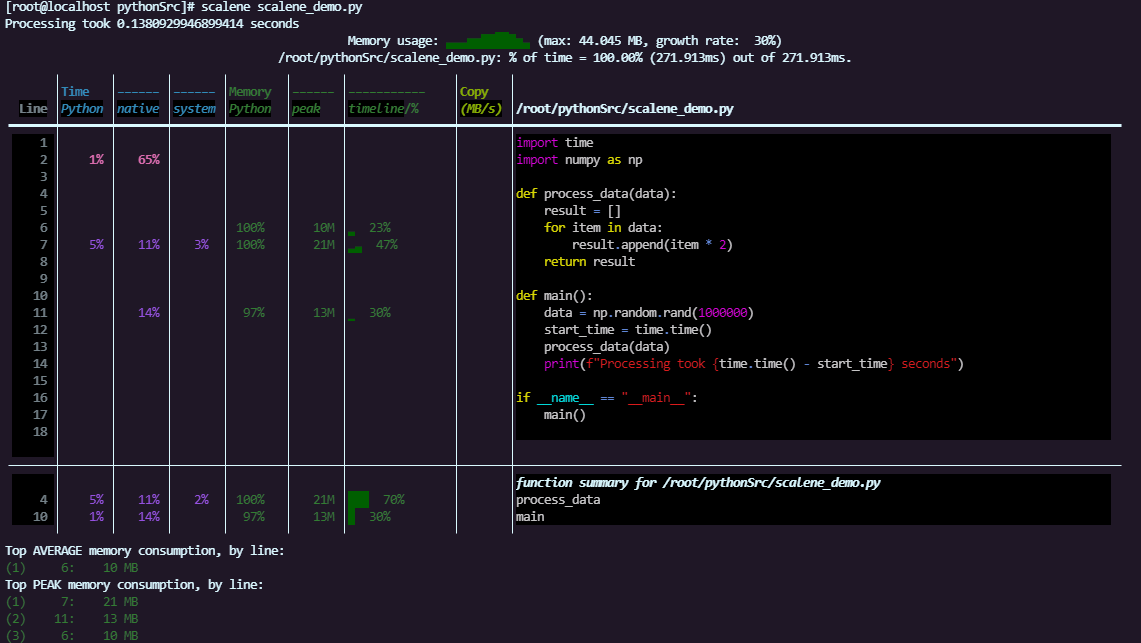

scalene将生成一个详细的性能报告,显示每行代码的CPU和内存使用情况(这是在类Linux下的命令输出,如果在windows下,加不加--html参数,都是以浏览器的方式呈现性能分析报告):

生成详细的性能报告

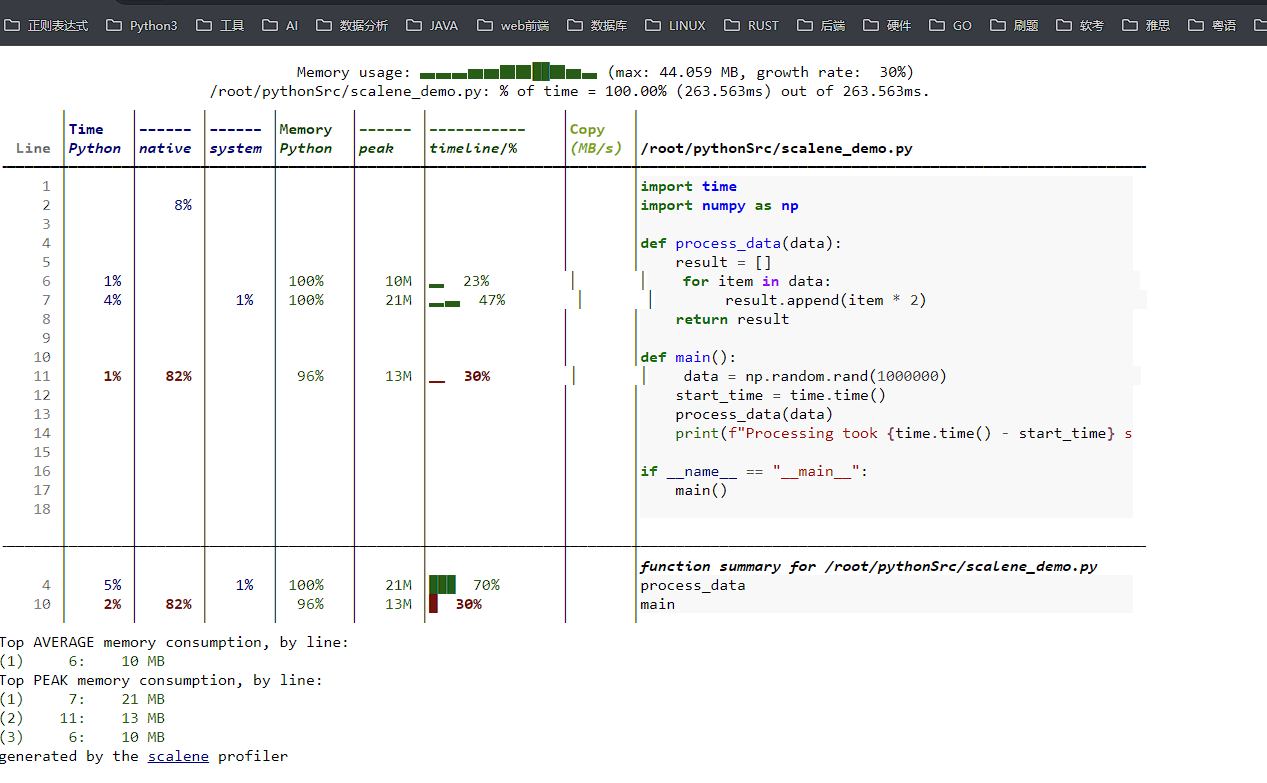

scalene不仅可以生成命令行报告,还可以生成详细的HTML报告,方便查看和分析:

scalene --html --outfile profile.html scalene_demo.py

该命令将在当前目录下生成一个HTML报告文件,打开这个文件即可查看详细的性能分析结果:

实战示例:优化数据处理程序

让我们通过一个实际的示例,演示如何使用scalene进行性能分析和优化,假设我们有一个数据处理程序:

import time

import numpy as np

def compute(data):

result = []

for item in data:

result.append(np.sin(item) ** 2 + np.cos(item) ** 2)

return result

def main():

data = np.random.rand(1000000)

start_time = time.time()

compute(data)

print(f"Computation took {time.time() - start_time} seconds")

if __name__ == "__main__":

main()

我们可以使用scalene进行详细分析:

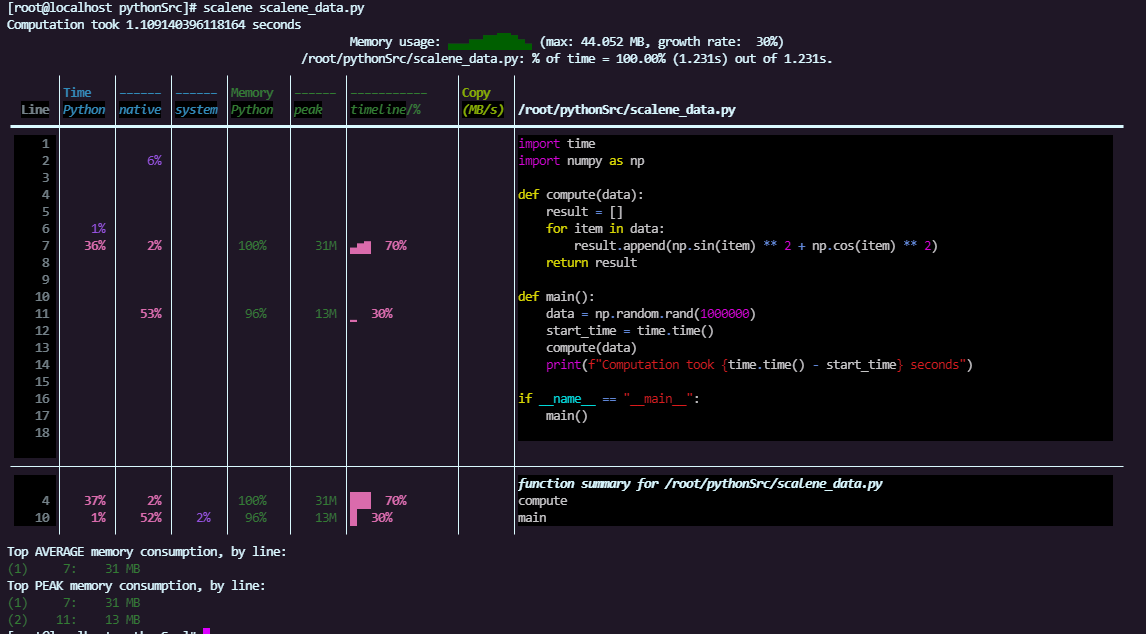

scalene scalene_data.py

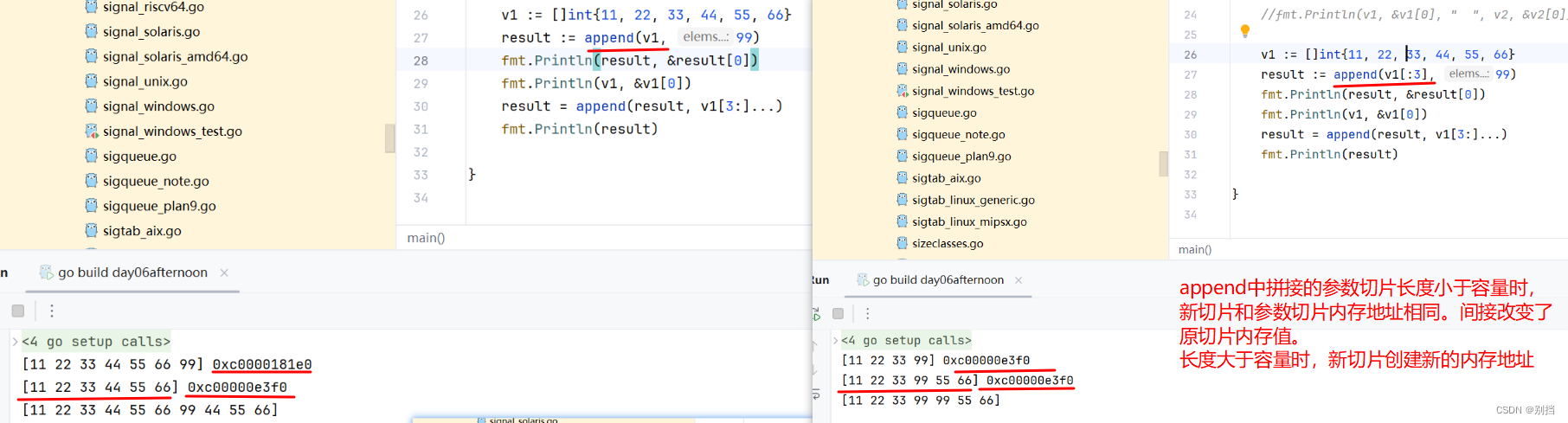

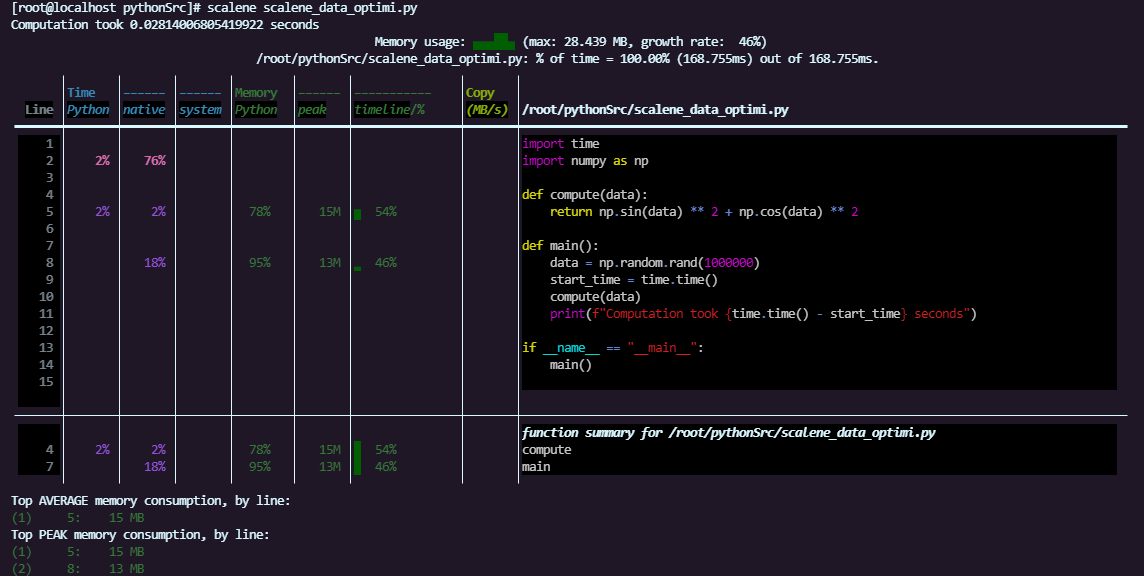

通过查看scalene生成的报告,我们可以发现process_data函数中的循环操作是性能瓶颈;具体来说,scalene的报告可能会显示该函数占用了大量的CPU时间和内存。以下是上面py文件执行的报告显示:

从报告中可以看出,process_data函数(第7行)是性能瓶颈;为了解决这个问题,我们可以通过使用NumPy的向量化操作来优化这个函数:

def compute(data):

return np.sin(data) ** 2 + np.cos(data) ** 2

优化后的代码如下:

import time

import numpy as np

def compute(data):

return np.sin(data) ** 2 + np.cos(data) ** 2

def main():

data = np.random.rand(1000000)

start_time = time.time()

compute(data)

print(f"Computation took {time.time() - start_time} seconds")

if __name__ == "__main__":

main()

再次使用scalene进行分析:

scalene scalene_data_optimi.py

优化后的处理时间将显著减少,scalene生成的报告会显示process_data函数的CPU和内存使用情况得到了明显改善:

scalene报告

让我们系统看看scalene生成的报告,报告分为以下几个部分:

- CPU时间分析:显示每行代码消耗的CPU时间比例,帮助我们找出最耗时的代码行;例如,报告中的第7行占用了80%的CPU时间,表明这是一个性能瓶颈;

- 内存分配分析:显示每行代码的内存分配情况,帮助我们找出内存使用量大的代码行;如果某行代码频繁分配和释放内存,可能会导致性能问题;

- 内存使用增长:显示内存使用量随时间的增长情况,帮助我们识别潜在的内存泄漏问题;如果内存使用量不断增加而没有释放,可能存在内存泄漏;

- 图形化展示:通过图表展示CPU和内存使用情况,更直观地分析性能瓶颈;通过颜色区分Python代码和本地代码的消耗情况。

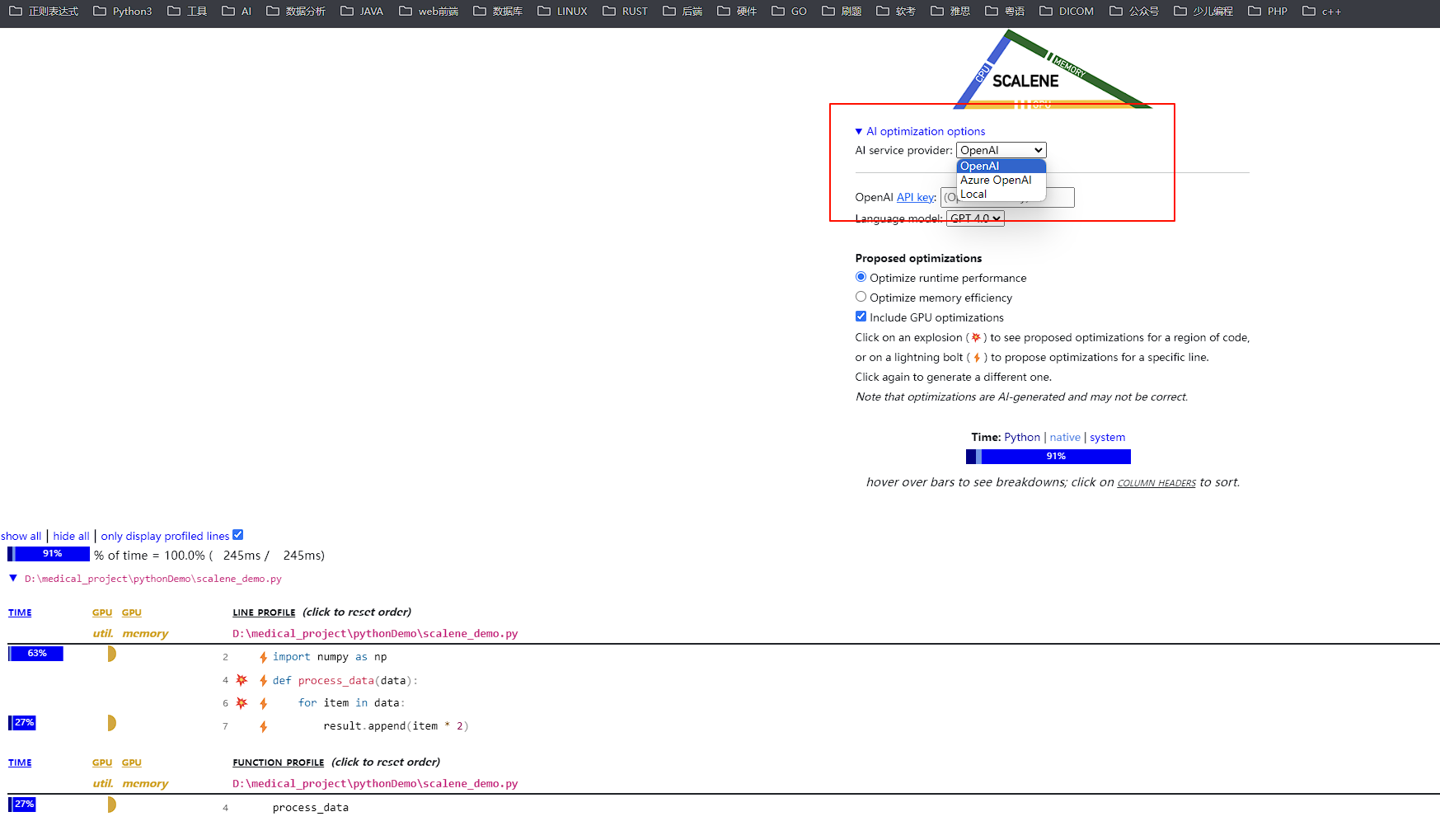

结合AI模型

目前scalene还能结合各种AI模型,直接让AI模型帮助你优化代码,主要有这两种OpenAI、Azure OpenAI,或者使用你本地自己训练的AI模型:

结语

通过本文的介绍,我们学习了如何利用 scalene 对 Python 程序进行性能分析和优化,大家可以将它与上一篇文章中介绍的 Py-Spy 进行比较,根据实际应用场景选择适合的工具。希望这些技巧能帮助你们在实际项目中编写出高效、稳定的代码!

如果你对计算机相关技术感兴趣,并且想要持续探索更多内容,请关注我的公众号!我们会持续分享更多精彩的技术干货!