| 如何让小型语言模型发挥作用! |

文章目录

- 一. 如何让小型语言模型发挥作用!

-

- 不可能的可能性

- 小模型的潜力

- 创新方法与突破

- 实践与验证

- 过滤系统与数据质量

- 小模型的逐步改进

- 信息理论蒸馏方法(新工作InfoSum)

- 总结与展望

- Infini-Gram与N-gram模型的新时代

- 后缀数组与高速计算

- 二. 参考文献

- 作者主页:https://homes.cs.washington.edu/~yejin/

一. 如何让小型语言模型发挥作用!

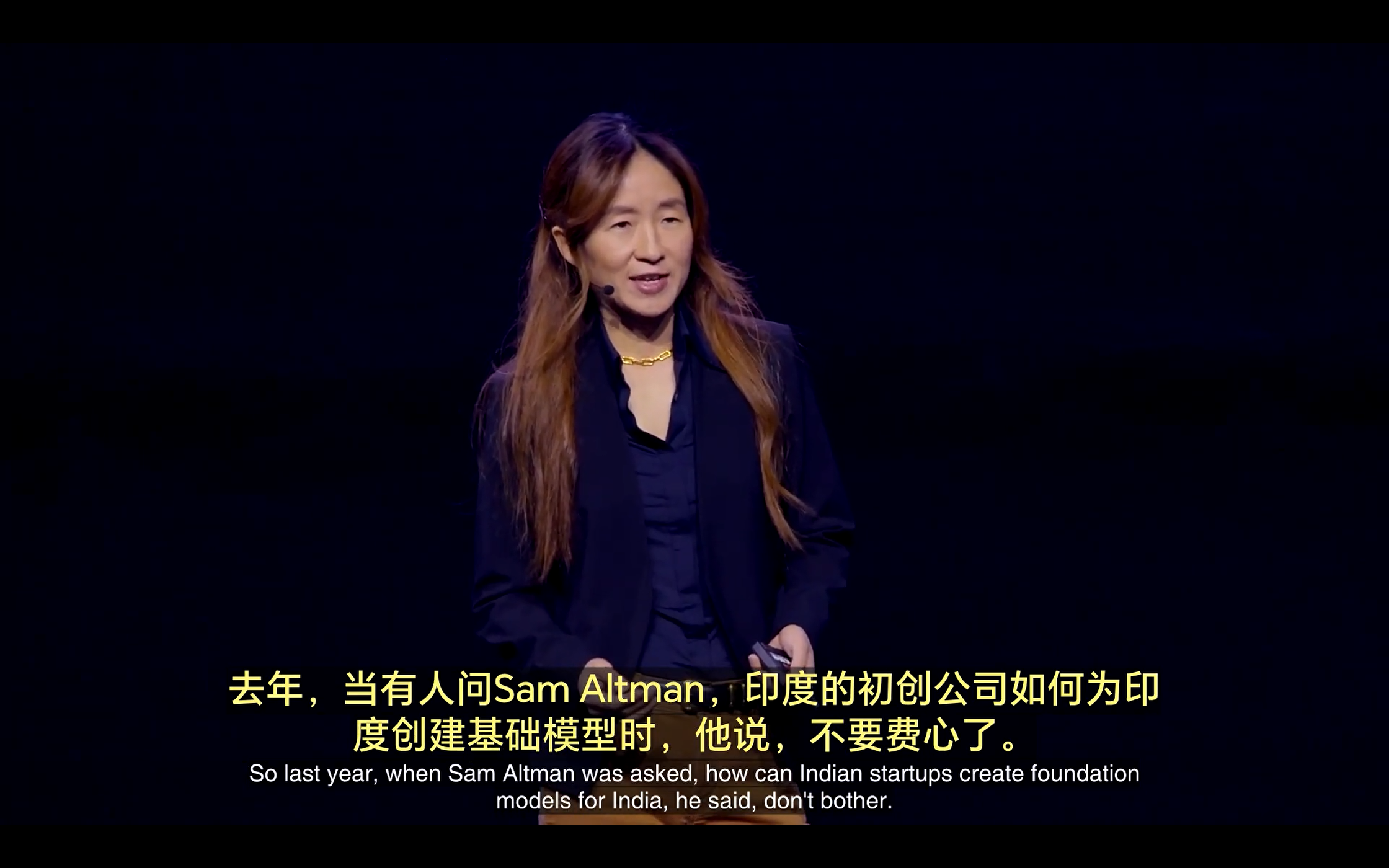

不可能的可能性

好吧,我今天要与你分享一些看似不可能的可能性。去年,有人问Sam Altman,印度的初创企业如何为印度创建基础模型时,他回答说:“不用费心了,这是没有希望的。”哇。首先,我希望印度的初创企业没有因此放弃,也不会放弃。其次,这种对话可能发生在任何地方。在美国的任何大学、初创企业或研究机构,即使它们没有那么多计算资源。所以,这里介绍一种“不可能的蒸馏”方法。如何以环保的方式训练你的小型语言模型,并且效果堪比大型模型。

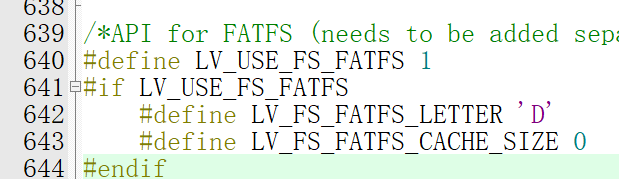

目前,我们听到的成功配方是极大规模的预训练,然后是极大规模的后训练,如RLHF(人类反馈强化学习)