节前,我们星球组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、参加社招和校招面试的同学.

针对算法岗技术趋势、大模型落地项目经验分享、新手如何入门算法岗、该如何准备、面试常考点分享等热门话题进行了深入的讨论。

汇总合集:

《大模型面试宝典》(2024版) 发布!

本文介绍如何训练 LLaVA v1.5 多模态模型。

LLaVA 训练包括特征对齐阶段(feature alignment stage)和视觉指令微调阶段(visual instruction tuning stage),其中特征对齐阶段使用 LAION-CC-SBU 数据集的 558K 子集(记为 LLaVA-Pretrain),目的是训练 MLP connector(或称为 projector),而视觉指令微调阶段使用 GPT-4 生成的 150K 条多模态指令跟随数据和来自学术任务的 515K 条 VQA 数据引导 LLaVA 模型遵从多模态指令。

官方给出的 LLaVA v1.5 使用了 8 个 A100 GPU(80G)进行训练,如果我们没有 8 个 GPU 或者足够的显存(80G),可以减小per_device_train_batch_size的值并增大gradient_accumulation_steps,始终保证全局 batch size 不变,其中 batch size 的大小等于 per_device_train_batch_sizexgradient_accumulation_stepsxnum_gpus 。

技术交流群

前沿技术资讯、算法交流、求职内推、算法竞赛、面试交流(校招、社招、实习)等、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企开发者互动交流~

我们建了大模型算法岗技术与面试交流群, 想要进交流群、需要源码&资料、提升技术的同学,可以直接加微信号:mlc2060。加的时候备注一下:研究方向 +学校/公司+CSDN,即可。然后就可以拉你进群了。

方式①、微信搜索公众号:机器学习社区,后台回复:技术交流

方式②、添加微信号:mlc2040,备注:技术交流

用通俗易懂方式讲解系列

- 用通俗易懂的方式讲解:自然语言处理初学者指南(附1000页的PPT讲解)

- 用通俗易懂的方式讲解:1.6万字全面掌握 BERT

- 用通俗易懂的方式讲解:NLP 这样学习才是正确路线

- 用通俗易懂的方式讲解:28张图全解深度学习知识!

- 用通俗易懂的方式讲解:不用再找了,这就是 NLP 方向最全面试题库

- 用通俗易懂的方式讲解:实体关系抽取入门教程

- 用通俗易懂的方式讲解:灵魂 20 问帮你彻底搞定Transformer

- 用通俗易懂的方式讲解:图解 Transformer 架构

- 用通俗易懂的方式讲解:大模型算法面经指南(附答案)

- 用通俗易懂的方式讲解:十分钟部署清华 ChatGLM-6B,实测效果超预期

- 用通俗易懂的方式讲解:内容讲解+代码案例,轻松掌握大模型应用框架 LangChain

- 用通俗易懂的方式讲解:如何用大语言模型构建一个知识问答系统

- 用通俗易懂的方式讲解:最全的大模型 RAG 技术概览

- 用通俗易懂的方式讲解:利用 LangChain 和 Neo4j 向量索引,构建一个RAG应用程序

- 用通俗易懂的方式讲解:使用 Neo4j 和 LangChain 集成非结构化知识图增强 QA

- 用通俗易懂的方式讲解:面了 5 家知名企业的NLP算法岗(大模型方向),被考倒了。。。。。

- 用通俗易懂的方式讲解:NLP 算法实习岗,对我后续找工作太重要了!。

- 用通俗易懂的方式讲解:理想汽车大模型算法工程师面试,被问的瑟瑟发抖。。。。

- 用通俗易懂的方式讲解:基于 Langchain-Chatchat,我搭建了一个本地知识库问答系统

- 用通俗易懂的方式讲解:面试字节大模型算法岗(实习)

- 用通俗易懂的方式讲解:大模型算法岗(含实习)最走心的总结

- 用通俗易懂的方式讲解:大模型微调方法汇总

下面以 LLaVA-v1.5-13B 为例介绍 LLaVA 模型的训练。

特征对齐阶段

准备数据

下载 LLaVA-Pretrain[2] 数据集

# 将数据下载到 ./playground/data/LLaVA-Pretrain,否则需要修改启动脚本的 data_path 参数

huggingface-cli download --repo-type dataset liuhaotian/LLaVA-Pretrain --local-dir ./playground/data/LLaVA-Pretrain

LLaVA-Pretrain 包含 3 个文件:

- blip_laion_cc_sbu_558k.json:此数据的构造过程是将 image-caption 数据添加随机选择的指令(例如:“Describe this image”)转换成多模态对话,下面是数据示例:

{

'id': '004539375',

'image': '00453/004539375.jpg',

'conversations': [

{

'from': 'human',

'value': 'Render a clear and concise summary of the photo.\n<image>'

},

{

'from': 'gpt',

'value': 'select luxury furniture 3 - inch gel memory foam mattress topper'

}

]

},

- blip_laion_cc_sbu_558k_meta.json:包含 3 种元数据,分别是图像路径、图像 URL 和 blip_caption

{

'id': '004539375',

'image': '00453/004539375.jpg',

'blip_caption': 'select luxury furniture 3 - inch gel memory foam mattress topper',

'url': 'http://ec1.ostkcdn.com/images/products/8111140/P15459545.jpg'

}

- images.zip:LAION/CC/SBU 筛选后的子集

解压images.zip

# 解压到 ./playground/data/LLaVA-Pretrain/images,否则需要修改启动脚本的 image_folder 参数

unzip ./playground/data/LLaVA-Pretrain/images.zip -d ./playground/data/LLaVA-Pretrain/images

启动训练

在这个阶段,使用 8 个 A100(80G)训练 LLaVA-v1.5-13B 大约需要 5.5 小时。

启动的脚本是scripts/v1_5/pretrain.sh,它的内容如下:

#!/bin/bash

deepspeed llava/train/train_mem.py \

--deepspeed ./scripts/zero2.json \ # 使用 DeepSpeed ZeRO-2

--model_name_or_path lmsys/vicuna-13b-v1.5 \ # 语言模型是 lmsys/vicuna-13b-v1.5

--version plain \

--data_path ./playground/data/LLaVA-Pretrain/blip_laion_cc_sbu_558k.json \ # 训练样本文件

--image_folder ./playground/data/LLaVA-Pretrain/images \ # 存放图像的目录

--vision_tower openai/clip-vit-large-patch14-336 \ # 视觉编码器

--mm_projector_type mlp2x_gelu \ # projector 的类型

--tune_mm_mlp_adapter True \ # 是否训练 projector

--mm_vision_select_layer -2 \

--mm_use_im_start_end False \

--mm_use_im_patch_token False \

--bf16 True \

--output_dir ./checkpoints/llava-v1.5-13b-pretrain \ # 保存的路径

--num_train_epochs 1 \

--per_device_train_batch_size 32 \

--per_device_eval_batch_size 4 \

--gradient_accumulation_steps 1 \

--evaluation_strategy 'no' \

--save_strategy 'steps' \

--save_steps 24000 \

--save_total_limit 1 \

--learning_rate 1e-3 \

--weight_decay 0. \

--warmup_ratio 0.03 \

--lr_scheduler_type 'cosine' \

--logging_steps 1 \

--tf32 True \

--model_max_length 2048 \

--gradient_checkpointing True \

--dataloader_num_workers 4 \

--lazy_preprocess True \

--report_to wandb

启动脚本:

sh ./scripts/v1_5/pretrain.sh

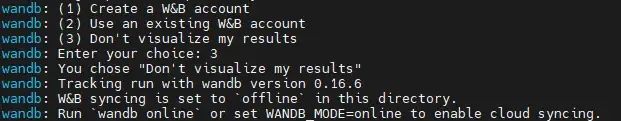

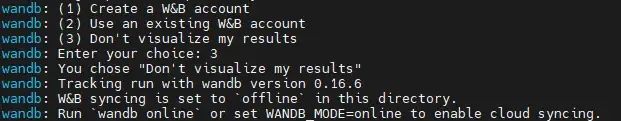

启动训练后,会自动下载语言模型视觉编码器的权重,完成权重的下载后会提示是否需要使用 wandb 可视化结果,这里按需选择即可。

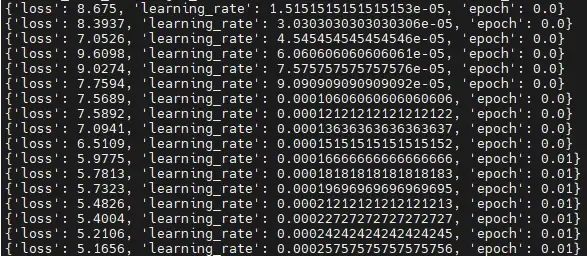

接下来就开始了训练,下面是 loss 的部分日志:

训练完成后,权重会保存在./checkpoints/llava-v1.5-13b-pretrain目录。

视觉指令微调阶段

完成特征对齐阶段的训练后,我们进入视觉指令微调阶段。注意:如果我们跳过特征对齐阶段的训练,则需要将对应的 projector 下载到./checkpoints目录,下载的命令如下:

huggingface-cli download liuhaotian/llava-v1.5-mlp2x-336px-pretrain-vicuna-13b-v1.5 --local-dir ./checkpoints/llava-v1.5-13b-pretrain

准备数据

下载数据集

- 下载 llava_v1_5_mix665k.json[3]

# 将数据下载到 ./playground/data/LLaVA-Instruct-150K

huggingface-cli download --repo-type dataset liuhaotian/LLaVA-Instruct-150K --local-dir ./playground/data/LLaVA-Instruct-150K

cp ./playground/data/LLaVA-Instruct-150K/llava_v1_5_mix665k.json ./playground/data/llava_v1_5_mix665k.json

下面是 llava_v1_5_mix665k.json 的示例:

{

'id': '000000033471', // 样本的唯一 id

'image': 'coco/train2017/000000033471.jpg', // 可以是绝对路径,也可以是相对于 image_folder 的路径

'conversations': [

{

'from': 'human',

'value': '<image>\nWhat are the colors of the bus in the image?'

},

{

'from': 'gpt',

'value': 'The bus in the image is white and red.'

},

{

'from': 'human',

'value': 'What feature can be seen on the back of the bus?'

},

{

'from': 'gpt',

'value': 'The back of the bus features an advertisement.'

},

{

'from': 'human',

'value': 'Is the bus driving down the street or pulled off to the side?'

},

{

'from': 'gpt',

'value': 'The bus is driving down the street, which is crowded with people and other vehicles.'

}

]

},

- 下载 COCO train2017[4]

wget http://images.cocodataset.org/zips/train2017.zip -P ./playground/data/coco

unzip ./playground/data/coco/train2017.zip -d ./playground/data/coco

- 下载 GQA images[5]

wget https://downloads.cs.stanford.edu/nlp/data/gqa/images.zip -P ./playground/data/gqa

unzip ./playground/data/gqa/images.zip -d ./playground/data/gqa

- •下载 OCR-VQA[6] 将 OCR-VQA 中的 dataset.json 和 loadDataset.py 文件下载到 ./playground/data/ocr_vqa 目录。注释 loadDataset.py 中的 pdb.set_trace()后执行下面的命令:

cd ./playground/data/ocr_vqa

python loadDataset.py

# 回到 LLaVA 目录

cd ../../../

使用下面的代码处理 OCR-VQA 图像的后缀问题[7]:

import json

import os

with open('./playground/data/llava_v1_5_mix665k.json') as f:

samples = json.load(f)

for sample in samples:

if 'image' not in sample:

continue

img_path = os.path.join('./playground/data', sample['image'])

if not os.path.exists(img_path):

# 处理 OCR-VQA 图像后缀和 llava_v1_5_mix665k.json 中的后缀不一致问题

img_path_wo_ext = os.path.splitext(img_path)[0]

for ext in ['.png', '.gif']:

real_path = img_path_wo_ext + ext

if os.path.exists(real_path):

# 重命名

os.replace(real_path, img_path)

break

也可以参考 https://github.com/haotian-liu/LLaVA/pull/1458 给出的路径下载 ORC-VQA 数据。

- 下载 TextVQA[8]

wget https://dl.fbaipublicfiles.com/textvqa/images/train_val_images.zip -P ./playground/data/textvqa

unzip ./playground/data/textvqa/train_val_images.zip -d ./playground/data/textvqa

- 下载 VisualGenome part1[9] 和 part2[10]

wget https://cs.stanford.edu/people/rak248/VG_100K_2/images.zip -P ./playground/data/vg

wget https://cs.stanford.edu/people/rak248/VG_100K_2/images2.zip -P ./playground/data/vg

unzip ./playground/data/vg/images.zip -d ./playground/data/vg

unzip ./playground/data/vg/images2.zip -d ./playground/data/vg

数据集结构

完成数据集的下载后,检查数据集的目录结构是否和下面的一致:

├── coco

│ ├── train2017

│ │ ├── xxx.jpg

├── gqa

│ ├── images

│ │ ├── xxx.jpg

├── llava_v1_5_mix665k.json

├── ocr_vqa

│ ├── dataset.json

│ ├── images

│ │ ├── xxx.jpg

│ └── loadDataset.py

├── textvqa

│ ├── train_images

│ │ ├── xxx.jpg

│── vg

├── └── VG_100K

│ │ ├── xxx.jpg

├── │── VG_100K_2

│ │ ├── xxx.jpg

使用下面的代码检查数据目录结构:

import json

import os

with open('./playground/data/llava_v1_5_mix665k.json') as f:

samples = json.load(f)

missing_cnt = 0 # 记录图像路径不存在的个数

for sample in samples:

if 'image' not in sample:

continue

img_path = os.path.join('./playground/data', sample['image'])

if not os.path.exists(img_path):

missing_cnt += 1

print(missing_cnt)

如果 missing_cnt 为 0,则说明数据的目录结构是正确的。

启动训练

在启动训练前,请查看 https://github.com/haotian-liu/LLaVA/issues/1144 以避免训练结束后权重保存出错。

在这个阶段,使用 8 个 A100(80G)训练 LLaVA-v1.5-13B 大约需要 20 小时。启动的脚本是scripts/v1_5/finetune.sh,它的内容如下:

#!/bin/bash

deepspeed llava/train/train_mem.py \

--deepspeed ./scripts/zero3.json \ # 使用 DeepSpeed ZeRO-3

--model_name_or_path lmsys/vicuna-13b-v1.5 \

--version v1 \

--data_path ./playground/data/llava_v1_5_mix665k.json \ # 训练样本

--image_folder ./playground/data \ # 存放图像的目录

--vision_tower openai/clip-vit-large-patch14-336 \

--pretrain_mm_mlp_adapter ./checkpoints/llava-v1.5-13b-pretrain/mm_projector.bin \

--mm_projector_type mlp2x_gelu \ # projector 的类型

--mm_vision_select_layer -2 \

--mm_use_im_start_end False \

--mm_use_im_patch_token False \

--image_aspect_ratio pad \

--group_by_modality_length True \

--bf16 True \

--output_dir ./checkpoints/llava-v1.5-13b \

--num_train_epochs 1 \

--per_device_train_batch_size 16 \

--per_device_eval_batch_size 4 \

--gradient_accumulation_steps 1 \

--evaluation_strategy 'no' \

--save_strategy 'steps' \

--save_steps 50000 \

--save_total_limit 1 \

--learning_rate 2e-5 \

--weight_decay 0. \

--warmup_ratio 0.03 \

--lr_scheduler_type 'cosine' \

--logging_steps 1 \

--tf32 True \

--model_max_length 2048 \

--gradient_checkpointing True \

--dataloader_num_workers 4 \

--lazy_preprocess True \

--report_to wandb

启动脚本:

sh ./scripts/v1_5/finetune.sh

启动训练后,会询问是否需要使用 wandb 可视化结果,这里按需选择即可。

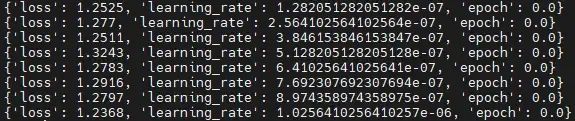

接下来就开始了训练,下面是 loss 的部分日志:

训练完成后,权重会保存在./checkpoints/llava-v1.5-13b目录。注意:如果单卡显存不足 80G,可以使用 LoRA 微调脚本 finetune_lora.sh[11]。完成训练后,可以参考 LLaVA 评测[12]对模型的性能进行评测。

微调自定义数据集

参考 Finetune LLaVA on Custom Datasets[13]

将训练样本以列表的形式保存到 json 文件,其中每一个样本是一个字典,它至少包含三个字段:

-

id:全局唯一的字符串

-

image:图片的路径,可以是绝对路径,也可以是相对于image_folder的相对路径

-

conversations:人类和语言模型的对话

下面是一个示例:

[

{

'id': '997bb945-628d-4724-b370-b84de974a19f',

'image': 'part-000001/997bb945-628d-4724-b370-b84de974a19f.jpg',

'conversations': [

{

'from': 'human',

'value': '<image>\nWrite a prompt for Stable Diffusion to generate this image.'

},

{

'from': 'gpt',

'value': 'a beautiful painting of chernobyl by nekro, pascal blanche, john harris, greg rutkowski, sin jong hun, moebius, simon stalenhag. in style of cg art. ray tracing. cel shading. hyper detailed. realistic. ue 5. maya. octane render. '

},

]

},

...

]

完成数据的处理后,修改 finetune.sh[14] 中的 data_path 参数(必须)以及其他想要调整的参数(可选,例如学习率)。

修改完成后,即可启动训练:

sh ./scripts/v1_5/finetune.sh

以上就是 LLaVA 的训练流程。

引用链接

[1] 官方教程: https://github.com/haotian-liu/LLaVA?tab=readme-ov-file#train

[2] LLaVA-Pretrain: https://huggingface.co/datasets/liuhaotian/LLaVA-Pretrain

[3] llava_v1_5_mix665k.json: https://huggingface.co/datasets/liuhaotian/LLaVA-Instruct-150K/blob/main/llava_v1_5_mix665k.json

[4] COCO train2017: http://images.cocodataset.org/zips/train2017.zip

[5] GQA images: https://downloads.cs.stanford.edu/nlp/data/gqa/images.zip

[6] OCR-VQA: https://drive.google.com/drive/folders/1_GYPY5UkUy7HIcR0zq3ZCFgeZN7BAfm_?usp=sharing

[7] OCR-VQA 图像的后缀问题: https://github.com/haotian-liu/LLaVA/issues/601

[8] TextVQA: https://dl.fbaipublicfiles.com/textvqa/images/train_val_images.zip

[9] part1: https://cs.stanford.edu/people/rak248/VG_100K_2/images.zip

[10] part2: https://cs.stanford.edu/people/rak248/VG_100K_2/images2.zip

[11] finetune_lora.sh: https://github.com/haotian-liu/LLaVA/blob/main/scripts/v1_5/finetune_lora.sh

[12] LLaVA 评测: https://github.com/haotian-liu/LLaVA?tab=readme-ov-file#evaluation

[13] Finetune LLaVA on Custom Datasets: https://github.com/haotian-liu/LLaVA/blob/main/docs/Finetune_Custom_Data.md

[14] finetune.sh: https://github.com/haotian-liu/LLaVA/blob/main/scripts/v1_5/finetune.sh