24年5月北大论文“DriveWorld: 4D Pre-trained Scene Understanding via World Models for Autonomous Driving”。

近年来,以视觉为中心的自动驾驶因其较低的成本而受到广泛关注。预训练对于提取通用表示至关重要。然而,当前以视觉为中心的预训练通常依赖于 2D 或 3D 预文本任务,忽略了自动驾驶作为 4D 场景理解任务的时间特征。本文引入一种基于世界模型的自动驾驶 4D 表示学习框架(称为 DriveWorld)来应对这一挑战,该框架能够以时空方式对多摄像头驾驶视频进行预训练。具体来说,提出一种用于时空建模的记忆-状态空间模型(Memory State- Space Model),它包括一个用于学习时域-觉察潜动态提供全面场景上下文预测未来变化的动态记忆库(Dynamic Memory Bank)模块和一个学习空域-觉察潜静态预测未来变化的静态场景传播(Static Scene Propagation)模块。还引入任务提示(Task Prompt)来解耦各种下游任务的任务-觉察特征。

如图所示:以视觉为中心的自动驾驶不同预训练方法的比较。 (a) 使用 2D 文本前任务(例如 2D 分类和深度估计)进行单目 2D 预训练。 (b) 通过 3D 场景重建或 3D 目标检测进行多摄像机 3D 预训练。 © 所提出的基于世界模型的 4D 预训练学习统一的时空表征。

如图所示DriveWorld 总体框架。由于自动驾驶很大程度上依赖于对 4D 场景的理解,因此该方法首先涉及将多摄像头图像转换为 4D 空间。在提出的用于时空建模的记忆-状态空间模型中,有两个基本组件:动态记忆库,它学习时域-觉察的潜动态以预测未来状态,以及静态场景传播,它学习空间感知的潜静态提供全面的场景上下文。这种配置有利于解码器重建当前和未来时间步的 3D 占据和动作的任务。此外,基于预训练的文本编码器设计任务提示,自适应地解耦各种任务的任务-觉察特征。

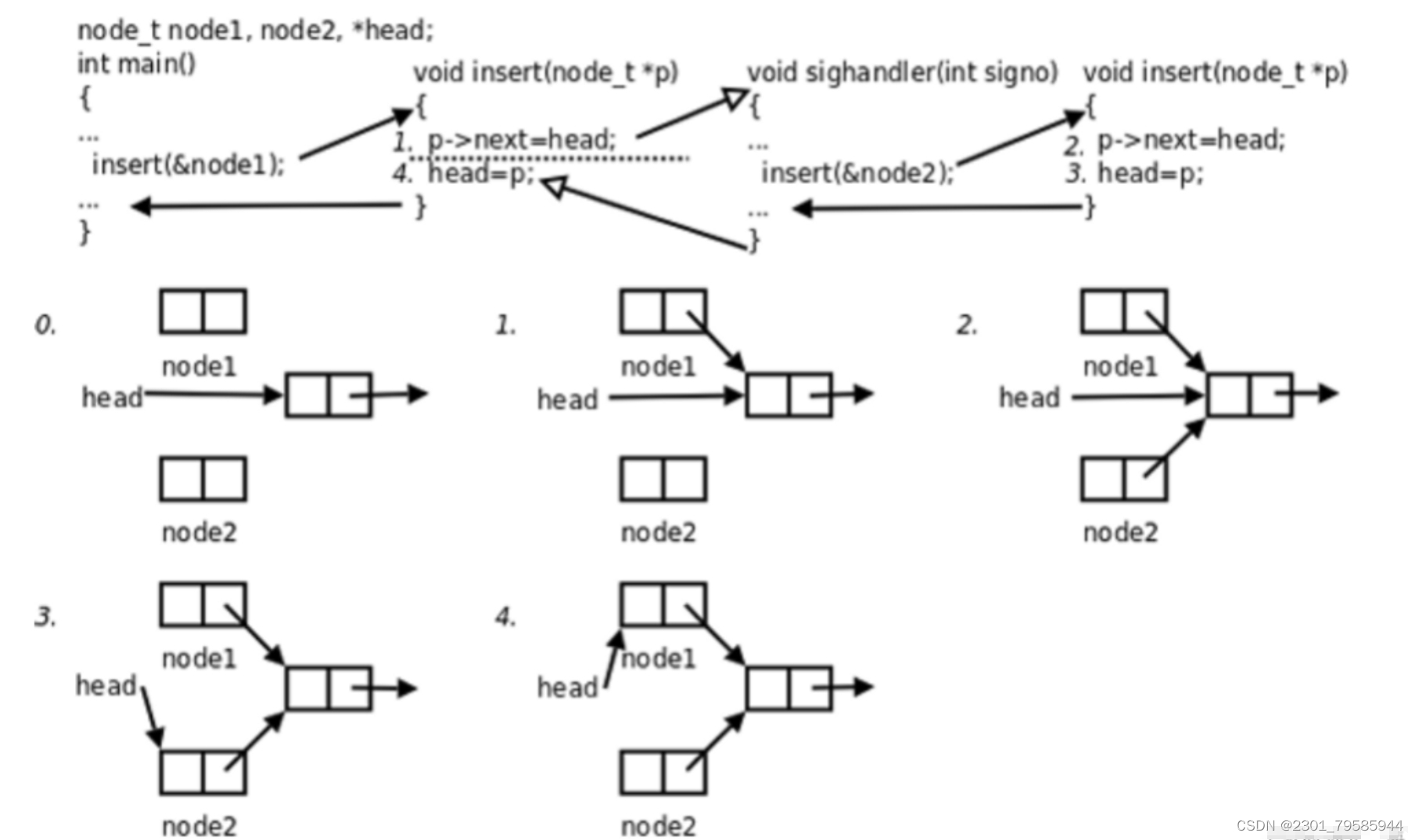

当自动驾驶车辆移动时,它会在其观察中顺序传达两种类型的信息:与由于目标移动而导致的场景变化相关的时域-觉察信息,以及与场景上下文相关的空域-觉察信息[82]。如图所示,为了分别处理这些动态智体和空间场景以进行 4D 预训练,作者提出用于动态记忆库模块和静态场景传播模块。图中显示记忆状态空间模型(MSSM)的总体架构。 动态记忆模块利用运动-觉察层归一化(MLN)来编码时域-觉察属性,并与动态更新的记忆进行信息交互。同时,静态场景传播模块采用 BEV 特征来表示空间-觉察的潜静态,并将其直接传送到解码器。

为了全面了解自动驾驶中的周围场景,将物理世界建模为3D占据结构,利用占据几何形式来描绘车辆的周围环境[13, 37, 50, 53, 69]。与重建输入 2D 图像 [22, 28] 的其他世界模型相比,3D 占据解码器可以对基于视觉的模型进行预训练来引入周围世界的几何先验。与主要表示目标表面的深度估计预训练 [60, 83] 不同,3D 占据可以表示整个结构。此外,与忽略关键高度信息的 MILE 这个 BEV 分割目标 [27] 不同,3D 占据提供了更全面的目标描述。 3D 占据解码器设置为 y^= lθ (m (h, s), b),其中 m 是将 1D 特征扩展到 BEV 维度的网络,lθ 是用于预测占据的 3D 卷积网络,b是潜静态的表征,即BEV特征,h 还是动态记忆库,s 是随机动态状态。

如图是记忆-状态空间模型的图模型。确定性状态用正方形表示,而随机状态用圆形表示。为了清晰起见,观测的状态以灰色突出显示。实线表示生成模型,而虚线表示变分推理。

OccNet [69] 和 UniScene [57] 等预训练算法已证明将重建 3D 占据作为前置任务是有效的。与 OccNet 和 UniScene 相比,进一步扩展到 4D 占据预训练,通过时空建模引入额外的先验知识。

虽然通过世界模型设计的前置任务能够学习时空表示,但不同的下游任务侧重于不同的信息[48, 72]。例如,3D 目标检测任务强调当前的空间-觉察信息,而未来的预测任务优先考虑时间-觉察信息。过度关注未来信息(例如车辆的未来位置)可能不利于 3D 目标检测任务。

为了缓解这个问题,受到用于少样本图像识别的语义提示(Semantic Prompt)[9]和用于多任务学习的视觉示例驱动提示(Visual Exemplar driven Prompts)[48]启发,引入了“任务提示”的概念,为不同的头提供特定的提示来指导他们提取任务-觉察特征。认识到不同任务之间存在的语义联系,用大语言模型 gφ (· )(例如 BERT [35]、CLIP [63])来构建这些任务提示。例如,针对当前场景的 3D 占据重建任务,任务提示 p 设置为简单的“任务是预测当前场景的 3D 占据”。将提示 ptext 输入 gφ(·) 获得提示编码 gφ (ptext )。随后,采用 AdaptiveInstanceNorm [27] 和 CNN 将其扩展到 BEV 维度,表示为 qφ(gφ(ptext)),将其与学习的时空特征集成。

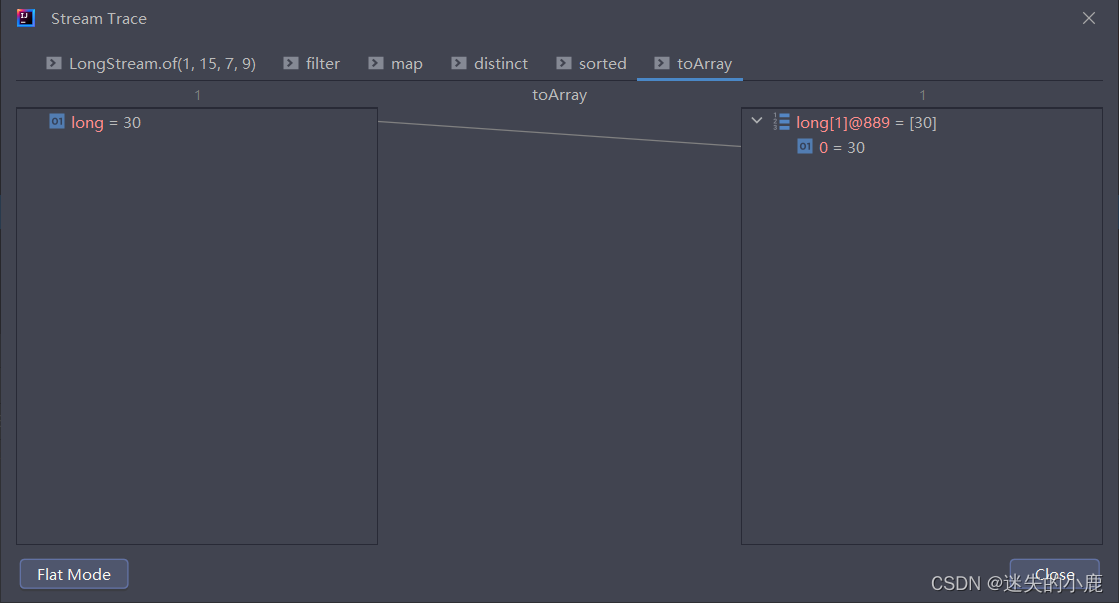

如图所示是不同任务提示的可视化BEV特征图: