huggingface-cli + hf_transfer 加速大模型下载

如果用的是autodl的话,可以直接开学术加速用 lfs 下也挺快

pip install -U huggingface_hub

设置环境变量

vim .bashrc

export HF_ENDPOINT=https://hf-mirror.com

source ~/.bashrc

下载模型:

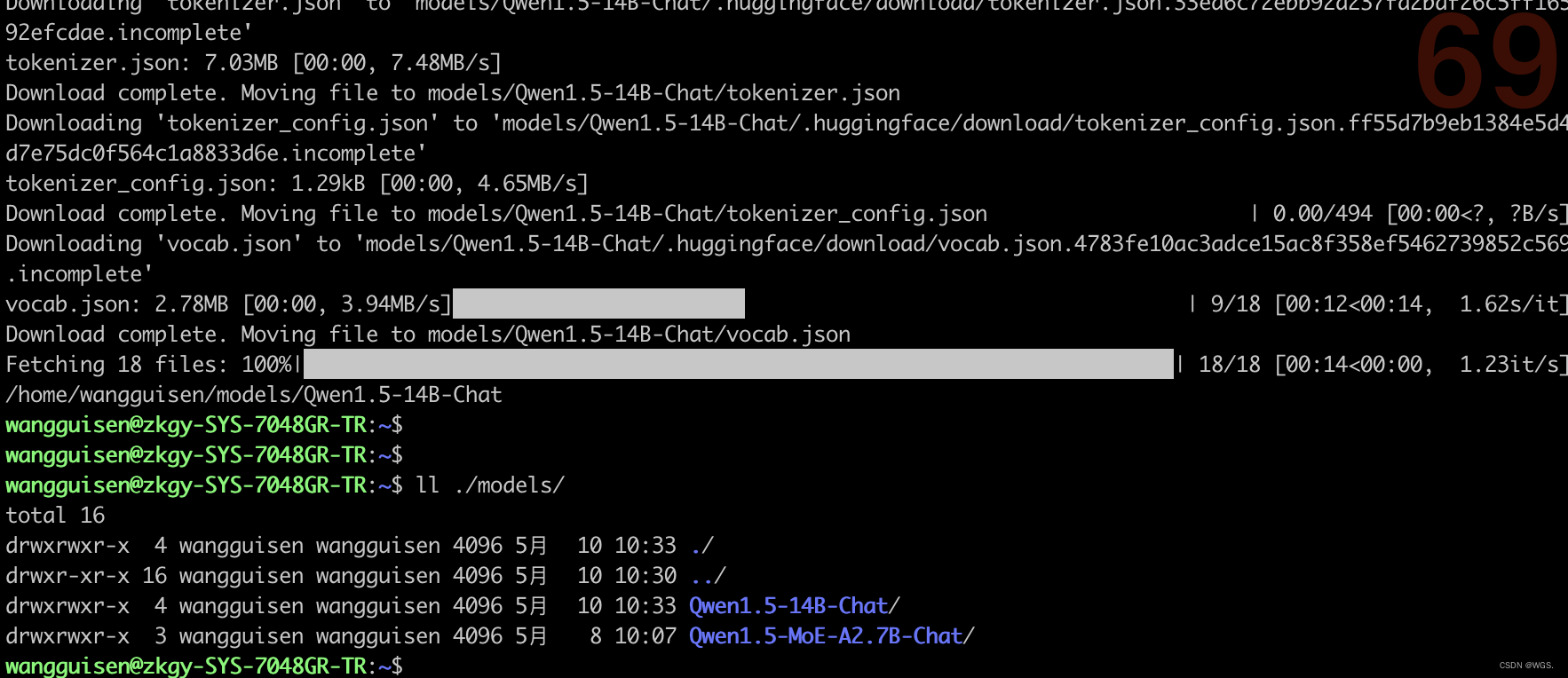

huggingface-cli download --resume-download Qwen/Qwen1.5-14B-Chat --local-dir ./models/Qwen1.5-14B-Chat

确实很快

ref:

https://hf-mirror.com/

https://zhuanlan.zhihu.com/p/663712983