目录

简介

设置

准备数据

使用数据增强

定义模型

实现梯度集中化

训练工具

不使用 GC 训练模型

使用 GC 训练模型

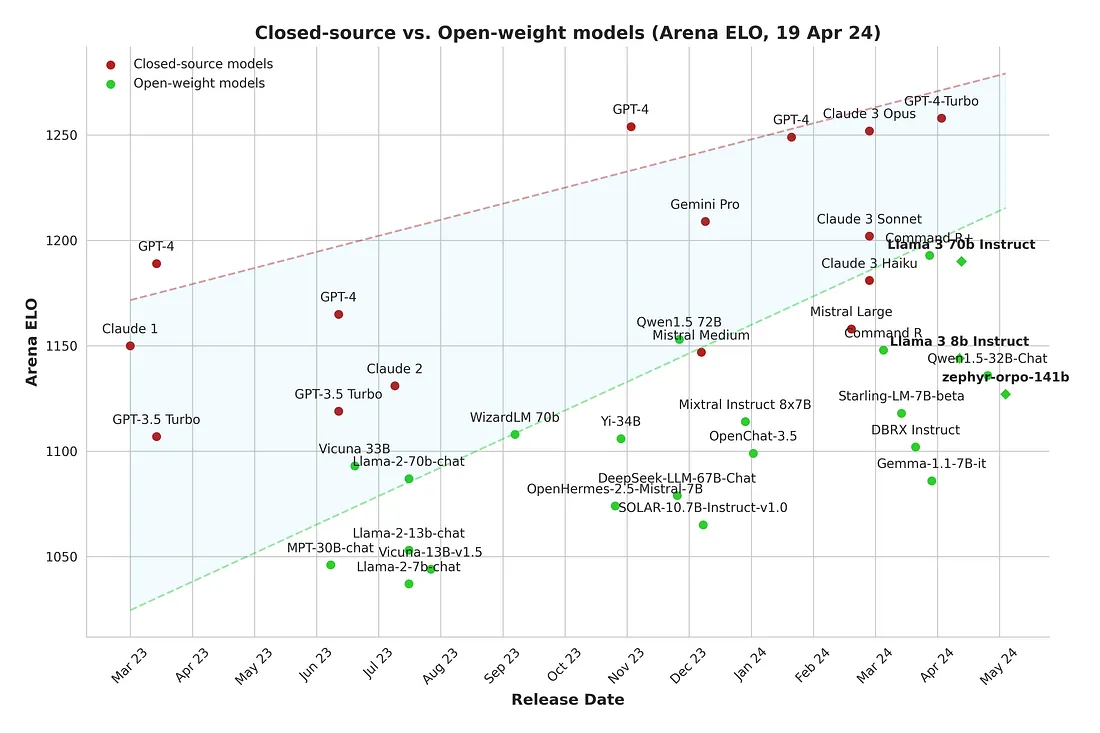

性能比较

政安晨的个人主页:政安晨

欢迎 👍点赞✍评论⭐收藏

收录专栏: TensorFlow与Keras机器学习实战

希望政安晨的博客能够对您有所裨益,如有不足之处,欢迎在评论区提出指正!

本文目标:实施梯度集中化,提高 DNN 的训练性能。

简介

本示例实现了 Yong 等人提出的深度神经网络新优化技术 "梯度集中化"(Gradient Centralization),并在 Laurence Moroney 的 "马或人 "数据集(Horses or Humans Dataset)上进行了演示。

梯度集中化既能加快训练过程,又能提高深度神经网络的最终泛化性能。

它通过将梯度向量集中为零均值,直接对梯度进行操作。

梯度集中化还能改善损失函数及其梯度的 Lipschitzness,从而提高训练过程的效率和稳定性。

此示例需要使用 tensorflow_datasets,可通过此命令安装:

设置

from time import time

import keras

from keras import layers

from keras.optimizers import RMSprop

from keras import ops

from tensorflow import data as tf_data

import tensorflow_datasets as tfds准备数据

在本例中,我们将使用 "马或人类 "数据集。

num_classes = 2

input_shape = (300, 300, 3)

dataset_name = "horses_or_humans"

batch_size = 128

AUTOTUNE = tf_data.AUTOTUNE

(train_ds, test_ds), metadata = tfds.load(

name=dataset_name,

split=[tfds.Split.TRAIN, tfds.Split.TEST],

with_info=True,

as_supervised=True,

)

print(f"Image shape: {metadata.features['image'].shape}")

print(f"Training images: {metadata.splits['train'].num_examples}")

print(f"Test images: {metadata.splits['test'].num_examples}")Image shape: (300, 300, 3)

Training images: 1027

Test images: 256使用数据增强

我们将把数据比例调整为 [0,1],并对数据进行简单的扩充。

rescale = layers.Rescaling(1.0 / 255)

data_augmentation = [

layers.RandomFlip("horizontal_and_vertical"),

layers.RandomRotation(0.3),

layers.RandomZoom(0.2),

]

# Helper to apply augmentation

def apply_aug(x):

for aug in data_augmentation:

x = aug(x)

return x

def prepare(ds, shuffle=False, augment=False):

# Rescale dataset

ds = ds.map(lambda x, y: (rescale(x), y), num_parallel_calls=AUTOTUNE)

if shuffle:

ds = ds.shuffle(1024)

# Batch dataset

ds = ds.batch(batch_size)

# Use data augmentation only on the training set

if augment:

ds = ds.map(

lambda x, y: (apply_aug(x), y),

num_parallel_calls=AUTOTUNE,

)

# Use buffered prefecting

return ds.prefetch(buffer_size=AUTOTUNE)重新缩放和扩充数据

train_ds = prepare(train_ds, shuffle=True, augment=True)

test_ds = prepare(test_ds)定义模型

在本文中,我们将定义一个卷积神经网络。

model = keras.Sequential(

[

layers.Input(shape=input_shape),

layers.Conv2D(16, (3, 3), activation="relu"),

layers.MaxPooling2D(2, 2),

layers.Conv2D(32, (3, 3), activation="relu"),

layers.Dropout(0.5),

layers.MaxPooling2D(2, 2),

layers.Conv2D(64, (3, 3), activation="relu"),

layers.Dropout(0.5),

layers.MaxPooling2D(2, 2),

layers.Conv2D(64, (3, 3), activation="relu"),

layers.MaxPooling2D(2, 2),

layers.Conv2D(64, (3, 3), activation="relu"),

layers.MaxPooling2D(2, 2),

layers.Flatten(),

layers.Dropout(0.5),

layers.Dense(512, activation="relu"),

layers.Dense(1, activation="sigmoid"),

]

)实现梯度集中化

现在,我们将对 RMSProp 优化器类进行子类化,修改 keras.optimizers.Optimizer.get_gradients() 方法,从而实现梯度集中化。从高层次上讲,我们的想法是,假设我们通过密集层或卷积层的反向传播获得梯度,然后计算权重矩阵列向量的平均值,再从每一列向量中去除平均值。

本文在一般图像分类、细粒度图像分类、检测和分割以及人员 ReID 等各种应用中进行的实验表明,GC 可以持续提高 DNN 学习的性能。

此外,为了简单起见,我们目前没有实现渐变剪切功能,但这很容易实现。

目前,我们只是为 RMSProp 优化器创建了一个子类,但你可以很容易地在任何其他优化器或自定义优化器上以同样的方式重现这个子类。在后面的文章中,我们将使用梯度集中法训练模型时使用该类。

class GCRMSprop(RMSprop):

def get_gradients(self, loss, params):

# We here just provide a modified get_gradients() function since we are

# trying to just compute the centralized gradients.

grads = []

gradients = super().get_gradients()

for grad in gradients:

grad_len = len(grad.shape)

if grad_len > 1:

axis = list(range(grad_len - 1))

grad -= ops.mean(grad, axis=axis, keep_dims=True)

grads.append(grad)

return grads

optimizer = GCRMSprop(learning_rate=1e-4)训练工具

我们还将创建一个回调函数,以便轻松测量总训练时间和每个历时所需的时间,因为我们有兴趣比较梯度集中化技术对上述模型的影响。

class TimeHistory(keras.callbacks.Callback):

def on_train_begin(self, logs={}):

self.times = []

def on_epoch_begin(self, batch, logs={}):

self.epoch_time_start = time()

def on_epoch_end(self, batch, logs={}):

self.times.append(time() - self.epoch_time_start)不使用 GC 训练模型

现在,我们在不使用梯度集中法的情况下训练之前建立的模型,并将其与使用梯度集中法训练的模型的训练性能进行比较。

time_callback_no_gc = TimeHistory()

model.compile(

loss="binary_crossentropy",

optimizer=RMSprop(learning_rate=1e-4),

metrics=["accuracy"],

)

model.summary()Model: "sequential"┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━┓ ┃ Layer (type) ┃ Output Shape ┃ Param # ┃ ┡━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━┩ │ conv2d (Conv2D) │ (None, 298, 298, 16) │ 448 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d (MaxPooling2D) │ (None, 149, 149, 16) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_1 (Conv2D) │ (None, 147, 147, 32) │ 4,640 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dropout (Dropout) │ (None, 147, 147, 32) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_1 (MaxPooling2D) │ (None, 73, 73, 32) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_2 (Conv2D) │ (None, 71, 71, 64) │ 18,496 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dropout_1 (Dropout) │ (None, 71, 71, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_2 (MaxPooling2D) │ (None, 35, 35, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_3 (Conv2D) │ (None, 33, 33, 64) │ 36,928 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_3 (MaxPooling2D) │ (None, 16, 16, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_4 (Conv2D) │ (None, 14, 14, 64) │ 36,928 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_4 (MaxPooling2D) │ (None, 7, 7, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ flatten (Flatten) │ (None, 3136) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dropout_2 (Dropout) │ (None, 3136) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dense (Dense) │ (None, 512) │ 1,606,144 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dense_1 (Dense) │ (None, 1) │ 513 │ └─────────────────────────────────┴───────────────────────────┴────────────┘Total params: 1,704,097 (6.50 MB)Trainable params: 1,704,097 (6.50 MB)Non-trainable params: 0 (0.00 B)

我们还保存了历史记录,因为我们以后要比较使用梯度集中化训练和未使用梯度集中化训练的模型。

history_no_gc = model.fit(

train_ds, epochs=10, verbose=1, callbacks=[time_callback_no_gc]

)Epoch 1/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 24s 778ms/step - accuracy: 0.4772 - loss: 0.7405

Epoch 2/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 597ms/step - accuracy: 0.5434 - loss: 0.6861

Epoch 3/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 700ms/step - accuracy: 0.5402 - loss: 0.6911

Epoch 4/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 9s 586ms/step - accuracy: 0.5884 - loss: 0.6788

Epoch 5/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 9s 588ms/step - accuracy: 0.6570 - loss: 0.6564

Epoch 6/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 591ms/step - accuracy: 0.6671 - loss: 0.6395

Epoch 7/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 594ms/step - accuracy: 0.7010 - loss: 0.6161

Epoch 8/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 9s 593ms/step - accuracy: 0.6946 - loss: 0.6129

Epoch 9/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 699ms/step - accuracy: 0.6972 - loss: 0.5987

Epoch 10/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 11s 623ms/step - accuracy: 0.6839 - loss: 0.6197使用 GC 训练模型

现在,我们将使用梯度集中法训练同一个模型,注意这次使用梯度集中法的是我们的优化器。

time_callback_gc = TimeHistory()

model.compile(loss="binary_crossentropy", optimizer=optimizer, metrics=["accuracy"])

model.summary()

history_gc = model.fit(train_ds, epochs=10, verbose=1, callbacks=[time_callback_gc])演绎展示:

Model: "sequential"┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━━━━━━━━━━━━━━━━┳━━━━━━━━━━━━┓ ┃ Layer (type) ┃ Output Shape ┃ Param # ┃ ┡━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━━━━━━━━━━━━━━━━╇━━━━━━━━━━━━┩ │ conv2d (Conv2D) │ (None, 298, 298, 16) │ 448 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d (MaxPooling2D) │ (None, 149, 149, 16) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_1 (Conv2D) │ (None, 147, 147, 32) │ 4,640 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dropout (Dropout) │ (None, 147, 147, 32) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_1 (MaxPooling2D) │ (None, 73, 73, 32) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_2 (Conv2D) │ (None, 71, 71, 64) │ 18,496 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dropout_1 (Dropout) │ (None, 71, 71, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_2 (MaxPooling2D) │ (None, 35, 35, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_3 (Conv2D) │ (None, 33, 33, 64) │ 36,928 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_3 (MaxPooling2D) │ (None, 16, 16, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ conv2d_4 (Conv2D) │ (None, 14, 14, 64) │ 36,928 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ max_pooling2d_4 (MaxPooling2D) │ (None, 7, 7, 64) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ flatten (Flatten) │ (None, 3136) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dropout_2 (Dropout) │ (None, 3136) │ 0 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dense (Dense) │ (None, 512) │ 1,606,144 │ ├─────────────────────────────────┼───────────────────────────┼────────────┤ │ dense_1 (Dense) │ (None, 1) │ 513 │ └─────────────────────────────────┴───────────────────────────┴────────────┘Total params: 1,704,097 (6.50 MB)Trainable params: 1,704,097 (6.50 MB)Non-trainable params: 0 (0.00 B)

Epoch 1/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 12s 649ms/step - accuracy: 0.7118 - loss: 0.5594

Epoch 2/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 592ms/step - accuracy: 0.7249 - loss: 0.5817

Epoch 3/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 9s 587ms/step - accuracy: 0.8060 - loss: 0.4448

Epoch 4/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 693ms/step - accuracy: 0.8472 - loss: 0.4051

Epoch 5/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 594ms/step - accuracy: 0.8386 - loss: 0.3978

Epoch 6/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 593ms/step - accuracy: 0.8442 - loss: 0.3976

Epoch 7/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 9s 585ms/step - accuracy: 0.7409 - loss: 0.6626

Epoch 8/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 587ms/step - accuracy: 0.8191 - loss: 0.4357

Epoch 9/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 9s 587ms/step - accuracy: 0.8248 - loss: 0.3974

Epoch 10/10

9/9 ━━━━━━━━━━━━━━━━━━━━ 10s 646ms/step - accuracy: 0.8022 - loss: 0.4589性能比较

print("Not using Gradient Centralization")

print(f"Loss: {history_no_gc.history['loss'][-1]}")

print(f"Accuracy: {history_no_gc.history['accuracy'][-1]}")

print(f"Training Time: {sum(time_callback_no_gc.times)}")

print("Using Gradient Centralization")

print(f"Loss: {history_gc.history['loss'][-1]}")

print(f"Accuracy: {history_gc.history['accuracy'][-1]}")

print(f"Training Time: {sum(time_callback_gc.times)}")Not using Gradient Centralization

Loss: 0.5345584154129028

Accuracy: 0.7604166865348816

Training Time: 112.48799777030945

Using Gradient Centralization

Loss: 0.4014038145542145

Accuracy: 0.8153935074806213

Training Time: 98.31573963165283我们鼓励读者在不同领域的不同数据集上尝试梯度集中化,并实验其效果。