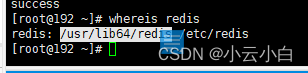

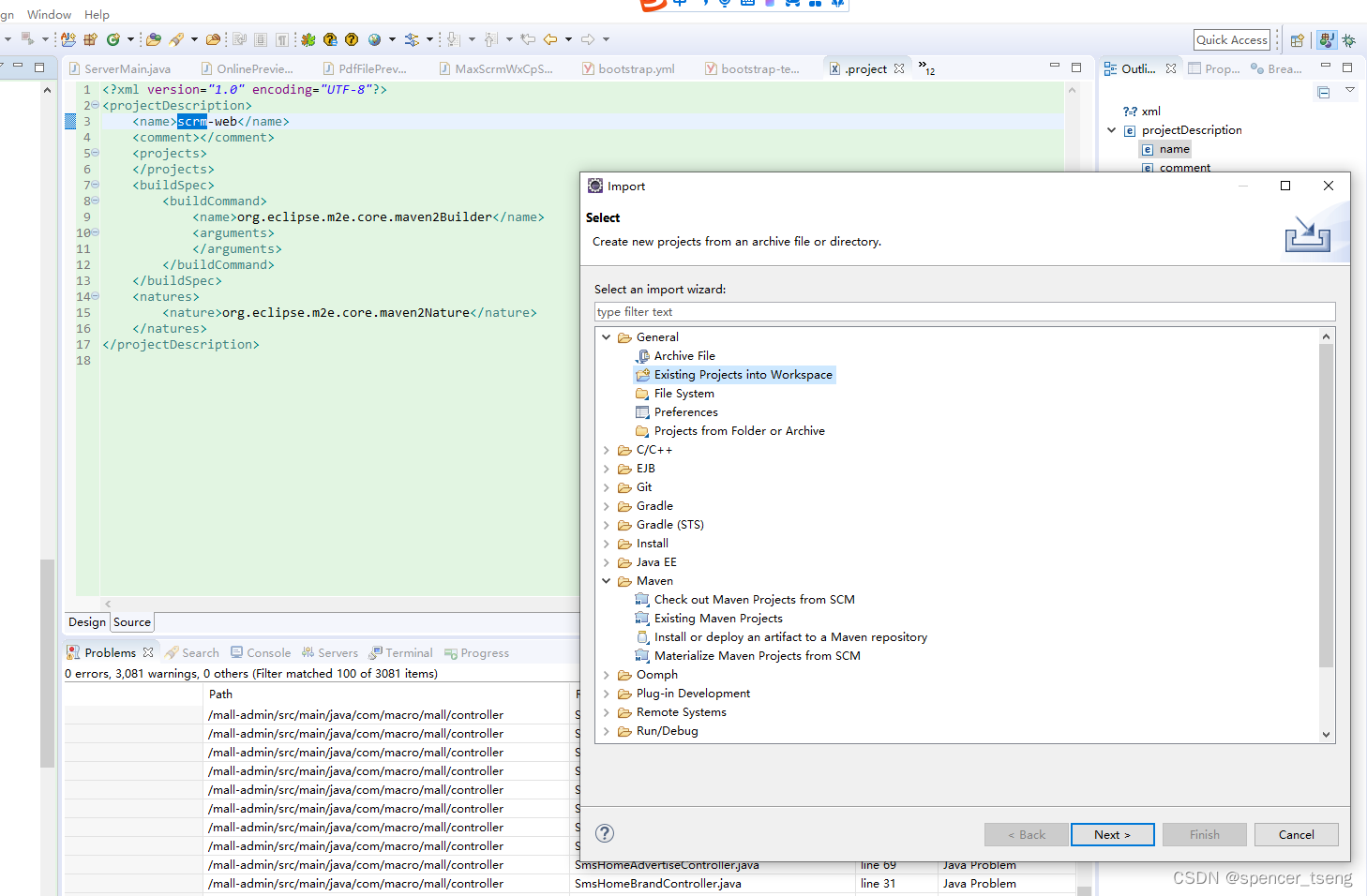

BS4实战-人民网

人民网_网上的人民日报 (people.com.cn)![]() http://www.people.com.cn/

http://www.people.com.cn/

import requests

from fake_useragent import UserAgent

from bs4 import BeautifulSoup

url = 'http://www.people.com.cn/'

headers ={'User-Agent':UserAgent().chrome}

# 发送请求

resp = requests.get(url,headers=headers)

# 设置字符集

resp.encoding='gbk'

# 获取结果

# with open('tmp.html','w',encoding='utf-8')

as f:

# f.write(resp.text)

# 构建一个bs4的对象

bs = BeautifulSoup(resp.text,'lxml')

# 提取数据

infos = bs.select('ul.list1 > li > a')

# 遍历结果集

for a in infos:

print(f'{a.text} === {a.get("href")}')

数据解析-pyquery

介绍

如果你对CSS选择器与Jquery有有所了解,那么还有个解析库可以适合你--PyQuery

PyQuery:一个类似 jQuery 的 Python 库 — PyQuery 1.2.4 文档 (pythonhosted.org)

安装

pip install pyquery

使用方式:

初始化方式:

- 字符串

from pyquery import PyQuery as pq

doc = pq(str)

print(doc(tagname))

- url

from pyquery import PyQuery as pq

doc = pq(url='http://www.baidu.com')

print(doc('title'))- 文件

from pyquery import PyQuery as pq

doc = pq(filename='demo.html')

print(doc(tagname))

选择节点:

- 获取当前节点

from pyquery import PyQuery as pq

doc = pq(filename='demo.html')

doc('#main #top')

- 获取子节点

在doc中一层层写出来

获取到父标签后使用children方法

from pyquery import PyQuery as pq

doc = pq(filename='demo.html')

doc('#main #top').children()

- 获取父节点

获取到当前节点后使用parent方法

- 获取兄弟节点

获取到当前节点后使用siblings方法

获取属性:

from pyquery import PyQuery as pq

doc = pq(filename='demo.html')

a = doc('#main #top')

print(a.attrib['href']) #Element

print(a.attr('href')) #PyQuery

获取内容:

from pyquery import PyQuery as pq

doc = pq(filename='demo.html')

div = doc('#main #top')

print(a.html())

print(a.text()) # pyquery

print(a.text) #element代码

from pyquery import PyQuery as pq

# 1.可加载一段HTML字符串,或一个HTML文件,或是一个

url地址,

d=pq("<html><title>hello</title></html>")

d=pq(filename=path_to_html_file)

d=pq(url='http://www.baidu.com') # 注意:此处

url似乎必须写全

# 2.html()和text() ——获取相应的HTML块或文本块,

p=pq("<head><title>hello</title></head>")

p('head').html()#返回<title>hello</title>

p('head').text()#返回hello

# 3.根据HTML标签来获取元素,

d=pq('<div><p>test 1</p><p>test 2</p>

</div>')

d('p')#返回[<p>,<p>]

print(d('p'))#返回<p>test 1</p><p>test 2</p>

print(d('p').html())#返回test 1

# 注意:当获取到的元素不只一个时,html()方法只返回首

个元素的相应内容块

# 4.eq(index) ——根据给定的索引号得到指定元素。接上

例,若想得到第二个p标签内的内容,则可以:

print(d('p').eq(1).html()) #返回test 2

# 5.filter() ——根据类名、id名得到指定元素,例:

d=pq("<div><p id='1'>test 1</p><p

class='2'>test 2</p></div>")

d('p').filter('#1') #返回[<p#1>]

d('p').filter('.2') #返回[<p.2>]

# 6.find() ——查找嵌套元素,例:

d=pq("<div><p id='1'>test 1</p><p

class='2'>test 2</p></div>")

d('div').find('p')#返回[<p#1>, <p.2>]

d('div').find('p').eq(0)#返回[<p#1>]

#7.直接根据类名、id名获取元素,例:

d=pq("<div><p id='1'>test 1</p><p

class='2'>test 2</p></div>")

d('#1').html()#返回test 1

d('.2').html()#返回test 2

# 8.获取属性值,例:

d=pq("<p id='my_id'><a

href='http://hello.com'>hello</a></p>")

d('a').attr('href')#返回http://hello.com

d('p').attr('id')#返回my_id

# 9.修改属性值,例:

d('a').attr('href', 'http://baidu.com')把

href属性修改为了baidu

# 10.addClass(value) ——为元素添加类,例:

d=pq('<div></div>')

d.addClass('my_class')#返回[<div.my_class>]

# 11.hasClass(name) #返回判断元素是否包含给定的

类,例:

d=pq("<div class='my_class'></div>")

d.hasClass('my_class')#返回True

# 12.children(selector=None) ——获取子元素,例:

d=pq("<span><p id='1'>hello</p><p

id='2'>world</p></span>")

d.children()#返回[<p#1>, <p#2>]

d.children('#2')#返回[<p#2>]

# 13.parents(selector=None)——获取父元素,例:

d=pq("<span><p id='1'>hello</p><p

id='2'>world</p></span>")

d('p').parents()#返回[<span>]

d('#1').parents('span')#返回[<span>]

d('#1').parents('p')#返回[]

# 14.clone() ——返回一个节点的拷贝

#15.empty() ——移除节点内容

# 16.nextAll(selector=None) ——返回后面全部的元

素块,例:

d=pq("<p id='1'>hello</p><p id='2'>world</p>

<img scr='' />")

d('p:first').nextAll()#返回[<p#2>, <img>]

d('p:last').nextAll()#返回[<img>]

# 17.not_(selector) ——返回不匹配选择器的元素,

例:

d=pq("<p id='1'>test 1</p><p id='2'>test

2</p>")

d('p').not_('#2')#返回[<p#1>]

数据解析-xpath的使用

介绍

之前 BeautifulSoup 的用法,这个已经是非常强大的库了,不过还有一些比较流行的解析库,例如 lxml,使用的是 Xpath 语法,同样是效率比较高的解析方法。如果大家对 BeautifulSoup使用不太习惯的话,可以尝试下 Xpath

lxml - Processing XML and HTML with Python![]() https://lxml.de/index.html XPath 教程 (w3school.com.cn)

https://lxml.de/index.html XPath 教程 (w3school.com.cn)![]() https://www.w3school.com.cn/xpath/index.asp

https://www.w3school.com.cn/xpath/index.asp

XPath语法

XPath 是一门在 XML 文档中查找信息的语言。XPath 可用来在XML 文档中对元素和属性进行遍历。XPath 是 W3C XSLT 标准的主要元素,并且 XQuery 和 XPointer 都构建于 XPath 表达之上

节点的关系 :

- 父(Parent)

- 子(Children)

- 同胞(Sibling)

- 先辈(Ancestor)

- 后代(Descendant)

常用的路径表达式:

| 表达式 | 描述 |

| nodename | 选取此节点的所有子节点 |

| / | 从根节点选取 |

| // | 从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置 |

| . | 选取当前节点 |

| .. | 选取当前节点的父节点 |

| @ | 选取属性 |

通配符 :

XPath 通配符可用来选取未知的 XML 元素。

| 通配符 | 描述 | 举例 | 结果 |

| * | 匹配任何元素节点 | xpath('div/*') | 获取div下的所有子节点 |

| @ | 匹配任何属性节点 | xpath('div[@*]') | 选取所有带属性的div节点 |

| node() | 匹配任何类型的节点 |

选取若干路径:

通过在路径表达式中使用“|”运算符,您可以选取若干个路径

| 表达式 | 结果 |

| xpath('//div | //table') | 获取所有的div与table节点 |

谓语:

谓语被嵌在方括号内,用来查找某个特定的节点或包含某个制定的值的节点

| 表达式 | 结果 |

| xpath('/body/div[1]') | 选取body下的第一个div节点 |

| xpath('/body/div[last()]') | 选取body下最后一个div节点 |

| xpath('/body/div[last()-1]') | 选取body下倒数第二个节点 |

| xpath('/body/div[positon()<3]') | 选取body下前两个div节点 |

| xpath('/body/div[@class]') | 选取body下带有class属性的div节点 |

| xpath('/body/div[@class="main"]') | 选取body下class属性为main的div节点 |

| xpath('/body/div[price>35.00]') | 选取body下price元素大于35的div节点 |

运算符 :

| 运算符 | 描述 | 实例 | 返回值 |

| // | 计算两个节点集 | //book | //cd |

| + | 加法 | 6 + 4 | 10 |

| – | 减法 | 6 – 4 | 2 |

| * | 乘法 | 6 * 4 | 24 |

| div | 除法 | 8 div 4 | 2 |

| = | 等于 | price=9.80 | 如果 price 是 9.80,则返回 true。如果 price 是9.90,则返回 false |

| != | 不等于 | price!=9.80 | 如果 price 是 9.90,则返回 true。如果 price 是9.80,则返回 false。 |

| < | 小于 | price<9.80 | 如果 price 是 9.00,则返回 true。如果 price 是9.90,则返回 false。 |

| <= | 小于或等于 | price<=9.80 | 如果 price 是 9.00,则返回 true。如果 price 是 9.90,则返回 false。 |

| > | 大于 | price>9.80 | 如果 price 是 9.90,则返回 true。如果 price 是9.80,则返回 false。 |

| >= | 大于或等 于 | price>=9.80 | 如果 price 是 9.90,则返回 true。如果 price 是9.70,则返回 false。 |

| or | 或 | price=9.80 or price=9.70 | 如果 price 是 9.80,则返回 true。如果 price 是9.50,则返回 false。 |

| and | 与 | price>9.00 and price<9.90 | 如果 price 是 9.80,则返回 true。如果 price 是 8.50,则返回 false。 |

| mod | 计算除法 的余数 | 5 mod 2 | 1 |

选择XML文件中节点:

- element(元素节点)

- attribute(属性节点)

- text() (文本节点)

- concat(元素节点,元素节点)

- comment (注释节点)

- root (根节点)