主要内容:

- 传统值迭代产生迭代控制策略,给出稳定性和吸引域判据;传统值迭代则迭代过程中得到可容许策略

- 折扣因子对迭代控制策略可容许的影响,神经网络对未知系统建模,讨论模型网络权重更新情况下参数误差和系统状态估计误差的最终一致有界稳定性。

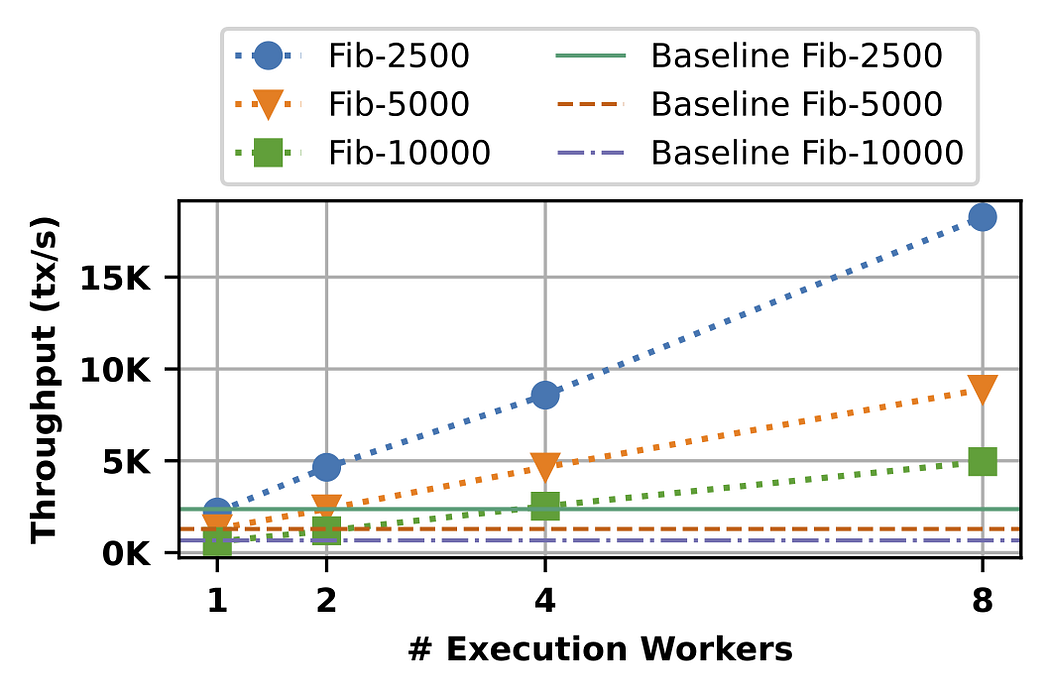

- 值函数收敛问题,提出速度可调节的新型迭代ADP

- 对ADP的跟踪问题,提出新的收敛分析方法使得跟踪误差趋于0

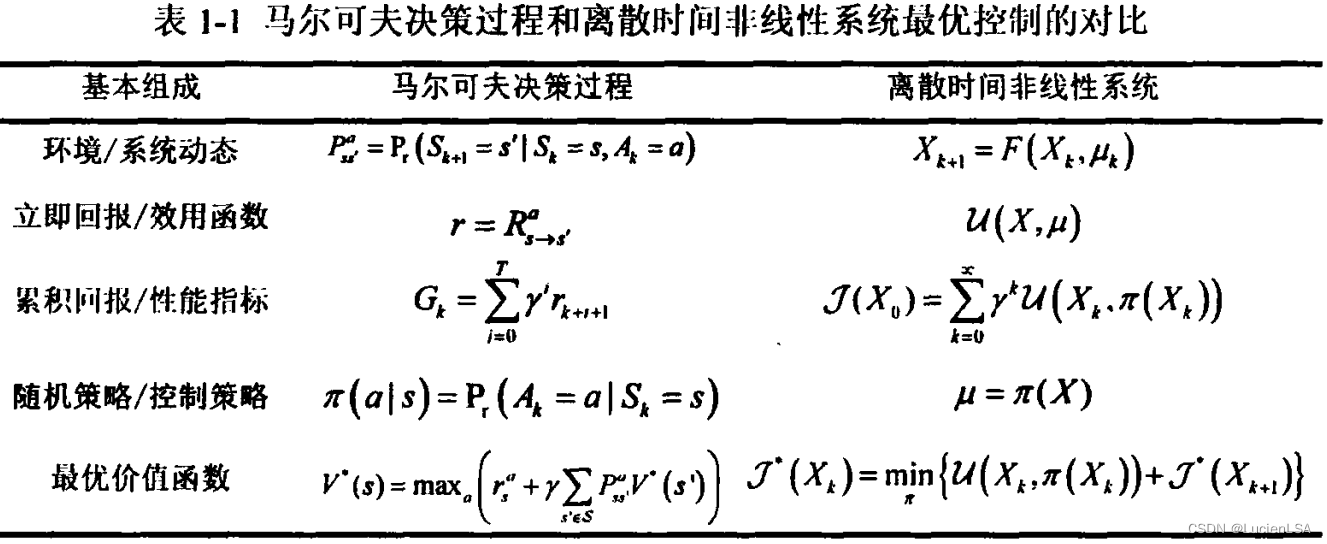

强化学习关注随机过程中的序贯决策问题,而自适应动态规划关注动态系统的控制问题

吸引域:系统渐近稳定的区域。

Related papers

Modified λ-Policy Iteration Based Adaptive Dynamic Programming for Unknown Discrete-Time Linear Systems

展望:

- 可容许控制策略下的迭代自适应动态规划要求更加严格,传统值函数初始化常会导致可容许控制策略是未知的,甚至无法保证有限次迭代得到可容许的控制策略。

- 折扣因子对最优控制策略和迭代控制策略的可容许性是未知的

- 对于传统迭代ADP方法,循环迭代逼近Bellman最优方程的解,加快迭代收敛速度的框架仍需要改进

- 基于跟踪控制问题,将原系统进行变换为增广系统,从而转化为最优调节问题。

![Vue element-plus 导航栏 [el-menu]](https://img-blog.csdnimg.cn/direct/cad688c77fb44593af301196dd40a963.png)