【PyTorch】进阶学习:一文详细介绍 torch.save() 的应用场景、实战代码示例

🌈 个人主页:高斯小哥

🔥 高质量专栏:Matplotlib之旅:零基础精通数据可视化、Python基础【高质量合集】、PyTorch零基础入门教程👈 希望得到您的订阅和支持~

💡 创作高质量博文(平均质量分92+),分享更多关于深度学习、PyTorch、Python领域的优质内容!(希望得到您的关注~)

🌵文章目录🌵

- 💾一、模型训练过程中的检查点保存

- 🚀二、模型部署与推理加速

- 📚三、模型迁移学习与微调

- 🔄四、模型版本控制与共享

- 🎨五、模型的可视化与调试

- 📚六、模型的序列化与反序列化

- 🌈七、总结与展望

- 🤝 期待与你共同进步

- 相关博客

本文旨在深入探讨PyTorch框架中

torch.save()的应用场景,并通过实战代码示例展示其具体应用。如果您对torch.save()的基础知识尚存疑问,博主强烈推荐您首先阅读博客文章《【PyTorch】基础学习:一文详细介绍 torch.save() 的用法和应用》,以全面理解其基本概念和用法。通过这篇文章,您将更好地掌握torch.save()在PyTorch框架中的实际运用,为您的深度学习之旅增添更多助力。期待您的阅读,一同探索PyTorch的无限魅力!

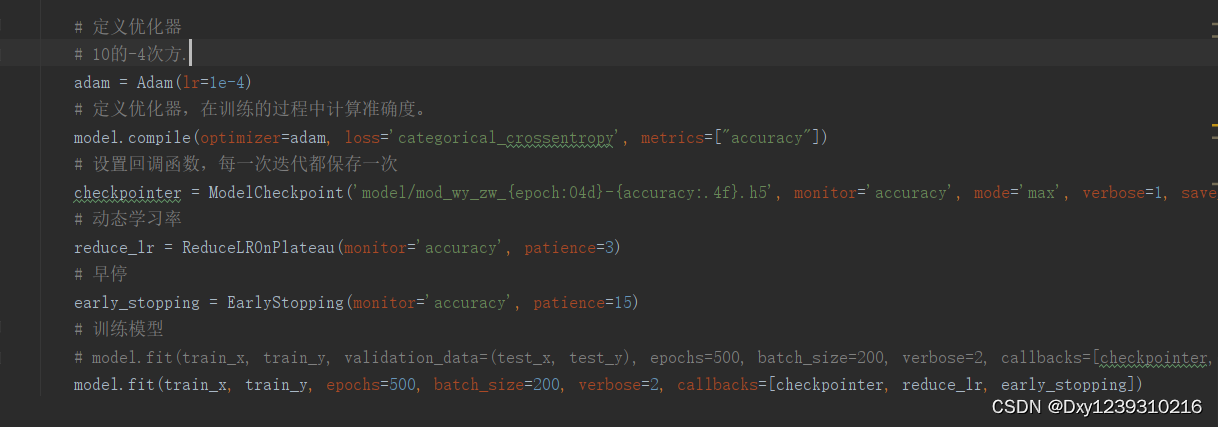

💾一、模型训练过程中的检查点保存

在深度学习模型的训练过程中,我们经常需要保存模型的中间状态,以便在训练中断时能够恢复训练进度,或者在模型性能达到某个要求时保存当前的最佳模型。torch.save() 在这个场景下发挥着至关重要的作用。

-

以下是一个简单的例子,展示了如何在训练循环中使用 torch.save() 保存模型的检查点:

import torch import torch.nn as nn import torch.optim as optim # 假设我们有一个简单的模型 class SimpleModel(nn.Module): def __init__(self): super(SimpleModel, self).__init__() self.fc = nn.Linear(10, 1) def forward(self, x): return self.fc(x) model = SimpleModel() optimizer = optim.SGD(model.parameters(), lr=0.01) criterion = nn.MSELoss() # 模拟一些训练数据 x_train = torch.randn(100, 10) y_train = torch.randn(100, 1) # 训练循环 for epoch in range(100): optimizer.zero_grad() outputs = model(x_train) loss = criterion(outputs, y_train) loss.backward() optimizer.step() # 每训练几个epoch保存一次模型检查点 if (epoch + 1) % 10 == 0: torch.save({ 'epoch': epoch + 1, 'model_state_dict': model.state_dict(), 'optimizer_state_dict': optimizer.state_dict(), 'loss': loss, ... }, f'checkpoint_epoch_{epoch+1}.pth')在这个例子中,我们每10个epoch保存一次模型的检查点,包括当前的epoch数、模型的参数、优化器的状态以及当前的损失值。这样,即使训练过程中遇到中断,我们也可以从最近的检查点恢复训练。

🚀二、模型部署与推理加速

在模型部署阶段,我们通常需要将模型加载到特定的设备(如CPU或GPU)上进行推理。torch.save() 可以帮助我们保存已经优化过的模型,以便在部署时快速加载并运行。

-

通过保存和加载模型的参数,我们可以快速地在不同的环境中部署模型,而无需重新训练。此外,将模型加载到GPU上还可以加速推理过程,提高模型的响应速度。

# 训练完成后,保存最终模型 final_model_state_dict = model.state_dict() torch.save(final_model_state_dict, 'final_model.pth') # 在部署时加载模型 loaded_model_state_dict = torch.load('final_model.pth') model.load_state_dict(loaded_model_state_dict) model.eval() # 设置模型为评估模式 # 将模型移动到指定设备 device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') model.to(device) # 进行推理...

📚三、模型迁移学习与微调

迁移学习是一种利用预训练模型在新任务上进行微调的技术。torch.save() 可以帮助我们保存预训练模型,以便在其他任务中进行迁移学习。

-

通过保存预训练模型和微调后的模型,我们可以方便地在新任务上利用已有的知识,加速模型的训练过程并提高性能。

# 假设我们有一个预训练的模型 pretrained_model = SomePretrainedModel() pretrained_model.load_state_dict(torch.load('pretrained_model.pth')) # 在新任务的数据集上进行微调 # ...(这里省略了数据加载和训练循环的代码) # 保存微调后的模型 finetuned_model_state_dict = pretrained_model.state_dict() torch.save(finetuned_model_state_dict, 'finetuned_model.pth')

🔄四、模型版本控制与共享

在模型开发和部署过程中,我们可能需要保存和管理不同版本的模型。torch.save() 结合文件名或路径的管理,可以帮助我们实现模型的版本控制。

-

通过保存不同版本的模型,并在文件名中明确标注版本号,我们可以轻松地管理和追踪模型的变更历史。同时,将模型文件上传到云存储或共享给团队成员,可以方便地实现模型的共享和协作:

# 保存不同版本的模型 torch.save(model1.state_dict(), 'model_v1.pth') torch.save(model2.state_dict(), 'model_v2.pth') # 加载特定版本的模型 def load_model_version(version): if version == 'v1': return torch.load('model_v1.pth') elif version == 'v2': return torch.load('model_v2.pth') else: raise ValueError("Invalid model version") # 使用特定版本的模型进行推理 model_state_dict = load_model_version('v2') loaded_model = SimpleModel() loaded_model.load_state_dict(model_state_dict) loaded_model.eval() # 模型共享 # 可以将保存的模型文件上传到云存储或共享给团队成员 # 其他人可以使用 torch.load() 加载模型进行推理或进一步训练

🎨五、模型的可视化与调试

除了直接用于模型的保存和加载,torch.save() 还可以与一些可视化工具结合使用,帮助我们对模型进行调试和分析。例如,我们可以保存模型的中间层输出或梯度信息,然后使用可视化工具进行展示。

-

通过保存中间层输出或梯度信息,并结合可视化工具进行分析,我们可以更好地理解模型的内部工作机制,发现潜在的问题并进行调试:

# 在训练循环中保存中间层输出 def forward(self, x): intermediate_output = self.some_layer(x) # 保存中间层输出到文件或内存(这里以保存到文件为例) torch.save(intermediate_output, 'intermediate_output.pth') return self.fc(intermediate_output) # ...(训练循环代码) # 在训练完成后,加载中间层输出进行可视化分析 intermediate_data = torch.load('intermediate_output.pth') # 使用可视化工具(如TensorBoard、Matplotlib等)展示中间层输出

📚六、模型的序列化与反序列化

torch.save() 和 torch.load() 的底层机制实际上是 Python 的序列化和反序列化过程。这意味着除了保存和加载模型参数外,我们还可以利用这些函数保存和加载任何可序列化的 Python 对象。

-

通过序列化和反序列化,我们可以将模型的参数、优化器的状态、超参数以及训练过程中的其他信息保存到一个文件中,并在需要时完整地恢复这些信息。这使得我们能够轻松地重现实验结果、分享训练数据以及进行模型的迁移和复用:

# 保存一个字典对象 data_dict = { 'model_state_dict': model.state_dict(), 'optimizer_state_dict': optimizer.state_dict(), 'hyperparameters': {'lr': 0.01, 'batch_size': 64}, 'training_loss_history': loss_history, # 假设这是训练过程中的损失记录 } torch.save(data_dict, 'training_data.pth') # 加载字典对象 loaded_data_dict = torch.load('training_data.pth') model.load_state_dict(loaded_data_dict['model_state_dict']) optimizer.load_state_dict(loaded_data_dict['optimizer_state_dict']) hyperparams = loaded_data_dict['hyperparameters'] loss_history = loaded_data_dict['training_loss_history']

🌈七、总结与展望

torch.save() 作为 PyTorch 中一个重要的函数,为模型的保存和加载提供了强大的支持。从模型训练过程中的检查点保存到模型部署与推理加速,再到模型迁移学习与微调,torch.save() 在深度学习项目的各个阶段都发挥着不可或缺的作用。此外,通过结合版本控制、模型可视化与调试以及高级序列化技术,我们可以进一步拓展 torch.save() 的应用场景,提高模型开发和部署的效率。

展望未来,随着深度学习技术的不断发展和应用领域的拓宽,对模型保存和加载的需求也将更加多样化和复杂化。相信 PyTorch 社区会不断完善和优化 torch.save() 及相关功能,为我们提供更加高效、灵活和安全的模型序列化工具,推动深度学习领域的持续进步。

🤝 期待与你共同进步

🌱 亲爱的读者,非常感谢你每一次的停留和阅读!你的支持是我们前行的最大动力!🙏

🌐 在这茫茫网海中,有你的关注,我们深感荣幸。你的每一次点赞👍、收藏🌟、评论💬和关注💖,都像是明灯一样照亮我们前行的道路,给予我们无比的鼓舞和力量。🌟

📚 我们会继续努力,为你呈现更多精彩和有深度的内容。同时,我们非常欢迎你在评论区留下你的宝贵意见和建议,让我们共同进步,共同成长!💬

💪 无论你在编程的道路上遇到什么困难,都希望你能坚持下去,因为每一次的挫折都是通往成功的必经之路。我们期待与你一起书写编程的精彩篇章! 🎉

🌈 最后,再次感谢你的厚爱与支持!愿你在编程的道路上越走越远,收获满满的成就和喜悦!祝你编程愉快!🎉

相关博客

| 博客文章标 | 链接地址 |

|---|---|

| 【PyTorch】基础学习:一文详细介绍 torch.save() 的用法和应用 | https://blog.csdn.net/qq_41813454/article/details/136777957?spm=1001.2014.3001.5501 |

| 【PyTorch】进阶学习:一文详细介绍 torch.save() 的应用场景、实战代码示例 | https://blog.csdn.net/qq_41813454/article/details/136778437?spm=1001.2014.3001.5501 |

| 【PyTorch】基础学习:一文详细介绍 torch.load() 的用法和应用 | https://blog.csdn.net/qq_41813454/article/details/136776883?spm=1001.2014.3001.5501 |

| 【PyTorch】进阶学习:一文详细介绍 torch.load() 的应用场景、实战代码示例 | https://blog.csdn.net/qq_41813454/article/details/136779327?spm=1001.2014.3001.5501 |

| 【PyTorch】基础学习:一文详细介绍 load_state_dict() 的用法和应用 | https://blog.csdn.net/qq_41813454/article/details/136778868?spm=1001.2014.3001.5501 |

| 【PyTorch】进阶学习:一文详细介绍 load_state_dict() 的应用场景、实战代码示例 | https://blog.csdn.net/qq_41813454/article/details/136779495?spm=1001.2014.3001.5501 |