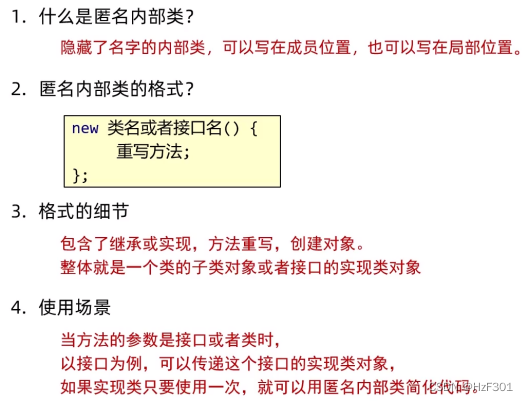

功能展示

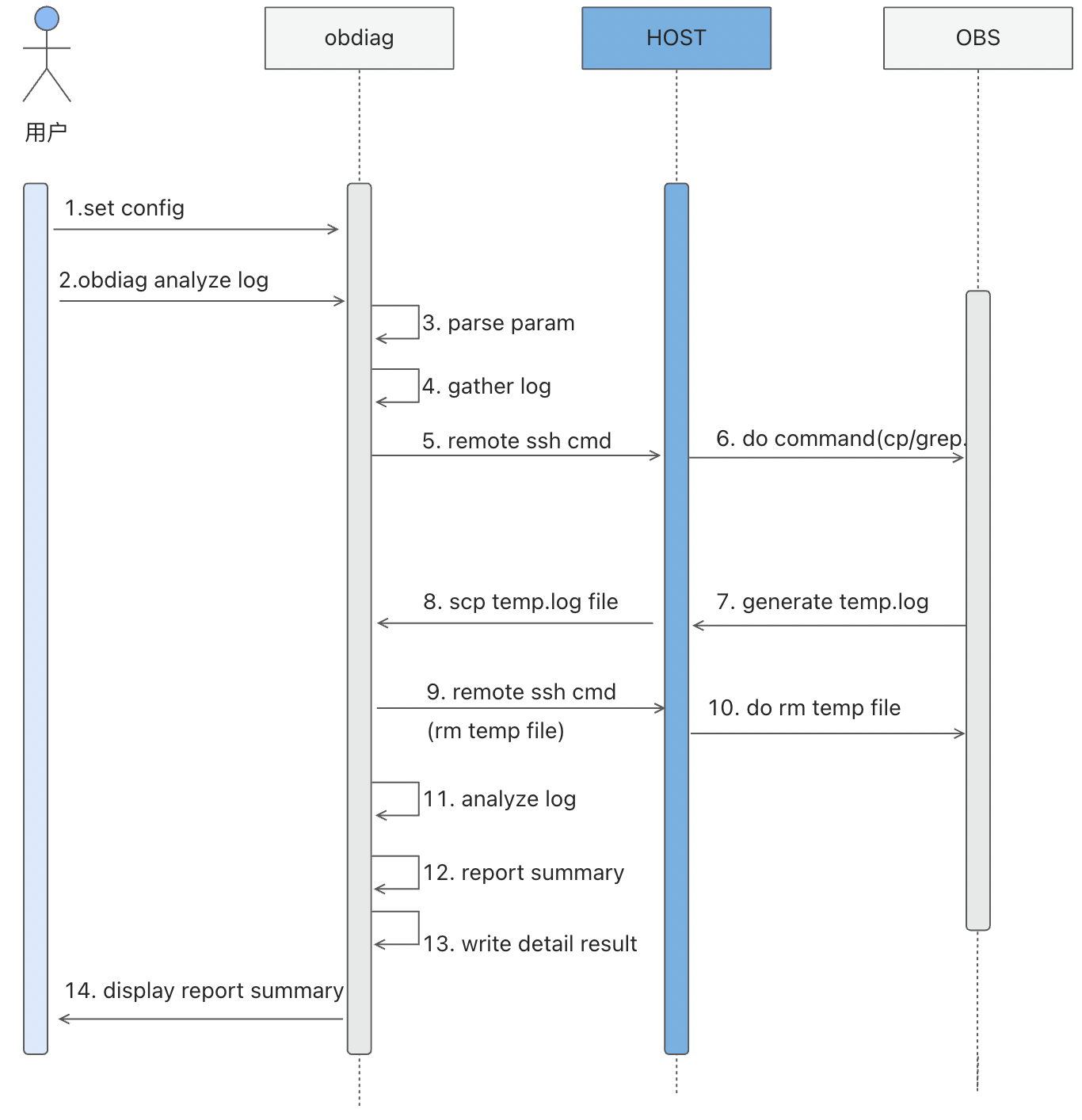

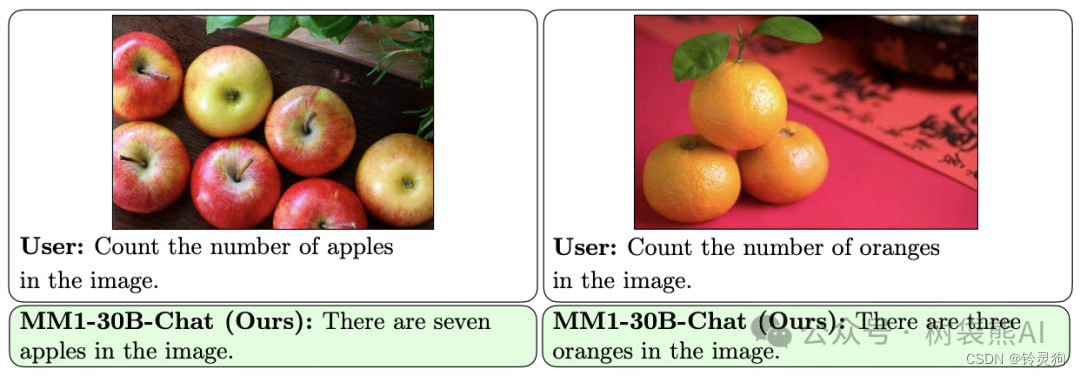

左图问:图片中有多少个苹果?

苹果大模型答:7个

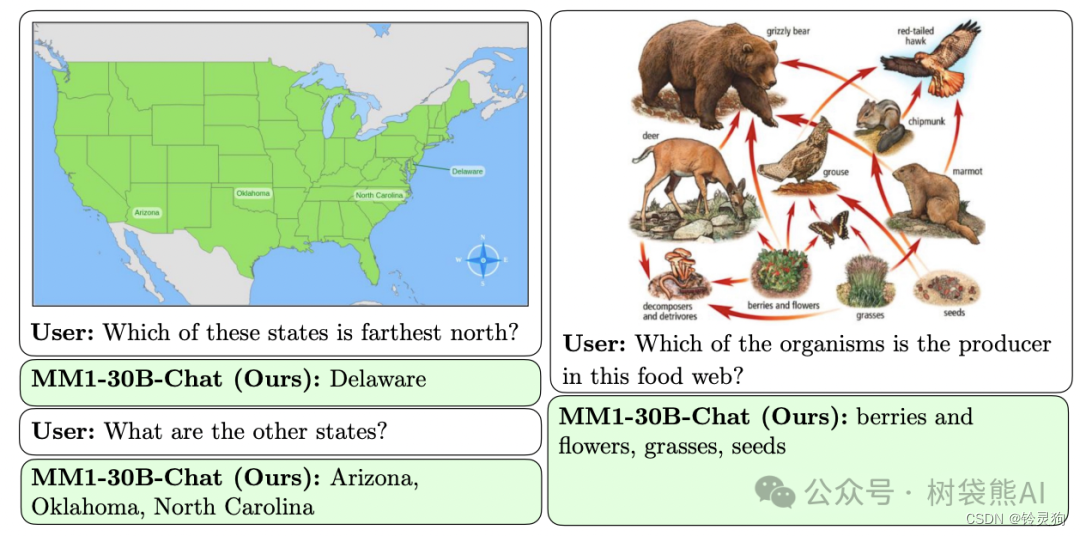

左图问:这些州中哪一个是最北的?

回答:Delaware

追问:其他的州是什么?

回答:Arizona, Oklahoma, North Carolina

右图问:在这个食物网中,哪一个生物是生产者?

回答:浆果和花朵、草类、种子

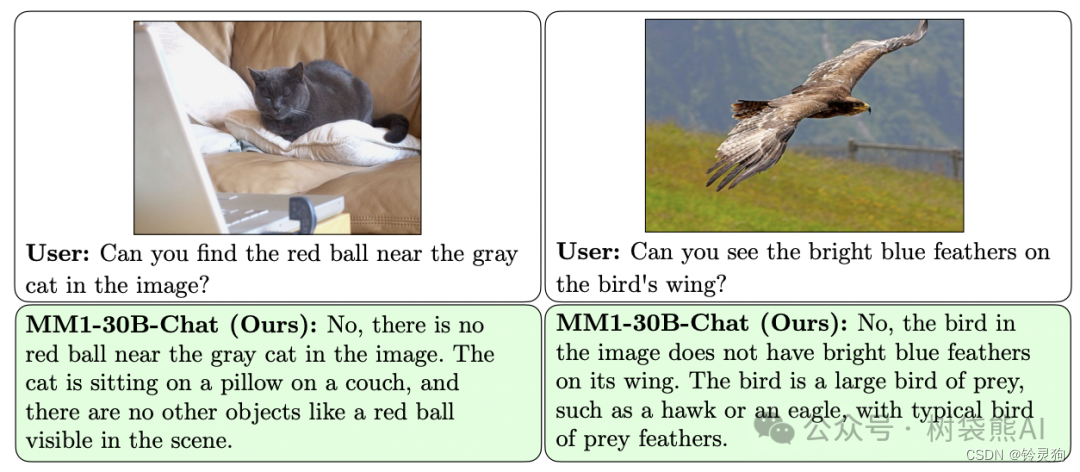

难度升级

左图问:你能找到灰色的猫旁边的红球吗?

MM1并没有上当,直接回答:灰猫旁边没有红球。

右图也是一样的方式,MM1轻松回答。

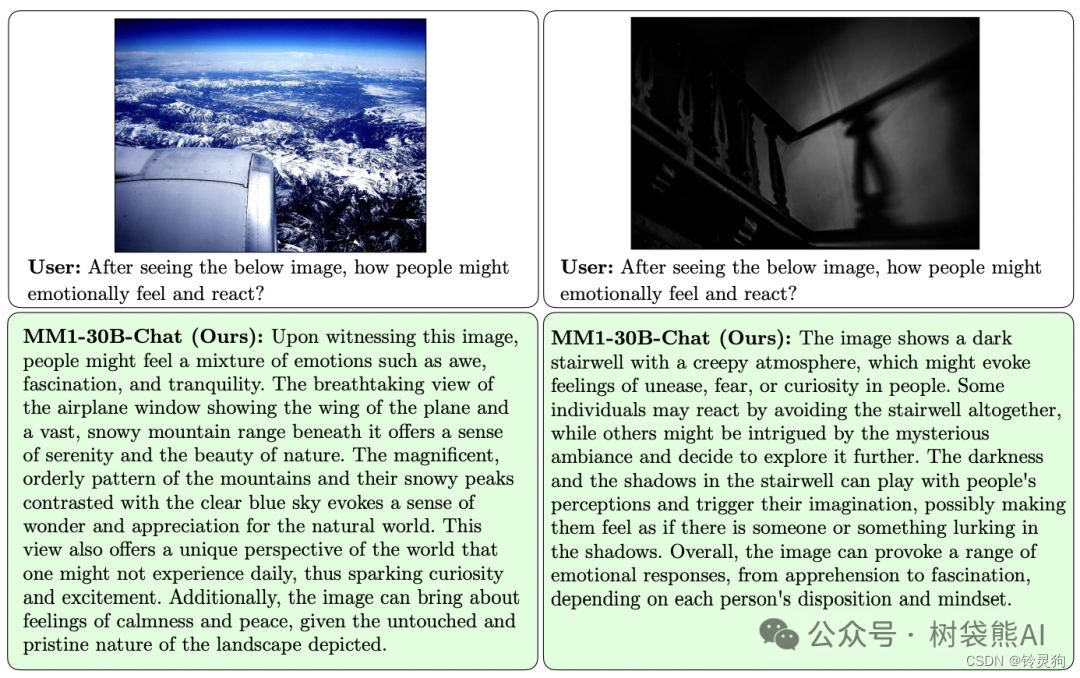

左图问:看到下面的图片后,人们可能会产生怎样的情感和反应?

回答:目睹这张图片时,人们可能会感受到一种敬畏、着迷和宁静的混合情绪。飞机舷窗展示出飞机机翼和广阔的雪山脉的壮丽景色,给人一种宁静和大自然美丽的感觉。雪山的壮观、有序的景观和雪峰与清澈的蓝天形成鲜明对比,唤起了对自然界的敬畏和赞赏之情。这个景象还提供了一种独特的世界观,人们可能不常体验到,因此引发了好奇心和兴奋。此外,这张图片也会带来宁静和平静的感觉,因为所展示的景观是未经触动和原始的。

右图问:看到下面的图片后,人们可能会产生怎样的情感和反应?

回答:这张图片展示了一个黑暗的楼梯间,氛围诡异,可能会在人们心中引起不安、恐惧或好奇等情感。一些人可能会选择完全避开这个楼梯间,而其他人可能会被神秘的氛围所吸引,决定进一步探索。楼梯间的黑暗和阴影可能会影响人们的感知,引发他们的想象,可能让他们觉得有人或某种东西潜伏在阴影中。总的来说,这张图片可能会引起一系列的情感反应,从不安到着迷不等,这取决于每个人的性格和心态。

左图问:对于这两张图片中的每一张,请评论水是否咸。

回答:在第一张图片中,有几艘船漂浮在一片水域上。根据船只的存在,这很可能是一个港口,而且水很可能是咸的,因为大多数港口通常都靠近海洋。然而,没有更多信息,无法确认水的咸度。

在第二张图片中,各种非洲动物,包括大象和长颈鹿,聚集在一个干草田里的水洼周围。这片水域很可能是淡水,因为动物需要饮用淡水。大量动物从水洼中喝水的存在证实了这种水对它们的生存至关重要,并且它们极不可能饮用咸水。

右图问:哪张图片展示了更健康的餐点?

回答:在给定的图片中,展示了更健康的餐点是那张包含西兰花和一碗蔬菜的,还有一盘肉类的图片。添加像西兰花和碗里的蔬菜这样的蔬菜提供了必要的营养、维生素和纤维,有助于保持均衡和更健康的饮食。而有各种配料的比萨和啤酒可能会被认为是不太健康的,因为它可能含有更多的卡路里、脂肪和加工成分,与另一种强调蔬菜和肉类的餐点相比。

MM1可以感知图像美学。

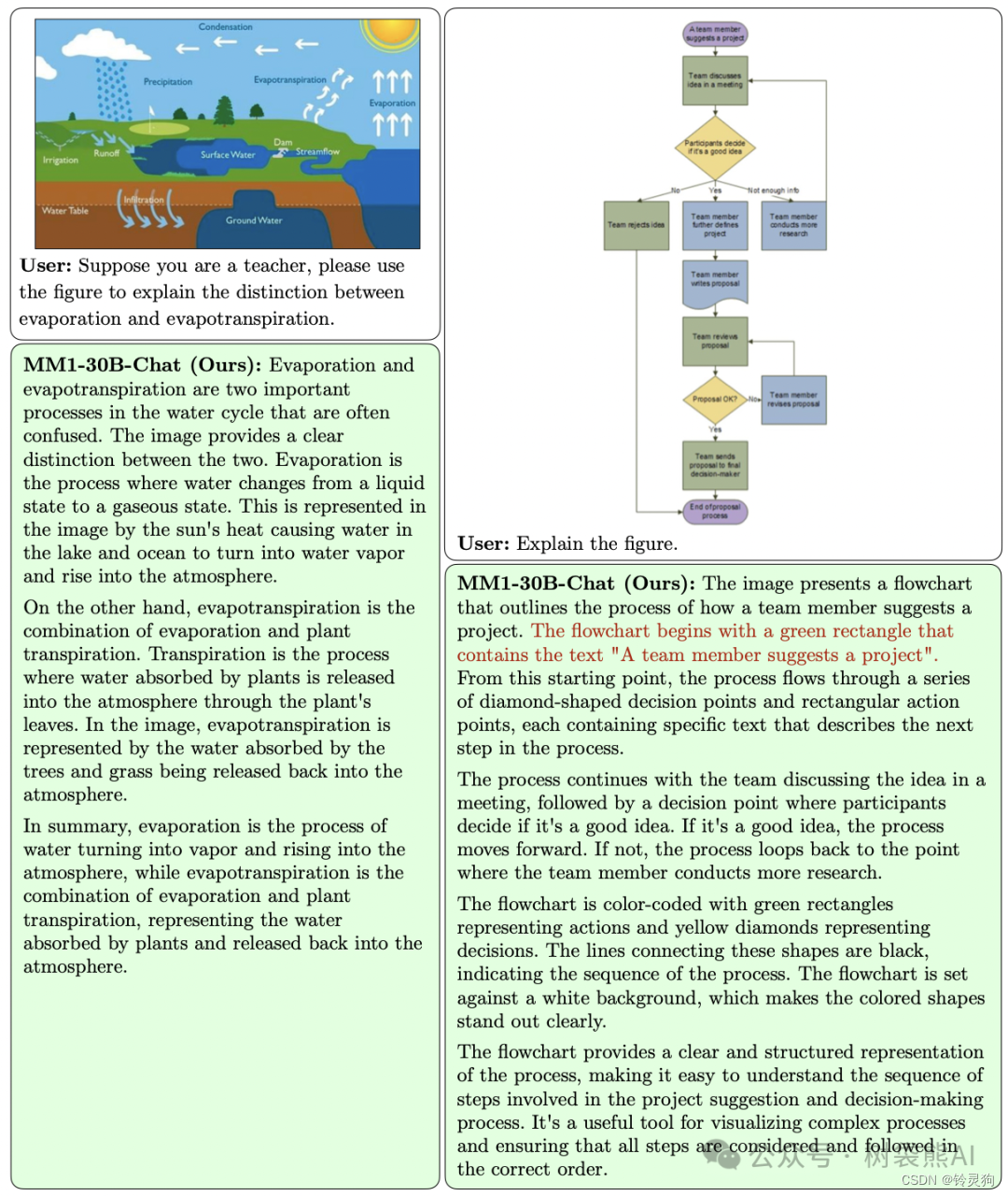

左图问:假设你是一位老师,请使用这个图示来解释蒸发和蒸散发之间的区别。

回答:蒸发和蒸散是水循环中两个重要的过程,经常容易混淆。这个图示清楚地区分了这两者。蒸发是水从液态变为气态的过程。图中,太阳的热量导致湖泊和海洋中的水蒸发成水蒸气,升入大气层中,这就是蒸发的过程。

另一方面,蒸散是蒸发和植物蒸腾的结合。蒸腾是植物吸收的水通过植物的叶子释放到大气中的过程。在图中,蒸散通过树木和草地吸收的水释放回大气中得到了体现。

总而言之,蒸发是水转化为水蒸气并升入大气层的过程,而蒸散是蒸发和植物蒸腾的结合,代表了植物吸收的水释放回大气中的过程。

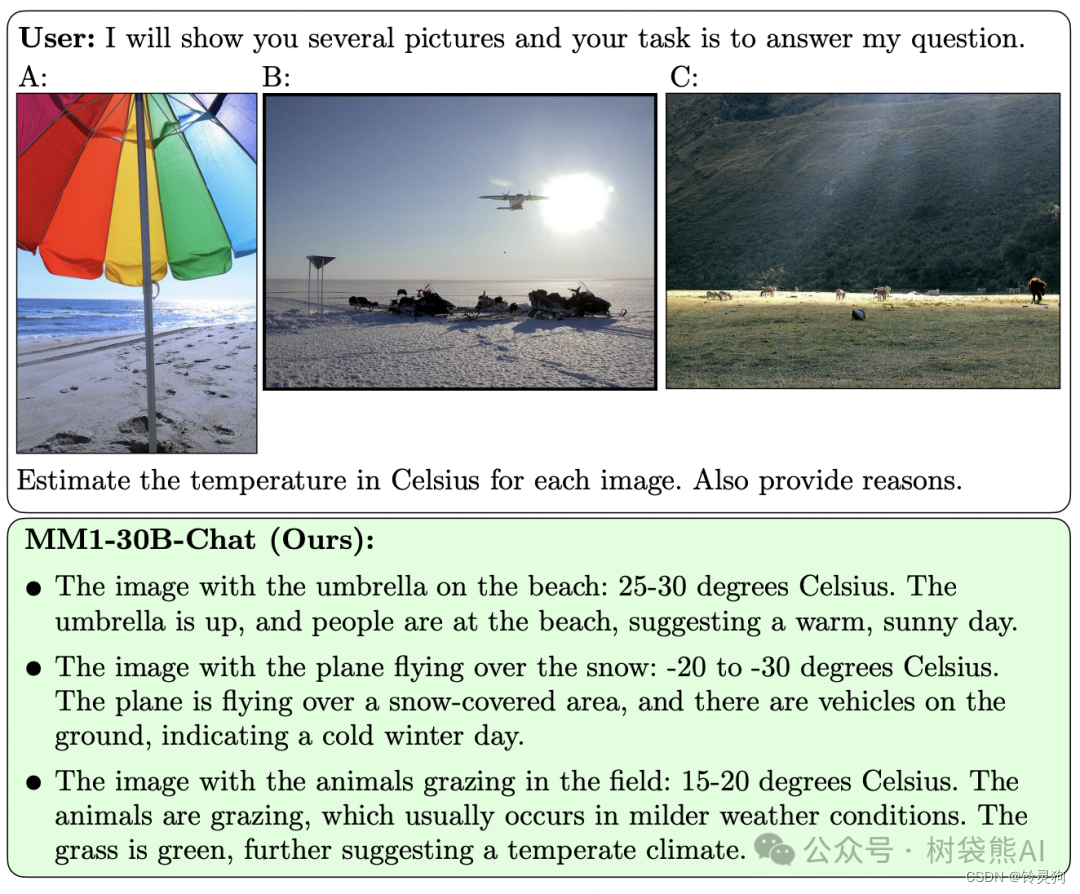

问:估计每张图片的摄氏温度,并提供理由。

海滩上有雨伞的图片:25-30摄氏度。雨伞张开,人们在海滩上,表明是一个温暖、晴朗的日子。

飞机飞过雪地的图片:零下20到零下30摄氏度。飞机飞过一片积雪覆盖的区域,地面上有车辆,表明是一个寒冷的冬日。

在田野里放牧的动物图片:15-20摄氏度。动物在放牧,这通常发生在温和的天气条件下。草是绿色的,进一步表明了温和的气候。

只能说MM1强的离谱

苹果大模型论文

今年以来,苹果已经加大了对生成式人工智能(GenAI)的重视和投入。在 2024 年苹果股东大会上,苹果 CEO 蒂姆・库克表示,今年将在 GenAI 领域实现重大进展。此外,苹果宣布放弃了长达 10 年的造车项目,这导致一部分造车团队成员开始专注于 GenAI。

这一系列举措表明,苹果正在向外界传达其加注 GenAI 的决心。目前,多模态领域的 GenAI 技术和产品非常受欢迎,其中以 OpenAI 的 Sora 最为著名,苹果自然也希望在该领域有所建树。

今天,在一篇由多位作者署名的论文《MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training》中,苹果正式公布了自家的多模态大型模型研究成果 —— 这个模型具有高达 30B 参数的多模态 LLM 系列。

论文地址:https://arxiv.org/pdf/2403.09611.pdf

原文简介:

在这项工作中,我们讨论了构建高性能多模态大型语言模型(MLLMs)的问题。

具体而言,我们研究了各种架构组件和数据选择的重要性。

通过对图像编码器、视觉语言连接器和各种预训练数据选择进行仔细而全面的消融实验,我们确定了几个关键的设计经验教训。例如,我们证明了在大规模多模态预训练中,使用精心选择的图像字幕、交叉图像文本和纯文本数据的混合是至关重要的,可以实现在多个基准测试中达到最新一代(SOTA)少样本结果,相比其他已发表的预训练结果。

此外,我们还表明图像编码器以及图像分辨率和图像令牌数量的设计具有重大影响,而视觉语言连接器的设计相对来说影响较小。

通过扩展所提出的方法,我们构建了MM1,一个多模态模型系列,参数高达30B,包括密集模型和专家混合(MoE)变体,在预训练指标上处于最新一代水平,并在一系列成熟的多模态基准测试上进行监督微调后获得了竞争性的性能。由于大规模预训练,MM1具有诸如增强上下文学习和多图像推理等吸引人的特性,实现了少样本推理链的提示。

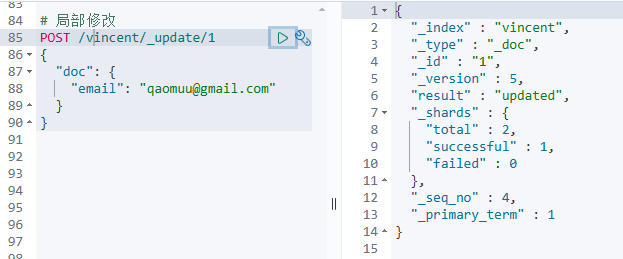

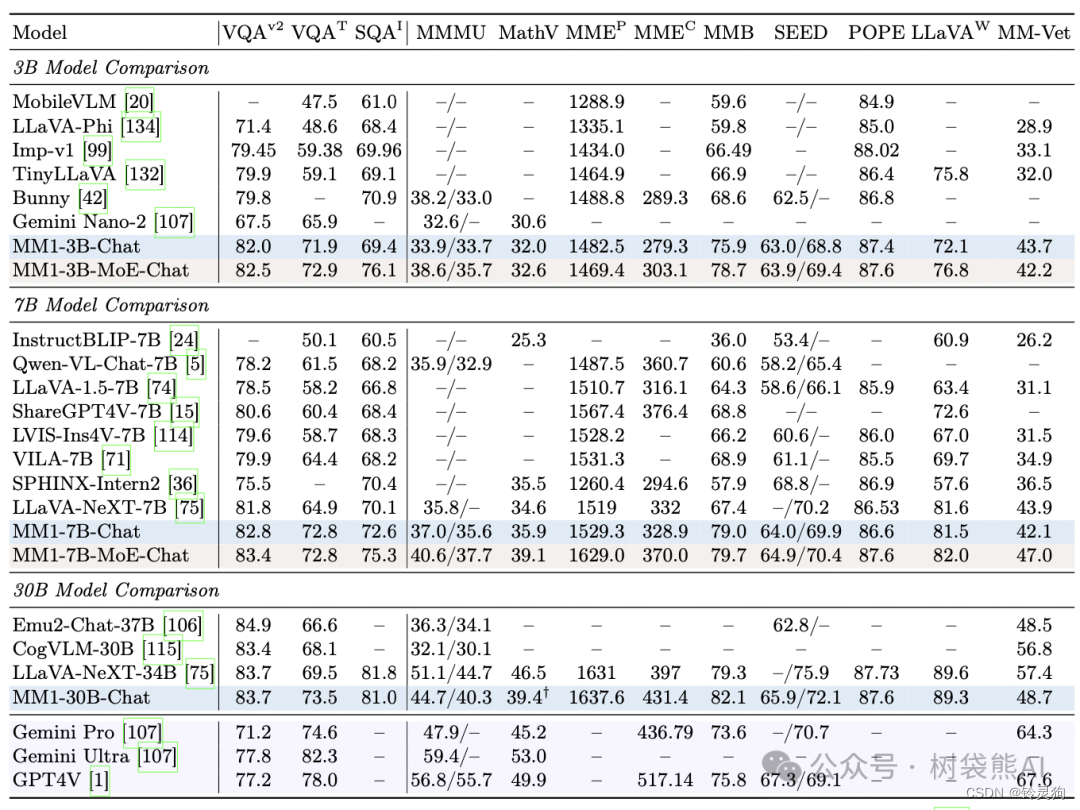

监督微调对比结果

最后,研究者介绍了他们进行的监督微调(SFT)实验,这是在预训练模型之上进行的。

他们遵循了LLaVA-1.5和LLaVA-NeXT的方法,从不同的数据集中收集了大约100万个SFT样本。鉴于直观上,更高的图像分辨率可能会带来更好的性能,研究者还采用了扩展到高分辨率的SFT方法。

监督微调的结果如下:

表中展示了与SOTA模型比较的情况,“-Chat”表示监督微调后的MM1模型。

MM1-3B-Chat和MM1-7B-Chat优于所有列出的相同规模的模型。MM1-3B-Chat和MM1-7B-Chat在VQAv2、TextVQA、ScienceQA、MMBench以及最近的基准测试(MMMU和MathVista)中表现尤为突出。

研究者探索了两种MoE模型:3B-MoE和6B-MoE。在几乎所有基准测试中,苹果的MoE模型都比密集模型取得了更好的性能。这显示了MoE进一步扩展的巨大潜力。

对于30B大小的模型,MM1-30B-Chat在TextVQA、SEED和MMMU上的表现优于Emu2-Chat37B和CogVLM-30B。与LLaVA-NeXT相比,MM1也取得了具有竞争力的全面性能。

LLaVA-NeXT不支持多图像推理,也不支持少样本提示,因为每幅图像都表示为2880个发送到LLM的token,而MM1的token总数只有720个。

更多细节请参考原文。

![[HTML]Web前端开发技术24(HTML5、CSS3、JavaScript )JavaScript基础JavaScript,Netscape,事件处理代码,外部JS——喵喵画网页](https://img-blog.csdnimg.cn/direct/dc56c08b886348fa8632a3bd2175e351.png)