Trust Region Policy Optimization (TRPO) 是一种强化学习算法,专门设计来改善策略梯度方法在稳定性和效率方面的表现。由 John Schulman 等人在 2015 年提出,TRPO 的核心思想是在策略优化过程中引入一个信任区域(trust region),这个区域限制了新策略与旧策略之间的散度,从而确保了策略更新的安全性。

1. 核心概念

TRPO 旨在解决策略更新时可能出现的性能下降问题。它通过限制策略更新步骤中的最大变化,来避免由于大幅度更新导致的性能急剧恶化。这是通过最小化一个目标函数来实现的,该函数在确保策略改进的同时,保持了新旧策略之间的 KL 散度(Kullback-Leibler divergence)在预定的小范围内。

2. 策略更新

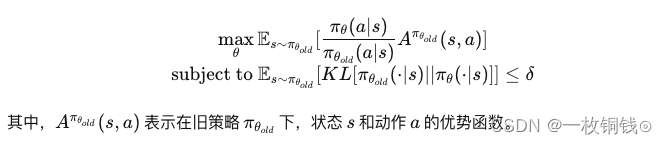

TRPO 使用了一个重要的约束来进行策略更新,即新策略与旧策略之间的平均 KL 散度不超过一个小常数 δ。这种方法可以形式化为一个优化问题:

3. 算法特点

- 稳定性:通过限制策略更新的幅度,TRPO 显著提高了学习过程的稳定性。

- 安全性:确保每次策略更新都在提升或至少不降低性能,避免了大幅更新带来的风险。

- 高效性:尽管 TRPO 在计算上比一些简单的策略梯度方法要复杂,但它在处理高维动作空间和连续动作空间的任务时表现出了高效性和优越性。

4. 应用与影响

TRPO 已经在多个领域得到了应用,包括机器人控制、自然语言处理、游戏AI等。它是后来许多高效强化学习算法的基石,包括 PPO。PPO 可以被看作是 TRPO 的一个简化版本,它通过使用一个裁剪的目标函数来近似 TRPO 的优化过程,旨在减少计算成本并简化实现。

5. 挑战

尽管 TRPO 在稳定性和安全性上有显著优势,但其计算复杂度和实现难度相对较高,这限制了它在某些实时或资源受限的应用场景中的使用。此外,选择合适的信任区域大小(δ 值)对于算法的性能和稳定性有重要影响,需要通过试验来调整。