目录

一、引言

二、CNN算法概述

1 卷积层

2 池化层

3 全连接层

三、CNN算法原理

1 前向传播

2 反向传播

四、CNN算法应用

1 图像分类

2 目标检测

3 人脸识别

六、CNN的优缺点

优点:

1 特征提取能力强

2 平移不变性

3 参数共享

4 层次化表示

缺点:

1 对输入数据要求较高

2 计算量大

3 可解释性较差

代码片段

六、优化CNN的计算效率

1 处理过拟合的问题

(1 数据增强(Data Augmentation)

(2 正则化(Regularization)

(3 提前终止(Early Stopping)

2 模型压缩与剪枝

3 使用高效的网络结构

4 使用更高效的卷积算法

七、总结与展望

一、引言

CNN(Convolutional Neural Network,卷积神经网络)算法是一种深度学习算法,特别适用于处理图像数据。随着大数据时代的到来,图像数据呈现出爆炸式增长。传统的图像处理算法往往依赖于手工设计的特征提取器,这种方式不仅效率低下,而且难以应对复杂的图像变化。CNN算法的出现,极大地提高了图像处理的效率和准确性,成为计算机视觉领域的研究热点。

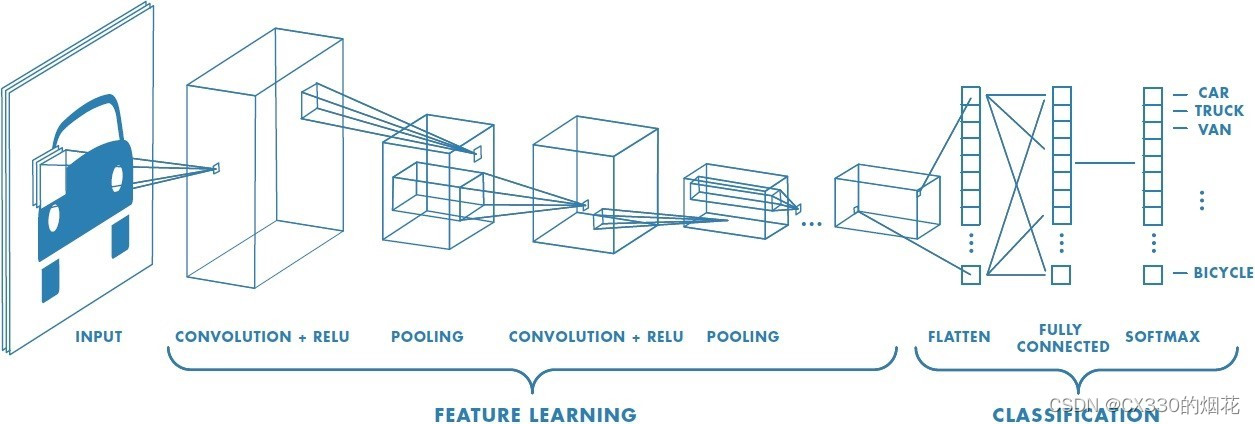

二、CNN算法概述

CNN算法是一种特殊的神经网络,其结构主要由卷积层、池化层和全连接层组成。卷积层负责提取图像中的局部特征,池化层用于降低数据的维度,减少计算量,而全连接层则负责将提取的特征进行分类或识别。

1 卷积层

卷积层是CNN的核心部分,它通过使用多个卷积核对输入图像进行卷积运算,提取出图像中的局部特征。每个卷积核都代表一种特定的特征提取方式,通过不断地学习和调整,CNN能够自动找到最适合的特征提取方式。

2 池化层

池化层位于卷积层之后,其主要作用是降低数据的维度,减少计算量。常见的池化方式有最大池化和平均池化。最大池化选取每个池化区域内的最大值作为输出,而平均池化则计算每个池化区域内的平均值作为输出。

3 全连接层

全连接层位于CNN的最后部分,它将前面层提取的特征进行整合,并通过分类器(如softmax)进行分类或识别。全连接层的参数数量较多,因此容易产生过拟合现象,需要通过正则化、dropout等方法进行优化。

三、CNN算法原理

CNN算法的核心思想是通过卷积运算和池化操作,逐步提取图像中的高级特征。在训练过程中,CNN通过反向传播算法不断调整卷积核和全连接层的参数,以最小化预测值与实际值之间的误差。

1 前向传播

在前向传播过程中,输入图像首先经过卷积层进行特征提取,然后通过池化层进行降维操作。经过多个卷积层和池化层的堆叠后,提取出的特征被送入全连接层进行分类或识别。最终,全连接层的输出即为CNN的预测结果。

2 反向传播

在反向传播过程中,CNN根据预测结果与实际值之间的误差,计算损失函数的梯度,并通过链式法则将梯度逐层反向传播至卷积层和全连接层。然后,根据梯度信息更新各层的参数,以减小损失函数的值。

四、CNN算法应用

CNN算法在图像处理领域具有广泛的应用,包括图像分类、目标检测、人脸识别等。以下是一些具体的应用场景:

1 图像分类

CNN算法在图像分类任务中取得了显著的效果。通过训练大量的图像数据,CNN能够自动学习到不同类别的特征表示,从而实现对新图像的准确分类。

2 目标检测

在目标检测任务中,CNN算法能够识别出图像中的目标物体并定位其位置。常见的目标检测算法有Faster R-CNN、YOLO等,它们通过结合区域提议网络和卷积神经网络,实现了高效且准确的目标检测。

3 人脸识别

人脸识别是CNN算法的另一个重要应用。通过训练人脸数据集,CNN能够学习到人脸的特征表示,并实现对新人脸的准确识别。人脸识别技术在安全监控、身份验证等领域具有广泛的应用前景。

六、CNN的优缺点

优点:

1 特征提取能力强

CNN可以自动从输入数据中提取有用的特征,特别适合处理图像和视频等具有空间结构的数据。

2 平移不变性

CNN的卷积层具有平移不变性,即对于图像中的物体位置变化,CNN仍然能够识别出相同的特征。

3 参数共享

CNN通过共享卷积核的参数,降低了模型的复杂度,减少了训练参数的数量,提高了训练效率。

4 层次化表示

CNN通过多层卷积和池化操作,能够逐步提取从低级到高级的特征表示,从而更好地理解输入数据。

缺点:

1 对输入数据要求较高

CNN通常要求输入数据具有固定的尺寸和格式,对于非规则或变长的数据处理能力较弱。

2 计算量大

CNN的训练和推理过程需要大量的计算资源,特别是在处理大规模数据集和复杂模型时。

容易过拟合:当训练数据不足或模型过于复杂时,CNN容易出现过拟合现象,导致在测试集上的性能下降。

3 可解释性较差

CNN的内部工作机制相对复杂,不易于理解和解释,这给模型调优和错误分析带来了一定的困难。

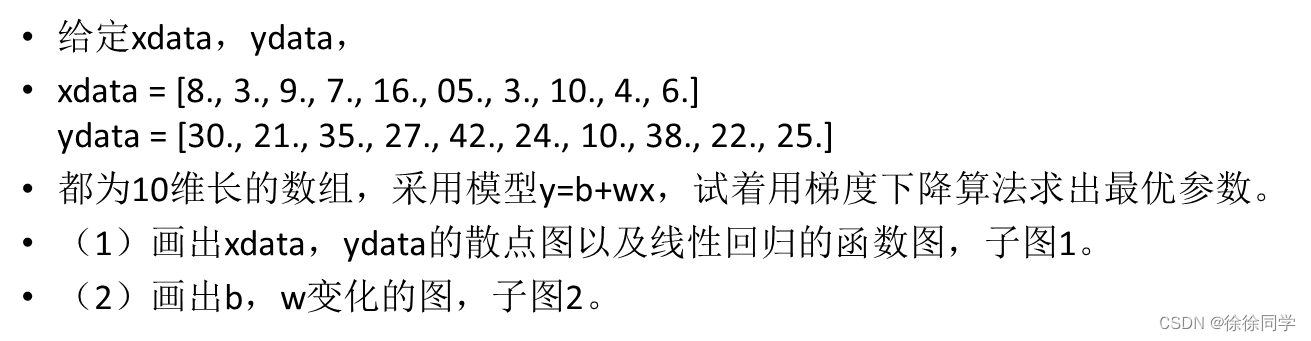

代码片段

以下是一个简单的CNN代码示例,使用Python的深度学习库TensorFlow和Keras实现。这个示例是一个用于图像分类的CNN模型,以MNIST数据集为例。

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

# 加载MNIST数据集

(train_images, train_labels), (test_images, test_labels) = datasets.mnist.load_data()

# 归一化像素值到0-1之间

train_images, test_images = train_images / 255.0, test_images / 255.0

# 将图像形状从(28, 28)调整为(28, 28, 1)以匹配CNN的输入要求

train_images = train_images[..., tf.newaxis]

test_images = test_images[..., tf.newaxis]

# 创建CNN模型

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

# 添加Flatten层,将特征图展平

model.add(layers.Flatten())

# 添加全连接层

model.add(layers.Dense(64, activation='relu'))

# 添加输出层

model.add(layers.Dense(10))

# 编译模型

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

# 训练模型

history = model.fit(train_images, train_labels, epochs=5,

validation_data=(test_images, test_labels))

# 评估模型

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print('\nTest accuracy:', test_acc)

在这个例子中,我们首先加载了MNIST数据集,并对图像进行了预处理。然后,我们定义了一个包含卷积层、池化层和全连接层的CNN模型。模型被编译以使用Adam优化器和稀疏分类交叉熵损失函数。最后,我们使用训练数据对模型进行训练,并在测试数据上评估其性能。

六、优化CNN的计算效率

1 处理过拟合的问题

(1 数据增强(Data Augmentation)

通过对训练数据进行一系列的随机变换来扩充数据集,以增加样本的多样性。这些变换可能包括图像平移、旋转、缩放、翻转等操作。数据增强可以有效地减少过拟合问题,因为它使得模型在训练时能够接触到更多的数据变体,从而提高其泛化能力。

(2 正则化(Regularization)

通过对模型的复杂性进行约束来减少过拟合。在CNN中,常见的正则化方法包括L1正则化、L2正则化和Dropout。L1和L2正则化通过向损失函数添加正则化项来惩罚模型中的大权重值,以减少模型的复杂性。Dropout则通过在训练过程中随机关闭一部分神经元,强制模型学习更鲁棒的特征表示。

(3 提前终止(Early Stopping)

这是一种正则化策略,用于在验证集上的错误率开始上升之前停止训练。通过监控验证集上的性能,当发现模型开始出现过拟合时,及时停止训练可以防止模型复杂度过高。

2 模型压缩与剪枝

通过移除网络中冗余或贡献较小的部分,减少模型参数数量,从而降低计算复杂度。权重裁剪是一种常用的方法,它根据权重的重要性设定阈值,将低于阈值的权重裁剪为0,进而减少模型的计算量。

3 使用高效的网络结构

选择或设计计算效率更高的网络结构,如ShuffleNet,它使用逐点群卷积和信道重排技术,降低了计算成本同时保持了较好的精度。

量化与低精度计算:通过将模型参数和激活值从32位浮点数转化为更低精度的数值(如8位整数),可以大幅减少计算量和内存消耗。硬件支持的低精度计算可以进一步提高计算效率。

4 使用更高效的卷积算法

例如,Winograd卷积算法可以在某些情况下减少卷积运算的计算量。此外,FFT(快速傅里叶变换)也可以用于加速卷积运算。

七、总结与展望

CNN算法作为一种强大的深度学习算法,在图像处理领域取得了显著的成果。通过不断地优化和改进,CNN算法的性能将得到进一步提升