随着AI技术和相关应用的不断发展,大模型、大数据和AI计算能力在AI发展中的重要性日益凸显。大模型和数据集构成AI研究的软件基础,而AI算力是关键的基础设施。在本文中,我们将探讨AI发展对数据中心网络架构的影响。

Fat-Tree数据中心网络架构

随着AI大模型训练在各个行业的广泛应用,传统的网络无法满足大模型集群训练的带宽和延迟要求。大模型分布式训练需要GPU之间的通信,且其流量模式与传统云计算不同,这增加了AI/ML数据中心的东西向流量。短期和高量的AI数据导致传统网络架构中的网络延迟和训练性能降低。因此,为了满足短期和高量数据处理需求,Fat-Tree网络的出现是必然的。

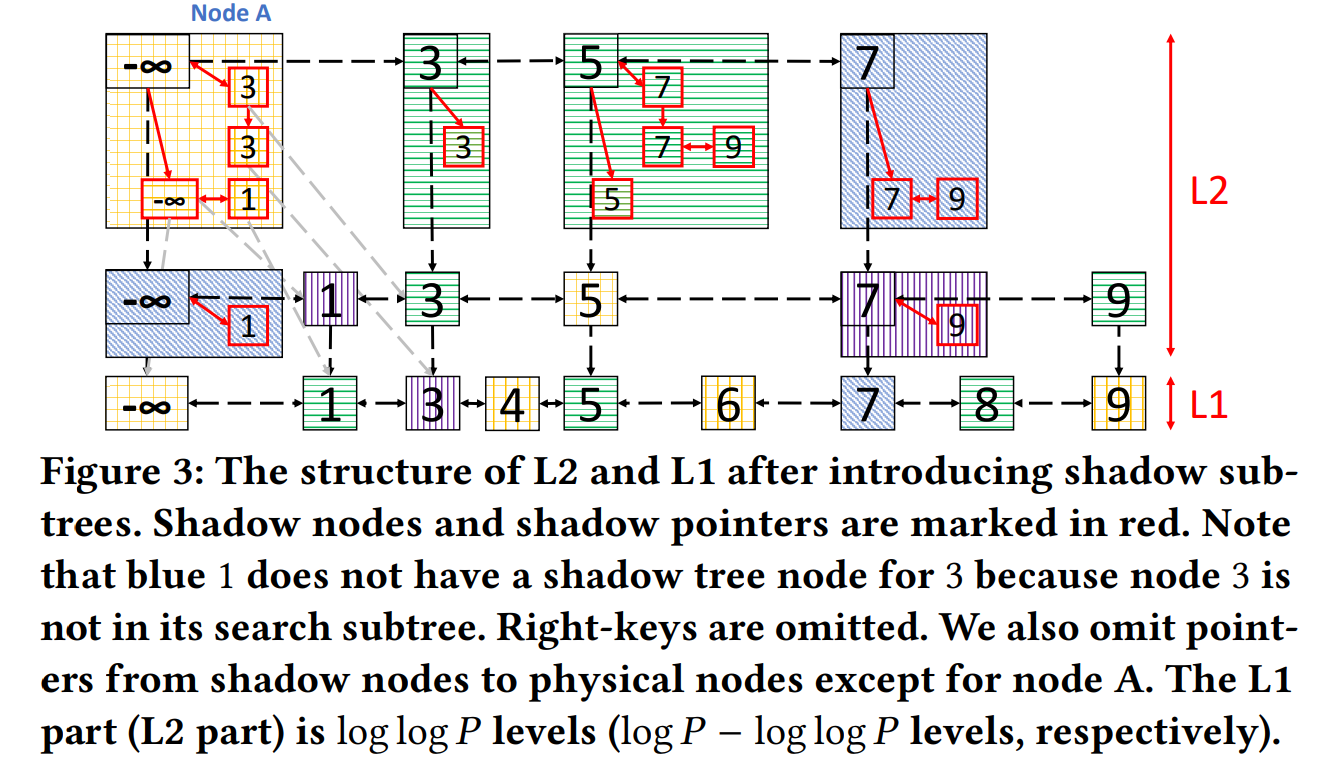

在传统的树状网络拓扑中,带宽逐层汇聚,树的底部网络带宽远小于所有叶节点的总带宽。相比之下,Fat-Tree看起来像一棵真正的树,靠近根部的分支更粗。因此,网络带宽从叶到根部逐渐增加,提高了网络效率并加速了训练过程。这是Fat-Tree架构的基本前提,可以实现非阻塞的网络。

数据中心网络速率升级演进

随着数据中心应用复杂性的不断提高,对网络速度的需求也在不断增长。从过去的1G、10G和25G到如今广泛使用的100G,数据中心网络升级和演进的速度正在加快。然而,面对大规模的人工智能工作负载,400G和800G传输速率已成为数据中心网络演进的下一个关键进程。

AI数据中心推动400G/800G光模块的发展

400G/800G光模块需求不断增长的原因

大规模数据处理需求

AI算法的训练和推理需要大量的数据集,因此,数据中心必须能够高效处理大量数据的传输。800G光模块的出现提供了更大的带宽,有助于解决这个问题。升级后的数据中心网络架构通常包括两个层级,从交换机延伸到服务器,其中400G作为底层。因此,升级到800G也会推动对400G的需求增长。

实时需求

在某些AI应用场景中,对实时数据处理的需求至关重要。例如,在自动驾驶系统中,传感器生成的海量数据需要快速传输和处理,优化系统延迟成为确保及时响应的关键因素。高速光模块的引入通过降低数据传输和处理的延迟,迅速满足这些实时需求,从而提高系统的响应能力。

多任务并发

现代AI数据中心通常需要同时处理多个任务,包括图像识别和自然语言处理等活动。采用高速800G/400G光模块可以增强对这种多任务工作负载的支持。

400G/800G光模块市场前景广阔

目前,400G和800G光模块的需求尚未出现显著增长,但预计2024年将受到AI计算需求增长的推动出现明显提升。据Dell'Oro预测,2024年400G光模块的需求将有所增加。AI、大数据和云计算驱动的高速率数据传输需求日益增长,有望加速800G光模块市场的增长。这一趋势凸显了800G/400G光模块市场的光明前景,在应对先进计算应用不断变化需求的过程中,其应用将逐步增多。

典型数据中心的400G/800G光模块解决方案

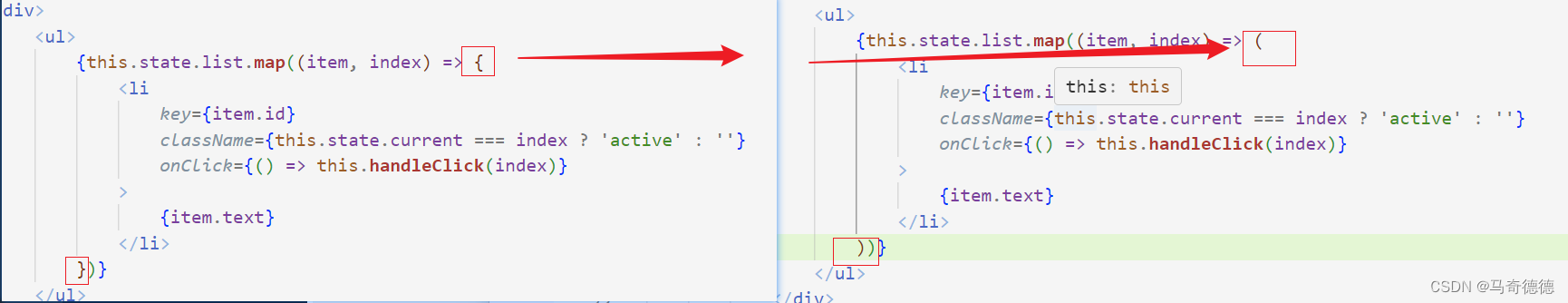

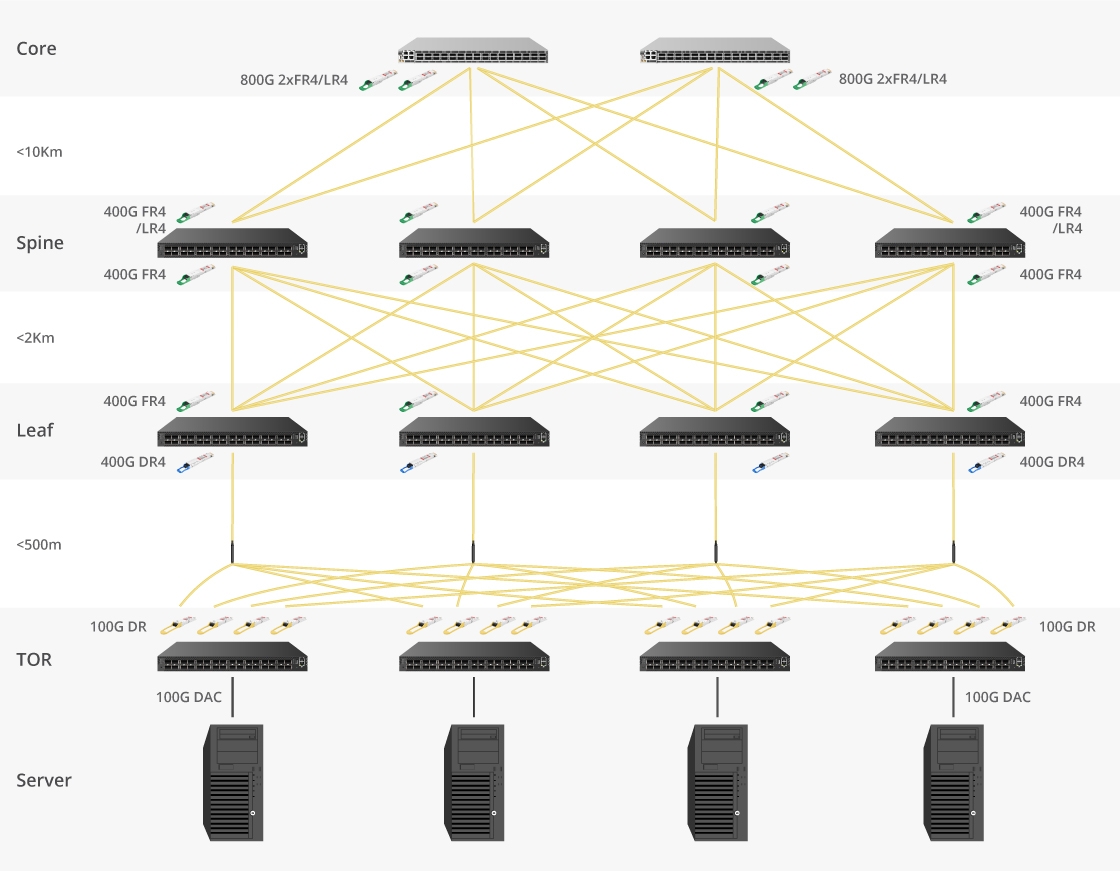

该图展示升级至800G数据中心的解决方案。飞速(FS)QDD-FR4-400G光模块和QDD800-2FR4-C1光模块在骨干层中的MSN4410-WS2FC交换机和核心层中的高性能800G交换机之间形成高带宽链路,以400G接口速率运行。

由于这些光模块采用高密度的QSFP-DD封装,可在高密度配置中部署。这增加了传输容量并提供了更大的带宽速率。此外,通过采用PAM4调制和重定时技术,这些光模块实现了更快的数据传输速率,同时显著降低了延迟,改善了整体系统性能。

800G/400G光模块新时代

随着对更快、更高效数据传输需求的不断增长,800G/400G光模块的时代已全面来临。这些光模块以其出色的带宽能力、LPO技术的进步和经济效益而备受青睐,有望改变AI领域并重新定义数据中心。利用高速光模块,完全开发和训练AI已不再只是构想。