介绍了一下InternLm的总体情况。

InternLm是训练框架,Lagent是智能体框架。

这个预训练需要这么多算力,大模型确实花钱。

Lagent是智能体框架,相当于LLM的应用。

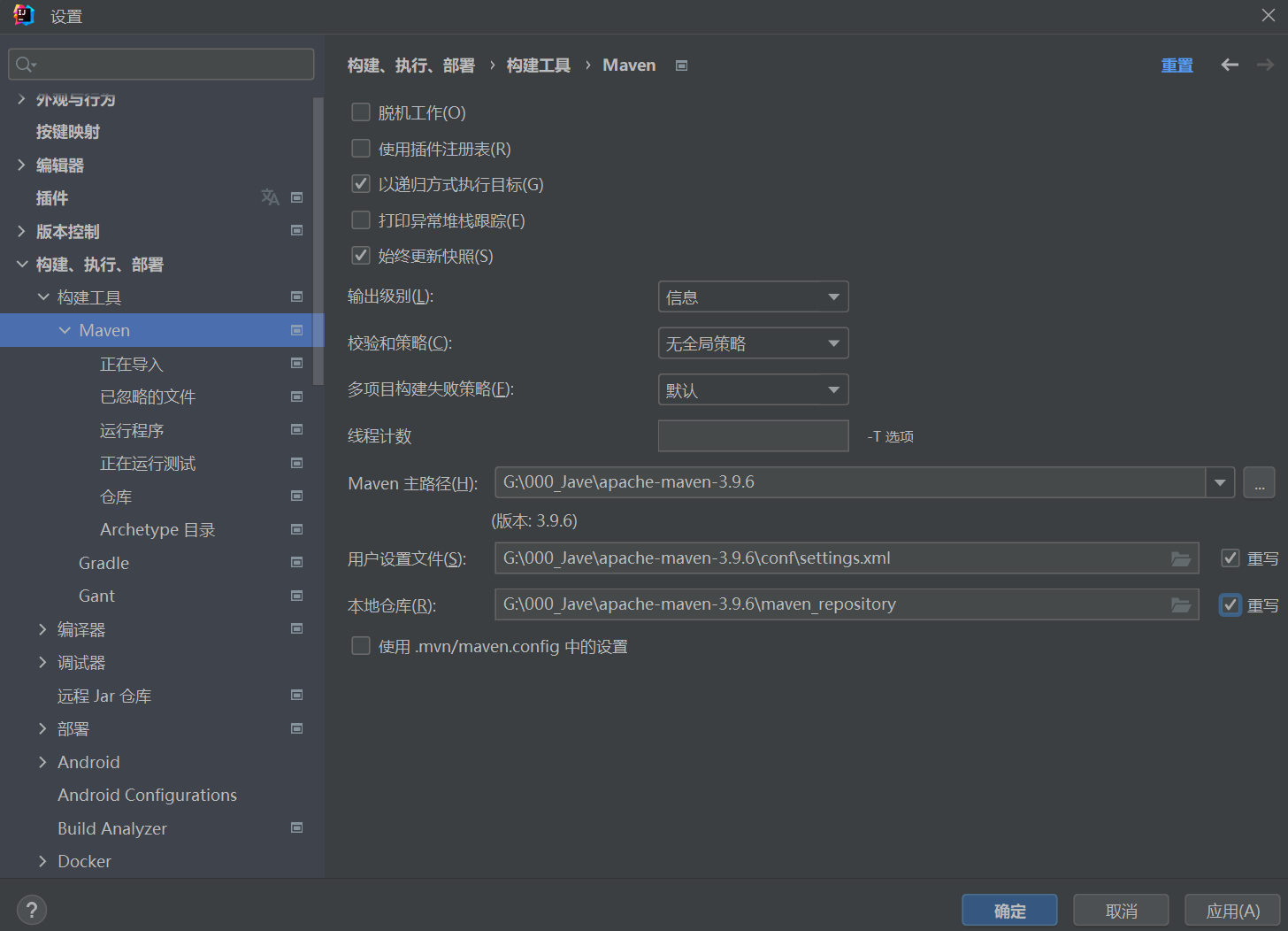

pip设置

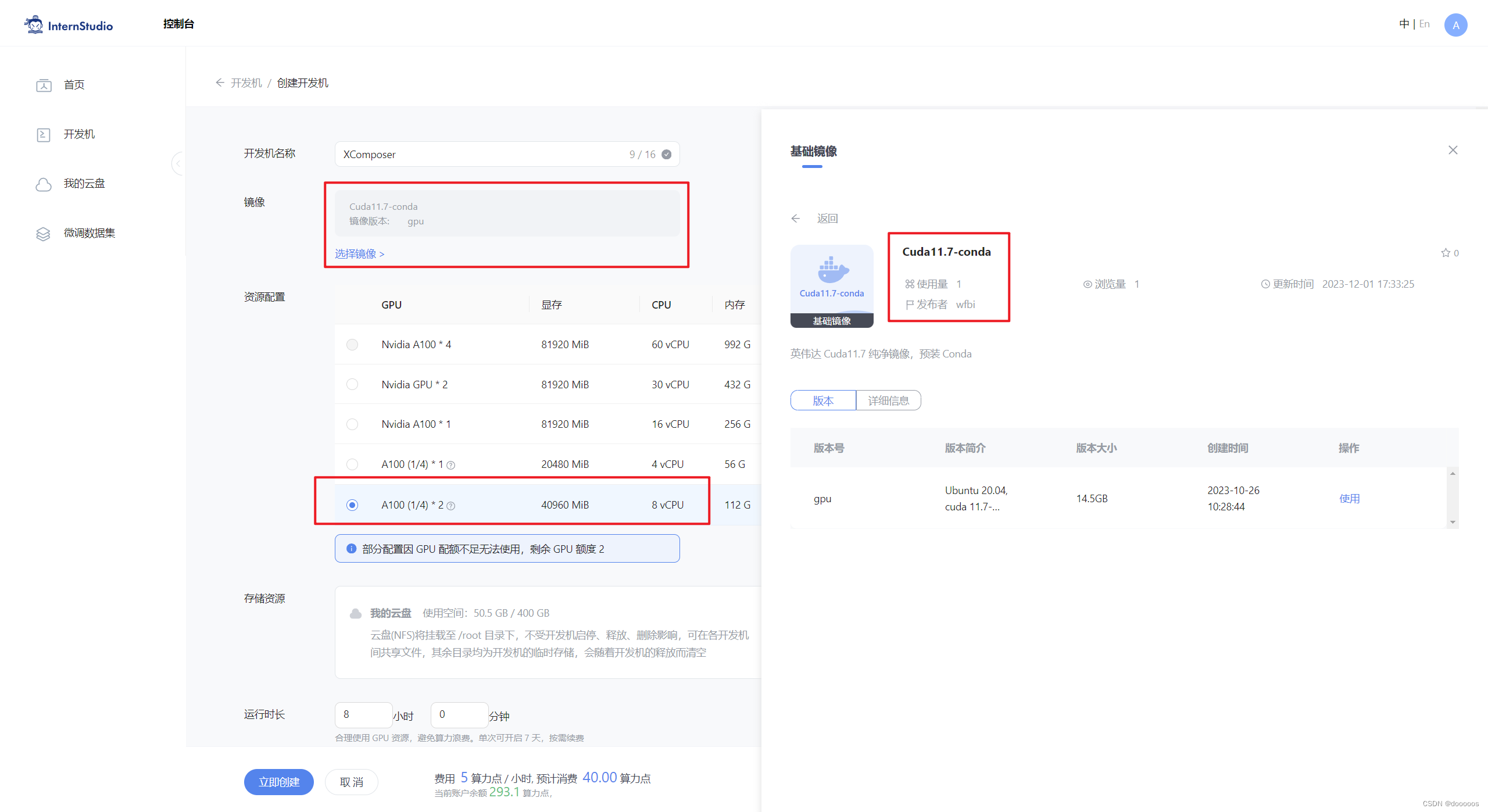

开发机的配置

pip install transformers==4.33.1 timm==0.4.12 sentencepiece==0.1.99 gradio==3.44.4 markdown2==2.4.10 xlsxwriter==3.1.2 einops accelerate

安装依赖设置

bash

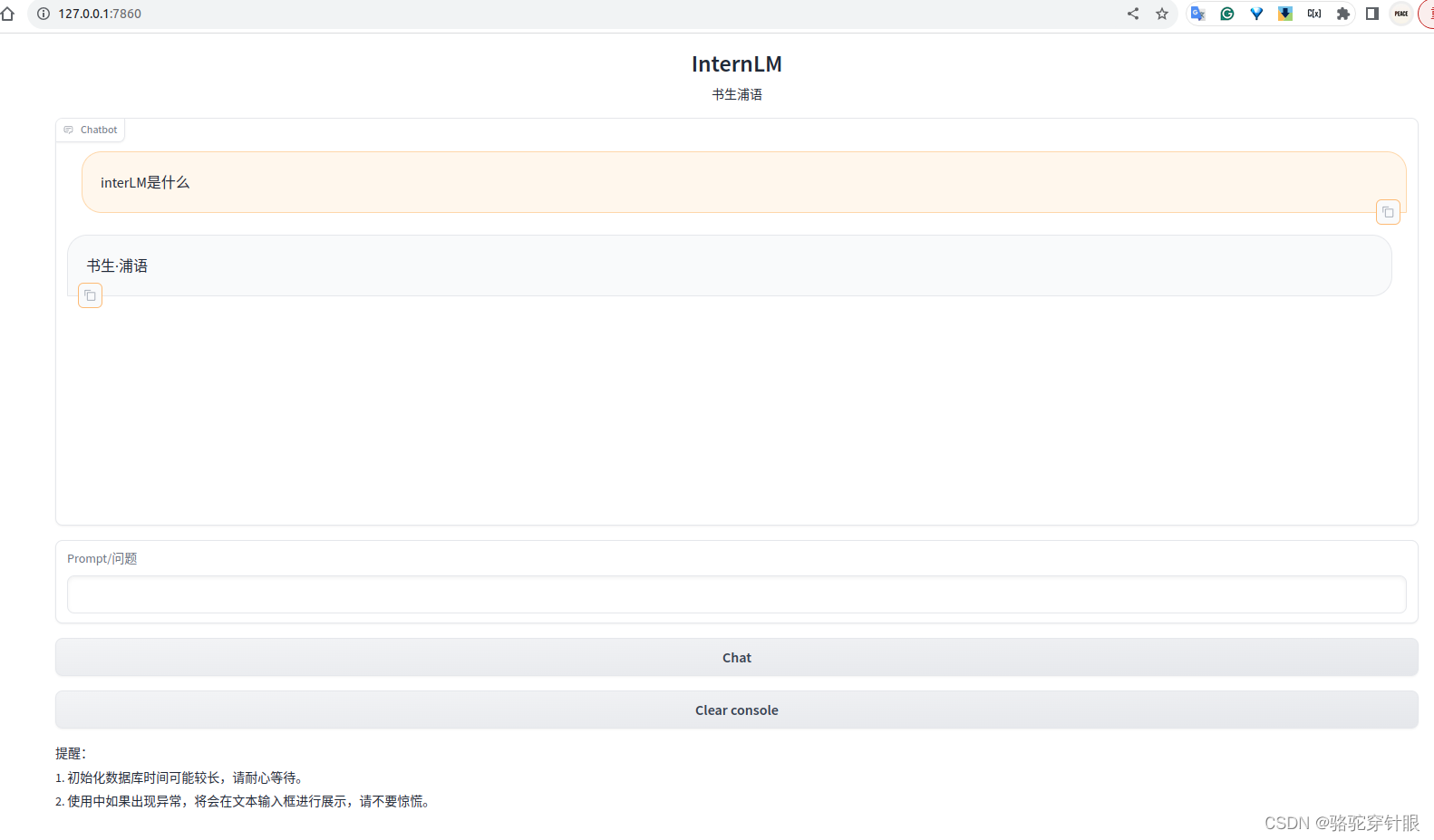

conda activate internlm-demo # 首次进入 vscode 会默认是 base 环境,所以首先切换环境

cd /root/code/InternLM

streamlit run web_demo.py --server.address 127.0.0.1 --server.port 6006

web_demo启动方式(主要不是直接用python运行,需要streamlit run)

import os

# 下载模型

os.system('huggingface-cli download --resume-download internlm/internlm-chat-7b --local-dir your_path')

hugging face下载模型的代码

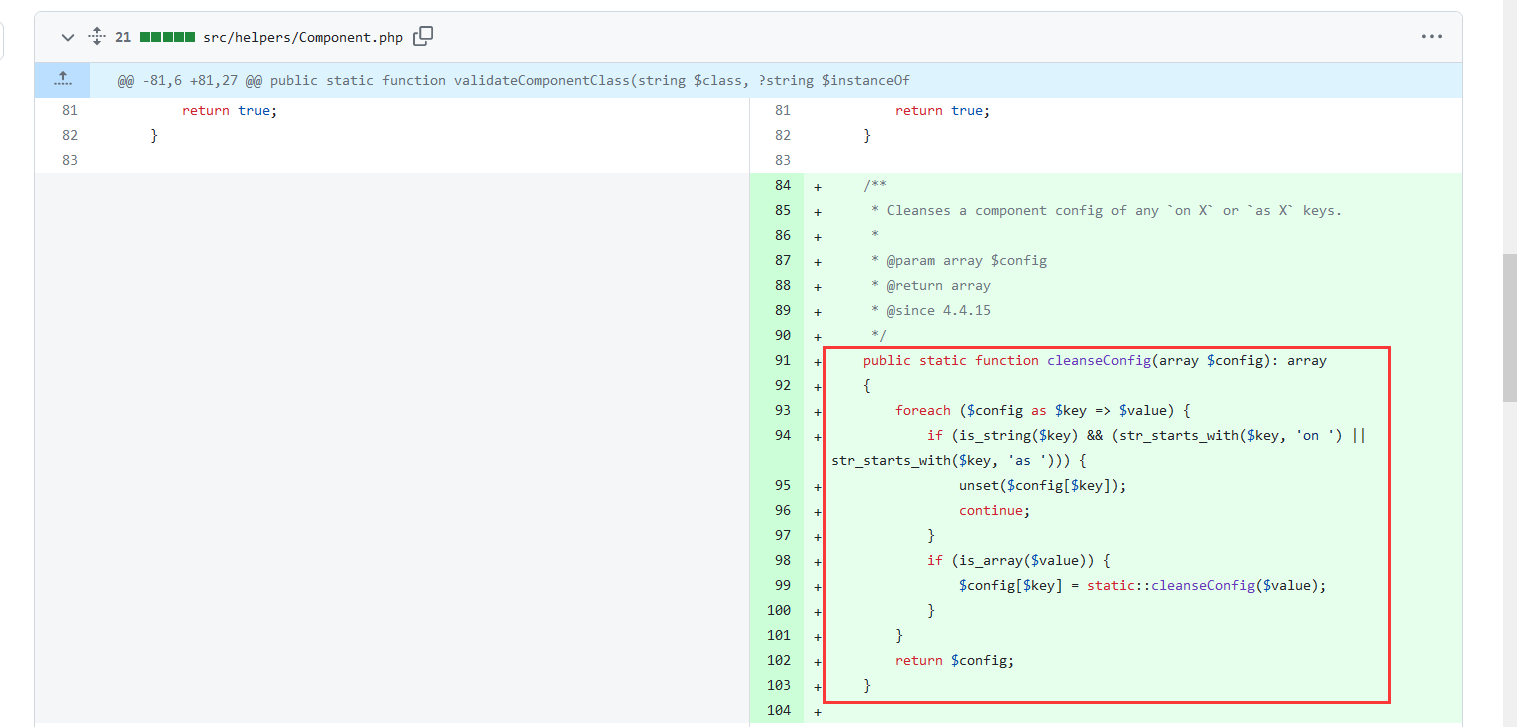

![[C#] 如何调用Python脚本程序](https://img-blog.csdnimg.cn/direct/542d30c1bf2d4687a67f3aaa4950ded9.png)