Layer Norm 的计算公式

Layer Norm(层归一化)是一种用于神经网络中的归一化技术,用于提高模型的训练效果和泛化能力。

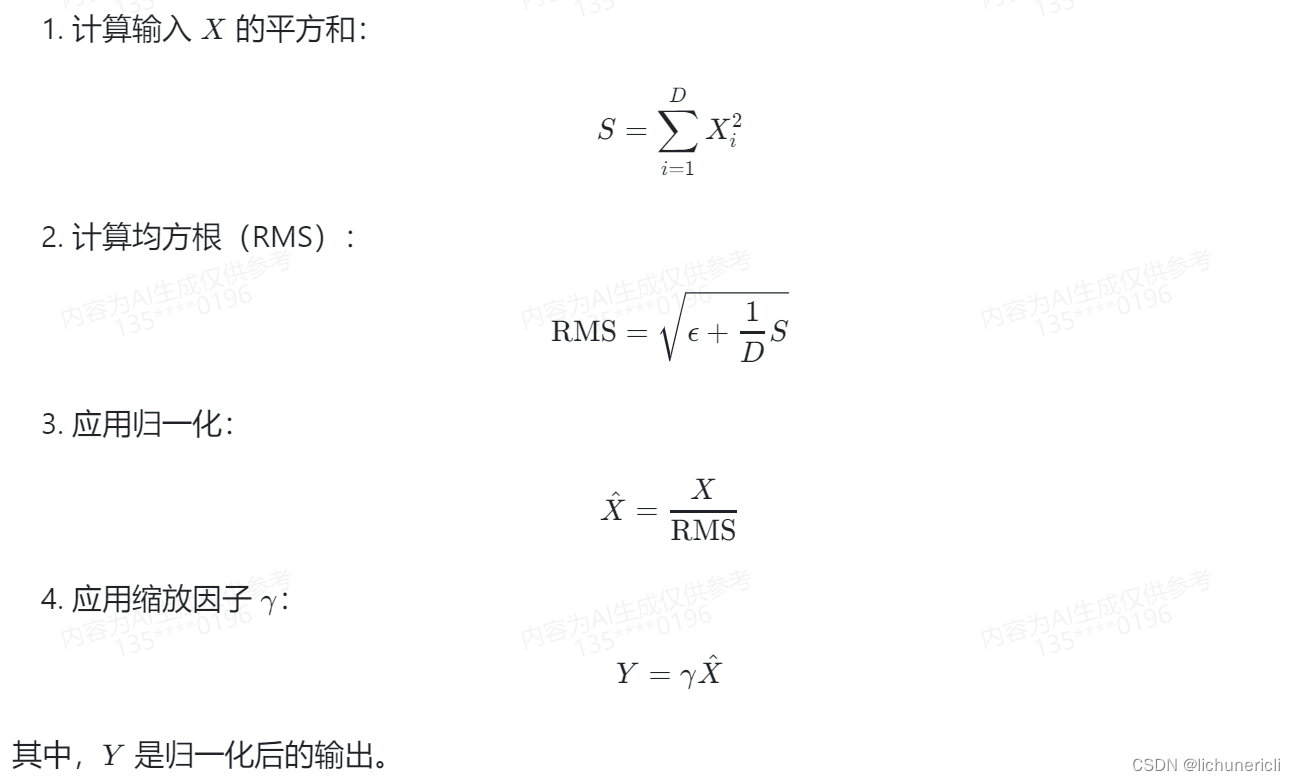

RMS Norm 的计算公式

RMS Norm 的作用是通过计算输入 X 的均方根,将每个样本的特征进行归一化,使得特征在不同样本之间具有相似的尺度,有助于提高模型的训练效果和泛化能力。RMS Norm 通常用于优化器中,例如在 AdamW 优化器中,它被用作权重衰减的一种形式。

RMS Norm 相比于 Layer Norm 有什么特点?

RMS Norm(Root Mean Square Norm)和 Layer Norm 是两种常用的归一化方法,它们在实现上有一些不同之处。

-

计算方式:RMS Norm 是通过计算输入数据的平方均值的平方根来进行归一化,而 Layer Norm 是通过计算输入数据在每个样本中的平均值和方差来进行归一化。

-

归一化范围:RMS Norm 是对整个输入数据进行归一化,而 Layer Norm 是对每个样本进行归一化。

-

归一化位置:RMS Norm 通常应用于循环神经网络(RNN)中的隐藏状态,而 Layer Norm 通常应用于卷积神经网络(CNN)或全连接层中。

-

归一化效果:RMS Norm 在处理长序列数据时可能会出现梯度消失或梯度爆炸的问题,而 Layer Norm 能够更好地处理这些问题。

综上所述,RMS Norm 和 Layer Norm 在计算方式、归一化范围、归一化位置和归一化效果等方面存在一些差异,适用于不同的神经网络结构和任务。选择哪种归一化方法应根据具体情况进行评估和选择。

Deep Norm 思路

Deep Norm 是一种基于归一化的深度学习模型优化方法,其思路是通过在深度神经网络中引入多层归一化操作,以改善模型的训练和泛化性能。

Deep Norm 的主要思想是在网络的每一层之间插入归一化层,以减小输入数据的分布差异,从而加速收敛并提高模型的泛化能力。与传统的批归一化(Batch Normalization)不同,Deep Norm 在每一层都进行归一化,而不是仅在特定层进行。

Deep Norm 的具体步骤如下:

-

输入数据:将输入数据传递给网络的第一层。

-

归一化层:在网络的每一层之间插入归一化层。归一化层的作用是将每层的输入数据进行归一化,使其均值为0,方差为1。这可以减小数据的分布差异,有助于提高模型的稳定性和泛化性能。

-

激活函数:在归一化层之后应用激活函数,以引入非线性变换。

-

下一层:将经过归一化和激活函数处理的数据传递给网络的下一层。

通过在每一层引入归一化操作,Deep Norm 可以有效地解决深度神经网络中的梯度消失和梯度爆炸问题,并提高模型的收敛速度和泛化性能。此外,Deep Norm 还可以减少对学习率的敏感性,使得模型更容易优化。

需要注意的是,Deep Norm 需要在训练过程中对每一层的均值和方差进行估计,可以使用滑动平均等方法来更新归一化层的参数。在测试阶段,可以使用训练阶段估计的均值和方差进行归一化。

总而言之,Deep Norm 是一种通过在深度神经网络中引入多层归一化操作来优化模型的方法,可以改善模型的训练和泛化性能。

Deep Norm 代码实现

Deep Norm 的代码实现可以基于 PyTorch 框架来完成。以下是一个简单的 Deep Norm 的代码示例:

import torch

import torch.nn as nn

class DeepNorm(nn.Module):

def __init__(self, input_dim, hidden_dims, output_dim):

super(DeepNorm, self).__init__()

self.layers = nn.ModuleList()

self.norm_layers = nn.ModuleList()

# 添加隐藏层和归一化层

for i, hidden_dim in enumerate(hidden_dims):

self.layers.append(nn.Linear(input_dim, hidden_dim))

self.norm_layers.append(nn.LayerNorm(hidden_dim))

input_dim = hidden_dim

# 添加输出层

self.output_layer = nn.Linear(input_dim, output_dim)

def forward(self, x):

for layer, norm_layer in zip(self.layers, self.norm_layers):

x = layer(x)

x = norm_layer(x)

x = torch.relu(x)

x = self.output_layer(x)

return x

# 创建一个 DeepNorm 模型实例

input_dim = 100

hidden_dims = [64, 32]

output_dim = 10

model = DeepNorm(input_dim, hidden_dims, output_dim)

# 使用模型进行训练和预测

input_data = torch.randn(32, input_dim)

output = model(input_data)在这个示例中,我们定义了一个 DeepNorm 类,其中包含了多个隐藏层和归一化层。在 forward 方法中,我们依次对输入数据进行线性变换、归一化和激活函数处理,并通过输出层得到最终的预测结果。

需要注意的是,在实际使用中,可以根据具体任务的需求来调整模型的结构和参数设置。此外,还可以使用其他归一化方法,如 Layer Norm 或 Batch Norm,根据实际情况进行选择和实现。

Deep Norm 有什么优点?

Deep Norm 有以下几个优点:

-

改善梯度传播:Deep Norm 在每一层都引入了归一化操作,可以有效地解决深度神经网络中的梯度消失和梯度爆炸问题。通过减小输入数据的分布差异,Deep Norm 可以使得梯度更加稳定,并加速模型的收敛速度。

-

提高泛化能力:Deep Norm 的归一化操作有助于提高模型的泛化能力。归一化可以减小数据的分布差异,使得模型更容易学习到数据的共性特征,从而提高模型对未见数据的预测能力。

-

减少对学习率的敏感性:Deep Norm 的归一化操作可以减少对学习率的敏感性。通过将输入数据归一化到相同的尺度,Deep Norm 可以使得模型的训练更加稳定,减少了对学习率的调整需求。

-

网络结构更简洁:Deep Norm 可以将归一化操作嵌入到网络的每一层中,而不需要额外的归一化层。这使得网络结构更加简洁,减少了模型参数的数量,降低了计算和存储成本。

-

提高模型的可解释性:Deep Norm 的归一化操作可以使得模型的输出具有更好的可解释性。通过将输入数据归一化到均值为0,方差为1的范围内,Deep Norm 可以使得模型输出的数值更易于理解和解释。

综上所述,Deep Norm 通过引入多层归一化操作,可以改善梯度传播、提高泛化能力、减少对学习率的敏感性,同时还能简化网络结构和提高模型的可解释性。这些优点使得 Deep Norm 成为一种有效的深度学习模型优化方法。

Layer normalization 在 LLMs 中的不同位置有什么区别?

在大语言模型(Large Language Models)中,Layer Norm(层归一化)可以应用在不同位置,包括输入层、输出层和中间隐藏层。这些位置的归一化有一些区别:

-

输入层归一化:在输入层应用 Layer Norm 可以将输入的特征进行归一化,使得输入数据的分布更加稳定。这有助于减少不同样本之间的分布差异,提高模型的泛化能力。

-

输出层归一化:在输出层应用 Layer Norm 可以将输出结果进行归一化,使得输出结果的分布更加稳定。这有助于减小输出结果的方差,提高模型的稳定性和预测准确性。

-

中间隐藏层归一化:在中间隐藏层应用 Layer Norm 可以在每个隐藏层之间进行归一化操作,有助于解决深度神经网络中的梯度消失和梯度爆炸问题。通过减小输入数据的分布差异,Layer Norm 可以使得梯度更加稳定,并加速模型的收敛速度。

总的来说,Layer Norm 在大语言模型中的不同位置应用可以解决不同的问题。输入层归一化可以提高模型的泛化能力,输出层归一化可以提高模型的稳定性和预测准确性,而中间隐藏层归一化可以改善梯度传播,加速模型的收敛速度。具体应用 Layer Norm 的位置需要根据具体任务和模型的需求进行选择。

LLMs 各模型分别用了哪种 Layer normalization?

不同的大语言模型(LLMs)可能会使用不同的层归一化方法,以下是一些常见的层归一化方法在大语言模型中的应用:

-

BERT(Bidirectional Encoder Representations from Transformers):BERT使用的是Transformer中的层归一化方法,即在每个Transformer编码层中应用Layer Normalization。

-

GPT(Generative Pre-trained Transformer):GPT系列模型通常使用的是GPT-Norm,它是一种变种的层归一化方法。GPT-Norm在每个Transformer解码层的每个子层(自注意力、前馈神经网络)之后应用Layer Normalization。

-

XLNet:XLNet使用的是两种不同的层归一化方法,即Token-wise层归一化和Segment-wise层归一化。Token-wise层归一化是在每个Transformer编码层中应用Layer Normalization,而Segment-wise层归一化是在每个Transformer解码层的自注意力机制之后应用Layer Normalization。

-

RoBERTa:RoBERTa是对BERT模型的改进,它也使用的是Transformer中的层归一化方法,即在每个Transformer编码层中应用Layer Normalization。

需要注意的是,虽然这些大语言模型使用了不同的层归一化方法,但它们的目的都是为了提高模型的训练效果和泛化能力。具体选择哪种层归一化方法取决于模型的设计和任务的需求。