HDFS介绍

什么是HDFS?

HDFS(Hadoop Distributed File System)是Apache Hadoop生态系统的一部分,是一个分布式文件系统。它被设计用于存储和处理大规模数据集,并且能够容错、高可靠和高性能地处理文件。

HDFS是为了支持Hadoop的分布式计算和存储而开发的,是Hadoop的核心组件之一。它可以在普通的硬件上运行,并且可以适应大型数据集和并行计算的需求。

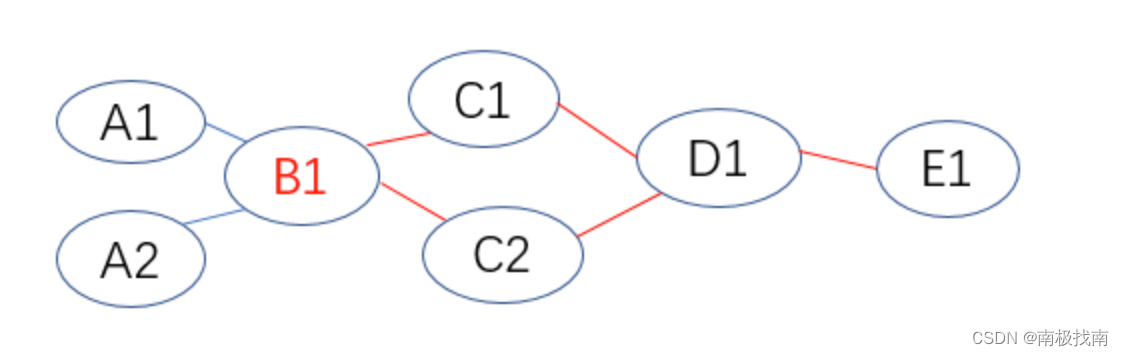

HDFS使用了主从架构,其中一个节点作为主节点(NameNode),负责存储文件的元数据信息,如文件的名称、大小、创建时间等。其他节点称为从节点(DataNode),负责存储实际的文件数据。

HDFS的特点

高容错性

HDFS是一个高容错性的文件系统,它通过数据冗余和自动故障恢复来保证数据的可靠性。HDFS会将文件的数据和校验和存储在多个节点上,一旦某个节点发生故障,系统会自动将数据恢复到其他节点上。

高可扩展性

HDFS可以处理大规模的数据集,它支持水平扩展,可以通过添加更多的节点来增加存储容量和计算能力。这使得HDFS能够适应不断增长的数据量和计算需求。

高吞吐量

HDFS是为了高吞吐量的数据访问而设计的。它支持数据流式访问,能够并行读取和写入大文件。这使得HDFS在大数据处理和分析场景下具有较好的性能表现。

适用于批处理

HDFS适用于批处理作业,可以高效地处理大规模数据集上的批量计算任务。它提供了高可靠的数据存储和访问接口,可以与Hadoop的其他组件无缝集成,如MapReduce等。

HDFS的应用场景

HDFS广泛应用于大数据领域,特别是与Hadoop生态系统相结合的场景,包括:

- 大数据存储和处理:HDFS提供了高可靠性和高性能的数据存储和访问能力,适用于大规模数据集的存储和处理。

- 数据仓库:HDFS可以作为数据仓库,用于存储结构化和非结构化数据,支持离线数据分析和处理。

- 分布式日志收集:HDFS可以用来存储分布式系统的日志数据,为日志分析和故障排查提供支持。

- 大规模文件传输:HDFS可以通过网络高效地传输大文件,适用于大规模数据集的离线传输需求。

总结

HDFS作为Hadoop生态系统的核心组件之一,提供了高容错性、高可扩展性、高吞吐量的分布式文件系统。它适用于大数据存储和处理、数据仓库、分布式日志收集等多种场景。通过使用HDFS,我们可以更好地管理和处理大规模数据集,实现大数据的存储、计算和分析。