继谷歌推出Tryon Diffusion虚拟试穿后,国内的头部电商阿里也推出的Outfit Anyone虚拟试穿技术。该技术采用双流条件扩散模型,处理模特和服装数据,通过衣物图像实现逼真的虚拟试穿效果,结合Animate Anyone技术,轻松制作任意角色的换装视频。只需要一张人物照片和服装照片,就可以为不同的姿势和身体形状创建高质量的虚拟试穿。国内的电商革命也终于要到来了!

体验网址:https://huggingface.co/spaces/HumanAIGC/OutfitAnyone

论文名称:Outfit Anyone: Ultra-high quality virtual try-on for Any Clothing and Any Person

论文链接:https://humanaigc.github.io/outfit-anyone/

项目链接:https://github.com/HumanAIGC/OutfitAnyone (未开源)

目录

摘要

方法

试穿结果

个人衣服

不规则服装

各种体型

动漫服装

精细化处理

换装+动画

总结分析

摘要

虚拟试穿已经成为一项变革性的技术,让用户无需亲自试穿就能体验时尚。然而,现有的方法往往难以产生高保真度和细节一致的结果。扩散模型已经证明了它们能够生成高质量和逼真的图像,但是当涉及到虚拟试穿等条件生成场景时,它们仍然面临着实现控制和一致性的挑战。Outfit Anyone利用两流条件扩散模型解决了这些限制,使其能够熟练地处理服装变形,以获得更逼真的结果。它的特点是可扩展性——姿势和体型等可调节因素——以及广泛的适用性,从动画延伸到野外图像。Outfit Anyone在各种场景中的表现突出了它的实用性和对实际部署的准备。

方法

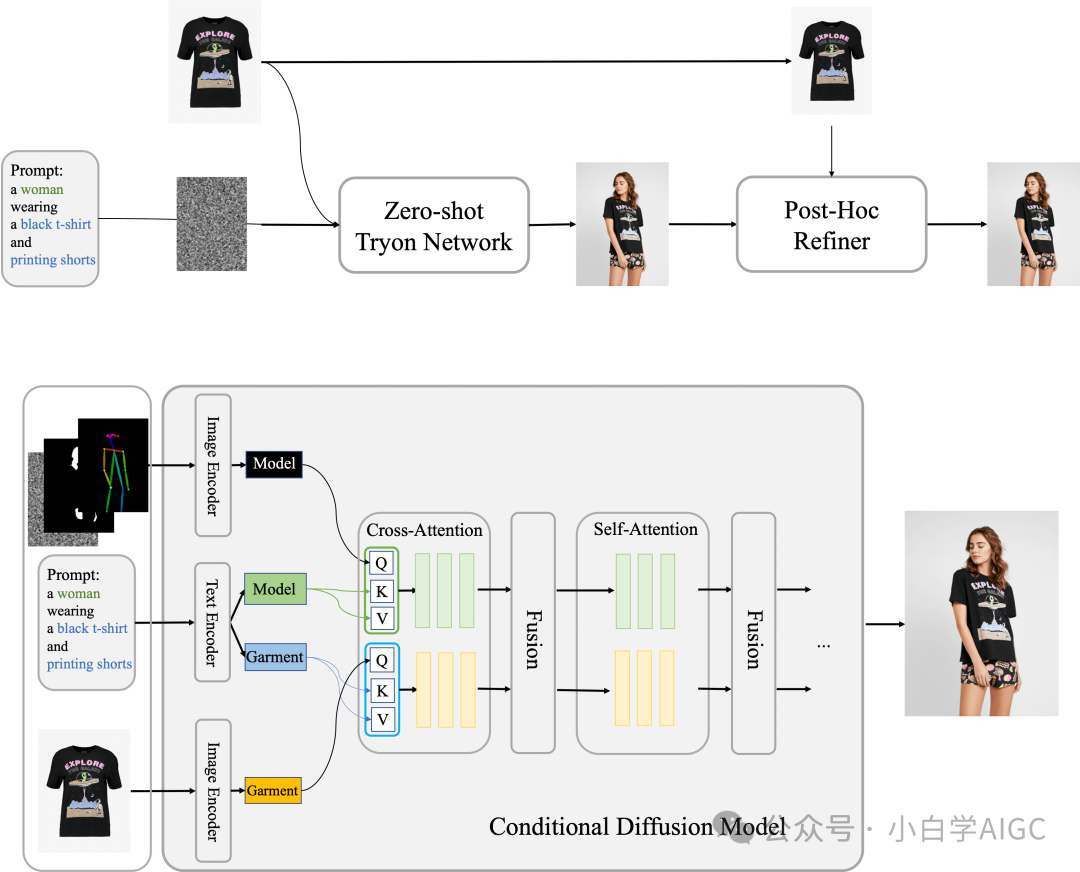

Outfit Anyone方法的核心是条件扩散模型,该模型使用服装图像作为控制因素,处理模特、服装和随附的文本提示的图像。在内部,网络分为两个流,分别对模型和服装数据进行独立处理。这些流汇聚在一个融合网络中,便于将服装细节嵌入到模型的特征表示中。在此基础上,Outfit Anyone建立了装备任何人,包括两个关键元素:用于初始试戴图像的零镜头试戴网络,以及用于详细增强输出图像中的服装和皮肤纹理的Post-hoc Refiner。

试穿结果

Outfit Anyone在现实世界中展示了多功能服装变化能力,包括在现实场景中完整套装和单件。

个人衣服

不规则服装

在这里展示各种古怪和独特的服装风格的能力,把它们穿在模特身上,在必要时创建相应的服装组合。

各种体型

Outfit Anyone同样可以适应各种体型,包括那些健康的、曲线的和娇小的,从而满足各行各业的人的试穿需求。

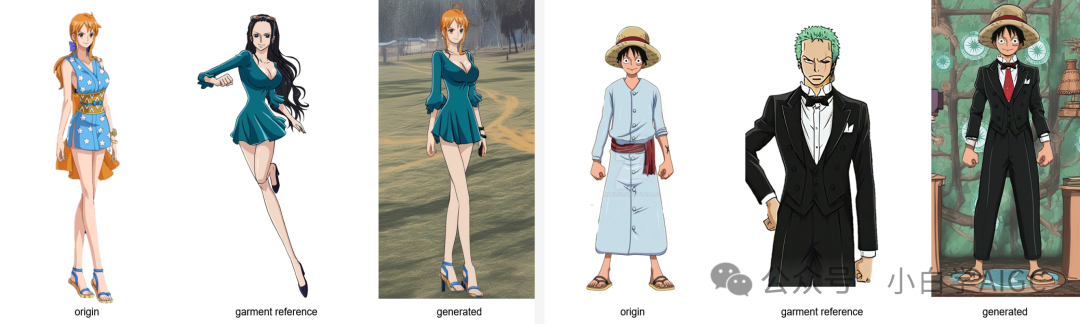

动漫服装

Outfit Anyone模型具有强大的泛化能力,可以支持新的动画角色的创建

精细化处理

通过配备精炼器(Refiner),Outfit Anyone 能够在保持服装风格一致性的同时,显著提升服装的纹理和真实感,使得最终效果更加逼真和吸引人。

换装+动画

Outfit Anyone 与 Animate Anyone(阿里最新推出的姿态转视频模型)的结合。这不仅仅意味着能够实现角色的服装变更,更是能够创造动作视频,将静态的虚拟试穿转变为动态的视觉体验。这种集成的技术展现了 AI 在时尚和娱乐领域的巨大潜力。

总结分析

1.Outfit Anyone主要特点

-

逼真效果:创造出非常真实的图片;

-

适用范围广:适配各种衣服和人物,适用于不同体型和风格;

-

个性化时尚展示:可以展示多种独特和时尚的服装搭配;

-

细节增强:增强服装的质感和真实感,同时保持一致性;

-

适应不同体型:能够根据用户的体型提供适合的试衣效果;

-

支持动画角色:泛化能力强,支持为动画角色创造新的服装形象;

-

整合Animate Anyone与Animate Anybody,实现服装变比和动态视频。

2.使用场景示例:

-

电商平台:用户可以在线试穿各种服装款式,提高购物体验。

-

虚拟试衣场景:用户可以通过手机应用程序尝试不同的衣物组合。

-

动漫角色设计:设计师可以使用 Outfit Anyone 为动漫角色设计各种服装样式。

3.产品特色:

-

基于条件扩散模型实现虚拟试穿。

-

处理衣物变形,生成逼真效果。

-

可扩展性,适用于各种身体形状和动漫角色。

欢迎大家关注我的微信公众号:小白学AIGC,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、Stable Diffusion等相关技术。这里不仅有简单易懂的AIGC理论实践和AI学习路线,还有大厂工作经历和体会分享。期待你的来临~