YOLOv8是一种物体检测算法,是YOLO系列算法的最新版本。

YOLO(You Only Look Once)是一种实时物体检测算法,其优势在于快速且准确的检测结果。YOLOv8在之前的版本基础上进行了一系列改进和优化,提高了检测速度和准确性。

YOLOv8采用了Darknet-53作为其基础网络架构。Darknet-53是一个53层的卷积神经网络,用于提取图像特征。与传统的卷积神经网络相比,Darknet-53具有更深的网络结构和更多的卷积层,可以更好地捕捉图像中的细节和语义信息。

在YOLOv8中,还使用了一些技术来提高检测性能。首先是使用了多尺度检测。YOLOv8在不同的尺度上检测物体,这样可以更好地处理物体的大小变化和远近距离差异。其次是利用了FPN(Feature Pyramid Network)结构来提取多尺度特征。FPN可以将不同层级的特征图进行融合,使得算法对不同大小的物体都有较好的适应性。

此外,YOLOv8还利用了一种称为CSPDarknet的网络结构来减少计算量。CSPDarknet使用了CSP(Cross Stage Partial)结构,在网络的前向和后向传播过程中进行特征融合,从而减少了网络的参数量和计算量。

在训练阶段,YOLOv8使用了一种称为CutMix的数据增强技术。CutMix将不同图像的一部分进行混合,从而增加了数据的多样性和鲁棒性。

总而言之,YOLOv8是一种快速而准确的物体检测算法,它通过引入Darknet-53网络、多尺度检测、FPN结构、CSPDarknet结构和CutMix数据增强等技术,实现了对不同大小和距离的物体进行快速、准确的检测。

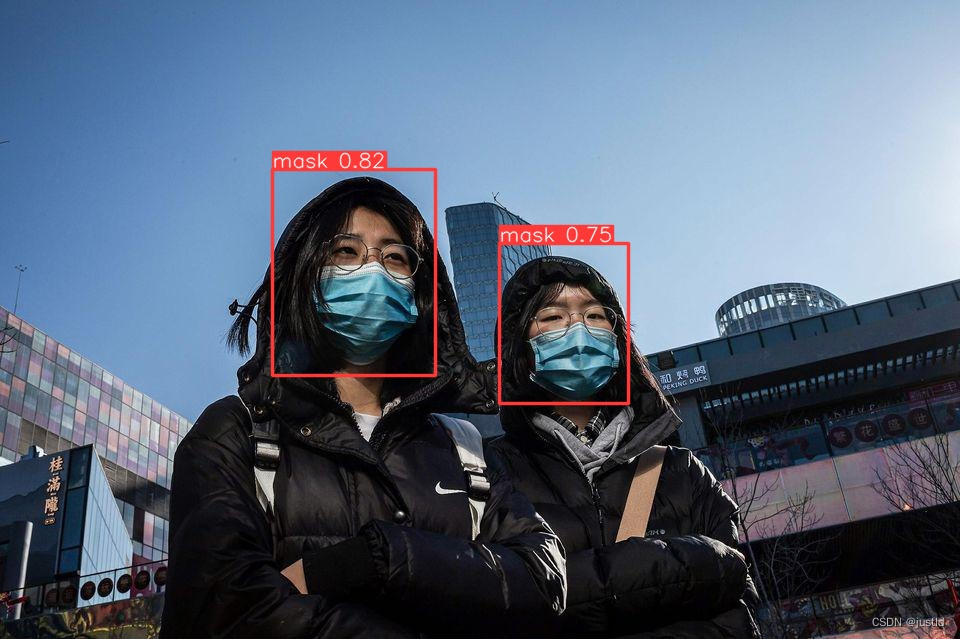

本文介绍了基于深度学习yolov8的口罩检测系统,包括训练过程和数据准备过程,同时提供了推理的代码和GUI。对准备计算机视觉相关的毕业设计的同学有着一定的帮助。

检测结果如下图:

一、安装YoloV8

yolov8官方文档:主页 - Ultralytics YOLOv8 文档

安装部分参考:官方安装教程

二、数据集准备

本文使用的数据集来自口罩佩戴数据集,该数据集是戴各种口罩的人和不戴口罩的人的物体检测数据集。这些图像最初由台湾伊甸社会福利基金会的 Cheng Hsun Teng 收集,并由 Roboflow 团队重新标记。数据集图片如下:

该数据集包含105个训练数据,29个验证数据,15个测试数据,共包含2个类别:佩戴口罩和不佩戴口罩,原有的数据集是VOC格式,命名比较混乱,本文提供整理后的口罩数据集,包含VOC/COCO/yolov8格式。

三、模型训练

1、数据集配置文件

在ultralytics/ultralytics/cfg/datasets目录下添加mask.yaml,添加以下内容(path修改为自己的路径):

# Ultralytics YOLO 🚀, AGPL-3.0 license

# COCO 2017 dataset http://cocodataset.org by Microsoft

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: datasets/mask_det/mask-yolov8 # 替换为自己的路径

train: images/train

val: images/val

test: images/test

# Classes

names:

# 0: normal

0: mask

1: no_mask2、修改模型配置文件

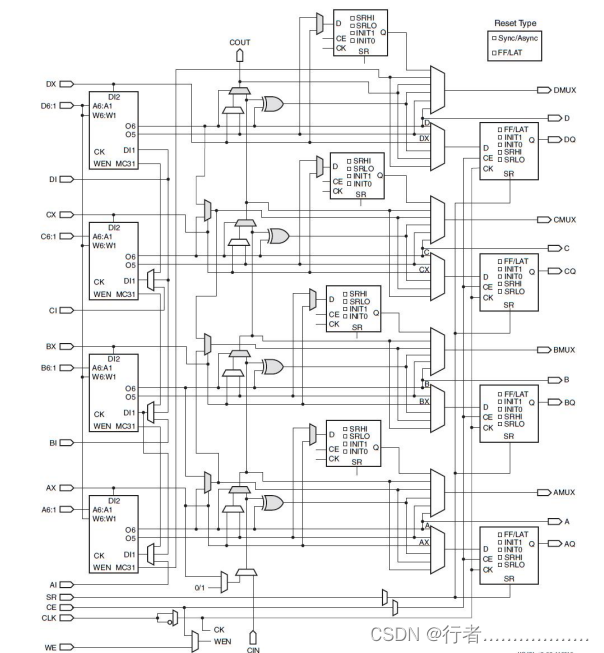

新建ultralytics/cfg/models/mask/yolov8_mask.yaml ,添加以下内容:,添加以下内容:

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLOv8 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 2 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolov8n.yaml' will call yolov8.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.33, 0.25, 1024] # YOLOv8n summary: 225 layers, 3157200 parameters, 3157184 gradients, 8.9 GFLOPs

s: [0.33, 0.50, 1024] # YOLOv8s summary: 225 layers, 11166560 parameters, 11166544 gradients, 28.8 GFLOPs

m: [0.67, 0.75, 768] # YOLOv8m summary: 295 layers, 25902640 parameters, 25902624 gradients, 79.3 GFLOPs

l: [1.00, 1.00, 512] # YOLOv8l summary: 365 layers, 43691520 parameters, 43691504 gradients, 165.7 GFLOPs

x: [1.00, 1.25, 512] # YOLOv8x summary: 365 layers, 68229648 parameters, 68229632 gradients, 258.5 GFLOPs

# YOLOv8.0n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 3, C2f, [128, True]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 6, C2f, [256, True]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 6, C2f, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 3, C2f, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

# YOLOv8.0n head

head:

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 3, C2f, [512]] # 12

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 3, C2f, [256]] # 15 (P3/8-small)

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 12], 1, Concat, [1]] # cat head P4

- [-1, 3, C2f, [512]] # 18 (P4/16-medium)

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 9], 1, Concat, [1]] # cat head P5

- [-1, 3, C2f, [1024]] # 21 (P5/32-large)

- [[15, 18, 21], 1, Detect, [nc]] # Detect(P3, P4, P5)

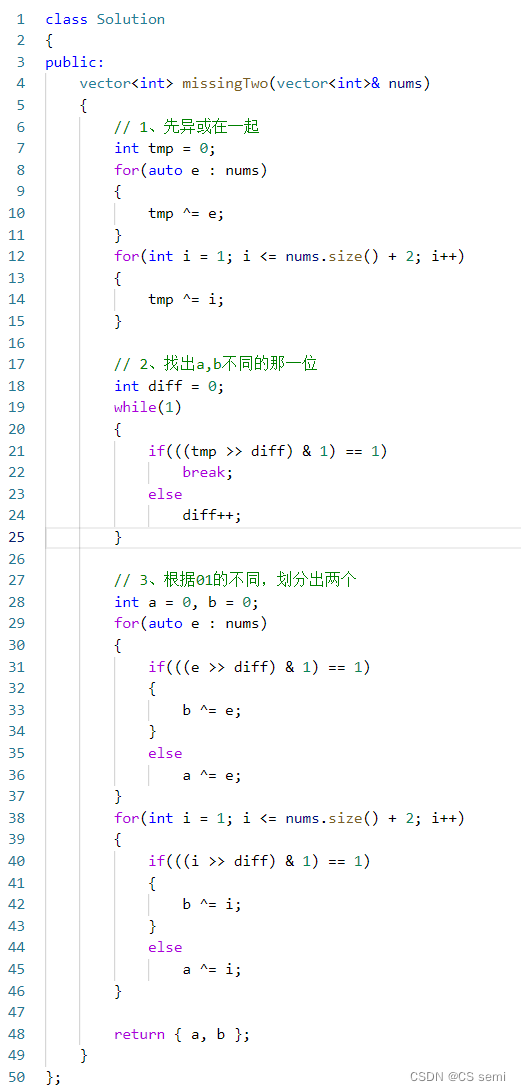

3、训练模型

使用如下命令训练模型,相关路径更改为自己的路径,建议绝对路径:

yolo detect train project=deploy name=yolov8_mask exist_ok=True optimizer=auto val=True amp=True epochs=100 imgsz=640 model=ultralytics/ultralytics/cfg/models/mask/yolov8_mask.yaml data=ultralytics/ultralytics/cfg/datasets/mask.yaml

4、验证模型

使用如下命令验证模型,相关路径根据需要修改:

yolo detect val imgsz=640 model=deploy/yolov8_mask/weights/best.pt data=ultralytics/ultralytics/cfg/datasets/mask.yaml

其精度如下:

Ultralytics YOLOv8.1.0 🚀 Python-3.9.18 torch-2.1.0+cu118 CUDA:0 (NVIDIA GeForce RTX 4090, 24210MiB)

YOLOv8_mask summary (fused): 168 layers, 3006038 parameters, 0 gradients, 8.1 GFLOPs

val: Scanning /home/yq/aitools/datasets/mask_det/mask-yolov8/labels/val.cache... 29 images, 0 backgrounds, 0 corrupt: 100%|█████████

Class Images Instances Box(P R mAP50 mAP50-95): 100%|██████████| 2/2 [00:01<00:00, 1.48it

all 29 162 0.715 0.592 0.62 0.334

mask 29 142 0.807 0.69 0.775 0.427

no_mask 29 20 0.622 0.495 0.465 0.241

Speed: 0.7ms preprocess, 29.6ms inference, 0.0ms loss, 0.5ms postprocess per image

Results saved to /home/yq/ultralytics/runs/detect/val16

💡 Learn more at https://docs.ultralytics.com/modes/val四、推理

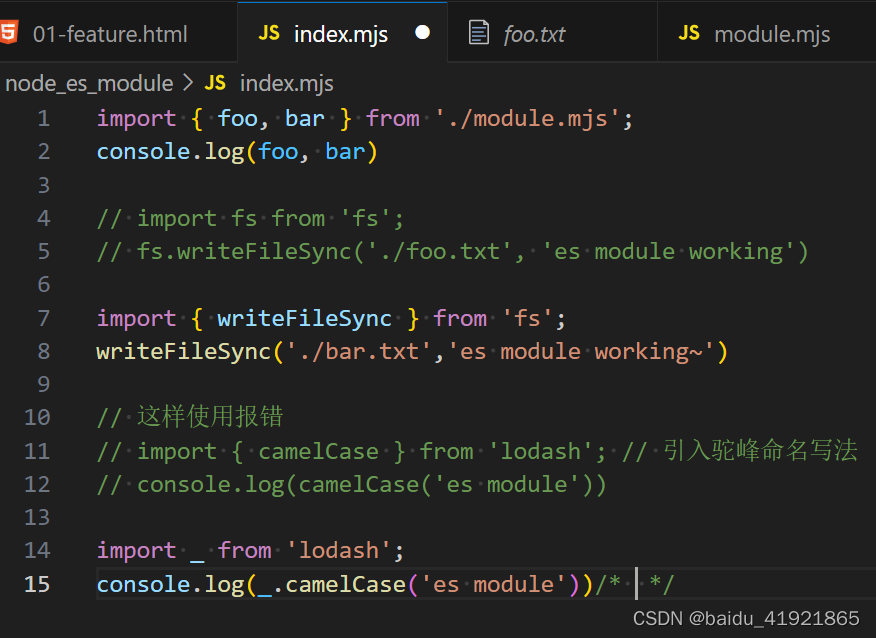

训练好了模型,可以使用如下代码实现推理,将权重放到同级目录:

from PIL import Image

from ultralytics import YOLO

# 加载预训练的YOLOv8n模型

model = YOLO('best.pt')

image_path = 'test.jpg'

results = model(image_path) # 结果列表

# 展示结果

for r in results:

im_array = r.plot() # 绘制包含预测结果的BGR numpy数组

im = Image.fromarray(im_array[..., ::-1]) # RGB PIL图像

im.show() # 显示图像

im.save('results.jpg') # 保存图像五、界面开发

使用pyqt5开发gui界面,支持图片、视频、摄像头输入,支持导出到指定路径,其GUI如下图:

六、代码下载

1、本文数据集下载

2、口罩识别系统源码-含GUI