【参考:tutorial/langchain at main · InternLM/tutorial】

【参考:(3)基于 InternLM 和 LangChain 搭建你的知识库_哔哩哔哩_bilibili-【OpenMMLab】】

笔记

基础作业

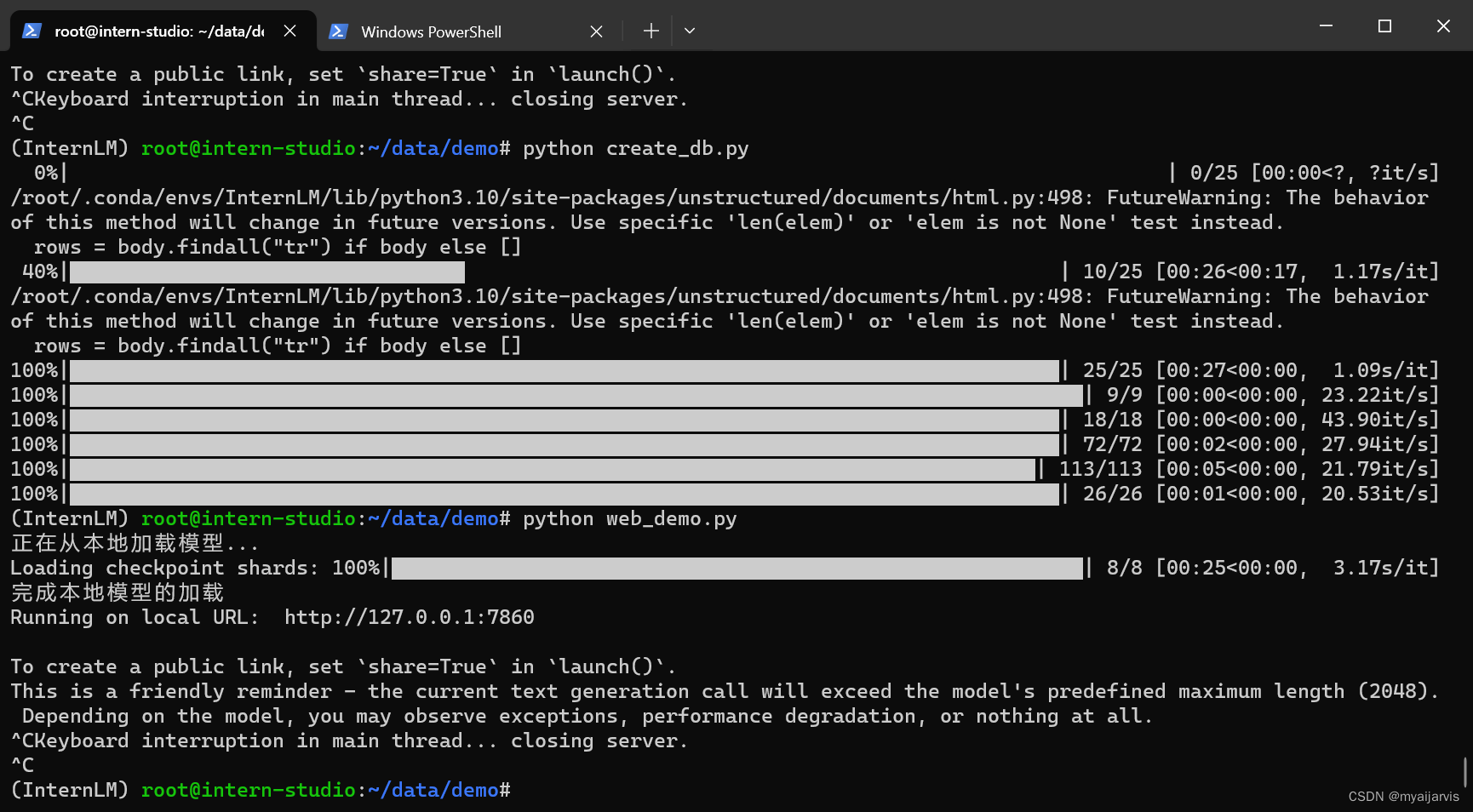

这里需要等好几分钟才行

bug:

碰到pandas相关报错就卸载重装

输出文字乱码:重新生成向量文件 python create_db.py

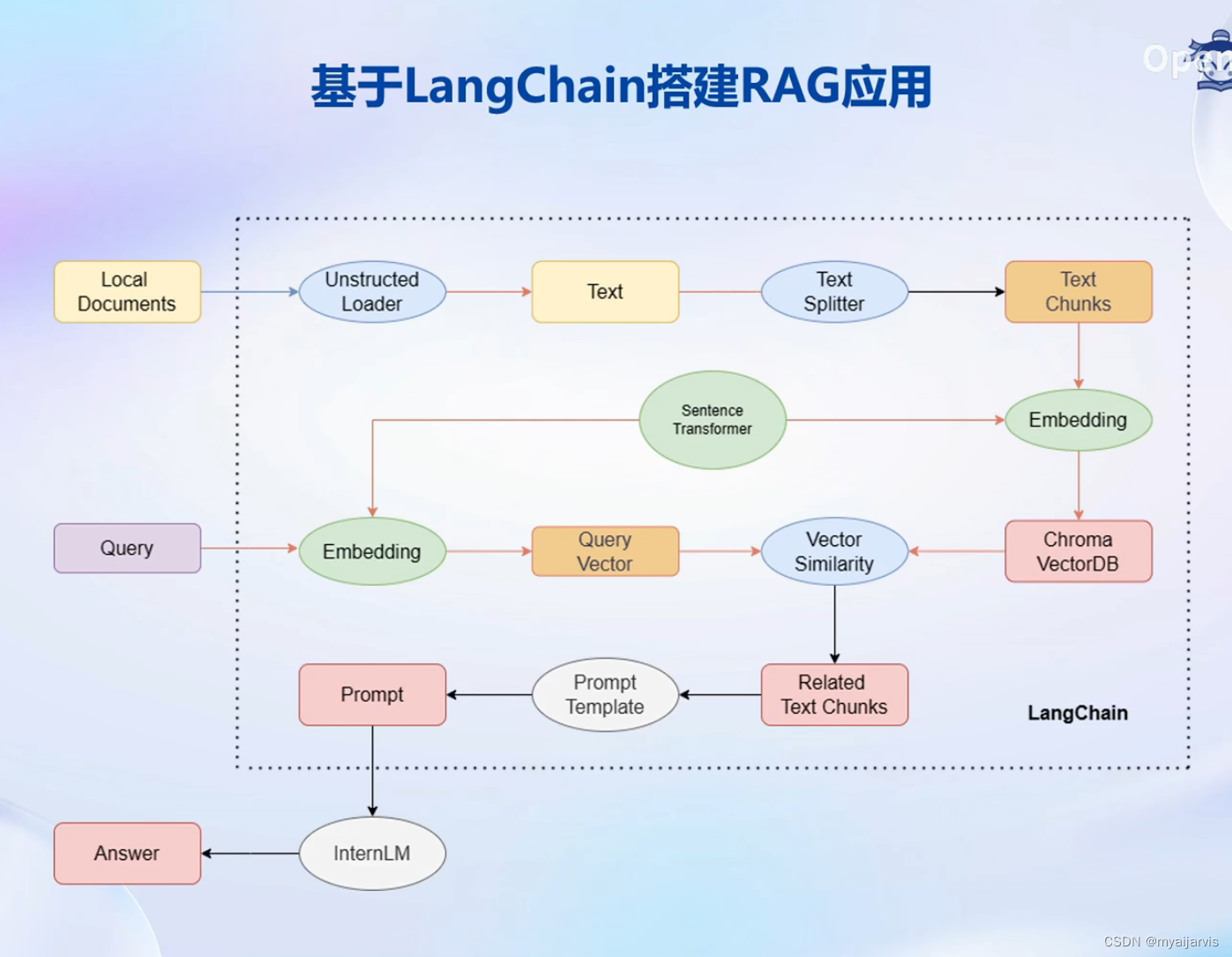

- create_db.py

# 首先导入所需第三方库

from langchain.document_loaders import UnstructuredFileLoader

from langchain.document_loaders import UnstructuredMarkdownLoader

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.vectorstores import Chroma

from langchain.embeddings.huggingface import HuggingFaceEmbeddings

from tqdm import tqdm

import os

# 获取文件路径函数

def get_files(dir_path):

# args:dir_path,目标文件夹路径

file_list = []

for filepath, dirnames, filenames in os.walk(dir_path):

# os.walk 函数将递归遍历指定文件夹

for filename in filenames:

# 通过后缀名判断文件类型是否满足要求

if filename.endswith(".md"):

# 如果满足要求,将其绝对路径加入到结果列表

file_list.append(os.path.join(filepath, filename))

elif filename.endswith(".txt"):

file_list.append(os.path.join(filepath, filename))

return file_list

# 加载文件函数

def get_text(dir_path):

# args:dir_path,目标文件夹路径

# 首先调用上文定义的函数得到目标文件路径列表

file_lst = get_files(dir_path)

# docs 存放加载之后的纯文本对象

docs = []

# 遍历所有目标文件

for one_file in tqdm(file_lst):

file_type = one_file.split('.')[-1]

if file_type == 'md':

loader = UnstructuredMarkdownLoader(one_file)

elif file_type == 'txt':

loader = UnstructuredFileLoader(one_file)

else:

# 如果是不符合条件的文件,直接跳过

continue

docs.extend(loader.load())

return docs

# 目标文件夹

tar_dir = [

"/root/data/InternLM",

"/root/data/InternLM-XComposer",

"/root/data/lagent",

"/root/data/lmdeploy",

"/root/data/opencompass",

"/root/data/xtuner"

]

# 加载目标文件

docs = []

for dir_path in tar_dir:

docs.extend(get_text(dir_path))

# 对文本进行分块

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=500, chunk_overlap=150)

split_docs = text_splitter.split_documents(docs)

# 加载开源词向量模型

embeddings = HuggingFaceEmbeddings(model_name="/root/data/model/sentence-transformer")

# 构建向量数据库

# 定义持久化路径

persist_directory = 'data_base/vector_db/chroma'

# 加载数据库

vectordb = Chroma.from_documents(

documents=split_docs,

embedding=embeddings,

persist_directory=persist_directory # 允许我们将persist_directory目录保存到磁盘上

)

# 将加载的向量数据库持久化到磁盘上

vectordb.persist()

- LLM.py

from langchain.llms.base import LLM

from typing import Any, List, Optional

from langchain.callbacks.manager import CallbackManagerForLLMRun

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

class InternLM_LLM(LLM):

# 基于本地 InternLM 自定义 LLM 类

tokenizer : AutoTokenizer = None

model: AutoModelForCausalLM = None

def __init__(self, model_path :str):

# model_path: InternLM 模型路径

# 从本地初始化模型

super().__init__()

print("正在从本地加载模型...")

self.tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True)

self.model = AutoModelForCausalLM.from_pretrained(model_path, trust_remote_code=True).to(torch.bfloat16).cuda()

self.model = self.model.eval()

print("完成本地模型的加载")

def _call(self, prompt : str, stop: Optional[List[str]] = None,

run_manager: Optional[CallbackManagerForLLMRun] = None,

**kwargs: Any):

# 重写调用函数 (这里可以随意改动)

system_prompt = """You are an AI assistant whose name is InternLM (书生·浦语).

- InternLM (书生·浦语) is a conversational language model that is developed by Shanghai AI Laboratory (上海人工智能实验室). It is designed to be helpful, honest, and harmless.

- InternLM (书生·浦语) can understand and communicate fluently in the language chosen by the user such as English and 中文.

"""

messages = [(system_prompt, '')]

response, history = self.model.chat(self.tokenizer, prompt , history=messages)

return response

@property

def _llm_type(self) -> str:

return "InternLM"

- web_demo.py

from langchain.vectorstores import Chroma

from langchain.embeddings.huggingface import HuggingFaceEmbeddings

import os

from LLM import InternLM_LLM

from langchain.prompts import PromptTemplate

from langchain.chains import RetrievalQA

def load_chain():

# 加载问答链

# 定义 Embeddings

embeddings = HuggingFaceEmbeddings(model_name="/root/data/model/sentence-transformer")

# 向量数据库持久化路径

persist_directory = 'data_base/vector_db/chroma'

# 加载数据库

vectordb = Chroma(

persist_directory=persist_directory, # 允许我们将persist_directory目录保存到磁盘上

embedding_function=embeddings

)

# 加载自定义 LLM

llm = InternLM_LLM(model_path = "/root/data/model/Shanghai_AI_Laboratory/internlm-chat-7b")

# 定义一个 Prompt Template

template = """使用以下上下文来回答最后的问题。如果你不知道答案,就说你不知道,不要试图编造答

案。尽量使答案简明扼要。总是在回答的最后说“谢谢你的提问!”。

{context}

问题: {question}

有用的回答:"""

QA_CHAIN_PROMPT = PromptTemplate(input_variables=["context","question"],template=template)

# 运行 chain

qa_chain = RetrievalQA.from_chain_type(llm,retriever=vectordb.as_retriever(),return_source_documents=True,chain_type_kwargs={"prompt":QA_CHAIN_PROMPT})

return qa_chain

class Model_center():

"""

存储检索问答链的对象

"""

def __init__(self):

# 构造函数,加载检索问答链

self.chain = load_chain()

def qa_chain_self_answer(self, question: str, chat_history: list = []):

"""

调用问答链进行回答

"""

if question == None or len(question) < 1:

return "", chat_history

try:

chat_history.append(

(question, self.chain({"query": question})["result"]))

# 将问答结果直接附加到问答历史中,Gradio 会将其展示出来

return "", chat_history

except Exception as e:

return e, chat_history

import gradio as gr

# 实例化核心功能对象

model_center = Model_center()

# 创建一个 Web 界面

block = gr.Blocks()

with block as demo:

with gr.Row(equal_height=True):

with gr.Column(scale=15):

# 展示的页面标题

gr.Markdown("""<h1><center>InternLM</center></h1>

<center>书生浦语</center>

""")

with gr.Row():

with gr.Column(scale=4):

# 创建一个聊天机器人对象

chatbot = gr.Chatbot(height=450, show_copy_button=True)

# 创建一个文本框组件,用于输入 prompt。

msg = gr.Textbox(label="Prompt/问题")

with gr.Row():

# 创建提交按钮。

db_wo_his_btn = gr.Button("Chat")

with gr.Row():

# 创建一个清除按钮,用于清除聊天机器人组件的内容。

clear = gr.ClearButton(

components=[chatbot], value="Clear console")

# 设置按钮的点击事件。当点击时,调用上面定义的 qa_chain_self_answer 函数,并传入用户的消息和聊天历史记录,然后更新文本框和聊天机器人组件。

db_wo_his_btn.click(model_center.qa_chain_self_answer, inputs=[

msg, chatbot], outputs=[msg, chatbot])

gr.Markdown("""提醒:<br>

1. 初始化数据库时间可能较长,请耐心等待。

2. 使用中如果出现异常,将会在文本输入框进行展示,请不要惊慌。 <br>

""")

gr.close_all()

# 直接启动

demo.launch()

进阶作业

选择一个垂直领域,收集该领域的专业资料构建专业知识库,并搭建专业问答助手,并在 OpenXLab 上成功部署(截图,并提供应用地址)

目前待定

![【算法每日一练]-练习篇 #Tile Pattern #Swapping Puzzle # socks](https://img-blog.csdnimg.cn/direct/fd6ca83830f24d55b2b881ec10190920.png)

![[Kubernetes]8. K8s使用Helm部署mysql集群(主从数据库集群)](https://img-blog.csdnimg.cn/direct/4857ce5444ba4a3e8b19d2d9d83187ed.png)