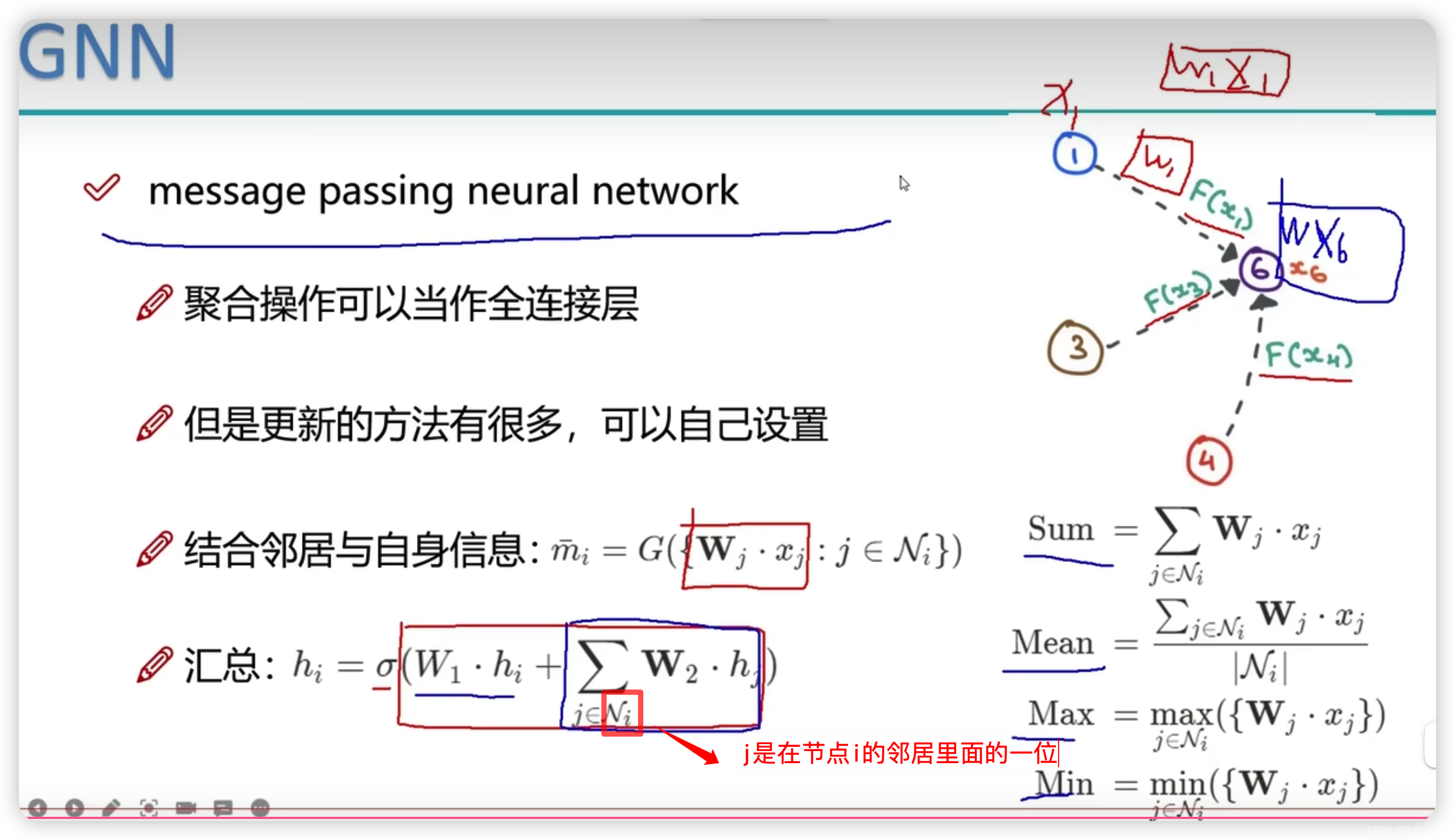

5.消息传递的计算方法

边的存放方式

注意,在实际的边的实现方式中,并不是以邻接矩阵来进行实现的,这是因为在图的更新中,用邻接矩阵进行更新所占用的时间开销相对大,二是因为领接矩阵占用的空间大(N方)。

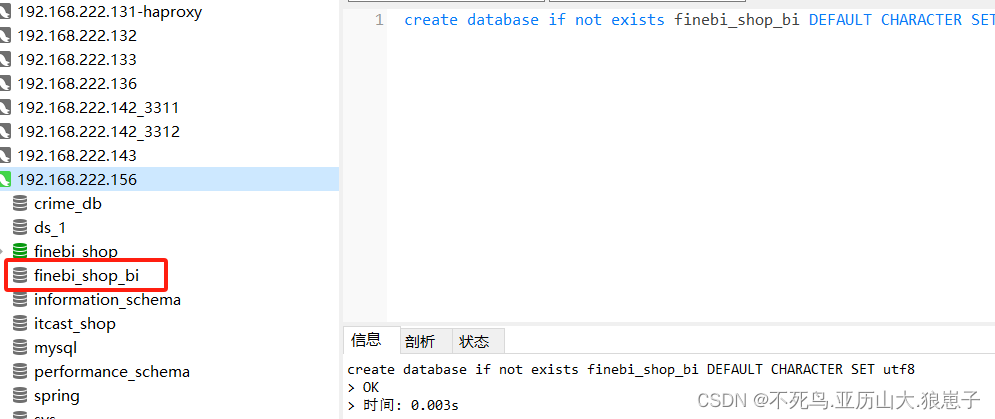

所以在实际实现中会采用2XN的存储结构,从而避免多余的存储开销。

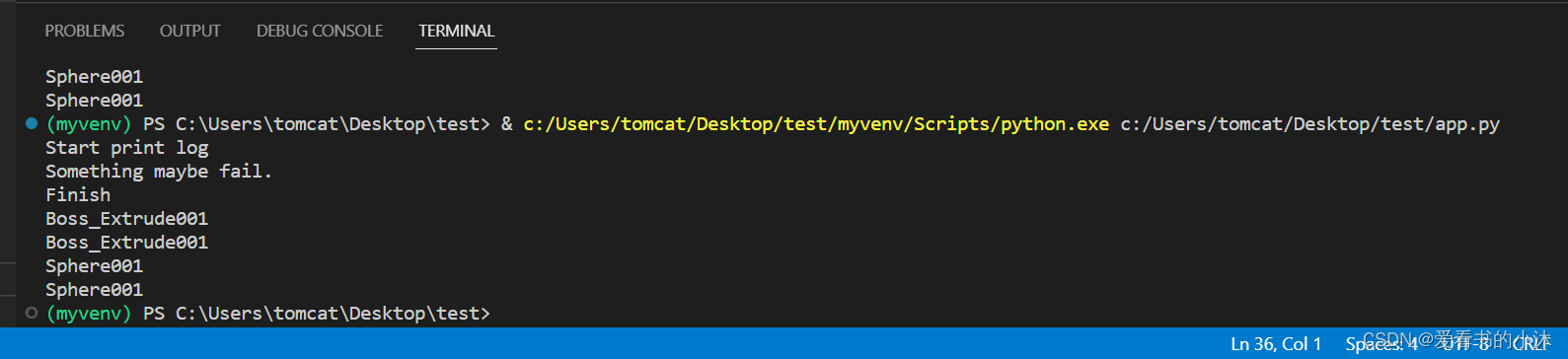

节点更新

在图神经网络中,某个节点的更新,不应该只关心自身的变化,还应该关心相邻节点与本节点的关系。

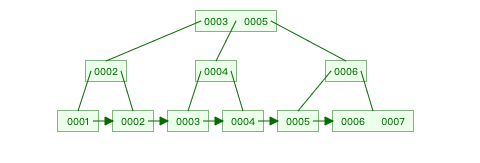

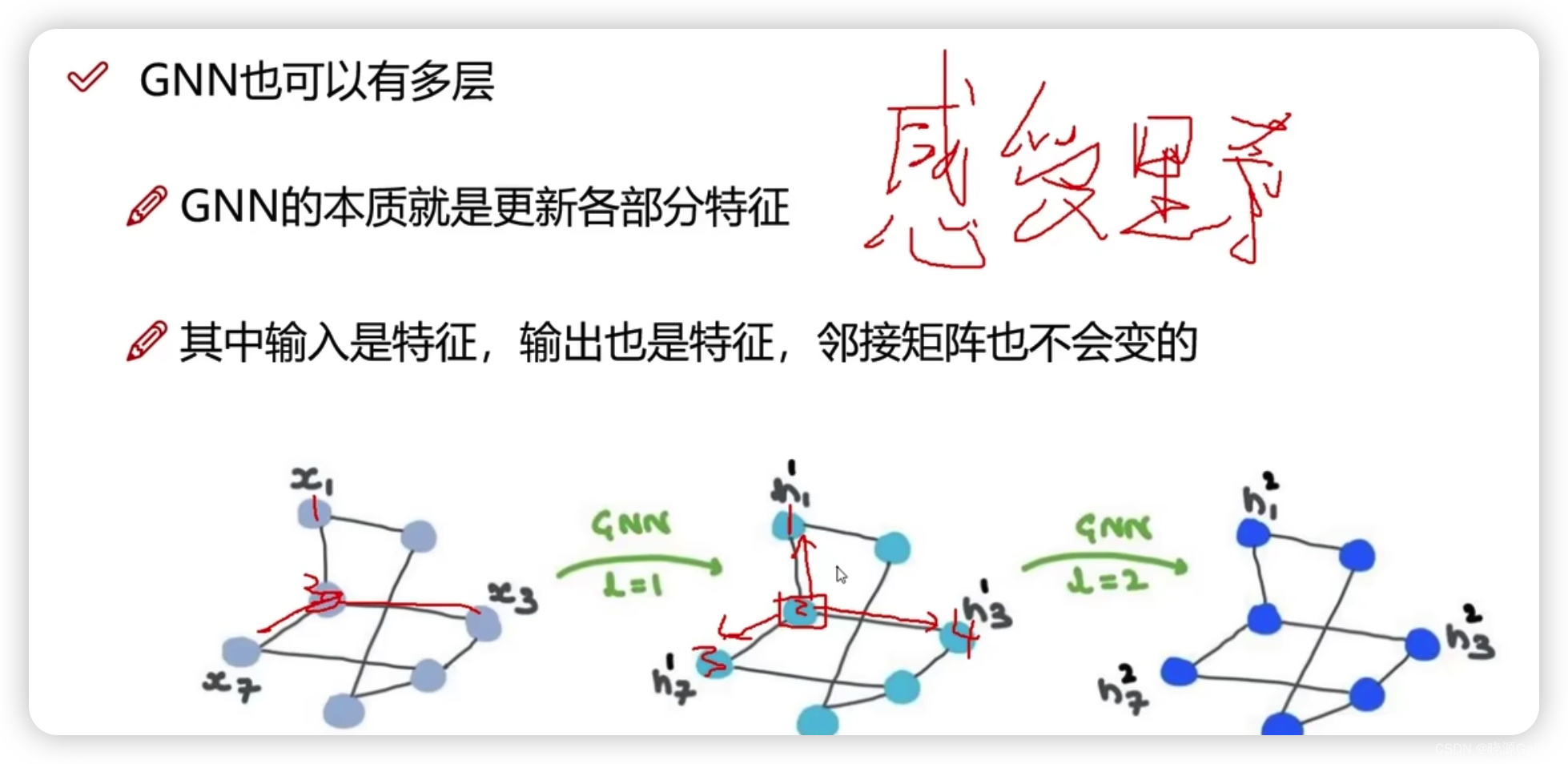

6.多层GNN的作用

首先,多层GNN并不会破坏图的结构(拓扑关系/邻接结构)。

而多层GNN能使得本点上的特征信息,不断进行迭代(就好像计算机网络中rip,不断交换路由信息,来得到更远处的路由信息,从而最后收敛)

GCN是Graph Convolutional Network图卷积神经网络的缩写。