🤍 前端开发工程师(主业)、技术博主(副业)、已过CET6

🍨 阿珊和她的猫_CSDN个人主页

🕠 牛客高级专题作者、在牛客打造高质量专栏《前端面试必备》

🍚 蓝桥云课签约作者、已在蓝桥云课上架的前后端实战课程《Vue.js 和 Egg.js 开发企业级健康管理项目》、《带你从入门到实战全面掌握 uni-app》

文章目录

- 1. 引言

- 介绍负载均衡的概念和重要性

- 2. 负载均衡的原理

- 描述负载均衡的工作原理

- 包括负载均衡算法的分类和示例

- 解释负载均衡如何提高系统的性能和可靠性

- 3. 常见的负载均衡策略

- 1. 轮询(Round Robin)

- 2. 加权轮询(Weighted Round Robin)

- 3. 随机(Random)

- 4. 最小连接数(Least Connections)

- 5. 哈希(Hash)

1. 引言

介绍负载均衡的概念和重要性

负载均衡的概念:

负载均衡是一种将工作负载分布到多个计算资源上的技术,以提高系统的性能、可靠性和可用性。它涉及将传入的请求分配给多个服务器或节点,以确保每个服务器或节点都能承担一部分工作负载,从而避免单个服务器或节点过度负载而导致性能下降或故障。

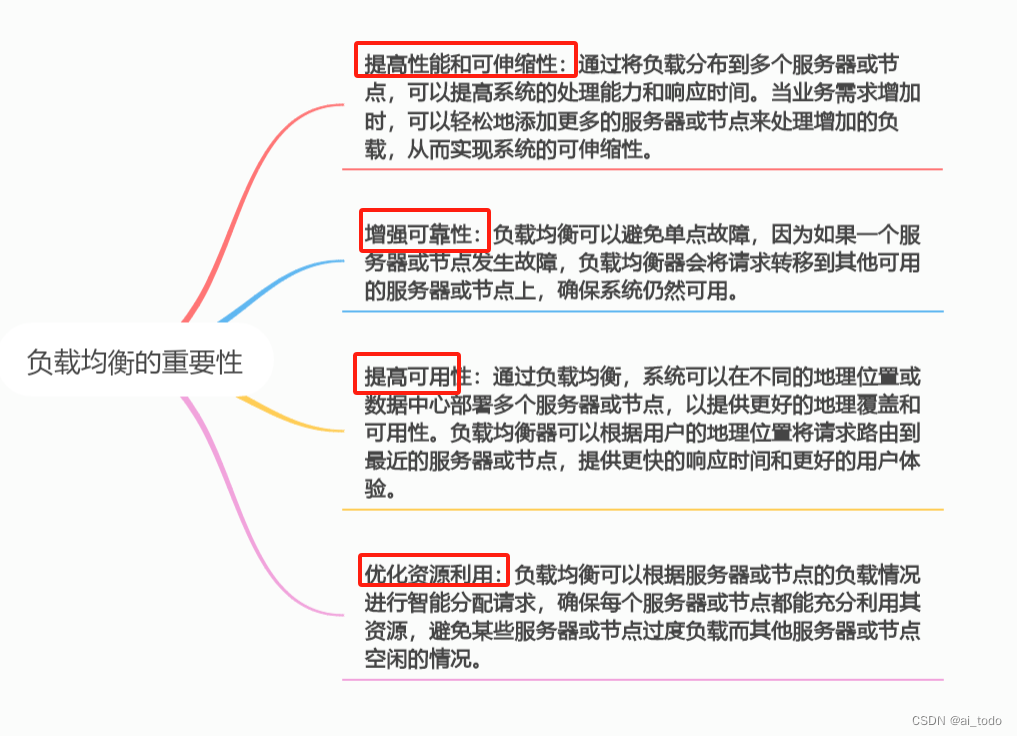

负载均衡的重要性:

-

提高性能和可伸缩性:通过将负载分布到多个服务器或节点,可以提高系统的处理能力和响应时间。当业务需求增加时,可以轻松地添加更多的服务器或节点来处理增加的负载,从而实现系统的可伸缩性。

-

增强可靠性:负载均衡可以避免单点故障,因为如果一个服务器或节点发生故障,负载均衡器会将请求转移到其他可用的服务器或节点上,确保系统仍然可用。 -

提高可用性:通过负载均衡,系统可以在不同的地理位置或数据中心部署多个服务器或节点,以提供更好的地理覆盖和可用性。负载均衡器可以根据用户的地理位置将请求路由到最近的服务器或节点,提供更快的响应时间和更好的用户体验。

-

优化资源利用:负载均衡可以根据服务器或节点的负载情况进行智能分配请求,确保每个服务器或节点都能充分利用其资源,避免某些服务器或节点过度负载而其他服务器或节点空闲的情况。

总之,负载均衡是现代分布式系统和云计算架构中不可或缺的一部分,它可以提高系统的性能、可靠性、可用性和可伸缩性,确保系统能够有效地处理大量的请求,并为用户提供更好的体验。

2. 负载均衡的原理

描述负载均衡的工作原理

负载均衡是一种将流量分发到多个服务器或虚拟机,以提高系统可用性和容错能力的技术。

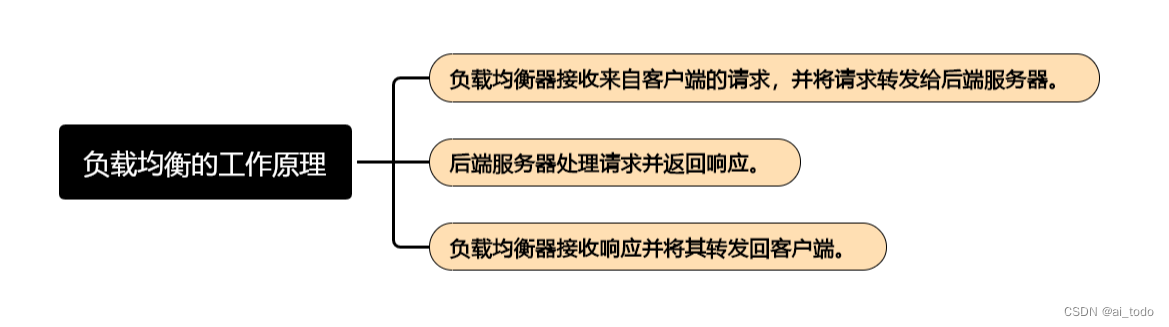

负载均衡的工作原理如下:

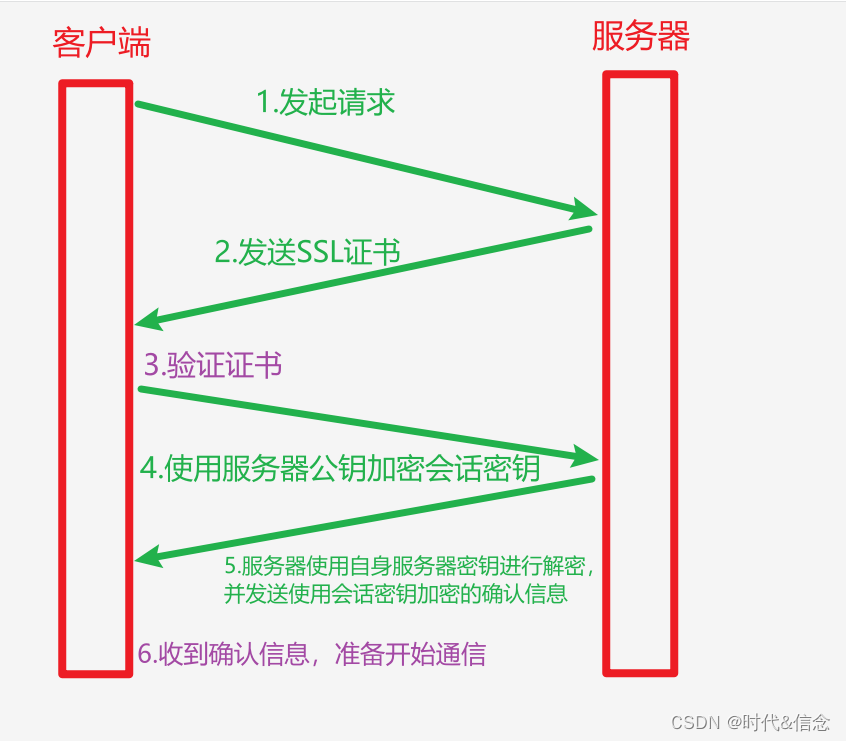

- 负载均衡器接收来自客户端的请求,并将请求转发给后端服务器。

- 后端服务器处理请求并返回响应。

- 负载均衡器接收响应并将其转发回客户端。

负载均衡器通常使用一些策略来决定将请求发送到哪个后端服务器。这些策略包括:

轮询(Round Robin):按照请求顺序依次将请求发送给每个后端服务器。IP哈希(IP Hash):根据客户端的IP地址对后端服务器进行哈希计算,将同一客户端的请求发送到同一台服务器。最少连接数(Least Connections):将请求发送到当前连接数最少的后端服务器。加权轮询(Weighted Round Robin):根据后端服务器的权重分配请求,权重越高的服务器处理的请求越多。加权最少连接数(Weighted Least Connections):根据后端服务器的权重和当前连接数进行负载均衡。

负载均衡器还可以提供其他功能,如:

- 健康检查:检查后端服务器是否可用,如果不可用,则将其从负载均衡器中移除。

- 会话保持:将同一个客户端的多个请求发送到同一台服务器,以保持会话状态。

- 故障转移:当一个后端服务器不可用时,负载均衡器将流量转移到其他可用服务器。

负载均衡器在分布式系统中非常重要,可以提高系统可用性和可靠性,同时降低单点故障的风险。

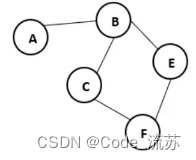

包括负载均衡算法的分类和示例

负载均衡算法根据不同的策略和原理可以分为以下几类:

1. 轮询(Round Robin):按照请求顺序依次将请求发送给每个后端服务器。

server1 -> server2 -> server3

2. IP哈希(IP Hash):根据客户端的IP地址对后端服务器进行哈希计算,将同一客户端的请求发送到同一台服务器。

client1 -> server1

client2 -> server2

client3 -> server3

3. 最少连接数(Least Connections):将请求发送到当前连接数最少的后端服务器。

server1 -> server2 -> server3

4. 加权轮询(Weighted Round Robin):根据后端服务器的权重分配请求,权重越高的服务器处理的请求越多。

server1 (weight=2) -> server2 (weight=1) -> server3 (weight=1)

5. 加权最少连接数(Weighted Least Connections):根据后端服务器的权重和当前连接数进行负载均衡。

server1 (weight=2, connections=10) -> server2 (weight=1, connections=5) -> server3 (weight=1, connections=2)

这些负载均衡算法可以根据实际需求进行组合和调整,以达到最佳负载均衡效果。

下面是一个使用Python的

socket库实现轮询负载均衡的示例:

import socket

import threading

# 创建服务器列表

servers = ['192.168.1.1', '192.168.1.2', '192.168.1.3']

# 创建socket对象

sock = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

sock.setsockopt(socket.SOL_SOCKET, socket.SO_REUSEADDR, 1)

# 绑定IP和端口

server_address = ('0.0.0.0', 12345)

sock.bind(server_address)

# 监听连接

sock.listen(5)

# 循环接收客户端请求

while True:

client_sock, client_address = sock.accept()

print(f"客户端 {client_address} 已连接")

# 轮询负载均衡

server = servers[0]

servers = servers[1:] + servers[:1]

# 连接到后端服务器

server_sock = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

server_address = (server, 12345)

server_sock.connect(server_address)

# 将客户端请求转发给后端服务器

server_sock.sendall(client_sock.recv(1024))

# 接收后端服务器响应并转发给客户端

client_sock.sendall(server_sock.recv(1024))

# 关闭连接

client_sock.close()

server_sock.close()

这个示例中,我们首先创建了一个服务器列表,然后创建了一个socket对象并绑定到0.0.0.0和12345端口。接着我们监听连接并进入循环接收客户端请求的循环。在循环中,我们使用轮询负载均衡策略选择一个后端服务器,然后连接到该服务器并接收客户端请求。最后,我们将请求转发给后端服务器,接收响应并将其转发回客户端,然后关闭连接。

解释负载均衡如何提高系统的性能和可靠性

负载均衡可以提高系统的性能和可靠性,主要表现在以下几个方面:

-

提高系统可用性:负载均衡器将流量分散到多台服务器上,即使一台服务器出现故障,其他服务器仍然可以继续处理请求,从而提高了系统的可用性。

-

降低单点故障风险:负载均衡器将流量分散到多台服务器上,降低了单点故障的风险。如果一台服务器出现故障,其他服务器仍然可以继续处理请求,从而保证了系统的稳定性。 -

提高系统性能:负载均衡器可以根据不同的策略和负载情况,动态地分配请求到不同的服务器上,避免了请求集中在一台服务器上导致的系统压力,从而提高了系统的性能。

-

减轻服务器压力:负载均衡器将流量分散到多台服务器上,减轻了服务器的压力,从而提高了系统的可靠性和稳定性。 -

扩展系统:负载均衡器可以根据需要动态地添加和删除服务器,从而可以轻松地扩展系统。

总之,负载均衡能够提高系统的性能和可靠性,使系统更加稳定、可靠、高效,同时也能够适应业务的变化和扩展。

3. 常见的负载均衡策略

以下是对常见负载均衡策略的详细说明:

1. 轮询(Round Robin)

轮询策略将请求依次分配给可用的服务器。每个服务器按顺序接收相等数量的请求。这是一种简单且公平的分配方式,适用于服务器具有相似性能的情况。

示例:如果有三个服务器(服务器 A、B、C),那么第一个请求将被发送到服务器 A,第二个请求将被发送到服务器 B,第三个请求将被发送到服务器C,依此类推。

-

优点:简单易懂,实现容易。

-

缺点:不考虑服务器的性能差异,可能导致性能不均衡。

2. 加权轮询(Weighted Round Robin)

加权轮询策略根据服务器的性能或权重来分配请求。服务器的权重决定了它接收请求的概率。性能更高或具有更高权重的服务器将接收更多的请求。

示例:如果服务器 A 的权重为 2,服务器 B 的权重为 1,服务器 C 的权重为 1,那么第一个请求将被发送到服务器 A,第二个请求可能被发送到服务器 B 或 C(各有 50%的概率),第三个请求将再次被发送到服务器 A。

-

优点:考虑了服务器的性能差异,可以根据服务器的能力进行分配。

-

缺点:需要知道服务器的相对性能或权重。

3. 随机(Random)

随机策略随机选择可用的服务器来处理请求。请求被随机分配给其中一个服务器,没有特定的顺序或优先级。

示例:当有三个可用的服务器时,请求可能随机地被发送到服务器 A、B 或 C。

-

优点:简单且不需要考虑服务器的性能。

-

缺点:无法预测请求将被发送到哪个服务器,可能导致不均衡的负载分布。

4. 最小连接数(Least Connections)

最小连接数策略将请求分配给当前具有最少活动连接数的服务器。这意味着负载较轻的服务器将更有可能接收新的请求。

示例:如果服务器 A 有 5 个活动连接,服务器 B 有 3 个活动连接,而服务器 C 有 1 个活动连接,那么新的请求将被发送到服务器C。

-

优点:能够动态地根据服务器的负载进行分配,确保负载均衡。

-

缺点:需要实时跟踪服务器的连接数。

5. 哈希(Hash)

哈希策略根据请求的某些属性(如 URL、IP 地址等)计算哈希值,并将请求分配给具有相应哈希值的服务器。这可以确保相同的请求始终被发送到相同的服务器。

示例:如果使用 URL 作为哈希键,请求的 URL 被哈希计算并映射到服务器 A、B 或 C 中的一个。

-

优点:可以确保特定请求始终被发送到相同的服务器,适用于需要会话保持或特定请求与特定服务器相关联的情况。

-

缺点:如果某个服务器出现故障,可能会导致哈希不均匀。

选择适当的负载均衡策略取决于应用程序的具体需求、性能要求和可扩展性目标。一些负载均衡器还提供了自定义策略的能力,可以根据特定的业务逻辑进行请求分配。