📋 博主简介

- 💖 作者简介:大家好,我是wux_labs。😜

热衷于各种主流技术,热爱数据科学、机器学习、云计算、人工智能。

通过了TiDB数据库专员(PCTA)、TiDB数据库专家(PCTP)、TiDB数据库认证SQL开发专家(PCSD)认证。

通过了微软Azure开发人员、Azure数据工程师、Azure解决方案架构师专家认证。

对大数据技术栈Hadoop、Hive、Spark、Kafka等有深入研究,对Databricks的使用有丰富的经验。- 📝 个人主页:wux_labs,如果您对我还算满意,请关注一下吧~🔥

- 📝 个人社区:数据科学社区,如果您是数据科学爱好者,一起来交流吧~🔥

- 🎉 请支持我:欢迎大家 点赞👍+收藏⭐️+吐槽📝,您的支持是我持续创作的动力~🔥

《PySpark大数据分析实战》-15.云服务模式Databricks介绍创建集群

- 《PySpark大数据分析实战》-15.云服务模式Databricks介绍创建集群

- 前言

- 创建集群

- 数据集成

- 结束语

《PySpark大数据分析实战》-15.云服务模式Databricks介绍创建集群

前言

大家好!今天为大家分享的是《PySpark大数据分析实战》第2章第5节的内容:云服务模式Databricks介绍创建集群。

图书在:当当、京东、机械工业出版社以及各大书店有售!

创建集群

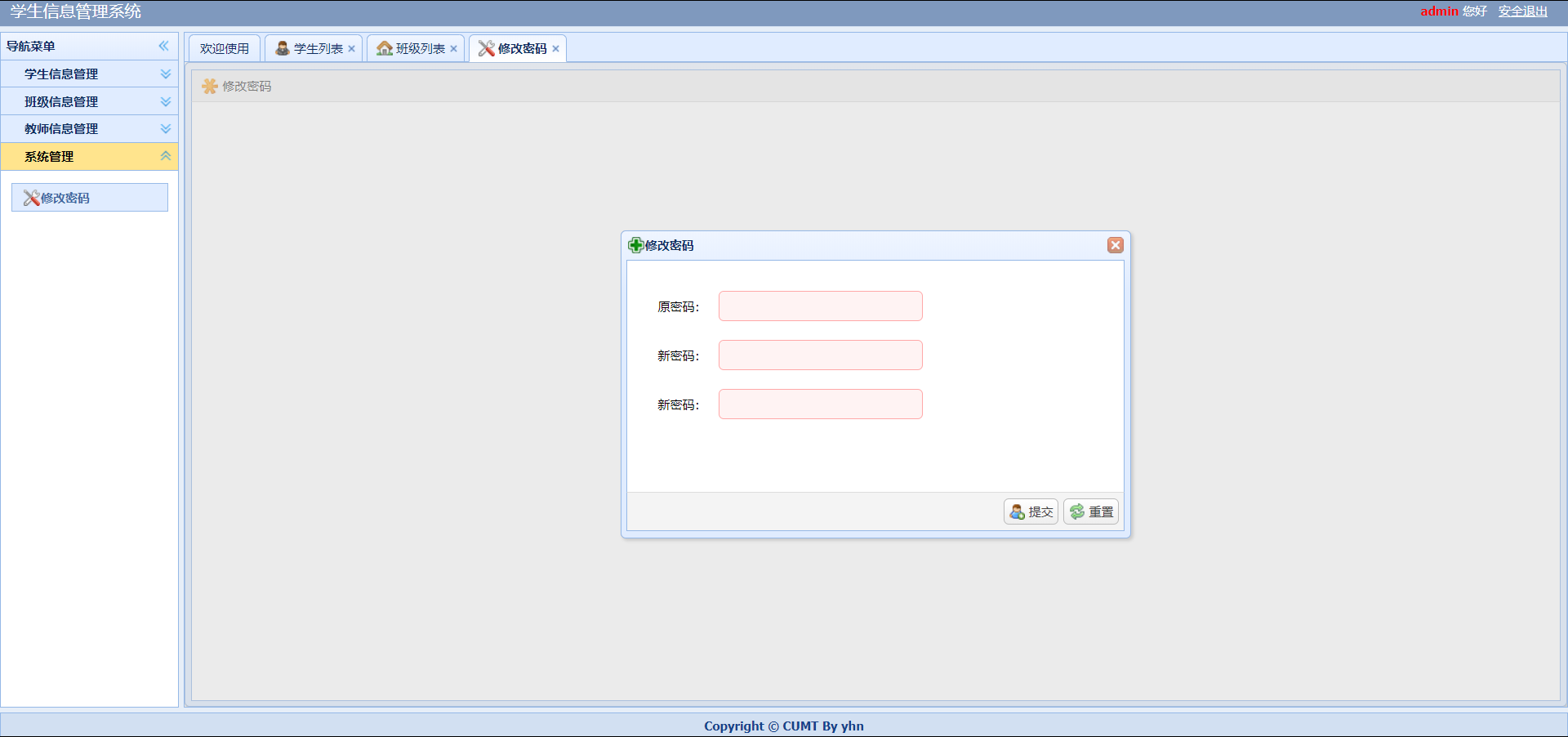

使用Databricks进行数据集成、数据分析、机器学习前,必须创建集群。通过Compute菜单打开Compute列表界面,如图所示。

Databricks支持两种类型的Compute,All-purpose compute是通用的计算资源,可用于交互式数据集成、数据分析等;Job compute是用于执行定时作业的计算资源。在All-purpose compute页面点击Create compute按钮,打开集群创建界面,如图所示。

Databricks的集群支持两种模式,Single node是单节点模式,类似于Spark的单机模式;Muti node是多节点模式,类似于Spark的独立集群模式,包含1个Master节点和多个可弹性扩缩容的Worker节点。选择Multi node选项,在Databricks runtime version下面选择Spark版本。Databricks支持两种类型的runtime版本,Standard是标准类型版本,通常用于数据工程、数据科学;ML版本包含更多的机器学习的库,适用于学习,支持GPU运算。在ML版本下选择不支持GPU运算的Spark 3.4.0版本的集群环境,如图所示。

在Worker type下面选择Worker节点的类型,主要是选择CPU核数和内存大小,以及Worker节点个数,Worker节点支持弹性伸缩,根据需要进行设置,如图所示。

在Driver type下面选择Master节点的类型,选择与Worker节点一样,如图所示。

所有配置设置完成,点击Create Cluster按钮创建集群。集群创建完成后,在Compute列表可以看到创建的集群,如图所示。

数据集成

在Databircks中可以通过URL访问HDFS上的文件,但是Databricks是部署在云端的,这种数据访问会带来网络数据传输的开销。为了能够快速访问数据,可以将文件存储在DBFS上。通过左侧菜单栏的New菜单,选择Data菜单,如图所示。

在数据集成界面列出了可以集成到Databricks的数据源,Databricks支持很多数据源的集成,如图所示。

选择DBFS,在Upload File页面下,选择words.txt上传到DBFS的/FileStore/tables/路径下,如图所示。

结束语

好了,感谢大家的关注,今天就分享到这里了,更多详细内容,请阅读原书或持续关注专栏。

![[BJDCTF2020]Mark loves cat1](https://img-blog.csdnimg.cn/direct/b224c3c4a88e4dd2b731de7e77ee2bec.png)