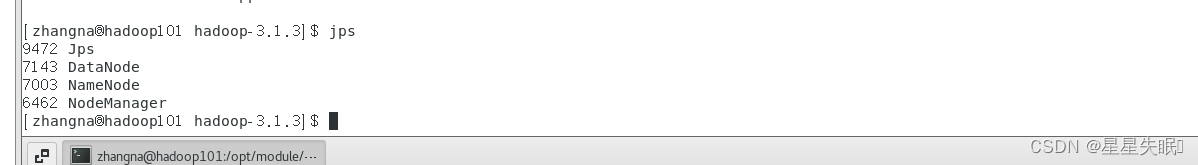

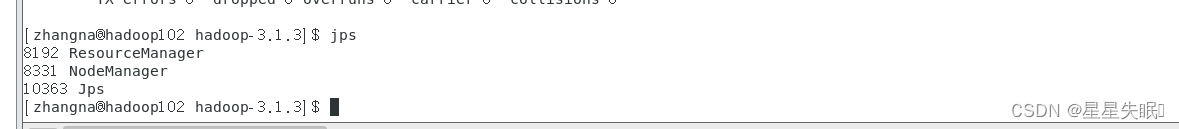

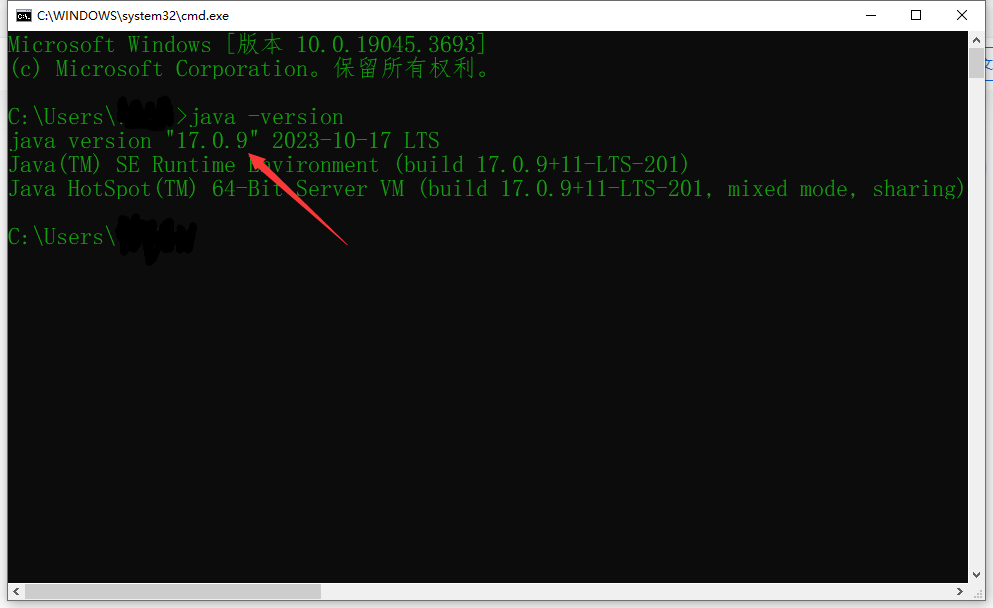

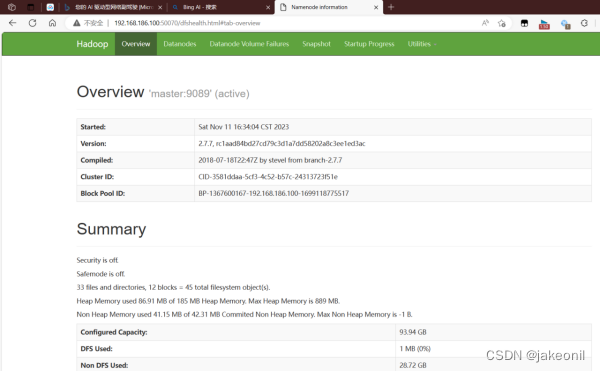

首先把hadoop服务起来

1. (简答题)

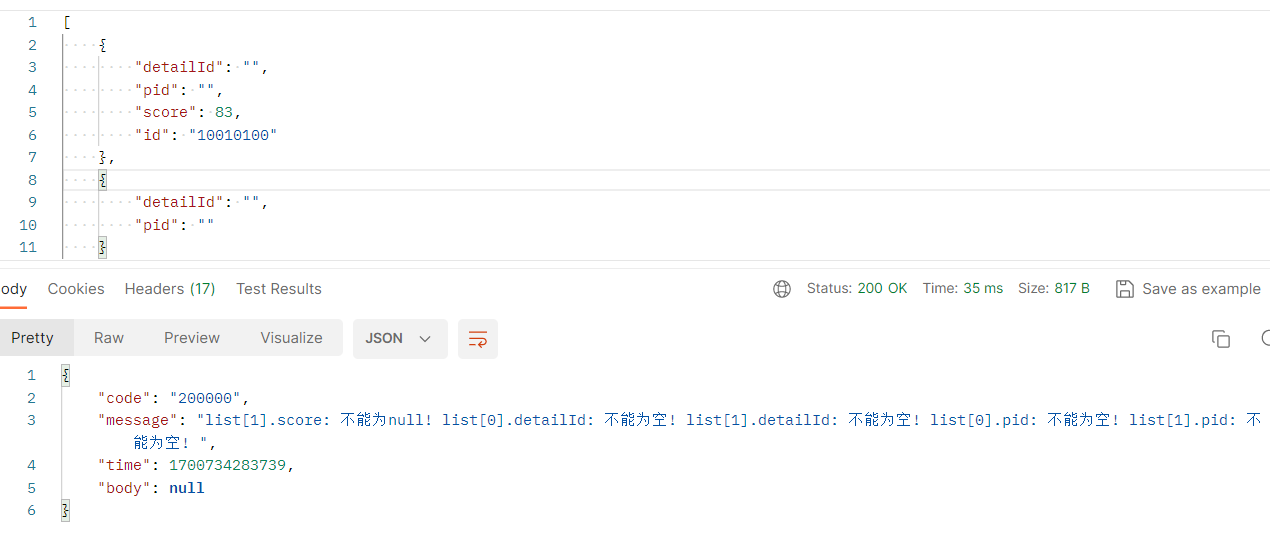

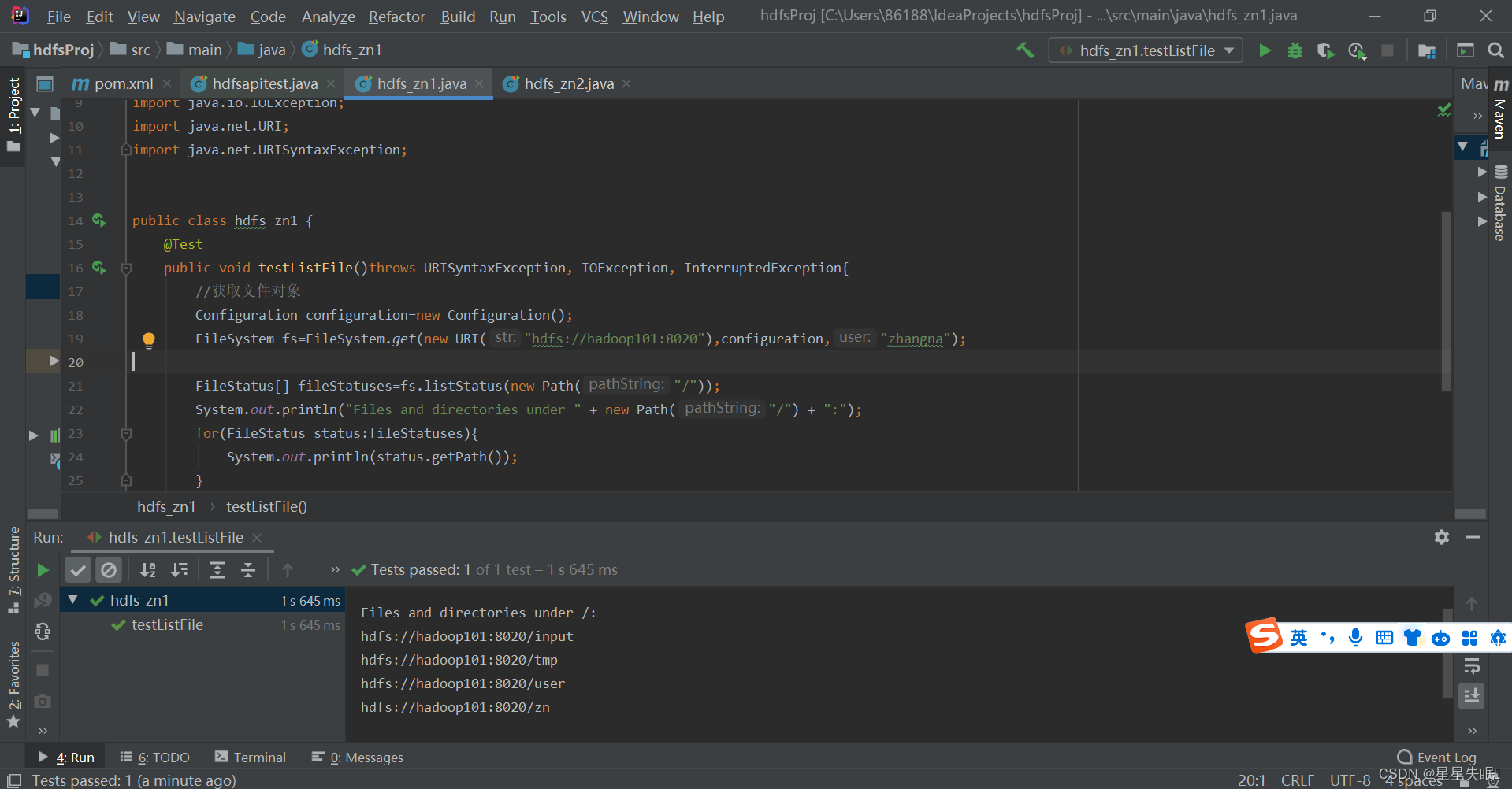

使用HDFS 的JAVA API 进行编程:

(1)获取自己HDFS集群下的所有文件和目录;

//获取自己HDFS集群下的所有文件和目录;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

public class hdfs_zn1 {

@Test

public void testListFile()throws URISyntaxException, IOException, InterruptedException{

//获取文件对象

Configuration configuration=new Configuration();

FileSystem fs=FileSystem.get(new URI("hdfs://hadoop101:8020"),configuration,"zhangna");

FileStatus[] fileStatuses=fs.listStatus(new Path("/"));

System.out.println("Files and directories under " + new Path("/") + ":");

for(FileStatus status:fileStatuses){

System.out.println(status.getPath());

}

}

}

(2)在根目录下创建以自己名字拼音缩写命名的目录,并任意上传一个文件至该目录;

我在D盘下写了一个文件名字叫hdfstest.txt 我要将它上传到创建的目录中

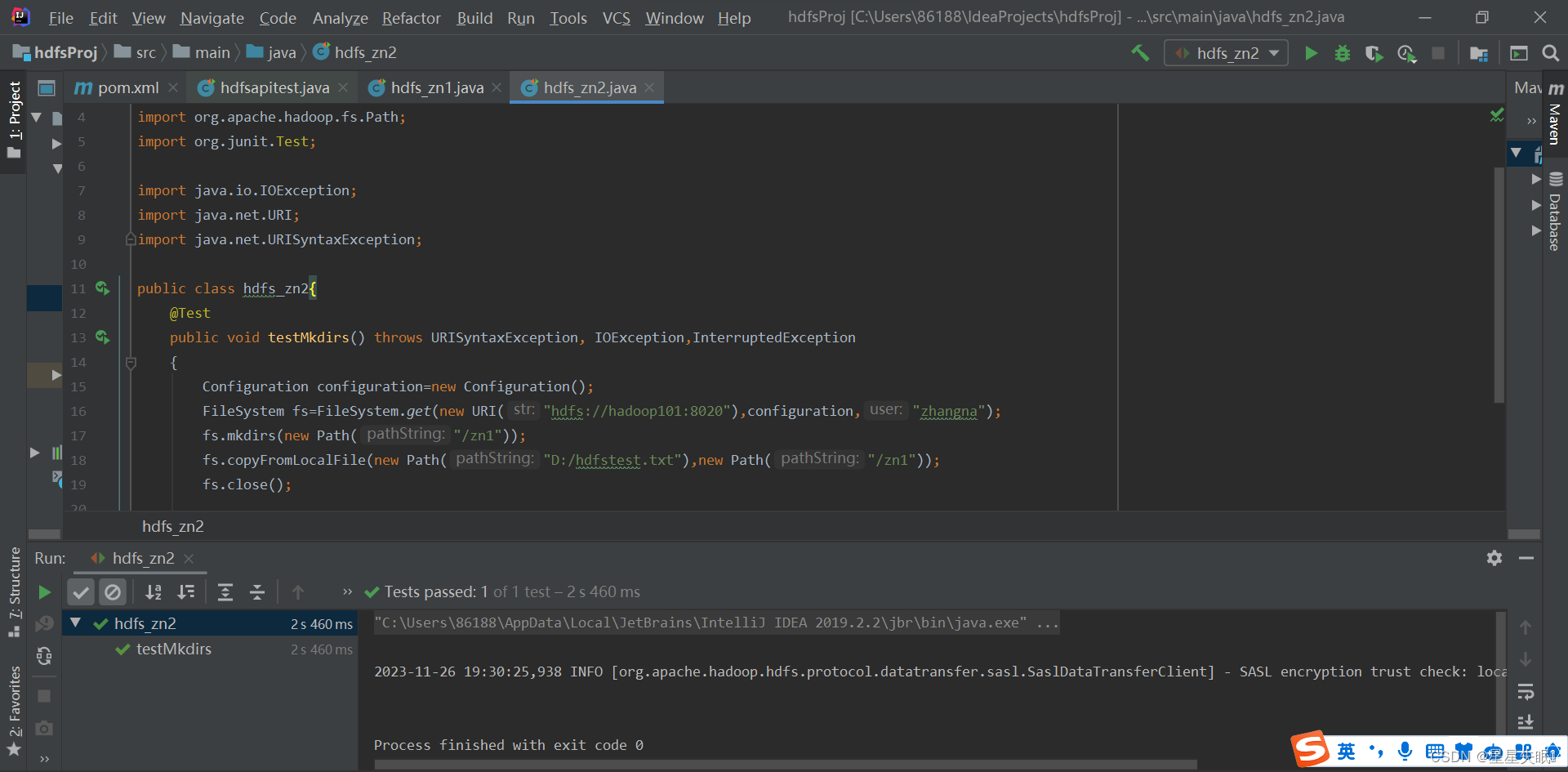

//(2)在根目录下创建以自己名字拼音缩写命名的目录,并任意上传一个文件至该目录;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

public class hdfs_zn2{

@Test

public void testMkdirs() throws URISyntaxException, IOException,InterruptedException

{

Configuration configuration=new Configuration();

FileSystem fs=FileSystem.get(new URI("hdfs://hadoop101:8020"),configuration,"zhangna");

fs.mkdirs(new Path("/zn1"));

fs.copyFromLocalFile(new Path("D:/hdfstest.txt"),new Path("/zn1"));

fs.close();

}

}

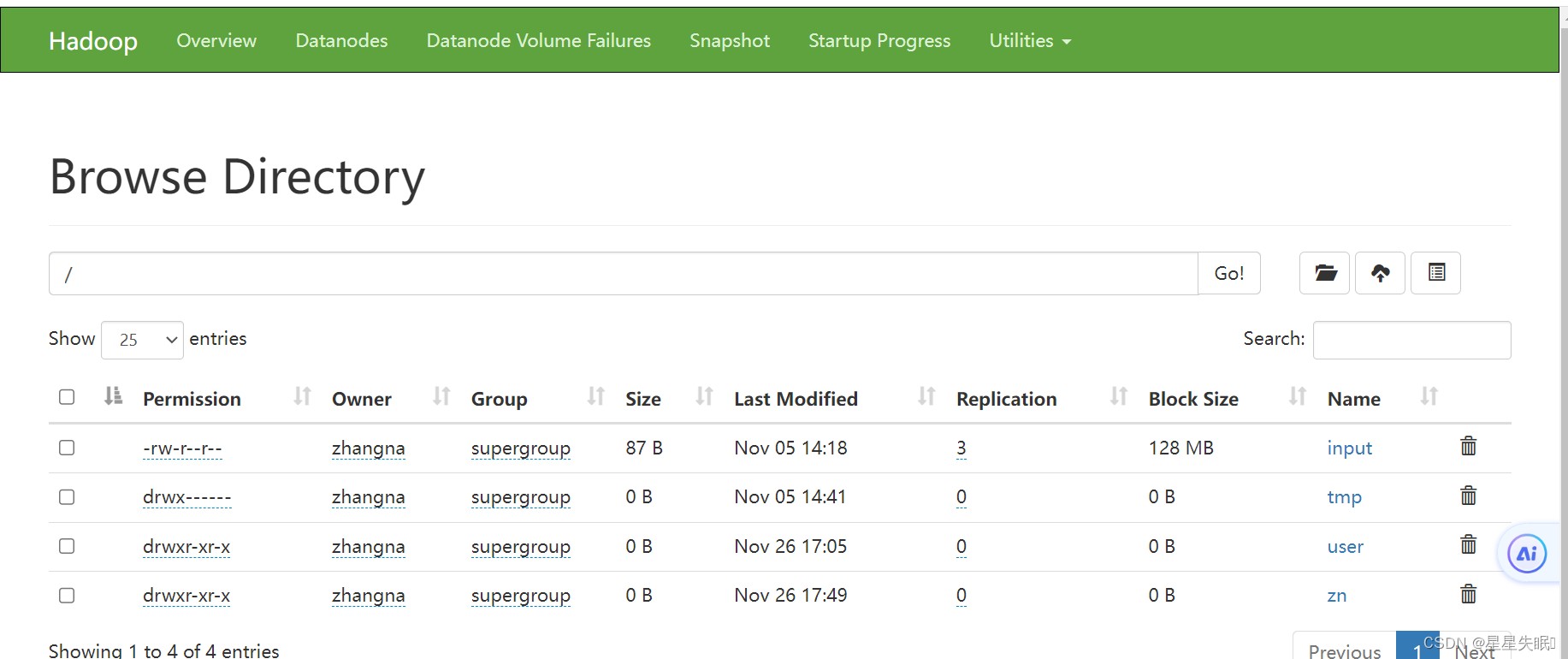

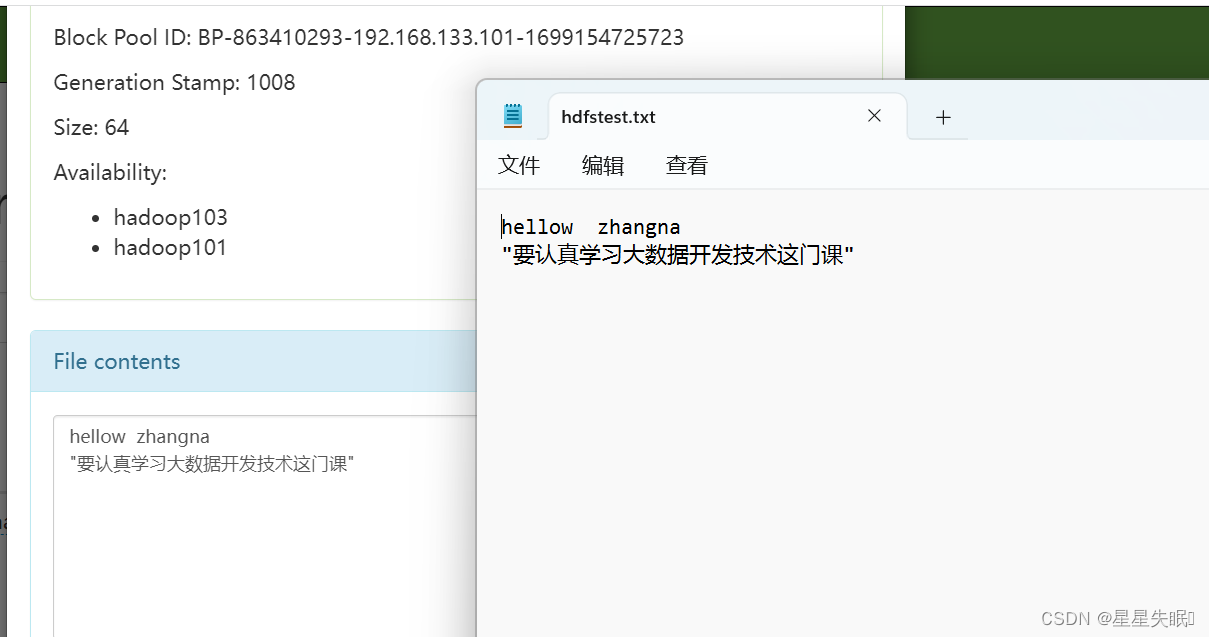

现在变成

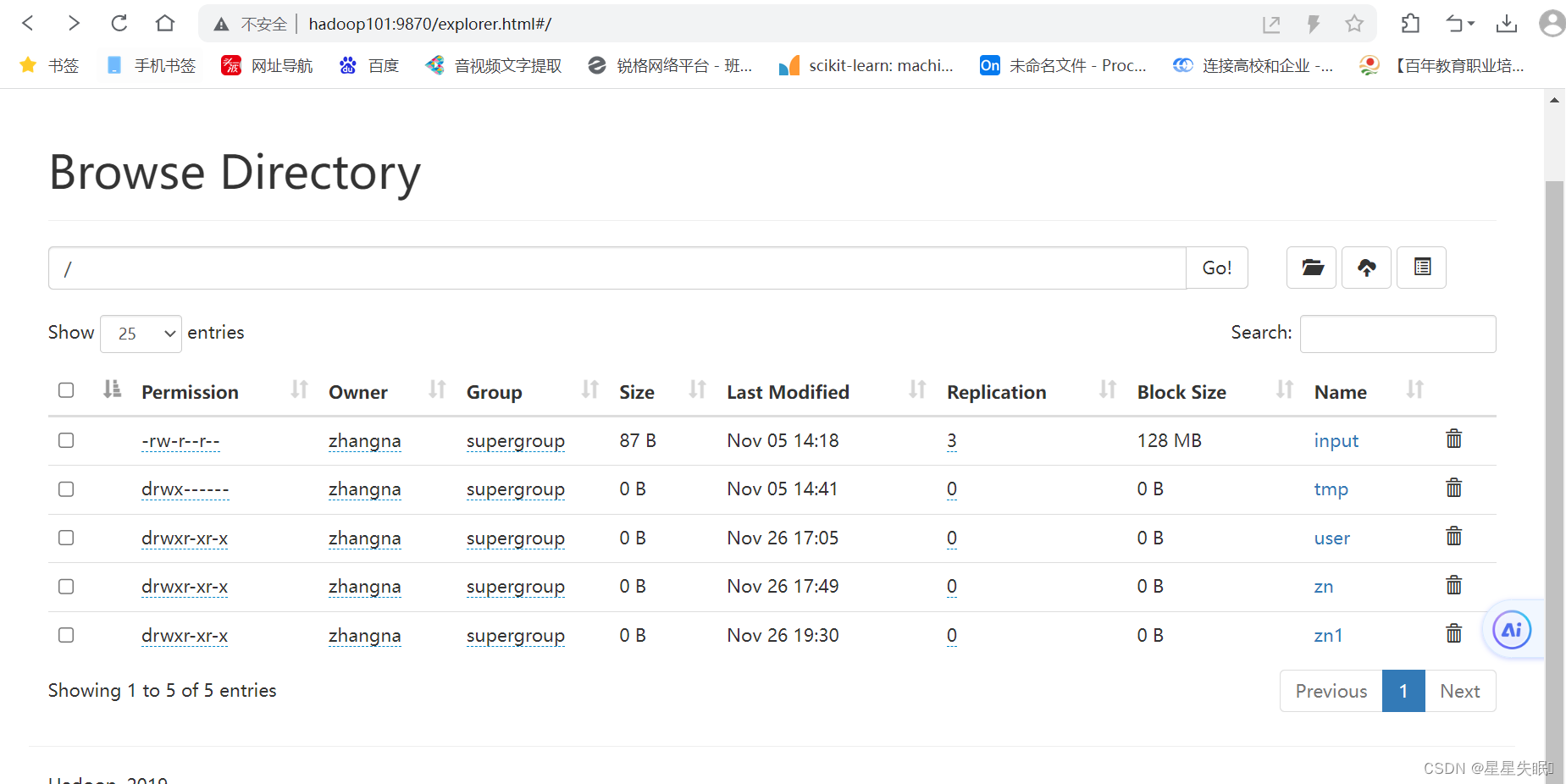

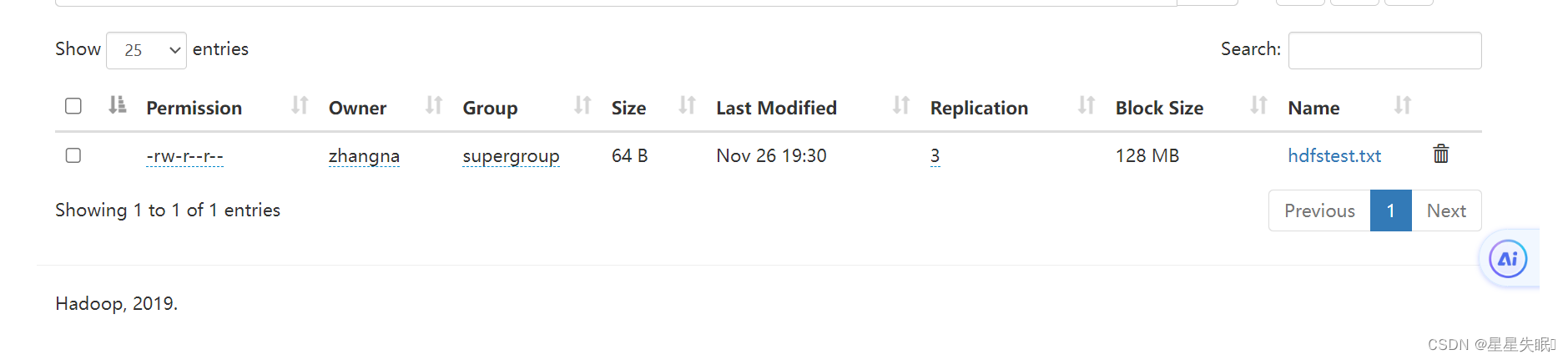

可以看到我上传的文件

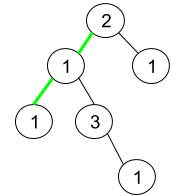

查看文件内容和我本地文件内容一样的

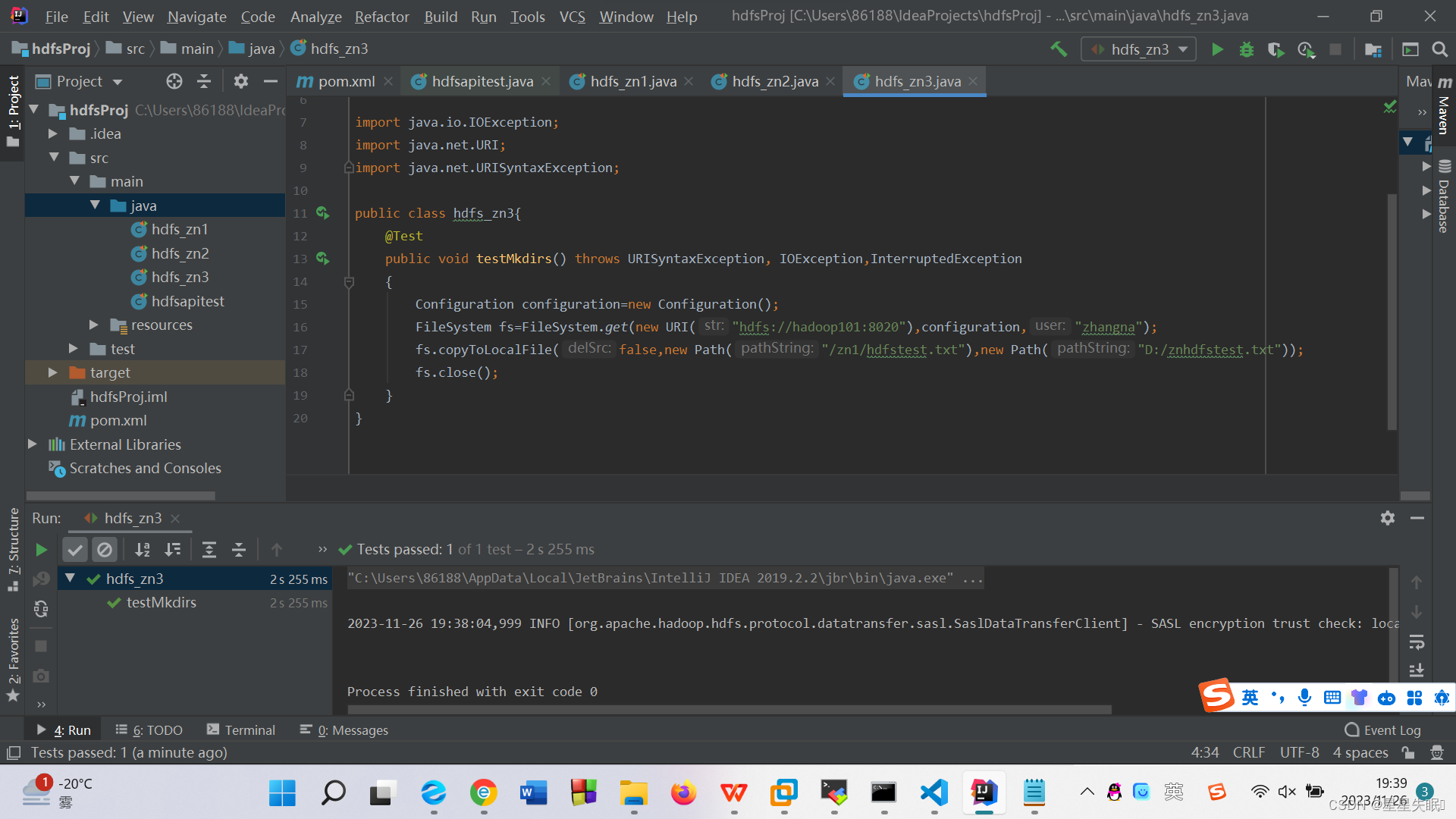

(3)下载(2)中上传的文件。

(3)下载(2)中上传的文件。

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

public class hdfs_zn3{

@Test

public void testMkdirs() throws URISyntaxException, IOException,InterruptedException

{

Configuration configuration=new Configuration();

FileSystem fs=FileSystem.get(new URI("hdfs://hadoop101:8020"),configuration,"zhangna");

fs.copyToLocalFile(false,new Path("/zn1/hdfstest.txt"),new Path("D:/znhdfstest.txt"));

fs.close();

}

}

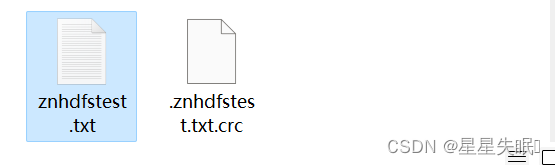

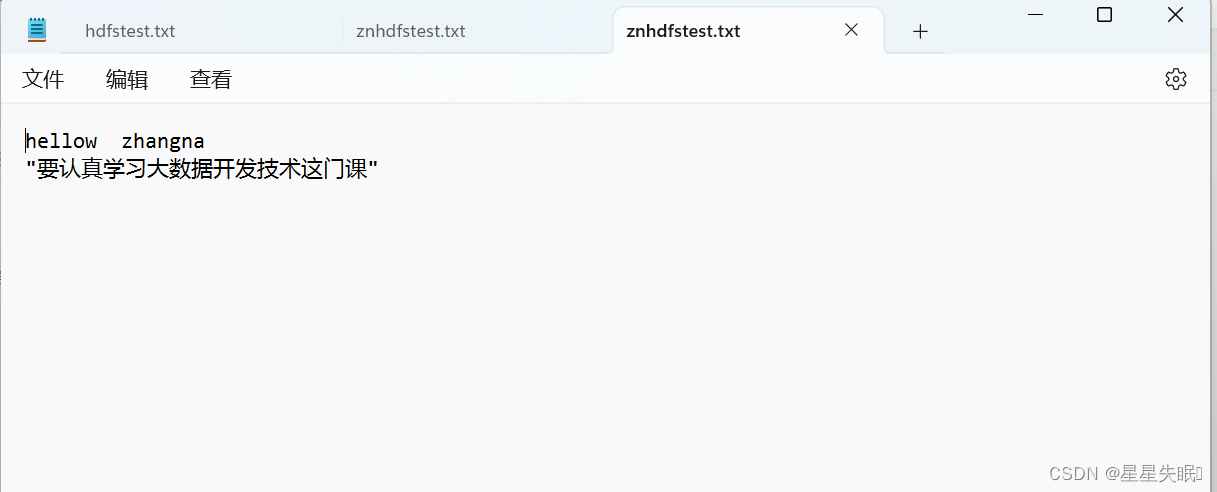

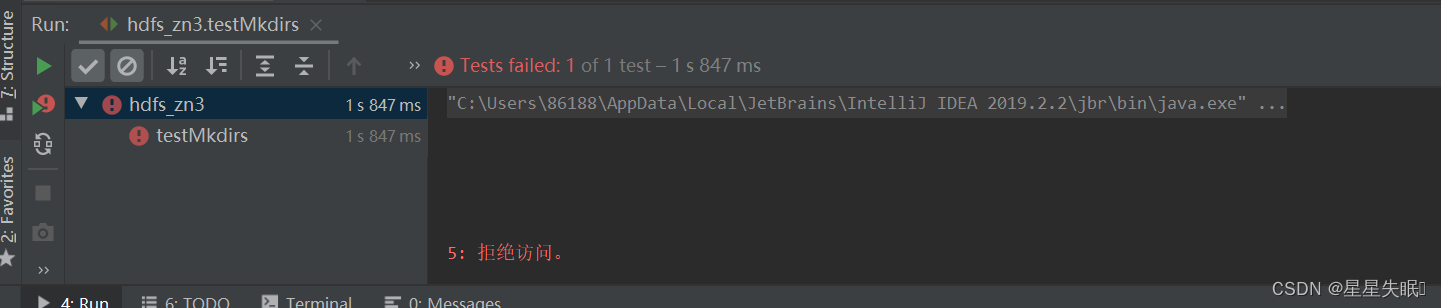

我下载了(2)中上传的文件,出现了一点小问题是,我想放到C盘根目录下,会因为权限问题而拒绝访问

要求:分别上传3道小题的源代码和结果截图(浏览器或控制台)。