目录

1. 简介:探索注意力机制的世界

2. 历史背景

3. 核心原理

4. 应用案例

5. 技术挑战与未来趋势

6. 图表和示例

7. Conclusion

1. 简介:探索注意力机制的世界

在当今的人工智能(AI)和机器学习(ML)领域,一个关键且日益受到重视的概念是“注意力机制”(Attention Mechanism)。这个概念源自于我们对人类大脑如何处理信息的理解,特别是在面对海量数据时,如何有效地筛选出关键信息。

注意力机制在AI中的运用,类似于人类在观看一幅画作或阅读一篇文章时的注意力分配。我们的大脑天然就会被某些特定的信息所吸引,从而忽略掉其他较不重要的部分。这个机制使我们能够在复杂的环境中高效地处理信息,专注于最关键的部分。

在机器学习领域,注意力机制的引入标志着模型能力的一个重要提升。它允许模型在处理如文本、图片或语音数据时,动态地关注数据中的关键部分,从而提高了处理效率和效果。例如,在翻译一段长文本时,注意力机制帮助模型集中于当前翻译的词汇周围的上下文,而不是整个文本。

这种机制的出现,不仅在自然语言处理(NLP)、图像识别和语音识别等领域得到了广泛应用,也推动了AI技术的快速发展和创新。它改变了我们构建和理解智能系统的方式,使这些系统更加高效、灵活,同时更接近于人类的信息处理方式。

总的来说,注意力机制为我们提供了一种更精细、更智能的方式来处理和分析大量数据,开辟了人工智能研究和应用的新篇章。在接下来的章节中,我们将深入探讨这一概念的历史背景、核心原理和广泛应用。

2. 历史背景

注意力机制的概念并非完全源自计算机科学,而是有着跨学科的起源。最初,它是心理学和神经科学领域研究人类认知过程的一个概念。心理学家和神经科学家发现,人类的大脑并不是平等地处理所有感官输入的信息,而是会根据其重要性或相关性进行筛选,集中精力处理某些特定的刺激。

进入21世纪,随着机器学习和人工智能的迅速发展,研究人员开始探索如何将这一人类大脑的特性应用到计算机模型中。最初的尝试出现在视觉任务中,例如图像识别,随后很快扩展到了其他领域,如自然语言处理和序列预测。

2014年,Google的研究团队在一项开创性的工作中首次将注意力机制应用到神经网络模型中,用于提高机器翻译的性能。这项工作标志着注意力机制在人工智能领域的正式诞生,并迅速引起了广泛的关注和研究。

自那以后,注意力机制已成为最重要的机器学习创新之一,并被广泛应用于多种AI模型和应用中,从而大大提高了它们的性能和效率。

3. 核心原理

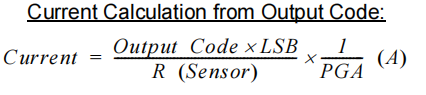

注意力机制的核心原理基于这样一个观点:在处理大量信息时,不是所有的数据都同等重要。因此,模型应该能够识别并集中处理最关键的信息。

在实际应用中,这通常意味着模型会为输入数据的不同部分分配不同的“注意力权重”。这些权重决定了模型在预测或决策时对数据各部分的关注程度。

例如,在处理自然语言的任务中,注意力机制可以帮助模型确定在给定的上下文中哪些词更重要,从而更好地理解句子的含义。类似地,在图像识别任务中,模型可以学会集中注意力于图像的关键区域,从而提高识别的准确性。

技术上,注意力机制通常通过一系列可训练的权重来实现,这些权重是在模型的训练过程中学习得到的。通过这种方式,模型可以动态地调整对输入数据的关注点,从而在各种复杂的任务中实现更好的性能。

4. 应用案例

注意力机制在多个领域中的应用展现了其广泛的适用性和强大的性能改善能力。以下是一些显著的应用案例:

-

自然语言处理(NLP):在NLP领域,注意力机制已成为一项关键技术。它被用于改进机器翻译、文本摘要、情感分析等任务的性能。例如,通过对文本中的关键词或短语进行聚焦,模型可以更准确地捕捉语言的细微差别和上下文含义。

import torch

import torch.nn as nn

import torch.nn.functional as F

class TextAttention(nn.Module):

def __init__(self, embed_dim, hidden_dim):

super(TextAttention, self).__init__()

self.attention = nn.Linear(embed_dim, hidden_dim)

self.context_vector = nn.Linear(hidden_dim, 1, bias=False)

def forward(self, embeddings):

# 应用注意力机制

attn_weights = F.softmax(self.context_vector(torch.tanh(self.attention(embeddings))), dim=1)

weighted_embeddings = embeddings * attn_weights

output = weighted_embeddings.sum(dim=1)

return output, attn_weights

# 示例:创建一个文本注意力模块,并应用于词嵌入

text_attention = TextAttention(embed_dim=100, hidden_dim=50)

embeddings = torch.randn(10, 100) # 假设有10个词,每个词的嵌入维度为100

output, attn_weights = text_attention(embeddings)

print(output.size()) # 输出文本表示的维度

-

图像识别:在图像处理领域,注意力机制帮助模型识别和关注图像中的重要特征,如对象的特定部分或关键细节。这在医学图像分析、面部识别和自动驾驶汽车的视觉系统等应用中尤为重要。

-

语音识别:在语音识别系统中,注意力机制用于提高识别准确性,通过关注语音中的关键声音模式或特定时间点的发音,来更好地理解和转录语音。

-

推荐系统:在推荐系统中,注意力机制被用来更准确地预测用户的兴趣和偏好。通过分析用户过往的互动和行为模式,模型可以更有效地推荐相关的内容或产品。

-

序列到序列的学习任务:在诸如文本翻译或语音到文本转换等序列到序列的任务中,注意力机制可以帮助模型在处理输入序列的同时,更有效地生成输出序列。

class Seq2SeqAttention(nn.Module):

def __init__(self, encoder_hidden_dim, decoder_hidden_dim):

super(Seq2SeqAttention, self).__init__()

self.encoder_hidden_dim = encoder_hidden_dim

self.decoder_hidden_dim = decoder_hidden_dim

self.attention = nn.Linear(self.encoder_hidden_dim + self.decoder_hidden_dim, decoder_hidden_dim)

self.v = nn.Parameter(torch.rand(decoder_hidden_dim))

def forward(self, hidden, encoder_outputs):

# 扩展最后一个隐藏状态到与encoder_outputs大小相同

hidden = hidden.unsqueeze(1).repeat(1, encoder_outputs.size(0), 1)

energy = torch.tanh(self.attention(torch.cat((hidden, encoder_outputs), dim=2)))

attention = F.softmax(torch.einsum("ijk,k->ij", [energy, self.v]), dim=1)

return attention

# 示例:创建一个序列到序列注意力模块

seq2seq_attention = Seq2SeqAttention(encoder_hidden_dim=100, decoder_hidden_dim=50)

hidden = torch.randn(50) # 假设decoder的隐藏状态维度为50

encoder_outputs = torch.randn(10, 100) # 假设encoder输出10个状态,每个状态维度为100

attention_weights = seq2seq_attention(hidden, encoder_outputs)

print(attention_weights.size()) # 输出注意力权重的维度

这些应用案例展示了注意力机制如何在各种不同的场景中增强模型的性能,使其能够更好地处理复杂的数据和任务。通过将这种机制应用于各种AI领域,研究人员和开发人员能够构建出更为智能和适应性强的系统。

5. 技术挑战与未来趋势

虽然注意力机制已经在多个领域取得显著成果,但它仍然面临着一系列技术挑战和研究问题。其中一个主要的挑战是计算复杂性。在处理特别大的数据集或复杂的模型时,计算所需的资源可能会迅速增加。优化算法以减少所需的计算资源,同时保持模型性能,是当前研究的重点之一。

此外,尽管注意力机制已经在模型的解释性方面取得了进展,但如何精确理解和解释模型的注意力决策仍然是一个开放的问题。这对于构建可信赖的AI系统尤为重要,特别是在涉及关键决策的应用中,如医疗诊断和自动驾驶。

展望未来,注意力机制可能会与其他前沿技术,如神经网络的新架构、量子计算等相结合,以解决现有的挑战并进一步拓展其应用领域。随着研究的深入,我们可以预期在效率、效果和解释性方面会有更多突破。

6. 图表和示例

为了更深入地解释注意力机制,我们可以通过以下图表和编码示例来增进理解:

-

图表:注意力机制在文本处理中的应用

- 描述:一张图表可以展示在处理一段文本时(例如,一句话),模型如何为每个单词分配不同的注意力权重。这可以用颜色的深浅来表示,颜色越深表示对应单词的权重越高,即模型更加关注这些词。

-

代码示例:简单的注意力机制实现

以下是一个简化的注意力机制的伪代码,用于解释其在神经网络中的实现方式:

import torch

import torch.nn as nn

import torch.nn.functional as F

class Attention(nn.Module):

def __init__(self, feature_dim):

super(Attention, self).__init__()

self.feature_dim = feature_dim

self.attention_weights = nn.Parameter(torch.Tensor(feature_dim))

def forward(self, x):

# 应用注意力机制

weights = F.softmax(self.attention_weights, dim=0)

weighted_features = x * weights

output = weighted_features.sum(dim=1)

return output

# 示例:创建一个注意力模块,并应用于一组特征

attention = Attention(feature_dim=10)

features = torch.randn(1, 10) # 假设有10个特征

output = attention(features)

print(output)

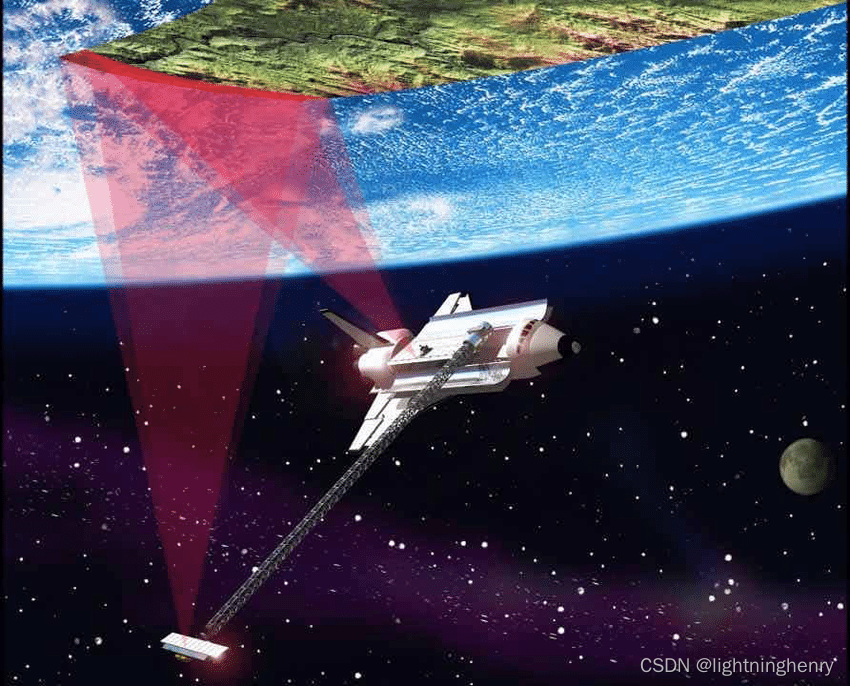

图表:注意力机制在图像识别中的应用

- 描述:另一张图表可以展示在处理图像时,模型如何集中注意力于特定的区域。例如,在面部识别任务中,模型可能会更关注眼睛、鼻子和嘴巴等关键特征。

7. Conclusion

在本文中,我们探讨了注意力机制的历史背景、核心原理、应用案例以及面临的挑战和未来趋势。通过这一创新的机制,人工智能系统能够更有效地处理和分析大量数据,从而在多个领域取得了显著的成果。

注意力机制不仅提高了模型的性能,也为我们提供了新的视角来理解人类大脑如何处理信息。随着技术的不断发展和深入应用,我们可以预期,注意力机制将继续在人工智能领域扮演重要角色,推动技术创新和应用的发展。

总之,注意力机制是连接人工智能理论与实际应用的关键桥梁,为我们打开了探索智能系统新领域的大门。