目录

前言

一、获取代理IP

二、解析代理IP

三、维护代理IP池

四、完整代码

总结

前言

在爬虫过程中,我们经常会使用代理IP来绕过一些限制,比如防止被封IP等问题。而代理IP的获取和维护是一个比较麻烦的问题,需要花费一定的时间和精力。在Python中,使用Pandas库可以非常方便地实现代理IP的获取和维护,本文将详细介绍如何使用Pandas一键爬取解析代理IP并维护代理IP池。

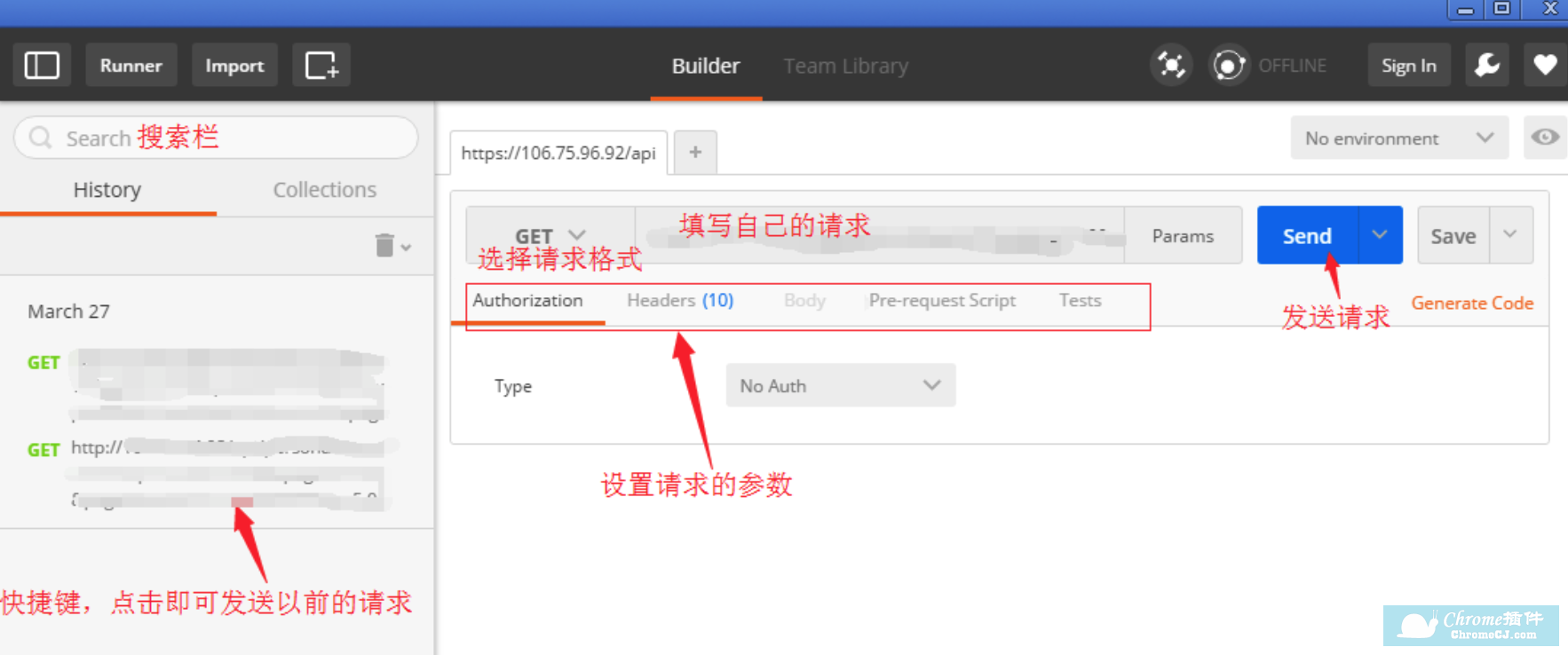

一、获取代理IP

首先我们需要从代理IP网站获取代理IP,代理IP网站有很多,本文以西刺代理为例。

我们可以使用requests库发起一个GET请求,获取代理IP网站的源码。针对站大爷代理,其代理IP信息都被包含在table标签中,我们可以使用Pandas库对其进行解析。另外,西刺代理网站还提供了一些筛选条件,我们也可以用requests库模拟筛选条件的POST请求,将代理IP筛选出来。

代码如下:

import requests

import pandas as pd

from bs4 import BeautifulSoup

def get_ip_pool(url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

# 获取代理IP网站的源码

res = requests.get(url, headers=headers)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'html.parser')

# 获取代理IP信息

table = soup.find('table', {'id': 'ip_list'})

df = pd.read_html(str(table))[0]

# 筛选出有效的代理IP

df = df[(df['类型'].isin(['HTTP', 'HTTPS'])) & (df['存活时间'].str.contains('天') | df['存活时间'].str.contains('小时') | df['存活时间'].str.contains('分钟'))]

# 将DataFrame转换为列表

ip_list = df[['IP地址', '端口号']].values.tolist()

return ip_list

二、解析代理IP

我们已经获取到了代理IP,接下来需要对其进行解析。

代理IP的形式一般为:IP地址:端口号,我们需要将其拆分为IP地址和端口号两部分。可以使用str.split()函数将其拆分。

代码如下:

def parse_ip(ip_list):

# 解析代理IP

parsed_ip_list = []

for ip in ip_list:

parsed_ip_list.append(tuple(ip.split(':')))

return parsed_ip_list

三、维护代理IP池

代理IP池是由一组可用的代理IP组成的集合,为了保证代理IP池的可用性,我们需要定时检测代理IP的可用性,并对不可用的代理IP进行删除。

我们可以使用requests库发起一个GET请求,以www.baidu.com为例,检测代理IP的可用性。如果响应状态码为200,则表示代理IP可用,否则代理IP不可用。

代码如下:

def check_ip(ip):

# 检测代理IP可用性

proxies = {

'http': 'http://' + ':'.join(ip),

'https': 'https://' + ':'.join(ip)

}

try:

res = requests.get('https://www.baidu.com', proxies=proxies, timeout=5)

if res.status_code == 200:

return True

else:

return False

except:

return False

def maintain_ip_pool(ip_pool):

# 维护代理IP池

valid_ip_pool = []

for ip in ip_pool:

if check_ip(ip):

valid_ip_pool.append(ip)

return valid_ip_pool

四、完整代码

import requests

import pandas as pd

from bs4 import BeautifulSoup

def get_ip_pool(url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

# 获取代理IP网站的源码

res = requests.get(url, headers=headers)

res.encoding = 'utf-8'

soup = BeautifulSoup(res.text, 'html.parser')

# 获取代理IP信息

table = soup.find('table', {'id': 'ip_list'})

df = pd.read_html(str(table))[0]

# 筛选出有效的代理IP

df = df[(df['类型'].isin(['HTTP', 'HTTPS'])) & (df['存活时间'].str.contains('天') | df['存活时间'].str.contains('小时') | df['存活时间'].str.contains('分钟'))]

# 将DataFrame转换为列表

ip_list = df[['IP地址', '端口号']].values.tolist()

return ip_list

def parse_ip(ip_list):

# 解析代理IP

parsed_ip_list = []

for ip in ip_list:

parsed_ip_list.append(tuple(ip.split(':')))

return parsed_ip_list

def check_ip(ip):

# 检测代理IP可用性

proxies = {

'http': 'http://' + ':'.join(ip),

'https': 'https://' + ':'.join(ip)

}

try:

res = requests.get('https://www.baidu.com', proxies=proxies, timeout=5)

if res.status_code == 200:

return True

else:

return False

except:

return False

def maintain_ip_pool(ip_pool):

# 维护代理IP池

valid_ip_pool = []

for ip in ip_pool:

if check_ip(ip):

valid_ip_pool.append(ip)

return valid_ip_pool

if __name__ == '__main__':

url = 'https://www.zdaye.com'

ip_list = get_ip_pool(url)

parsed_ip_list = parse_ip(ip_list)

valid_ip_pool = maintain_ip_pool(parsed_ip_list)

print(valid_ip_pool)

总结

本文介绍了如何使用Pandas库一键爬取解析代理IP并维护代理IP池。Pandas库是Python中非常强大的数据处理库,可以大大简化数据处理的流程。在实际开发中,我们可以根据实际需求灵活使用Pandas库,提高数据处理效率。