权重量化方面的最新进展使我们能够在消费类硬件上运行大量大型语言模型,例如 RTX 3090 GPU 上的 LLaMA-30B 模型。 这要归功于性能下降最小的新型 4 位量化技术,例如 GPTQ、GGML 和 NF4。

在上一篇文章中,我们介绍了简单的 8 位量化技术和出色的 LLM.int8()。 在本文中,我们将探索流行的 GPTQ 算法,以了解其工作原理并使用 AutoGPTQ 库实现它。

你可以在 Google Colab 和 GitHub 上找到代码。

在线工具推荐: Three.js AI纹理开发包 - YOLO合成数据生成器 - GLTF/GLB在线编辑 - 3D模型格式在线转换 - 可编程3D场景编辑器

1、最优大脑量化

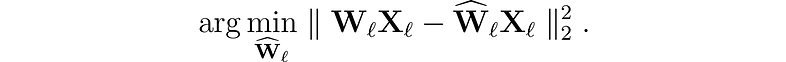

让我们首先介绍我们要解决的问题。 对于网络中的每一层 ℓ,我们希望找到原始权重 Wₗ 的量化版本 Ŵₗ。 这称为分层压缩问题。 更具体地说,为了最大限度地减少性能下降,我们希望这些新权重的输出 (ŴᵨXᵨ) 尽可能接近原始权重 (WᵨXᵨ)。 换句话说,我们想要找到:

人们提出了不同的方法来解决这个问题,但我们对这里的最优大脑量化器(OBQ:Optimal Brain Quantizer)框架感兴趣。

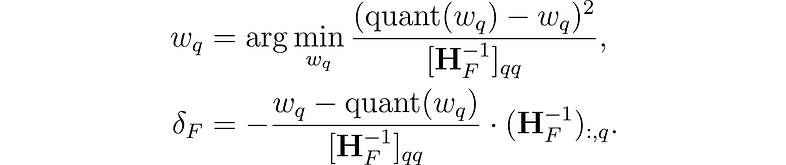

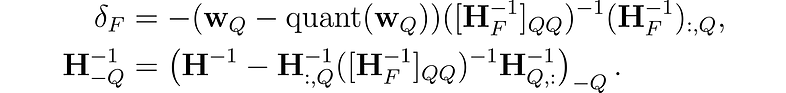

该方法的灵感来自于一种修剪(pruning)技术,该技术可以仔细地从经过充分训练的密集神经网络(最佳脑外科医生)中去除权重。 它使用近似技术,并为要删除的最佳单个权重 w和最佳更新 δ提供显式公式,以调整剩余非量化权重 F 的集合以弥补删除:

其中 quant(w) 是量化给出的权重舍入,H 是 Hessian 矩阵。

使用 OBQ,我们可以首先量化最简单的权重,然后调整所有剩余的非量化权重以补偿这种精度损失。 然后我们选择下一个要量化的权重,依此类推。

这种方法的一个潜在问题是当存在异常权重时,这可能会导致高量化误差。 通常,当剩下很少的非量化权重可以调整以补偿大误差时,这些离群值将最后被量化。 当一些权重因中间更新而被进一步推到网格之外时,这种效果可能会恶化。 应用一个简单的启发式方法来防止这种情况:异常值一出现就被量化。

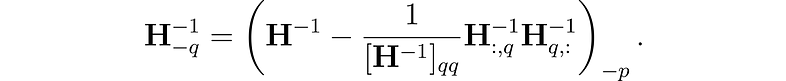

这个过程的计算量可能很大,尤其是对于KKM而言。 为了解决这个问题,OBQ 方法使用了一种技巧,可以避免每次简化权重时都重新进行整个计算。 量化权重后,它通过删除与该权重关联的行和列(使用高斯消除)来调整计算中使用的矩阵(Hessian):

该方法还采用矢量化来一次处理多行权重矩阵。 尽管其效率很高,但 OBQ 的计算时间随着权重矩阵大小的增加而显着增加。 这种立方增长使得在具有数十亿参数的大型模型上使用 OBQ 变得困难。

2、GPTQ 算法

由 Frantar 等人提出,GPTQ 算法从 OBQ 方法中汲取灵感,但进行了重大改进,以将其扩展到(非常)大型语言模型。

第 1 步:任意排序洞察

OBQ 方法按一定的顺序选择权重(模型中的参数)进行量化,所确定的权重将增加最少的附加误差。 然而,GPTQ 观察到,对于大型模型,以任何固定顺序量化权重都可以获得同样的效果。 这是因为,即使某些权重可能会单独引入更多误差,但它们会在过程中稍后进行量化,因为此时几乎没有其他权重可能会增加误差。 所以顺序并不像我们想象的那么重要。

基于这一见解,GPTQ 旨在以相同的顺序量化矩阵所有行的所有权重。 这使得过程更快,因为某些计算只需为每列执行一次,而不是为每个权重执行一次。

第 2 步:惰性批量更新

该方案不会很快,因为它需要更新一个巨大的矩阵,并且每个条目的计算量很少。 此类操作无法充分利用 GPU 的计算能力,并且会因内存限制(内存吞吐量瓶颈)而减慢速度。

为了解决这个问题,GPTQ 引入了“惰性批量”更新。 事实证明,给定列的最终舍入决策仅受对该列执行的更新的影响,而不受后续列上执行的更新的影响。 因此,GPTQ 可以一次将该算法应用于一批列(例如 128 列),仅更新这些列和矩阵的相应块。 完全处理一个块后,算法对整个矩阵执行全局更新。

步骤 3:Cholesky 重构

然而,还有一个问题需要解决。 当算法扩展到非常大的模型时,数值不准确可能会成为一个问题。 具体来说,重复应用某个运算可能会累积数值误差。

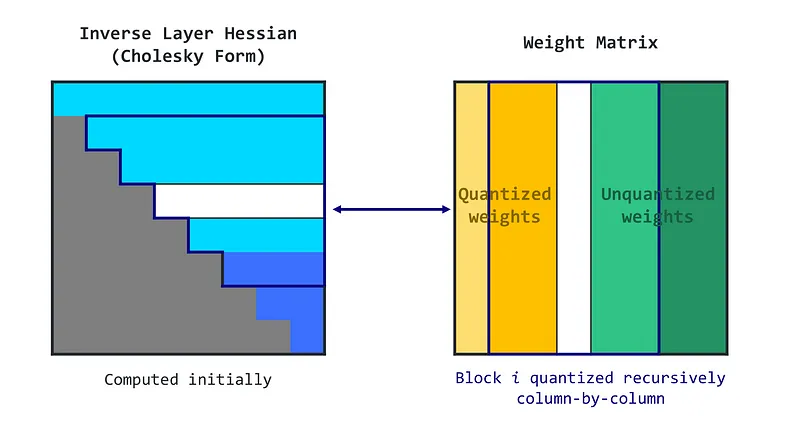

为了解决这个问题,GPTQ 使用 Cholesky 分解,这是一种用于解决某些数学问题的数值稳定方法。 它涉及使用 Cholesky 方法从矩阵中预先计算一些所需的信息。 这种方法与轻微的“阻尼”(向矩阵的对角元素添加一个小常数)相结合,有助于算法避免数值问题。

完整的算法可以概括为以下几个步骤:

- GPTQ 算法从 Hessian 逆矩阵(帮助决定如何调整权重的矩阵)的 Cholesky 分解开始

- 然后它循环运行,一次处理一批列。

- 对于批次中的每一列,它都会量化权重,计算误差,并相应地更新块中的权重。

- 处理完该批次后,它会根据块的错误更新所有剩余的权重。

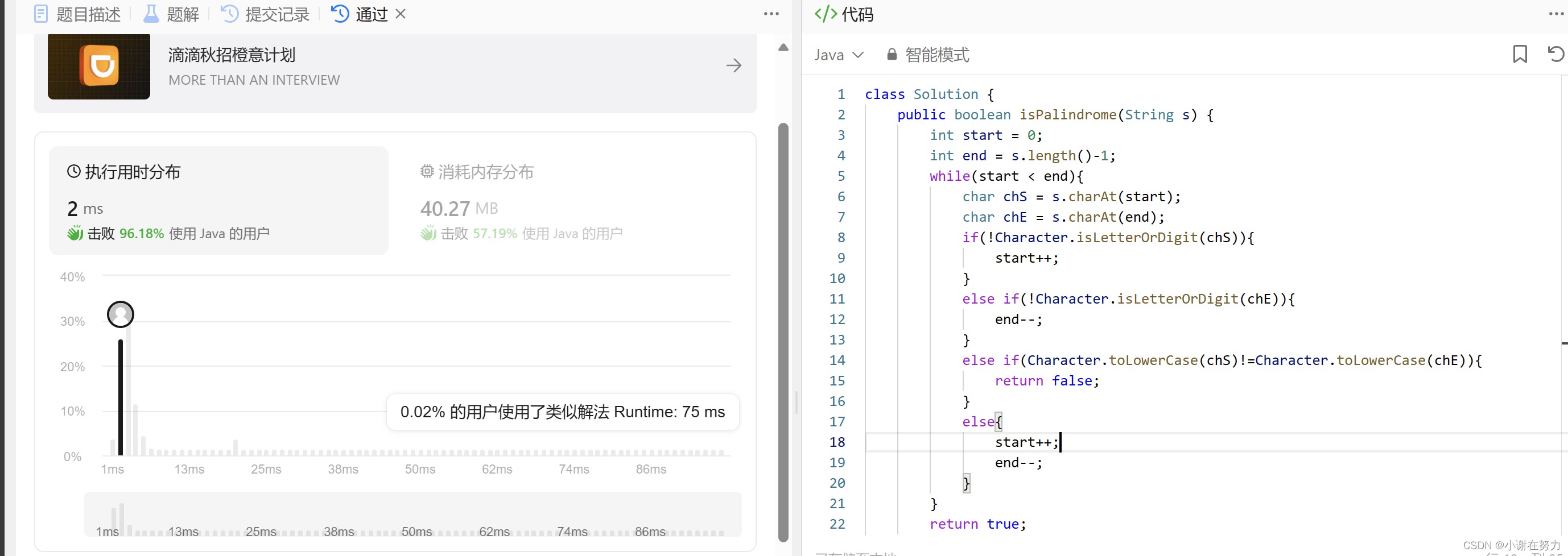

GPTQ 算法在各种语言生成任务上进行了测试。 它与其他量化方法进行了比较,例如将所有权重四舍五入到最接近的量化值(RTN)。 GPTQ 与 BLOOM(176B 参数)和 OPT(175B 参数)模型系列一起使用,并使用单个 NVIDIA A100 GPU 对模型进行量化。

3、使用 AutoGPTQ 量化 LLM

GPTQ 在创建可在 GPU 上高效运行的 4 位精度模型方面非常流行。 你可以在 Hugging Face Hub 上找到许多示例,尤其是来自 TheBloke 的示例。 如果你正在寻找一种对 CPU 更友好的方法,GGML 目前是你的最佳选择。 最后,带有 bitsandbytes 的 Transformer 库允许你在使用 load_in_4bit=true 参数加载模型时对其进行量化,这需要下载完整模型并将其存储在 RAM 中。

让我们使用 AutoGPTQ 库实现 GPTQ 算法并量化 GPT-2 模型。 这需要 GPU,但 Google Colab 上的免费 T4 就可以了。 我们首先加载库并定义我们想要量化的模型(在本例中为 GPT-2)。

!BUILD_CUDA_EXT=0 pip install -q auto-gptq transformersimport random

from auto_gptq import AutoGPTQForCausalLM, BaseQuantizeConfig

from datasets import load_dataset

import torch

from transformers import AutoTokenizer

# Define base model and output directory

model_id = "gpt2"

out_dir = model_id + "-GPTQ"我们现在要加载模型和分词器。 分词器是使用 Transformers 库中的经典 AutoTokenizer 类加载的。 另一方面,我们需要传递特定的配置(BaseQuantizeConfig)来加载模型。

在此配置中,我们可以指定要量化的位数(此处,bits=4)和组大小(惰性批次的大小)。 请注意,该组大小是可选的:我们还可以对整个权重矩阵使用一组参数。 在实践中,这些组通常以非常低的成本提高量化质量(特别是在 group_size=1024 的情况下)。 此处的 hum_percent 值用于帮助 Cholesky 重新公式化,不应更改。

最后,desc_act(也称为行为顺序)是一个棘手的参数。 它允许你根据减少的激活来处理行,这意味着首先处理最重要或最有影响力的行(由采样的输入和输出确定)。 该方法旨在将大部分量化误差(在量化过程中不可避免地引入)置于不太重要的权重上。 这种方法通过确保以更高的精度处理最重要的权重,提高了量化过程的整体准确性。 然而,当与组大小一起使用时,由于需要频繁重新加载量化参数,desc_act 可能会导致性能下降。 因此,我们不会在这里使用它(但是将来可能会修复它)。

# Load quantize config, model and tokenizer

quantize_config = BaseQuantizeConfig(

bits=4,

group_size=128,

damp_percent=0.01,

desc_act=False,

)

model = AutoGPTQForCausalLM.from_pretrained(model_id, quantize_config)

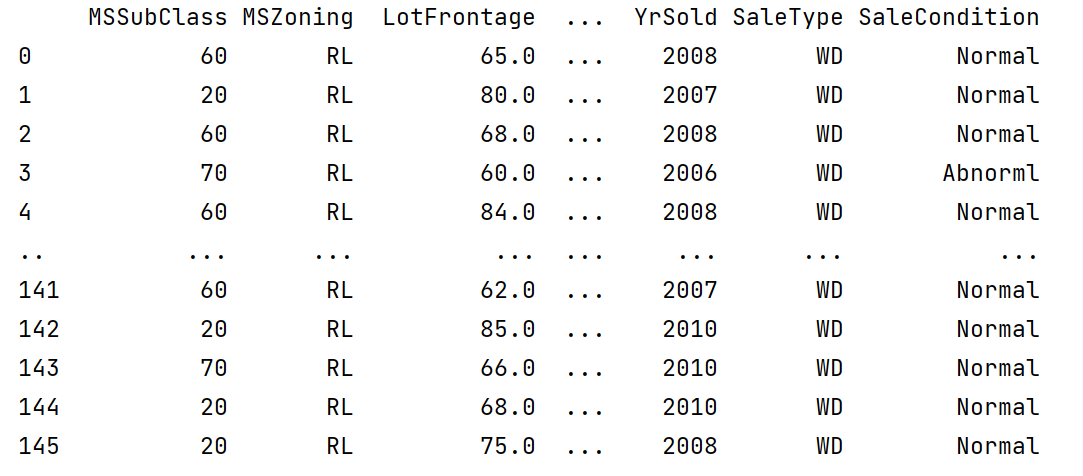

tokenizer = AutoTokenizer.from_pretrained(model_id)量化过程很大程度上依赖于样本来评估和提高量化质量。 它们提供了一种比较原始模型和新量化模型产生的输出的方法。 提供的样本数量越多,进行更准确和有效比较的潜力就越大,从而提高量化质量。

在本文中,我们利用 C4(Colossal Clean Crawled Corpus)数据集来生成样本。 C4 数据集是从 Common Crawl 项目收集的大规模、多语言的网络文本集合。 这个庞大的数据集经过专门清理和准备,用于训练大规模语言模型,使其成为此类任务的重要资源。 维基文本数据集是另一个流行的选择。

在下面的代码块中,我们从 C4 数据集中加载 1024 个样本,对它们进行标记并格式化。

# Load data and tokenize examples

n_samples = 1024

data = load_dataset("allenai/c4", data_files="en/c4-train.00001-of-01024.json.gz", split=f"train[:{n_samples*5}]")

tokenized_data = tokenizer("\n\n".join(data['text']), return_tensors='pt')

# Format tokenized examples

examples_ids = []

for _ in range(n_samples):

i = random.randint(0, tokenized_data.input_ids.shape[1] - tokenizer.model_max_length - 1)

j = i + tokenizer.model_max_length

input_ids = tokenized_data.input_ids[:, i:j]

attention_mask = torch.ones_like(input_ids)

examples_ids.append({'input_ids': input_ids, 'attention_mask': attention_mask})现在数据集已准备就绪,我们可以开始批大小为 1 的量化过程。我们还可以选择使用 OpenAI Triton(CUDA 的替代方案)与 GPU 进行通信。 完成此操作后,我们将分词器和模型保存为安全张量格式。

# Quantize with GPTQ

model.quantize(

examples_ids,

batch_size=1,

use_triton=True,

)

# Save model and tokenizer

model.save_quantized(out_dir, use_safetensors=True)

tokenizer.save_pretrained(out_dir)像往常一样,然后可以使用 AutoGPTQForCausalLM 和 AutoTokenizer 类从输出目录加载模型和标记生成器。

device = "cuda:0" if torch.cuda.is_available() else "cpu"

# Reload model and tokenizer

model = AutoGPTQForCausalLM.from_quantized(

out_dir,

device=device,

use_triton=True,

use_safetensors=True,

)

tokenizer = AutoTokenizer.from_pretrained(out_dir)让我们检查一下模型是否正常工作。 AutoGPTQ 模型(大部分)作为普通transformer模型工作,这使得它与推理管道兼容,如以下示例所示:

from transformers import pipeline

generator = pipeline('text-generation', model=model, tokenizer=tokenizer)

result = generator("I have a dream", do_sample=True, max_length=50)[0]['generated_text']

print(result)I have a dream," she told CNN last week. "I have this dream of helping my mother find her own. But, to tell that for the first time, now that I'm seeing my mother now, just knowing how wonderful it is that我们成功地从量化的 GPT-2 模型中获得了令人信服的完成结果。 更深入的评估需要测量量化模型与原始模型的复杂度。 但是,我们将其排除在本文的讨论范围之外。

4、结束语

在本文中,我们介绍了 GPTQ 算法,这是一种在消费级硬件上运行 LLM 的最先进的量化技术。 我们展示了它如何基于具有任意顺序洞察、惰性批量更新和 Cholesky 重构的改进 OBS 技术来解决分层压缩问题。 这种新颖的方法显着降低了内存和计算需求,使LLM可供更广泛的受众使用。

此外,我们在免费的 T4 GPU 上量化了我们自己的 LLM 模型,并运行它来生成文本。 你可以在 Hugging Face Hub 上推送自己的 GPTQ 4 位量化模型版本。 正如简介中提到的,GPTQ 并不是唯一的 4 位量化算法:GGML 和 NF4 都是优秀的替代方案,但范围略有不同。 我鼓励你更多地了解它们并尝试一下!

原文链接:GPTQ 4位量化实战 - BimAnt