Resnet

在深度学习领域,卷积神经网络(CNN)是一种非常重要的模型,它在图像识别、目标检测等领域取得了显著的成果。然而,随着网络层数的增加,梯度消失和梯度爆炸问题变得越来越严重,导致训练深层网络变得非常困难。为了解决这个问题,研究人员提出了残差网络(ResNet),通过引入残差模块,使得深度网络的训练变得更加容易。本文将详细介绍ResNet网络的原理、实现以及应用。

我的pytorch代码实现:Resnet

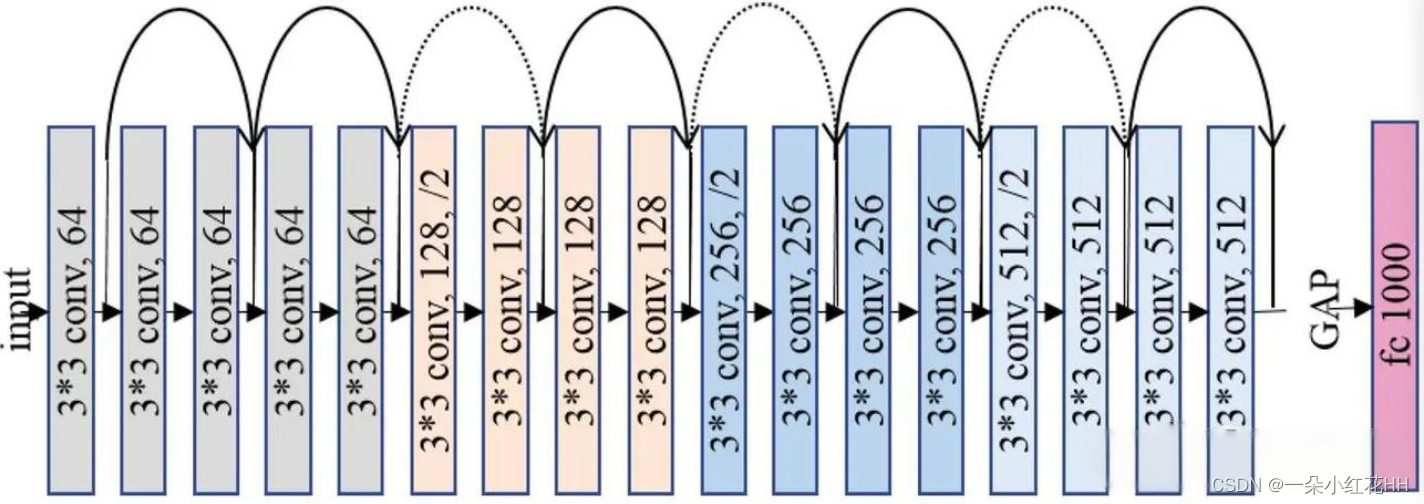

ResNet网络原理

- 残差模块

ResNet的核心思想是引入残差模块(Residual Block),每个残差模块包含两个或多个卷积层。残差模块的输入和输出之间存在一个恒等映射关系,即:

F(x) = H(x) + x

其中,F(x)表示残差模块的输出,H(x)表示卷积层的输出,x表示输入。这种恒等映射关系使得深层网络的训练变得更加容易。 - 跳跃连接

为了进一步解决梯度消失和梯度爆炸问题,ResNet采用了跳跃连接(Skip Connection)的方式。跳跃连接是指将前面若干层的输出直接连接到后面的层,这样可以帮助梯度更快地传播到更深的层次。 - 深度可分离卷积

为了减少计算量和参数数量,ResNet采用了深度可分离卷积(Depthwise Separable Convolution)。深度可分离卷积将标准的卷积分解为逐深度卷积(Depthwise Convolution)和逐点卷积(Pointwise Convolution),从而降低了计算复杂度。

ResNet网络实现

- 定义残差模块(Residual Block)

class ResidualBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1):

super(ResidualBlock, self).__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, stride=stride, padding=1, bias=False)

self.bn1 = nn.BatchNorm2d(out_channels)

self.relu = nn.ReLU(inplace=True)

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, stride=1, padding=1, bias=False)

self.bn2 = nn.BatchNorm2d(out_channels)

self.shortcut = nn.Sequential()

if stride != 1 or in_channels != out_channels:

self.shortcut = nn.Sequential(

nn.Conv2d(in_channels, out_channels, kernel_size=1, stride=stride, bias=False),

nn.BatchNorm2d(out_channels)

)

def forward(self, x):

out = self.relu(self.bn1(self.conv1(x)))

out = self.bn2(self.conv2(out))

out += self.shortcut(x)

out = self.relu(out)

return out

- 定义ResNet网络结构

class ResNet(nn.Module):

def __init__(self, block, num_blocks, num_classes=1000):

super(ResNet, self).__init__()

self.in_channels = 64

self.conv1 = nn.Conv2d(3, 64, kernel_size=7, stride=2, padding=3, bias=False)

self.bn1 = nn.BatchNorm2d(64)

self.relu = nn.ReLU(inplace=True)

self.maxpool = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

self.layer1 = self._make_layer(block, 64, num_blocks[0], stride=1)

self.layer2 = self._make_layer(block, 128, num_blocks[1], stride=2)

self.layer3 = self._make_layer(block, 256, num_blocks[2], stride=2)

self.layer4 = self._make_layer(block, 512, num_blocks[3], stride=2)

self.avgpool = nn.AdaptiveAvgPool2d((1, 1))

self.fc = nn.Linear(512 * block.expansion, num_classes)

def _make_layer(self, block, out_channels, num_blocks, stride):

strides = [stride] + [1] * (num_blocks - 1)

layers = []

for stride in strides:

layers.append(block(self.in_channels, out_channels, stride))

self.in_channels = out_channels * block.expansion

return nn.Sequential(*layers)

def forward(self, x):

out = self.relu(self.bn1(self.conv1(x)))

out = self.maxpool(out)

out = self.layer1(out)

out = self.layer2(out)

out = self.layer3(out)

out = self.layer4(out)

out = self.avgpool(out)

out = torch.flatten(out, 1)

out = self.fc(out)

return out

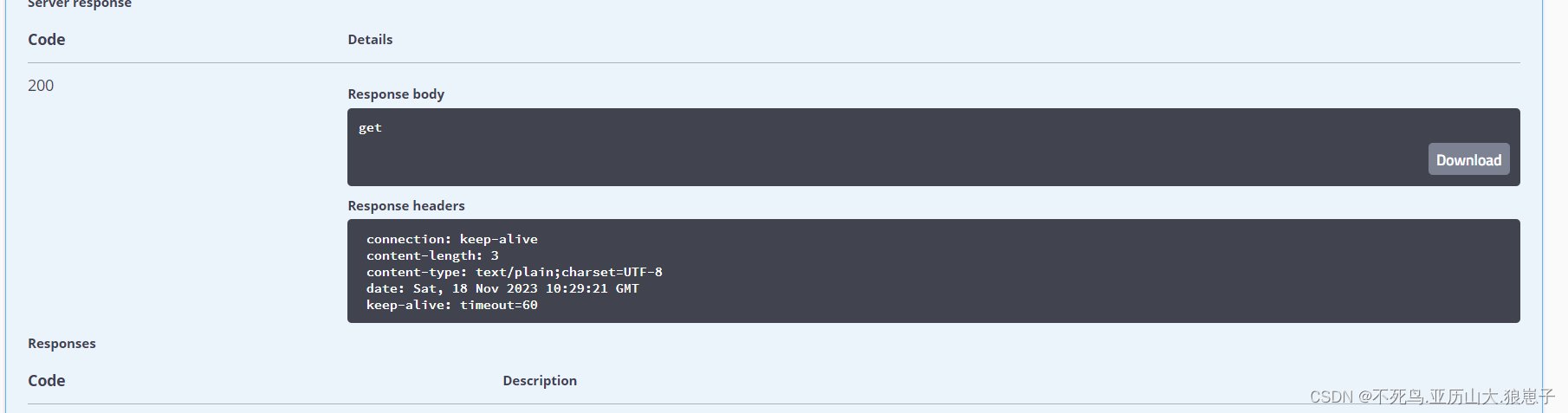

ResNet网络应用

ResNet网络在许多计算机视觉任务中都取得了优异的性能,例如图像分类、物体检测和语义分割等。

我们在vgg16神经网络上训练了SIGNS数据集,这是一个分类的数据集,在我的github上有介绍怎么下载数据集以及如何训练。