文章目录

- LDA主题数

- 困惑度

- 1.概率分布的困惑度

- 2.概率模型的困惑度

- 3.每个分词的困惑度

LDA主题数

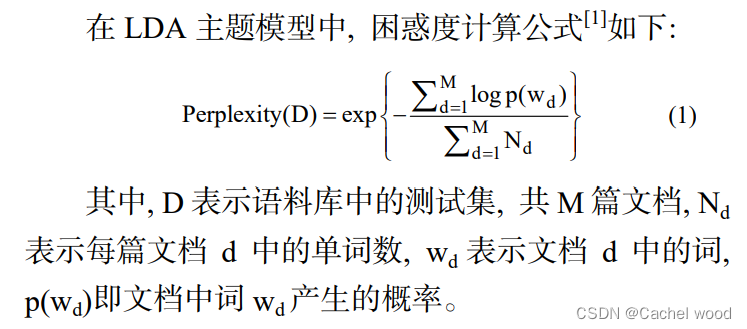

LDA作为一种无监督学习方法,类似于k-means聚类算法,需要给定超参数主题数K,但如何评价主题数的优劣并无定论,一般采取人为干预、主题困惑度preplexing和主题一致性得分coherence score,本文介绍困惑度。

困惑度

在信息论中,perplexity(困惑度)用来度量一个概率分布或概率模型预测样本的好坏程度。它也可以用来比较两个概率分布或概率模型。低困惑度的概率分布模型或概率模型能更好地预测样本。

1.概率分布的困惑度

定义离散概率分布的困惑度如下:

2

H

(

p

)

=

2

−

∑

x

p

(

x

)

log

2

p

(

x

)

2^{H(p)} = 2^{-\sum_x p(x) \log_2 p(x)}

2H(p)=2−∑xp(x)log2p(x)

其中H§是概率分布p的熵,x是样本点。因此一个随机变量X的困惑度是定义在X的概率分布上的(X所有"可能"取值为x的部分)。

一个特殊的例子是k面均匀骰子的概率分布,它的困惑度恰好是k。一个拥有k困惑度的随机变量有着和k面均匀骰子一样多的不确定性,并且可以说该随机变量有着k个困惑度的取值(k-ways perplexed)。(在有限样本空间离散随机变量的概率分布中,均匀分布有着最大的熵)

困惑度是信息熵的指数。

2.概率模型的困惑度

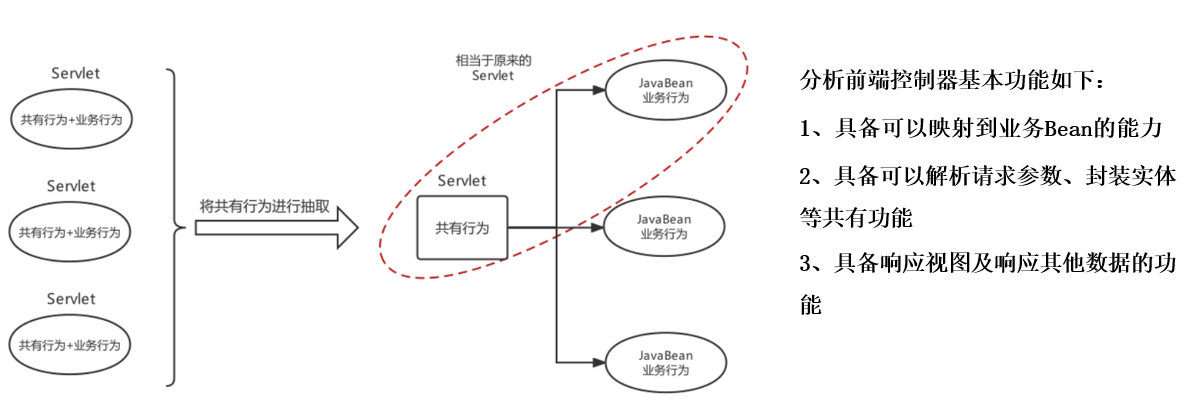

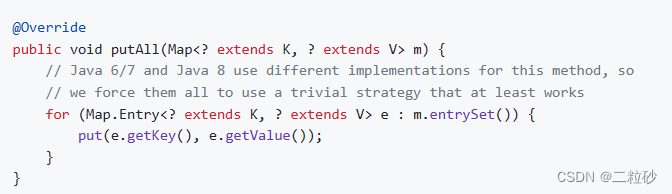

用一个概率模型q去估计真实概率分布p,那么可以通过测试集中的样本来定义这个概率模型的困惑度。

b

−

1

N

∑

i

=

1

N

log

b

q

(

x

i

)

b^{-\frac{1}{N}\sum_{i=1}^N \log_b q(x_i)}

b−N1∑i=1Nlogbq(xi)

其中测试样本 x 1 , x 2 , … , x N x_1, x_2, …, x_N x1,x2,…,xN是来自于真实概率分布p的观测值,b通常取2。因此,低的困惑度表示q对p拟合的越好,当模型q看到测试样本时,它不会“感到”那么“困惑”。

我们指出,指数部分是交叉熵。

H

(

p

^

,

q

)

=

−

∑

x

p

^

(

x

)

log

2

q

(

x

)

H(\hat{p},q) ={-\sum_x\hat{p}(x) \log_2 q(x)}

H(p^,q)=−x∑p^(x)log2q(x)

其中

p

^

\hat{p}

p^表示我们对真实分布下样本点x出现概率的估计。比如用

p

(

x

)

=

n

/

N

p(x)=n/N

p(x)=n/N

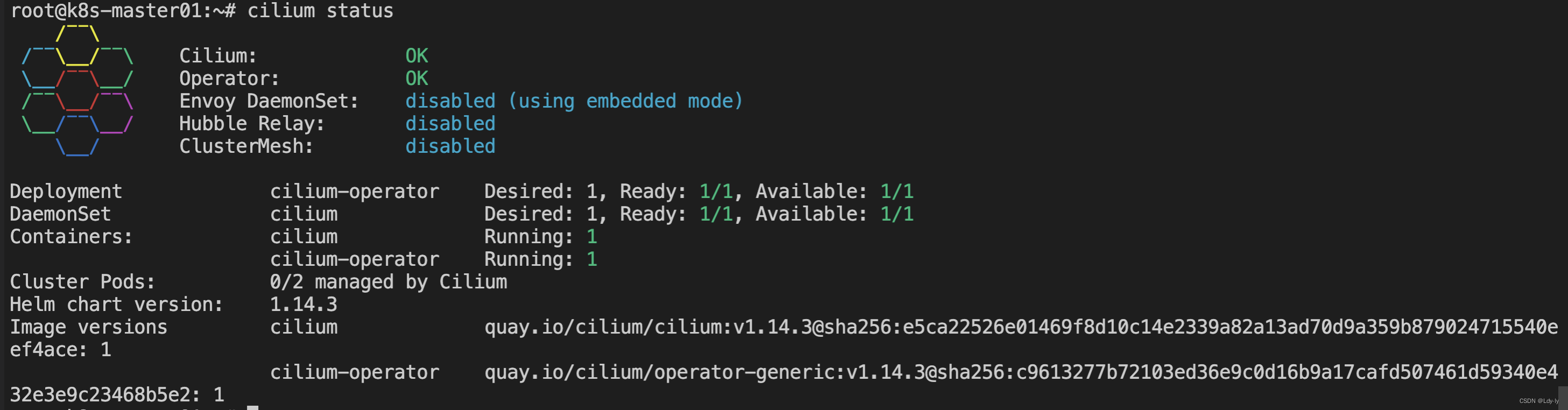

3.每个分词的困惑度

在自然语言处理中,困惑度是用来衡量语言概率模型优劣的一个方法。一个语言概率模型可以看成是在整个句子或者文段上的概率分布。

![[mysql]索引优化-2](https://img-blog.csdnimg.cn/c38ec557f8d241ab88c9d02a9c59b22e.png)