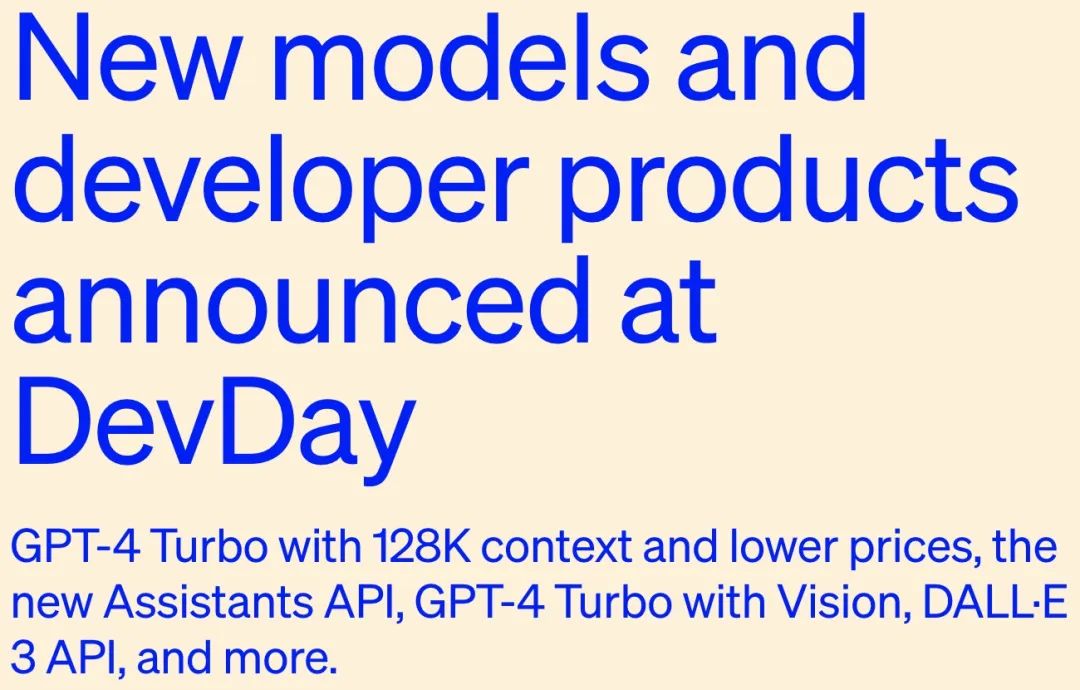

2023年11月7日,OpenAI开发者大会带来一些列功能更新以及更低的API价格:

- GPT-4升级了 GPT-4 Turbo,性能更强,价格更低,重磅支持128K上下文;

- 新的Assistants API使开发人员更容易构建自己的辅助人工智能应用程序,这些应用程序具有目标并可以调用模型和工具;

- 平台新增了多模态功能,包括视觉、图像创建(DALL·E 3)和文本到语音(TTS)

更多可以参考:https://openai.com/blog/introducing-gpts

支持128K上下文的GPT-4 Turbo

OpenAI在今年3月份发布了GPT-4的第一个版本,并在7月份向所有开发人员提供了GPT-4。今天又将推出下一代GPT-4 Turbo的预览版(https://platform.openai.com/docs/models/gpt-4-and-gpt-4-turbo)。

GPT-4 Turbo支持128K的上下文窗口,因此在一个提示中可以容纳相当于300多页文本的内容,并且预训练数据已经更新到2023年4月。价格也便宜了不少,输入便宜了3倍,输出便宜了2倍。

所有付费开发人员通过调用GPT-4-1106-preview API来调用GPT-4 Turbo,OpenAI在未来几周内会发布稳定适合生产环境模型。

函数调用更新

OpenAI发布了多项函数调用功能更新,包括在一条消息中调用多个功能的能力,用户可以发送一条消息请求多个操作,例如“打开车窗并关闭空调”,这在以前需要与模型进行多次往返,还在提高函数调用的准确性,GPT-4 Turbo更有可能返回正确的函数参数。

指令跟随和JSON模式更新

GPT-4 Turbo在需要仔细遵循指令的任务上比以前的型号表现得更好,例如生成特定格式(例如,“始终以XML输出”),还支持我们新的JSON模式(https://platform.openai.com/docs/guides/text-generation/json-mode),该模式确保模型将响应有效的JSON。新的API参数response_format使模型能够约束其输出,以生成语法正确的JSON对象。JSON模式对于开发人员在函数调用之外的Chat Complexions API中生成JSON非常有用。

输出可复现和对数概率

新的seed参数可以让模型在大多数时间返回一致的完成,实现可重复的输出,该功能对于程序debugging、单元测试以及对模型更高程度控制非常有用。据OpenAI爆料,他们内部也在使用该功能进行单元测试,发现非常好用,更多可以参考:https://platform.openai.com/docs/guides/text-generation/reproducible-outputs

在未来几周后,OpenAI计划推出一项功能,该功能会返回GPT-4 Turbo和GPT-3.5 Turbo输出最可能生成tokens的对数概率,该功能将有助于构建搜索体验中的自动完成等功能。

GPT-3.5 Turbo更新

此次发布会除了GPT-4 Turbo,还发布了GPT-3.5 Turbo的新版本,默认情况下支持16K上下文窗口。新的3.5 Turbo支持改进的指令跟随、JSON模式和并行函数调用。OpenAI内部评估显示,在格式跟踪任务(如生成JSON、XML和YAML)上有38%的改进。开发者可以在API中调用gpt-3.5-turbo-1106来使用该新模型,之前使用gpt-3.5-turbo名称的应用程序将于12月11日自动升级为该新模型。在2024年6月13日之前,老模型可以通过gpt-3.5-turbo-0613继续调用使用(更多可以参考:https://platform.openai.com/docs/models/gpt-3-5)。

Assistants API, 检索和代码解释器

OpenAI发布的Assistants API(https://platform.openai.com/docs/assistants/overview)将帮助开发人员在自己的应用程序中构建AI助手(比如agent),包括指令,可以利用额外的知识,调用模型和工具来执行用户响应。新的Assistants API又新增了代码解释器和检索以及函数调用等功能,可以帮助处理大量重复的工作。

Assistants API支持包括基于自然语言的数据分析应用程序、编码助手、人工智能度假计划器、语音控制DJ、智能视觉canvas等功能。Assistants API还引入了一个关键变化是持久和无限长的线程,这允许开发人员将线程状态管理交给OpenAI,并围绕上下文窗口约束进行工作。使用Assistants API,只需将每个新消息添加到现有线程中。

下面介绍一下Assistants API的新工具,包括:

代码解释器:在沙盒执行环境中可以编写和运行Python代码,可以生成图形和图表,也可以处理不同数据和格式的文件。代码解释器允许助手迭代运行代码,这可以解决具有挑战性的代码和数学问题;

检索:具有RAG功能,可以利用大模型之外的知识,比如专有领域数据、产品信息或用户提供的文档,以增强助手的能力。但是,与传统RAG不同,Assistants API既不需要为文档计算和存储嵌入,也不需要实现分块和搜索算法,Assistants API根据ChatGPT中构建知识检索的经验,优化了要使用的检索技术;

函数调用:使Assistants API能够调用用户自定义函数,并将函数响应结果加入到在其消息中。

PS:OpenAI承诺开发者传递到OpenAI API的数据和文件永远不会用于训练模型,用户可以随时随地删除数据(具体可以参考:https://openai.com/enterprise-privacy)。

Assistants API可以在Assistants playground中尝试,参考视频如下:https://cdn.openai.com/new-models-and-developer-products-announced-at-devday/assistants-playground.mp4

带视觉功能的GPT-4 Turbo

GPT-4 Turbo可以接受图像作为聊天完成API中的输入,从而实现生成字幕、详细分析真实世界图像以及阅读带数字的文档等用例。例如,BeMyEyes使用这项技术帮助盲人或视力低下的人完成日常任务,如识别产品或浏览商店。开发人员可以在API中尝试使用gpt-4-vision-preview模型来访问此功能。OpenAI计划在GPT-4 Turbo正式发布时,将视觉功能集成到里面,定价取决于输入图像的大小,例如,将1080×1080像素的图像传递给GPT-4 Turbo需要0.00765美元(具体可以参考:https://platform.openai.com/docs/guides/vision)。

DALL·E 3

开发人员可以通过API将文本生成图像模型DALL·E 3 直接集成到应用程序和产品中,价格从每张图像0.04美元起。与DALL·E的前一版本类似,API内置了审核功能,以帮助开发人员保护其应用程序免受滥用。Snap、可口可乐和Shutterstock等公司已使用DALL·E 3以编程方式为其客户和活动生成图像和设计。(DALL·E 3介绍可以参考:https://platform.openai.com/docs/guides/images)

文本到语音(TTS)

开发人员现在可以通过文本到语音 API生成高质量的语音。OpenAI最新的TTS模型提供了六种预设语音可供选择,以及两种模型变体TTS-1和TTS-1-hd。tts在实时方面进行了优化,tts-1-hd针对质量进行了优化。价格从每输入1000个字符0.015美元起。(具体可以参考:https://platform.openai.com/docs/guides/text-to-speech)

模型定制化

微调GPT-4

现在,GPT-4 微调正在实验访问阶段。OpenAI 正在创建一个用于 GPT-4 微调的实验性访问程序。不过与 GPT-3.5 微调获得的实质收益相比,GPT-4 微调需要更多工作才能对基础模型实现有意义的改进。

未来,随着 GPT-4 微调在质量和安全性方面得到提升,GPT-3.5 微调的活跃使用者可以选择在他们的微调控制中心应用 GPT-4 程序。(具体可以参考:https://platform.openai.com/finetune)

自定义模型

在微调之外,对于那些需要更多定制化功能的组织机构(特别适用于拥有超大专有数据集的领域——至少有数十亿个tokens),OpenAI 启动了自定义模型(Custom Models)计划,允许组织机构与 OpenAI 研究人员一起针对特定领域来训练定制化 GPT-4。这包括修改模型训练过程的每一步,从额外的领域特定预训练到运行针对特定领域的定制化 RL 训练后(post-training)过程。组织机构对其定制化模型拥有独家访问权。OpenAI 不会提供给其他客户或与其他客户共享,也不会用于训练其他模型。此外提供给 OpenAI 以训练定制化模型的专有数据不会在其他上下文中重复使用。不过,OpenAI 表示,目前自定义模型的功能有限且成本高昂。(需要定制化的用户可以参考:https://openai.com/form/custom-models)

更低的价格

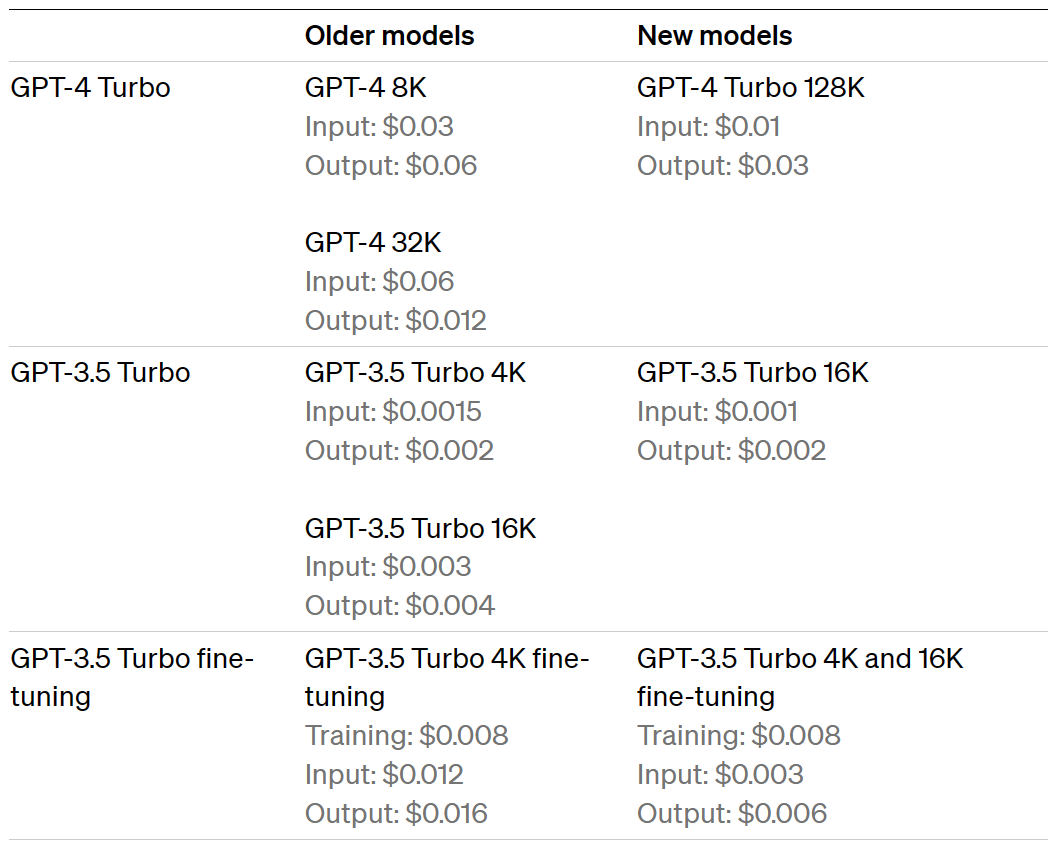

OpenAI在整个平台上降低了几个价格,以将节省的费用转嫁给开发商(以下所有价格均以每1000个代币表示):

- GPT-4 Turbo输入tokens比GPT-4便宜3倍,售价0.01美元,输出tokens便宜2倍,售价0.03美元。

- GPT-3.5 Turbo输入tokens比之前的16K模型便宜3倍,售价0.001美元,输出tokens便宜2倍,售价0.002美元。以前使用GPT-3.5 Turbo 4K的开发者可以从0.001美元的输入tokens上获得33%的折扣。这些较低的价格仅适用于今天推出的新款GPT-3.5 Turbo。

- 微调后的GPT-3.5 Turbo 4K模型输入tokens在0.003美元时减少了4倍,输出tokens在0.006美元时便宜了2.7倍。微调还支持16K上下文,价格与新GPT-3.5 Turbo模型的4K相同。这些新价格也适用于微调的gpt-3.5-turbo-0613模型。

参考文献:

[1] https://openai.com/blog/new-models-and-developer-products-announced-at-devday