Spark 基础

本文来自 B站 黑马程序员 - Spark教程 :原地址

什么是Spark

什么是Spark 1.1

定义:Apache Spark是用于大规模数据(large-scala data)处理的统一(unified)分析引擎

Spark最早源于一篇论文 Resilient Distributed Datasets:A Fault-Tolerant Abstraction for In-Memory Cluster Computing,该论文是由加州大学柏克莱分校的Matei Zaharia 等人发表的。论文中提出了一种弹性分布式数据集(即RDD)的概念。

翻译过来:RDD是一种分布式内存抽象,其使得程序员能够在大规模集群中做内存运算,并且有一定的容错方式。而这也是整个Spark的核心数据结构,Spark整个平台都围绕着RDD进行。

什么是Spark 1.2

定义:Apache Spark是用于大规模数据(large-scala data)处理的统一(unified)分析引擎

简而言之,Spark借鉴了MapReduce 思想发展而来,保留了其分布式并行计算的优点并改进了其明显的缺陷,让中间数据存储在内存中提高了运行速度,并提供丰富的操作数据的API提高了开发速度。

什么是Spark 1.3

统一分析引擎?

Spark是一款分布式内存计算的统一分析引擎。

其特点就是对任意类型的数据进行自定义计算。

Spark可以计算:结构化,半结构化,非结构化等各种类型的数据结构,同时也支持使用Python,java,Scala,R以及SQL语言去开发应用程序计算数据。

Spark的适用面非常广泛,所以,被称之为统一的(适用面广)的分析引擎(数据处理)

Spark 历史

Spark 历史 1.1

Spark 是加州大学伯克分校AMP实验室(Algorithms Machines and People Lab)开发的通用大数据处理框架

Spark的发展历史,经历过几大重要阶段,如下图所示:

Spark 历史 1.2

Stack Overflow的数据可以看出,2015年开发Spark每月的问题提交数量已经超越Hadoop,而2018年Spark Python版本的API PySpark每月的问题提交数量也已超过Hadoop。2019年排名Spark第一,PySpark第二,而十年的累计排名是Spark第一,PySpark第三。按照这个趋势发展下去,Spark和PySpark在未来很长的一段时间内应该还会处于垄断地位。

Spark 历史 1.3

十年走来,Spark目前已经迭代到了3.2.0版本(2021.10.13发布)

Spark VS Hadoop(MapReduce)

Spark VS Hadoop(MapReduce) 1.1

Spark和前面学习的Hadoop技术栈有何区别呢?

| Hadoop | Spark | |

|---|---|---|

| 类型 | 基础平台,包含计算,存储,调试 | 纯计算工具(分布式) |

| 场景 | 海量数据批处理(磁盘迭代计算) | 海量数据的批处理(内存迭代计算,交互式计算),海量数据流计算 |

| 价格 | 对机器要求低,便宜 | 对内存有要求,相对较贵 |

| 编程范式 | Map+Reduce,API较为底层,算法适应性差 | Rdd组成Dag有向无环图,API较为顶层,方便使用 |

| 数据存储结构 | MapReduce中间计算结果在HDFS磁盘上,延迟大 | RDD中间运算结果在内存中,延迟小 |

| 运行方式 | Task以进程方式维护,任务启动慢 | Task以线程方式维护,任务启动快,可批量创建提高并行能力 |

尽管Spark相对于Hadoop而言具有较大优势,但Spark并不能完全替代Hadoop

- 在计算层面,Spark相比较MR(MapReduce)有巨大的性能优势,但至今仍有许多计算工具基于MR构架,比如非常成熟的Hive

- Spark仅做计算,而Hadoop生态圈不仅有计算(MR)也有存储(HDFS)和资源管理调试(Yarn),HDFS和Yarn仍是许多大数据体系的核心架构

Spark VS Hadoop(MapReduce) 1.2

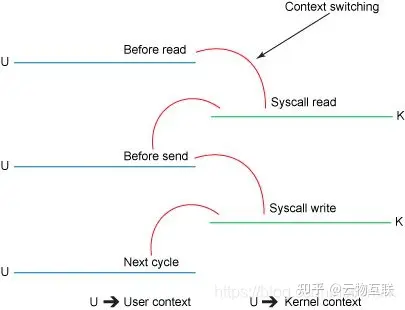

面试题:Hadoop的基于进程的计算和Spark基于线程方式优缺点?

答案:Hadoop中的MR中每个map/reduce task都是一个java进程方式运行,好处在于进程之间是相互独立的,每个task独享进程资源,没有互相干扰,监控方便,但是问题在于task之前不方便共享数据,执行效率比较低。比如多个map task读取不同数据源文件需要将数据源加载到每个map task中,造成重复加载和浪费内存。而基于线程的方式计算是为了数据共享和提高执行效率,Spark采用线程的最小执行单位,但缺点是线程之间会有资源竞争。

线程的基本概念

- 线程是cpu的基本调度单位

- 一个进程一般包含多个线程,一个进程下的多个线程共享进程的资源

- 不同进程之间的线程相互不可见

- 线程不能独立执行

- 一个线程可以创建和撤销另外一个线程

Spark 四大特点

速度快

由于Apache Spark 支持内存计算,并且通过DAG(有向无环图)执行引擎支持无环数据流,所以官方宣称其在内存中的运行速度比Hadoop的Map Reduce快100倍,在硬盘中要快10倍。

Spark处理数据与MapReduce处理数据相比,有如下两个不同点:

- 其一 spark处理数据时,可以将中间处理的结果数据存储到内存中

- 其二 spark提供了非常丰富的算子(API),可以做到复杂任务在一个Spark程序中完成。

易于使用

spark 的版本已经更新到 spark 3.2.0 (截止日期2021.10.13),支持包括java, scala, python, R和sql语言在内的多种语言,为了兼容spark2.x 企业级应用场景,spark 仍然持续更新 spark2 版本

通用性强

在spark 的基础上,spark还提供了包括spark sql, spark streaming, Mlib及GraphX在内的多个工具库,我们可以在一个应用中无缝地使用这些工具库。

运行方式

spark 支持多种运行方式,包含在hadoop 和Mesos上,也支持Standalone的独立运行模式,同时也可以运行在云Kubernetes (Spark 2.3开始支持)上。

对于数据源而言,spark支持从HDFS, HBase, Cassandra及 Kafka等多种途径获取数据。

Spark 框架模块-了解

整个Spark框架模块包含:spark Core, spark SQL, Spark Streaming, Spark GraphX, Spark Mlib,而后四项的能力都是建立在核心引擎之上

Spark Core: Spark的核心,Spark核心功能均由Spark core模块提供,是Spark运行的基础,Spark Core以RDD为数据抽象,提供Python,java,scala, R 语言的API,可以编程进行海量离线数据批处理计算。

SparkSQL:基于SparkCore之上,提供结构化数据的处理模块,SparkSql支持以Sql语言对数据进行处理,SparkSql本身针对离线计算场景。同时基于SparkSql,Spark提供了StructuredStreaming模块,可以以SparkSql为基础,进行数据的流式计算。

SparkStreaming:以SparkCore为基础,提供数据的流式计算功能

MlIib:以sparkcore 为基础,进行机器学习计算,内置了大量的机器学习库和API算法等。方便用户以分布式计算的模式进行机器学习计算。

GraphX:以SparkCore为基础,进行图计算,提供了大量的图计算API, 方便用于以分布式计算模式进行图计算。

Spark 运行模式-了解

spark 提供了多种运行模式,包括:

-

本地模式(单机)

本地模式就是以一个独立的进程,通过其内部的多个线程来模拟整个spark运行时环境

-

Standalone模式(集群)

spark中的各个角色以独立进程的形式存在,并组成spark集群环境

-

Hadoop Yarn模式(集群)

spark中的各个角色运行在yarn的容器内部,并组成spark集群环境

-

Kubernetes模式(容器集群)

spark中的各个角色运行在kubernetes的容器内部,并组成spark集群环境

-

云服务模式(运行在云平台上)

aws,华为云,阿里云

Spark的架构角色-理解

Spark的架构角色-理解 1.1

yarn角色回顾

yarn主要有4类角色,从2个层面去看:

资源管理层面

- 集群资源管理者(master)resourceManager

- 单机资源管理者(worker)nodeManager

任务计算层面

- 单任务管理者(master)applicationMaster

- 单任务执行者(worker)Task(容器内计算框架的工作角色)

Spark的架构角色-理解 1.2

spark运行角色

Spark的架构角色-理解 1.3

spark运行角色

spark中由4类角色组成整个spark的运行时环境

- master角色,管理整个集群的资源 类比与yarn的ResouceManager

- worker角色,管理单个服务器的资源 类比与yarn的NodeManger

- Driver角色,管理单个Spark任务在运行的时候的工作 类比于yarn的applicationMaster

- Executor角色,单个任务运行的时候的一堆工作者,干活的, 类比于yarn的容器内运行的task

从2个层面划分

资源管理层面

- 管理者:spark是master角色,yarn是ResourcesManger

- 工作中:spark是worker角色,yarn是NodeManager

从任务执行层面

- 某任务管理者:spark是Driver角色,yarn是applicationMaster

- 某任务执行者:spark是Executor角色,yarn是容器中运行的具体工作进程

相关问题

spark解决什么问题?

海量数据的计算,可以进行离线批处理以及实时流计算

spark有哪些模块?

核心sparkCore,sql计算(SparkSql),流计算(sparkStreaming),图计算(GraphX), 机器学习(MLib)

spark特点有哪些?

速度快,使用简单,通用性强,多种模式运行

spark的运行模式?

本地模式

集群模式(standAlone,yarn,K8s)

云模式

Spark的运行角色(对比yarn)

master: 集群资源管理(类同ResourceManager)

worker: 单机资源管理(类同NodeManager)

Driver:单任务管理者(类同ApplicationMaster)

Executor:单任务执行者(类同Yarn容器内的Task)

用简单,通用性强,多种模式运行

spark的运行模式?

本地模式

集群模式(standAlone,yarn,K8s)

云模式

Spark的运行角色(对比yarn)

master: 集群资源管理(类同ResourceManager)

worker: 单机资源管理(类同NodeManager)

Driver:单任务管理者(类同ApplicationMaster)

Executor:单任务执行者(类同Yarn容器内的Task)

![[科研图像处理]用matlab平替image-j,有点麻烦,但很灵活!](https://img-blog.csdnimg.cn/72dc461bc457472eae9e23816043765e.png#pic_center)