Code处理结果:DataFrame 及 流程

方式①:每个页面的数据处理成df, 然后再合并df , pd.concat()/ df.append() 循环合并

方式②:原始数据中,每个页面的数据存储在一个列表中,然后页面中的每条数据以字典单元形式盛放在列表中,因此,策略是可以先通过aList.extend(bList)方法,把所有的需要的n个页面中的列表中的字典(每条记录)总体组装在一个总列表中 --》 然后再转成一个总的df

个人感觉方式②的效果会更高效一些 !!!

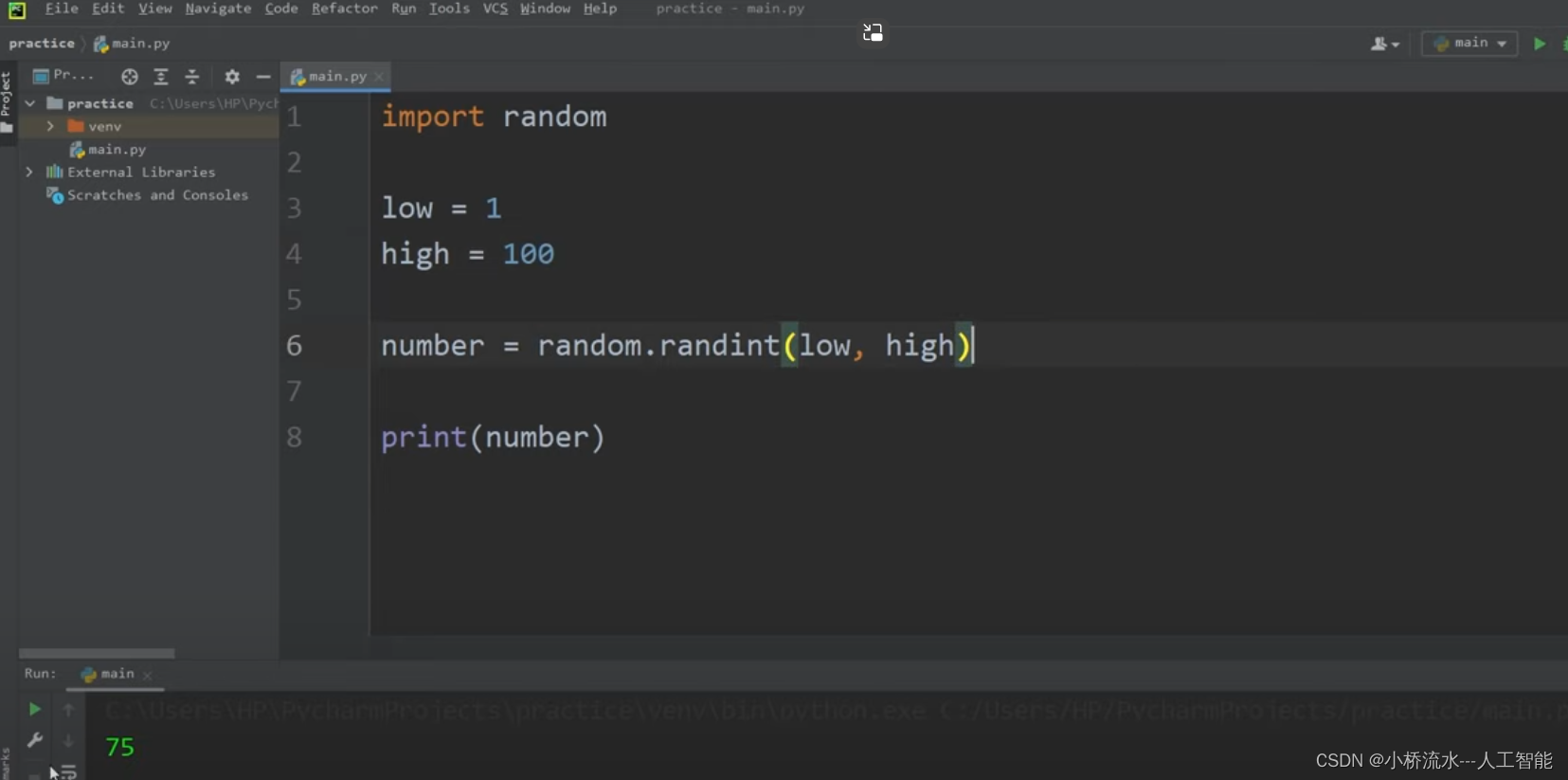

import requests

import datetime

import time

import re

import json

import pandas as pd

url = f'http://model.super202.cn/getJixingData.html?page=1&limit=100&sousuo='

requ = requests.get(url)

requ.headers

{'Server': 'nginx', 'Date': 'Mon, 30 Oct 2023 10:47:54 GMT', 'Content-Type': 'text/html; charset=UTF-8', 'Transfer-Encoding': 'chunked', 'Connection': 'keep-alive', 'Vary': 'Accept-Encoding', 'Strict-Transport-Security': 'max-age=31536000', 'Content-Encoding': 'gzip'}

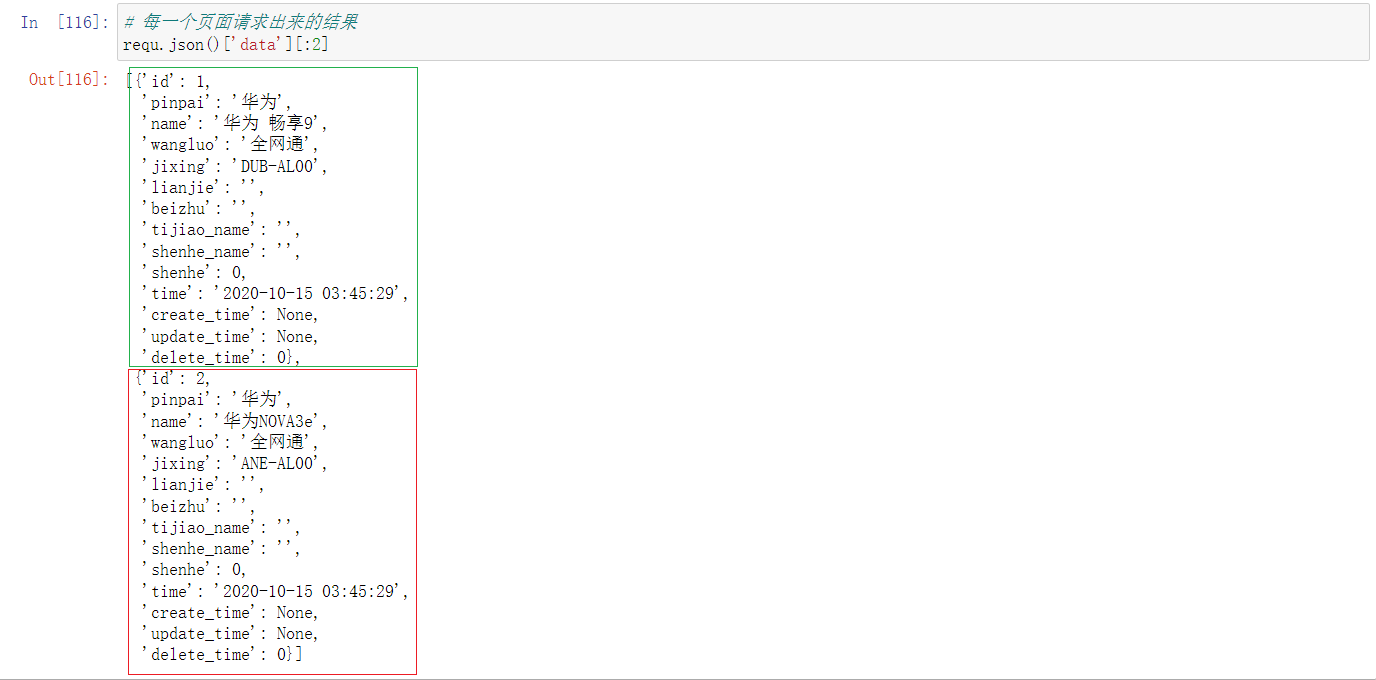

# 每一个页面请求出来的结果

requ.json()['data']

json.loads(requ.text)

# 方式1:

# 初始化

start_num = 1

data = pd.DataFrame()

while 1:

try:

page_num = start_num

print(f'正在获取{page_num}页……')

url = f'http://model.super202.cn/getJixingData.html?page={page_num}&limit=100&sousuo='

requ = requests.get(url)

df = pd.DataFrame(requ.json()['data'])

if df.shape[0] == 0:

print(f'{page_num}-数据获取完毕')

break

else:

# data = data.append(df,ignore_index=True) # FutureWarning

data = data = pd.concat([data,df],ignore_index=True)

start_num = start_num + 1

except Exception as e:

print(str(e))

break

正在获取1页……

正在获取2页……

正在获取3页……

正在获取4页……

正在获取5页……

正在获取6页……

6-数据获取完毕

# 查看前5行

data[:5]

# 方式2:

# 初始化

start_num = 1

aList =[]

while 1:

try:

page_num = start_num

print(f'正在获取{page_num}页……')

url = f'http://model.super202.cn/getJixingData.html?page={page_num}&limit=100&sousuo='

requ = requests.get(url)

bList = json.loads(requ.text)["data"]

if len(bList) == 0:

print(f'{page_num}-数据获取完毕')

break

else:

aList.extend(bList)

start_num = start_num + 1

except Exception as e:

print(str(e))

break

res=pd.DataFrame(aList)

# print(res)

正在获取1页……

正在获取2页……

正在获取3页……

正在获取4页……

正在获取5页……

正在获取6页……

6-数据获取完毕

# 导出结果:

result.to_csv(r'D:\JixingData.csv',encoding='utf_8_sig')

# 单个查询

result.query('jixing=="V2068A"')