Text-to-Speech(通常缩写为TTS)是指一种将文本读成音频的技术。换句话说,它指的是一种模型,在该模型中,当文本或类似于字符的东西作为输入时,会生成波形音频作为输出。

但实际上,这个 TTS 的音频质量在最近几年有了很大的提高。现在不那么尴尬了。整体内容结构遵循[Tan21],并添加了迄今为止(2022年8月)发表的最新论文。

1.历史

第一台“会说话的机器”可能是在 18 世纪后期制造的(据说是一位匈牙利科学家发明的)。计算机辅助创作起源于20世纪中叶,各种技术已经使用了大约50年。如果我们对旧技术进行分类.首先,

1)Articulatory Synthesis: 这是一种模拟人的嘴唇、舌头和发声器官的技术。从理论上讲,这会很棒。但光是看着就很难看出来。因此,以下两种类型较为常用。

2)共振峰合成:人声可以看作是在语音器官中过滤某些声音而产生的声音。这就是所谓的源滤波器模型,它是一种在基本声音(例如单个音高)上添加各种滤波器以使其听起来像人声的方法(称为加法合成)。非常经典的方法仍在广泛研究。

3) Concatenative Synthesis:现在使用数据的模型。举个简单的例子,你可以录制 0 到 9 的声音,并通过链接这些声音来拨打电话号码。因为我们使用的是真实数据。然而,声音并不是很自然流畅。因此,为了创建更复杂的语音模型,提出了以下方法。

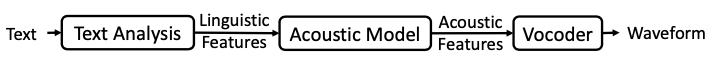

4)统计参数语音合成(SPSS):通过创建声学模型、估计模型参数并使用它来生成音频的模型。它可以大致分为三个部分。首先,“文本分析” ,将输入文本转换为语言特征,“声学模型” ,将语言特征转换为声学特征,最后是声学特征。这是“声码器。该领域使用最广泛的声学模型是隐马尔可夫模型(HMM)。使用 HMM,能够创建比以前更好的声学特征。但是,大部分生成的音频仍然缺少机器人声音等。

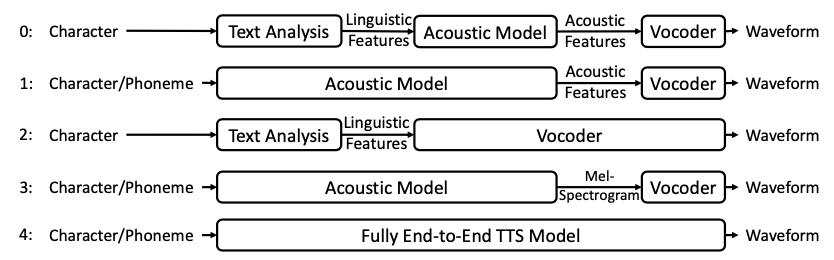

5)神经 TTS:随着我们在 2010 年代进入 DL 时代,已经开发了基于几种新神经网络的模型。这些逐渐取代了HMM,并被用于“声学模型”部分,逐渐提高了结果的质量。从某种意义上说,它可以看作是SPSS的一次进化,但随着模型性能的逐渐提高,它朝着逐渐简化上述三个组成部分的方向发展。比如下图中,可以看出它是在从上(0)到下(4)的方向发展的。

现在(2022年)推出的研究成果很多都属于3号的大部分,而在4号(最难)上取得成功的模型也在陆续推出。因此,在本文中,将重点关注模型 3 和模型 4。尝试将其分为三个模型。

-声学模型:以字符(文本)或音素(音素;发音单位)为输入并创建任何声学特征的模型。如今,大多数声学特征都是指梅尔频谱图。

-声码器:一种将梅尔频谱图(和类似的频谱图)作为输入并生成真实音频的模型。

-完全端到端的 TTS 模型:接收字符或音素作为输入并立即生成音频的模型。

2.文本分析

它只是简单地将字符文本转换为语言特征。文本分析是更改输入文本以使其在以后的合成中可用的一部分,可以应用多种技术。

1) 文本规范化:将缩写或数字更改为发音。比如把1989改成‘十九八九’的部分

2)分词:这在中文、韩语等基于字符的语言中是必须的部分。例如,它根据上下文判断是把'bag'看成单个词还是把'ga'和'bang'分开看.

3)词性标注:分析你在学校学到的“词性”的部分称为POS。也就是说,如果把动词、名词、介词等分析出来,后面的工作肯定会变得容易一些。

4) Prosody prediction:你可以在TTS中找到prosody这个词,但是如果你把它翻译成韩语,感觉就像'rhyme'。表达对句子的哪些部分重读、每个部分的长度如何变化、语气如何变化等的微妙感觉的词。如果没有这个,它会产生一种真正感觉像“机器人说话”的声音。尤其是英语(stress-based)等语言在这方面差异很大,只是程度不同而已,但每种语言都有自己的韵律。如果我们可以通过查看文本来预测这些韵律,那肯定会有所帮助。例如,文本末尾的“?”。如果有,自然会产生上升的音调。

5) Grapheme-to-phoneme (G2P):即使拼写相同,也有很多部分发音不同。例如,“resume”这个词有时会读作“rizju:m”,有时读作“rezjumei”。这也是一个问题,必须查看整个文本并查看上下文。所以,如果优先考虑字素转音素的部分,后面的事情就容易多了。也就是将‘语音’转换成‘spiy ch’等音标的部分。

在过去的 SPSS 时代,添加和开发了这些不同的部分以提高生成音频的质量。在 neural TTS 中,这些部分已经简化了很多,但仍然有一些部分是肯定需要的。比如1)text normalization或者5)G2P基本上都是先处理后输入。如果你真的读过论文说可以接收字符和音素作为输入,那么很多情况下都会写“实际上,当输入音素时结果更好”。尽管如此,它还是比以前简单了很多,所以在大多数神经 TTS 中,文本分析部分并没有单独处理,它被认为是一个简单的预处理。特别是在 G2P 的情况下,已经进行了几项研究,例如英语 [Chae18]、中文 [Park20]、韩语 [Kim21d],并且还提供可用的开源资源。

3.声学模型

声学模型是指通过接收字符或音素作为输入或通过接收在文本分析部分创建的语言特征来生成声学特征的部分。前面提到,在SPSS时代,HMM(Hidden Markov Model)在Acoustic Model中的皱纹很大,后来神经网络技术逐渐进来,开始取而代之。例如,[Zen13][Qian14] 表明用 DNN 替换 HMM 效果更好。不过RNN系列可能更适合语音等时间序列。因此,在[Fan14][Zen15]中,使用LSTM等模型来提高性能。然而,尽管使用了神经网络模型,这些模型仍然接收语言特征作为输入和输出,如 MCC(梅尔倒谱系数)、BAP(带非周期性)、LSP(线谱对)、LinS(线性谱图)和 F0 .(基频)等 因此,这些模型可以被认为是改进的 SPSS 模型。

DeepVoice [Arık17a],吴恩达在百度研究院时宣布的,其实更接近SPSS模型。它由几个部分组成,例如一个G2P模块,一个寻找音素边界的模块,一个预测音素长度的模块,一个寻找F0的模块,每个模块中使用了各种神经网络模型。之后发布的DeepVoice 2 [Arık17b],也可以看作是第一版的性能提升和多扬声器版本,但整体结构类似。

3.1.基于Seq2seq的声学模型

事实上,在将seq2seq模型用于声学模型之后,就可以看到神经TTS可以被认真讨论的时间。在2014-5年的机器翻译领域,使用attention的seq2seq模型成为一种趋势。然而,由于字母和声音之间有很多相似之处,我认为这也可以应用于语音。基于这个想法,Google 开发了 Tacotron[Wang17](因为作者喜欢 tacos 而得名;;)。通过将 CBHG 模块添加到作为 seq2seq 基础的 RNN 中,终于开始出现可以接收字符作为输入并立即提取声学特征的适当神经 TTS,从而摆脱了以前的 SPSS。这个seq2seq模型从那以后很长一段时间都是TTS模型的基础。

在百度,DeepVoice 3 [Ping18] 与之前使用的旧模型分道扬镳,加入了使用注意力的 seq2seq 的行列。然而,DeepVoice 持续基于 CNN 的传统仍然存在。DeepVoice 在版本 3 末尾停止使用这个名称,之后的 ClariNet [Ping19] 和 ParaNet [Peng20] 也沿用了该名称。特别是,ParaNet 引入了几种技术来提高 seq2seq 模型的速度。

谷歌的 Tacotron 在保持称为 seq2seq 的基本形式的同时,也向各个方向发展。第一个版本有点过时,但从 Tacotron 2 [Shen18] 开始,mel-spectrogram 被用作默认的中间表型。在 [Wang18] 中,学习了定义某种语音风格的风格标记,并将其添加到 Tacotron 中,以创建一个控制风格的 TTS 系统。同时发表的另一篇谷歌论文 [Skerry-Ryan18] 也提出了一种模型,可以通过添加一个部分来学习韵律嵌入到 Tacotron 中来改变生成音频的韵律(这些表达性 TTS 的内容将在本文后面进一步讨论。详细介绍)。在 DCTTS [Tachibana18] 中,将 Tacotron 的 RNN 部分替换为 Deep CNN 表明在速度方面有很大的增益。从那时起,该模型已改进为快速模型 Fast DCTTS,尺寸显着减小 [Kang21]。

在 DurIAN [Yu20] 中,Tacotron 2 的注意力部分更改为对齐模型,从而减少了错误。Non-Attentive Tacotron [Shen20] 也做了类似的事情,但在这里,Tacotron 2 的注意力部分被更改为持续时间预测器,以创建更稳健的模型。在FCL-TACO2 [Wang21]中,提出了一种半自回归(SAR)方法,每个音素用AR方法制作,整体用NAR方法制作,以提高速度,同时保持质量。此外,蒸馏用于减小模型的大小。建议使用基于 Tacotron 2 的模型,但速度要快 17-18 倍。

3.2.基于变压器的声学模型

随着2017年Transformers出现在地球上,注意力模型演变成NLP领域的Transformers,使用Transformers的模型也开始出现在TTS领域。TransformerTTS [Li19a]可以看作是一个起点,这个模型原样沿用了Tacotron 2的大部分,只是将RNN部分改成了Transformer。这允许并行处理并允许考虑更长的依赖性。因此,可以更快地产生类似的结果。

FastSpeech [Ren19a] 系列可以被引用为使用 Transformer 模型的 TTS 的代表。在这种情况下,可以通过使用前馈 Transformer 以非常高的速度(顾名思义)创建梅尔频谱图。作为参考,mel-spectrogram是一种考虑人的听觉特性,对FFT的结果进行变换的方法,虽然是很古老的方法,但仍然被重要地使用。优点之一是可以用少量维度(通常为 80)表示。

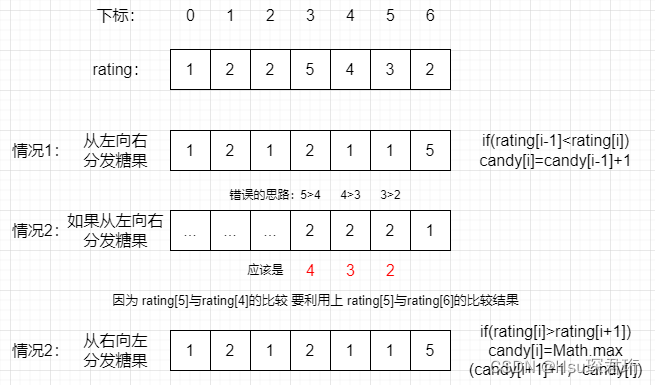

在 TTS 中,将输入文本与梅尔频谱图的帧相匹配非常重要。需要准确计算出一个字符或音素变化了多少帧,其实attention方法过于灵活,对NLP可能有好处,但在speech上反而不利(单词重复或跳过)。因此,FastSpeech 排除了注意力方法,并利用了一个准确预测长度的模块(长度调节器)。后来,FastSpeech 2 [Ren21a] 进一步简化了网络结构,并额外使用了音高、长度和能量等更多样化的信息作为输入。FastPitch[ Łancucki21] 提出了一个模型,通过向 FastSpeech 添加详细的音高信息进一步改进了结果。LightSpeech [Luo21] 提出了一种结构,通过使用 NAS(Neural Architecture Search)优化原本速度很快的 FastSpeech 的结构,将速度提高了 6.5 倍。

MultiSpeech [Chen20] 还介绍了各种技术来解决 Transformer 的缺点。在此基础上,对 FastSpeech 进行训练(师生)以创建一个更加改进的 FastSpeech 模型。TransformerTTS 作者随后还提出了进一步改进的 Transformer TTS 模型,在 RobuTrans [Li20] 模型中使用基于长度的硬注意力。AlignTTS [Zeng20] 还介绍了一种使用单独的网络而不是注意力来计算对齐方式的方法。来自 Kakao 的 JDI-T [Lim20] 引入了一种更简单的基于 transformer 的架构,还使用了改进的注意力机制。NCSOFT 提出了一种在文本编码器和音频编码器中分层使用转换器的方法,方法是将它们堆叠在多个层中 [Bae21]。限制注意力范围和使用多层次音高嵌入也有助于提高性能。

3.3.基于流的声学模型

2014年左右开始应用于图像领域的新一代方法Flow,也被应用到声学模型中。Flowtron [Valle20a] 可以看作是 Tacotron 的改进模型,它是一个通过应用 IAF(逆自回归流)生成梅尔谱图的模型。在 Flow-TTS [Miao20] 中,使用非自回归流制作了一个更快的模型。在后续模型 EfficientTTS [Miao21] 中,在模型进一步泛化的同时,对对齐部分进行了进一步改进。

来自 Kakao 的 Glow-TTS [Kim20] 也使用流来创建梅尔频谱图。Glow-TTS 使用经典的动态规划来寻找文本和梅尔帧之间的匹配,但 TTS 表明这种方法也可以产生高效准确的匹配。后来,这种方法(Monotonic Alignment Search)被用于其他研究。

3.4.基于VAE的声学模型

另一个诞生于 2013 年的生成模型框架 Variational autoencoder (VAE) 也被用在了 TTS 中。顾名思义,谷歌宣布的 GMVAE-Tacotron [Hsu19]使用 VAE 对语音中的各种潜在属性进行建模和控制。同时问世的VAE-TTS[Zhang19a]也可以通过在Tacotron 2模型中添加用VAE建模的样式部件来做类似的事情。BVAE-TTS [Lee21a] 介绍了一种使用双向 VAE 快速生成具有少量参数的 mel 的模型。Parallel Tacotron [Elias21a] 是 Tacotron 系列的扩展,还引入了 VAE 以加快训练和创建速度。

3.5.基于GAN的声学模型

一个好朋友在 2014 年提出的 Generative Adversarial Nets (GAN) 没有理由不能用在 TTS 中。在 [Guo19] 中,Tacotron 2 被用作生成器,GAN 被用作生成更好的 mels 的方法。在 [Ma19] 中,使用 Adversarial training 方法让 Tacotron Generator 一起学习语音风格。Multi-SpectroGAN [Lee21b] 还以对抗方式学习了几种样式的潜在表示,这里使用 FastSpeech2 作为生成器。GANSpeech [Yang21b] 还使用带有生成器的 GAN 方法训练 FastSpeech1/2,自适应调整特征匹配损失的规模有助于提高性能。

3.6.基于扩散的声学模型

最近备受关注的使用扩散模型的TTS也相继被提出。Diff-TTS [Jeong21] 通过对梅尔生成部分使用扩散模型进一步提高了结果的质量。Grad-TTS [Popov21] 也通过将解码器更改为扩散模型来做类似的事情,但在这里,Glow-TTS 用于除解码器之外的其余结构。在 PriorGrad [Lee22a] 中,使用数据统计创建先验分布,从而实现更高效的建模。在这里,我们介绍一个使用每个音素的统计信息应用声学模型的示例。腾讯的 DiffGAN-TTS [Liu22a] 也使用扩散解码器,它使用对抗训练方法。这大大减少了推理过程中的步骤数并降低了生成速度。

3.7.其他声学模型

其实上面介绍的这些技术不一定要单独使用,而是可以相互结合使用的。 FastSpeech 的作者自己分析发现,VAE 即使在小尺寸下也能很好地捕捉韵律等长信息,但质量略差,而 Flow 保留细节很好,而模型需要很大为了提高质量, PortaSpeech我们还提出了另一种模型,称为也就是说,这里包含了Transformer+VAE+Flow的每一个元素。

VoiceLoop [Taigman18] 在旧的 Facebook 元中提出,提出了一种模型,该模型使用类似于人类工作记忆模型的模型来存储和处理语音信息,称为语音循环。它是考虑多扬声器的早期模型,结构本身也很有趣。之后,它被用作 Facebook [Akuzawa18] [Nachmani18] 和 [deKorte20] 的其他研究的骨干。

DeviceTTS [Huang21] 是一个使用深度前馈顺序记忆网络(DFSMN)作为基本单元的模型。该网络是一种带有记忆块的前馈网络,是一种小型但高效的网络,可以在不使用递归方案的情况下保持长期依赖关系。由此,我们提出了一种可以在一般移动设备中充分使用的 TTS 模型。

4.声码器

声码器是使用声学模型生成的声学特征并将其转换为波形的部件。即使在 SPSS 时代,当然也需要声码器,此时使用的祖父声码器包括 STRAIGHT [Kawahara06] 和 WORLD [Morise16]。

4.1.自回归声码器

Neural Vocoder 从 WaveNet [Oord16] 开始是一个既定的理论(?)。引入扩张卷积层来创建长音频样本很重要,并且可以使用自回归方法生成高级音频,该方法使用先前创建的样本生成下一个音频样本(一个接一个)。实际上,WaveNet本身可以作为一个Acoustic Model+Vocoder,将语言特征作为输入,生成音频。然而,从那时起,通过更复杂的声学模型创建梅尔频谱图,并基于 WaveNet 生成音频就变得很普遍。

在 Tacotron [Wang17] 中,创建了一个线性频谱图,并使用 Griffin-Lim 算法 [Griffin84] 将其转换为波形。由于该算法是40年前使用的,尽管网络的整体结构非常好,但得到的音频并不是很令人满意。在 DeepVoice [Arık17a] 中,从一开始就使用了 WaveNet 声码器,特别是在论文 DeepVoice2 [Arık17b] 中,除了他们自己的模型外,还通过将 WaveNet 声码器添加到另一家公司的模型 Tacotron 来提高性能(这么说来,在单个speaker上比DeepVoice2好)给出了更好的性能,实验过后一定是苦了。。)。自版本 2 [Shen18] 以来,Tacotron 使用 WaveNet 作为默认声码器。

SampleRNN [Mehri17] 是另一种自回归模型,在 RNN 方法中一个一个地创建样本。这些自回归模型生成音频的速度非常慢,因为它们通过上一个样本一个一个地构建下一个样本。因此,许多后来的研究建议采用更快生产率的模型。

FFTNet [Jin18] 着眼于WaveNet的dilated convolution的形状与FFT的形状相似,提出了一种可以加快生成速度的技术。在 WaveRNN [Kalchbrenner18] 中,使用了各种技术(GPU 内核编码、剪枝、缩放等)来加速 WaveNet 。WaveRNN 从此演变成通用神经声码器和各种形式。在 [Lorenzo-Trueba19] 中,使用 74 位说话人和 17 种语言的数据对 WaveRNN 进行了训练,以创建 RNN_MS(多说话人)模型,证明它是一种即使在说话人和环境中也能产生良好质量的声码器。数据。[Paul20a] 提出了 SC(Speaker Conditional)_WaveRNN 模型,即通过额外使用 speaker embedding 来学习的模型。该模型还表明它适用于不在数据中的说话人和环境。

苹果的TTS[Achanta21]也使用了WaveRNN作为声码器,并且在server端和mobile端做了各种优化编码和参数设置,使其可以在移动设备上使用。

通过将音频信号分成几个子带来处理音频信号的方法,即较短的下采样版本,已应用于多个模型,因为它具有可以快速并行计算的优点,并且可以对每个子带执行不同的处理。。例如,在 WaveNet 的情况下,[Okamoto18a] 提出了一种子带 WaveNet,它通过使用滤波器组将信号分成子带来处理信号,[Rabiee18] 提出了一种使用小波的方法。[Okamoto18b] 提出了 FFTNet 的子带版本。DurIAN [Yu19] 是一篇主要处理声学模型的论文,但也提出了 WaveRNN 的子带版本。

现在,很多后来推出的声码器都使用非自回归方法来改善自回归方法生成速度慢的问题。换句话说,一种无需查看先前样本(通常表示为平行)即可生成后续样本的方法。已经提出了各种各样的非自回归方法,但最近一篇表明自回归方法没有死的论文是 Chunked Autoregressive GAN (CARGAN) [Morrison22]。它表明许多非自回归声码器存在音高错误,这个问题可以通过使用自回归方法来解决。当然,速度是个问题,但是通过提示可以分成chunked单元计算,我们介绍一种可以显着降低速度和内存的方法。

4.2.基于流的声码器

归一化基于流的技术可以分为两大类。首先是自回归变换,在有代表性的IAF(inverse autoregressive flow)的情况下,生成速度非常快,而不是需要很长的训练时间。因此,它可以用来快速生成音频。然而,训练速度慢是一个问题,在Parallel WaveNet [Oord18]中,首先创建一个自回归WaveNet模型,然后训练一个类似的非自回归IAF模型。这称为教师-学生模型,或蒸馏。之后,ClariNet [Ping19] 使用类似的方法提出了一种更简单、更稳定的训练方法。在成功训练 IAF 模型后,现在可以快速生成音频。但训练方法复杂,计算量大。

另一种流技术称为二分变换。代表性地,一种使用称为仿射耦合层的层来加速训练和生成的方法。大约在同一时间,提出了两个使用这种方法的声码器,WaveGlow [Prenger19] 和 FloWaveNet [Kim19]。这两篇论文来自几乎相似的想法,只有细微的结构差异,包括混合通道的方法。Bipartite transform的优点是简单,但也有缺点,要创建一个等价于IAF的模型,需要堆叠好几层,所以参数量比较大。

从那时起,WaveFlow [Ping20] 提供了几种音频生成方法的综合视图。不仅解释了 WaveGlow 和 FloWaveNet 等流方法,还解释了WaveNet 作为广义模型的生成方法,我们提出了一个计算速度比这些更快的模型。此外,SqueezeWave [Zhai20] 提出了一个模型,该模型通过消除 WaveGlow 模型的低效率并使用深度可分离卷积,速度提高了几个数量级(性能略有下降)。WG-WaveNet [Hsu20] 还提出了一种方法,通过在 WaveGlow 中使用权重共享显着减小模型大小并添加一个小的 WaveNet 滤波器来提高音频质量来创建模型,从而使 44.1kHz 音频在 CPU 上比实时音频更快音频...

4.3.基于 GAN 的声码器

广泛应用于图像领域的生成对抗网络(GANs)经过很长一段时间(4-5年)后成功应用于音频生成领域。WaveGAN [Donahue19] 可以作为第一个主要研究成果被引用。在图像领域发展起来的结构在音频领域被沿用,所以虽然创造了一定质量的音频,但似乎仍然有所欠缺。

从GAN-TTS [Binkowski20]开始,为了让模型更适合音频,也就是我开始思考如何做一个能够很好捕捉波形特征的判别器。在 GAN-TTS 中,使用多个随机窗口(Random window discriminators)来考虑更多样化的特征,而在 MelGAN [Kumar19] 中,使用了一种在多个尺度(Multi-scale discriminator)中查看音频的方法。来自Kakao的HiFi-GAN [Kong20]提出了一种考虑更多音频特征的方法,即一个周期(Multi-period discriminator)。在 VocGAN [Yang20a] 的情况下,还使用了具有多种分辨率的鉴别器。在 [Gritsenko20] 中,生成的分布与实际分布之间的差异以广义能量距离 (GED) 的形式定义,并在最小化它的方向上学习。复杂的鉴别器以各种方式极大地提高了生成音频的性能。[You21] 进一步分析了这一点,并提到了多分辨率鉴别器的重要性。在 Fre-GAN [Kim21b] 中,生成器和鉴别器都使用多分辨率方法连接。使用离散波形变换 (DWT) 也有帮助。

在generator的情况下,很多模型使用了MelGAN提出的dilated + transposed convolution组合。如果稍有不同,Parallel WaveGAN [Yamamoto20] 也接收高斯噪声作为输入,而 VocGAN 生成各种尺度的波形。在 HiFi-GAN 中,使用了具有多个感受野的生成器。[Yamamoto19] 还建议在 GAN 方法中训练 IAF 生成器。

前面提到的 Parallel WaveGAN [Yamamoto20] 是 Naver/Line 提出的一种模型,它可以通过提出非自回归 WaveNet 生成器来以非常高的速度生成音频。[Wu20] 通过在此处添加依赖于音高的扩张卷积提出了一个对音高更稳健的版本。之后,[Song21]提出了一种进一步改进的 Parallel WaveGAN,通过应用感知掩蔽滤波器来减少听觉敏感错误。此外,[Wang21] 提出了一种通过将 Pointwise Relativistic LSGAN(一种改进的最小二乘 GAN)应用于音频来创建具有较少局部伪影的 Parallel WaveGAN(和 MelGAN)的方法。在 LVCNet [Zeng21] 中,使用根据条件变化的卷积层的生成器,称为位置可变卷积,被放入 Parallel WaveGAN 并训练以创建更快(4x)的生成模型,质量差异很小。

此后,MelGAN 也得到了多种形式的改进。在Multi-Band MelGAN [Yang21a]中,增加了原有MelGAN的感受野,增加了多分辨率STFT loss(Parallel WaveGAN建议),计算了多波段划分(DurIAN建议),使得速度更快,更稳定的模型。还提出了 Universal MelGAN [Jang20] 的多扬声器版本,它也使用多分辨率鉴别器来生成具有更多细节的音频。这个想法在后续的研究 UnivNet [Jang21] 中得到延续,并进一步改进,比如一起使用多周期判别器。在这些研究中,音频质量也通过使用更宽的频带 (80->100) mel 得到改善。

最近,首尔国立大学/NVIDIA 推出了一种名为 BigVGAN [Lee22b] 的新型声码器。作为考虑各种录音环境和未见语言等的通用Vocoder,作为技术改进,使用snake函数为HiFi-GAN生成器提供周期性的归纳偏置,并加入低通滤波器以减少边由此造成的影响。另外,模型的大小也大大增加了(~112M),训练也成功了。

4.4.基于扩散的声码器

扩散模型可以称为最新一代模型,较早地应用于声码器。ICLR21同时介绍了思路相似的DiffWave[Kong21]和WaveGrad[Chen21a]。Diffusion Model用于音频生成部分是一样的,但DiffWave类似于WaveNet,WaveGrad基于GAN-TTS。处理迭代的方式也有所不同,因此在比较两篇论文时阅读起来很有趣。之前声学模型部分介绍的PriorGrad [Lee22a]也以创建声码器为例进行了介绍。在这里,先验是使用梅尔谱图的能量计算的。

扩散法的优点是可以学习复杂的数据分布并产生高质量的结果,但最大的缺点是生成时间相对较长。另外,由于这种方法本身是以去除噪声的方式进行的,因此如果进行时间过长,存在原始音频中存在的许多噪声(清音等)也会消失的缺点。FastDiff [Huang22] 通过将 LVCNet [Zeng21] 的思想应用到扩散模型中,提出了时间感知的位置-变化卷积。通过这种方式,可以更稳健地应用扩散,并且可以通过使用噪声调度预测器进一步减少生成时间。

来自腾讯的 BDDM [Lam22] 也提出了一种大大减少创建时间的方法。换句话说,扩散过程的正向和反向过程使用不同的网络(正向:调度网络,反向:分数网络),并为此提出了一个新的理论目标。在这里,我们展示了至少可以通过三个步骤生成音频。在这个速度下,扩散法也可以用于实际目的。虽然以前的大多数研究使用 DDPM 型建模,但扩散模型也可以用随机微分方程 (SDE) 的形式表示。ItoWave [Wu22b] 展示了使用 SDE 类型建模生成音频的示例。

4.5.基于源滤波器的声码器

在这篇文章的开头,在处理 TTS 的历史时,我们简单地了解了 Formant Synthesis。人声是一种建模方法,认为基本声源(正弦音等)经过口部结构过滤,转化为我们听到的声音。这种方法最重要的部分是如何制作过滤器。在 DL 时代,我想如果这个过滤器用神经网络建模,性能会不会更好。在神经源滤波器方法 [Wang19a] 中,使用 f0(音高)信息创建基本正弦声音,并训练使用扩张卷积的滤波器以产生优质声音。不是自回归的方法,所以速度很快。之后,在[Wang19b]中,将其扩展重构为谐波+噪声模型以提高性能。DDSP [Engel20] 提出了一种使用神经网络和多个 DSP 组件创建各种声音的方法,其中谐波使用加法合成方法,噪声使用线性时变滤波器。

另一种方法是将与语音音高相关的部分(共振峰)和其他部分(称为残差、激励等)进行划分和处理的方法。这也是一种历史悠久的方法。共振峰主要使用了LP(线性预测),激励使用了各种模型。GlotNet [Juvela18],在神经网络时代提出,将(声门)激励建模为 WaveNet。之后,GELP [Juvela19] 使用 GAN 训练方法将其扩展为并行格式。

Naver/Yonsei University 的 ExcitNet [Song19] 也可以看作是具有类似思想的模型,然后,在扩展模型 LP-WaveNet [Hwang20a] 中,source 和 filter 一起训练,并使用更复杂的模型。在 [Song20] 中,引入了逐代建模 (MbG) 概念,从声学模型生成的信息可用于声码器以提高性能。在神经同态声码器 [Liu20b] 中,谐波使用线性时变 (LTV) 脉冲序列,噪声使用 LTV 噪声。[Yoneyama21] 提出了一种模型,它使用 Parallel WaveGAN 作为声码器,并集成了上述几种源滤波器模型。Parallel WaveGAN本身也被原作者组(Naver等)不断扩充,首先在[Hwang21b]中,Generator被扩充为Harmonic + Noise模型,同时也加入了subband版本。此外,[Yamamoto21] 提出了几种提高鉴别器性能的技术,其中,模型浊音(谐波)和清音(噪声)的鉴别器分为考虑因素。

LPCNet [Valin19] 可以被认为是继这种源过滤器方法之后使用最广泛的模型。作为在 WaveRNN 中加入线性预测的模型, LPCNet 此后也进行了多方面的改进。在 Bunched LPCNet [Vipperla20] 中,通过利用原始 WaveRNN 中引入的技术,LPCNet 变得更加高效。Gaussian LPCNet [Popov20a] 还通过允许同时预测多个样本来提高效率。[Kanagawa20] 通过使用张量分解进一步减小 WaveRNN 内部组件的大小来提高另一个方向的效率。iLPCNet [ Hwang20b] 提出了一种模型,该模型通过利用连续形式的混合密度网络显示出比现有 LPCNet 更高的性能。[Popov20b] 提出了一种模型,在LPCNet中的语音中找到可以切断的部分(例如,停顿或清音),将它们划分,并行处理,并通过交叉淡入淡出来加快生成速度. LPCNet 也扩展到了子带版本,首先在 FeatherWave [Tian20] 中引入子带 LPCNet。 在 [Cui20] 中,提出了考虑子带之间相关性的子带 LPCNet 的改进版本。最近LPCNet的作者也推出了改进版(好像是从Mozilla/Google转到Amazon)[Valin22],使用树结构来减少采样时的计算量,使用8位量化权重。建议。这些都是有效使用缓存并利用最新 GPU 改进的并行计算能力的所有方法。

ETC...

如前所述,声码器的发展正朝着从高质量、慢速的AR(Autoregressive)方法向快速的NAR(Non-autoregressive)方法转变的方向发展。由于几种先进的生成技术,NAR 也逐渐达到 AR 的水平。两者之间也有一些有趣的论文,例如在TTS-BY-TTS [Hwang21a]中,使用AR方法创建了大量数据并用于NAR模型的训练,效果不错。但是,使用所有数据可能会很糟糕。因此,TTS-BY-TTS2 [Song22] 提出了一种仅使用此数据进行训练的方法,方法是使用 RankSVM 获得与原始音频更相似的合成音频。

DelightfulTTS [Liu21],微软使用的 TTS 系统,有一些自己的结构修改,例如使用 conformers,并且特别以生成 48 kHz 的最终音频为特征(大多数 TTS 系统通常生成 16 kHz 音频)。为此,梅尔频谱图以 16kHz 的频率生成,但最终音频是使用内部制作的 HiFiNet 以 48kHz 的频率生成的。

5.完全端到端的TTS

接下来,通过一起学习声学模型和声码器,介绍在输入文本或音素时立即创建波形音频的模型。实际上,最好一次完成所有操作。无需划分训练步骤,更少的步骤减少错误。无需使用 Mel Spectrum 等声学功能。其实Mel是好的,但是被人任意设定了(次优),相位信息也丢失了。然而,这些模型之所以不容易从一开始就开发出来,是因为很难一次全部完成。

例如,作为输入的文本在 5 秒内大约为 20,对于音素大约为 100。但波形是 80,000 个样本(采样率为 16 kHz)。因此,一旦记忆力成为问题,与其完全匹配(文本->音频样本),不如使用中等分辨率的表达方式(如Mel)分两步进行比较简单。但是,随着技术的逐渐发展,你可以找到一些用这种 Fully End-to-End 方法训练的模型(意思是从端到端,意思是一次性完成)。作为参考,在许多处理声学模型的论文中,他们经常使用术语端到端模型,这意味着文本分析部分已被一起吸收到他们的模型中,或者他们可以通过将声码器附加到他们的模型来生成音频. 它通常用于表示能够。因此,为了区分从文本到音频创建模型的真正端到端方法,本文使用术语“完全”端到端方法(非官方)。

也许这个领域的第一个是 Char2Wav [Sotelo17]。这是蒙特利尔大学名人Yoshua Bengio教授团队的论文,通过将其团队制作的SampleRNN [Mehri17] vocoder添加到Acoustic Model using seq2seq中一次性训练而成。ClariNet[Mehri17]的主要内容其实就是让WaveNet->IAF方法的Vocoder更加高效,但是有他们团队(百度)创建的Acoustic Model(DeepVoice 3),所以在里面添加一个新创建的vocoder并且赶紧学起来吧,还介绍了如何创建-to-End模型。

FastSpeech 2 [Ren21a] 也是关于一个好的 Acoustic Model,这篇论文也介绍了一个 Fully End-to-End 模型,叫做 FastSpeech 2s(命名为 senseboso)。FastSpeech 2模型附加了一个WaveNet声码器,为了克服训练的困难,采取了使用预先制作的mel编码器的方法。名为EATS [Donahue21](有点饿)的模型使用他们团队(谷歌)创建的GAN-TTS [Binkowski20]作为声码器,创建一个新的Acoustic Model,并一起训练。但是,一次训练很困难,因此创建并使用了中等分辨率的表示。Wave-Tacotron [Weiss21],正如您光听名字就知道的那样,是一种通过将声码器连接到 Tacotron 来立即训练的模型。这里使用了流式声码器,作者中有 Kingma(生成模型界的巨头,包括流方法),因此可以在不显着降低性能的情况下创建更快的模型。

之前Acoustic Model部分介绍的EfficientTTS [Miao21]也介绍了一种模型(EFTS-Wav),通过将decoder换成MelGAN,以端到端的方式进行训练。该模型还表明,它可以显着加快音频生成速度,同时仍然表现良好。Kakao 团队开发了一种名为 Glow-TTS [Kim20] 的声学模型和一种名为 HiFi-GAN [Kong20] 的声码器。然后可以将两者放在一起以创建端到端模型。这样创建的模型是 VITS [Kim21a],它使用 VAE 连接两个部分,并使用对抗性方法进行整个训练。再次,提出了具有良好速度和质量的模型。

延世大学/Naver 还在 2021 年推出了 LiteTTS [Nguyen21],这是一种高效的完全端到端 TTS。使用了前馈变换器和 HiFi-GAN 结构的轻量级版本。特别是,域传输编码器用于学习与韵律嵌入相关的文本信息。腾讯和浙江大学提出了一种名为 FastDiff [Huang22] 的声码器,还引入了 FastDiff-TTS,这是一种结合 FastSpeech 2(也是浙江大学)的完全端到端模型。Kakao 还引入了 JETS,它可以一起训练 FastSpeech2 和 HiFi-GAN [Lim22]。微软在将现有的 DelightfulTTS 升级到版本 2 的同时,也引入了 Fully End-to-End 方法 [Liu22b]。这里,VQ音频编码器被用作中间表达方法。

参考文献

【1】[논문들소개] Neural Text-to-Speech(TTS)

【2】1906.10859.pdf (arxiv.org)

Reference

- [Griffin84] D.Griffin, J.Lim. Signal estimation from modified short-time fourier transform. IEEE Transactions on Acoustics, Speech, and Signal Processing, 32(2):236–243, 1984.

- [Kawahara06] H.Kawahara. Straight, exploitation of the other aspect of vocoder: Perceptually isomor- phic decomposition of speech sounds. Acoustical science and technology, 27(6):349–353, 2006.

- [Zen13] H.Zen, A.Senior, M.Schuster. Statistical parametric speech synthesis using deep neural networks. ICASSP 2013.

- [Fan14] Yuchen Fan, Yao Qian, Feng-Long Xie, and Frank K Soong. TTS synthesis with bidirectional lstm based recurrent neural networks. Fifteenth annual conference of the international speech communication association, 2014.

- [Qian14] Y. Qian, Y.-C. Fan, W.-P. Hum, F. K. Soong, On the training aspects of deep neural network (DNN) for parametric TTS synthesis. ICASSP 2014.

- [Zen15] H.Zen, Hasim Sak. Unidirectional long short-term memory recurrent neural network with recurrent output layer for low-latency speech synthesis. ICASSP 2015.

- [Morise16] M.Morise, F.Yokomori, K.Ozawa. World: a vocoder-based high-quality speech synthesis system for real-time applications. IEICE Transactions on Information and Systems, 99(7):1877–1884, 2016.

- [Oord16] A.van den Oord, S.Dieleman, H.Zen, K.Simonyan, O.Vinyals, A.Graves, N.Kalchbrenner, A.Senior, K.Kavukcuoglu. WaveNet: A generative model for raw audio. arXiv preprint arXiv:1609.03499, 2016.

- [Arık17a] S.Ö.Arık, M.Chrzanowski, A.Coates, G.Diamos, A.Gibiansky, Y.Kang, X.Li, J.Miller, J.Raiman, S.Sengupta, M.Shoeybi. Deep Voice: Real-time neural text-to-speech. ICML 2017.

- [Arık17b] S.Ö.Arık, G.Diamos, A.Gibiansky, J.Miller, K.Peng, W.Ping, J.Raiman, Y.Zhou. Deep Voice 2: Multi-speaker neural text-to-speech. NeurIPS 2017.

- [Lee17] Y.Lee, A.Rabiee, S.-Y.Lee. Emotional end-to-end neural speech synthesizer. arXiv preprint arXiv:1711.05447, 2017.

- [Mehri17] S.Mehri, K.Kumar, I.Gulrajani, R.Kumar, S.Jain, J.Sotelo, A.Courville, Y.Bengio. SampleRNN: An unconditional end-to-end neural audio generation model. ICLR 2017.

- [Ming17] H.Ming, Y.Lu, Z.Zhang, M.Dong. Alight-weight method of building an LSTM-RNN-based bilingual TTS system. International Conference on Asian Language Processing 2017.

- [Sotelo17] J.Sotelo, S.Mehri, K.Kumar, J.F.Santos, K.Kastner, A.Courville, Y.Bengio. Char2wav: End-to-end speech synthesis. ICLR workshop 2017.

- [Tjandra17] A.Tjandra, S.Sakti, S.Nakamura. Listening while speaking: Speech chain by deep learning. IEEE Automatic Speech Recognition and Understanding Workshop (ASRU) 2017.

- [Wang17] Y.Wang, RJ Skerry-Ryan, D.Stanton, Y.Wu, R.Weiss, N.Jaitly, Z.Yang, Y.Xiao, Z.Chen, S.Bengio, Q.Le, Y.Agiomyrgiannakis, R.Clark, R.A.Saurous. Tacotron: Towards end-to-end speech synthesis. Interspeech 2017.

- [Adigwe18] A.Adigwe, N.Tits, K.El Haddad, S.Ostadabbas, T.Dutoit. The emotional voices database: Towards controlling the emotion dimension in voice generation systems. arXiv preprint arXiv:1806.09514, 2018.

- [Akuzawa18] K.Akuzawa, Y.Iwasawa, Y.Matsuo. Expressive speech synthesis via modeling expressions with variational autoencoder. Interspeech 2018.

- [Arık18] S.Ö.Arık, J.Chen, K.Peng, W.Ping, Y.Zhou. Neural voice cloning with a few samples. NeurIPS 2018.

- [Chae18] M.-J.Chae, K.Park, J.Bang, S.Suh, J.Park, N.Kim, L.Park. Convolutional sequence to sequence model with non-sequential greedy decoding for grapheme to phoneme conversion. ICASSP 2018.

- [Guo18] W.Guo, H.Yang, Z.Gan. A dnn-based mandarin-tibetan cross-lingual speech synthesis. Asia-Pacific Signal and Information Processing Association Annual Summit and Conference 2018.

- [Kalchbrenner18] N.Kalchbrenner, E.Elsen, K.Simonyan, S.Noury, N.Casagrande, E.Lockhart, F.Stimberg, A.van den Oord, S.Dieleman, K.Kavukcuoglu. Efficient neural audio synthesis. ICML 2018.

- [Jia18] Y.Jia, Y.Zhang, R.J.Weiss, Q.Wang, J.Shen, F.Ren, Z.Chen, P.Nguyen, R.Pang, I.L.Moreno, Y.Wu. Transfer learning from speaker verification to multispeaker text-to-speech synthesis. NeurIPS 2018.

- [Jin18] Z.Jin, A.Finkelstein, G.J.Mysore, J.Lu. FFTNet: A real-time speaker-dependent neural vocoder. ICASSP 2018.

- [Juvela18] L.Juvela, V.Tsiaras, B.Bollepalli, M.Airaksinen, J.Yamagishi, P. Alku. Speaker-independent raw waveform model for glottal excitation. Interspeech 2018.

- [Nachmani18] E.Nachmani, A.Polyak, Y.Taigman, L.Wolf. Fitting new speakers based on a short untranscribed sample. ICML 2018.

- [Okamoto18a] T. Okamoto, K. Tachibana, T. Toda, Y. Shiga, and H. Kawai. An investigation of subband wavenet vocoder covering entire audible frequency range with limited acoustic features. ICASSP 2018.

- [Okamoto18b] T. Okamoto, T. Toda, Y. Shiga, and H. Kawai. Improving FFT-Net vocoder with noise shaping and subband approaches. IEEE Spoken Language Technology Workshop (SLT) 2018.

- [Oord18] A.van den Oord, Y.Li, I.Babuschkin, K.Simonyan, O.Vinyals, K.Kavukcuoglu, G.van den Driessche, E.Lockhart, L.C.Cobo, F.Stimberg et al., Parallel WaveNet: Fast high-fidelity speech synthesis. ICML 2018.

- [Ping18] W.Ping, K.Peng, A.Gibiansky, S.O.Arık, A.Kannan, S.Narang, J.Raiman, J.Miller. Deep Voice 3: Scaling text-to-speech with convolutional sequence learning. ICLR 2018.

- [Shen18] J.Shen, R.Pang, R.J.Weiss, M.Schuster, N.Jaitly, Z.Yang, Z.Chen, Y.Zhang, Y.Wang, RJ S.Ryan, R.A.Saurous, Y.Agiomyrgiannakis, Y.Wu. Natural TTS synthesis by conditioning WaveNet on mel spectrogram predictions. ICASSP 2018.

- [Skerry-Ryan18] R.J.Skerry-Ryan, E.Battenberg, Y.Xiao, Y.Wang, D.Stanton, J.Shor, R.Weiss, R.Clark, R.A.Saurous. Towards end-to-end prosody transfer for expressive speech synthesis with tacotron. ICML 2018.

- [Tachibana18] H.Tachibana, K.Uenoyama, S.Aihara. Efficiently trainable text-to-speech system based on deep convolutional networks with guided attention. ICASSP 2018.

- [Taigman18] Y.Taigman, L.Wolf, A.Polyak, E.Nachmani. VoiceLoop: Voice fitting and synthesis via a phonological loop. ICLR 2018.

- [Tjandra18] A.Tjandra, S.Sakti, S.Nakamura. Machine speech chain with one-shot speaker adaptation. Interspeech 2018.

- [Wang18] Y.Wang, D.Stanton, Y.Zhang, R.J.Skerry-Ryan, E.Battenberg, J.Shor, Y.Xiao, Y.Jia, F.Ren, R.A.Saurous. Style tokens: Unsupervised style modeling, control and transfer in end-to-end speech synthesis. ICML 2018.

- [Bollepalli19] B.Bollepalli, L.Juvela, P.Alkuetal. Lombard speech synthesis using transfer learning in a Tacotron text-to-speech system. Interspeech 2019.

- [Chen19a] Y.-J.Chen, T.Tu, C.-c.Yeh, H.-Y.Lee. End-to-end text-to-speech for low-resource languages by cross-lingual transfer learning. Interspeech 2019.

- [Chen19b] Y.Chen, Y.Assael, B.Shillingford, D.Budden, S.Reed, H.Zen, Q.Wang, L.C.Cobo, A.Trask, B.Laurie, C.Gulcehre, A.van den Oord, O.Vinyals, N.de Freitas. Sample efficient adaptive text-to-speech. ICLR 2019.

- [Chen19c] M.Chen, M.Chen, S.Liang, J.Ma, L.Chen, S.Wang, J.Xiao. Cross-lingual, multi-speaker text-to-speech synthesis using neural speaker embedding. Interspeech 2019.

- [Chung19] Y.-A.Chung, Y.Wang, W.-N.Hsu,Y.Zhang, R.J.Skerry-Ryan.Semi-supervised training for improving data efficiency in end-to-end speech synthesis. ICASSP 2019.

- [Donahue19] C.Donahue, J.McAuley, M.Puckette. Adversarial audio synthesis. ICLR 2019. [논문리뷰]

- [Fang19] W.Fang, Y.-A.Chung, J.Glass. Towards transfer learning for end-to-end speech synthesis from deep pre-trained language models. arXiv preprint arXiv:1906.07307, 2019.

- [Guo19] H.Guo, F.K.Soong, L.He, L.Xie. A new GAN-based end-to-end tts training algorithm. Interspeech 2019.

- [Gururani19] S.Gururani, K.Gupta, D.Shah, Z.Shakeri, J.Pinto. Prosody transfer in neural text to speech using global pitch and loudness features. arXiv preprint arXiv:1911.09645, 2019.

- [Habib19] R.Habib, S.Mariooryad, M.Shannon, E.Battenberg, R.J.Skerry-Ryan, D.Stanton, D.Kao, T.Bagby. Semi-supervised generative modeling for controllable speech synthesis. ICLR 2019.

- [Hayashi19] T. Hayashi, S. Watanabe, T. Toda, K. Takeda, S. Toshniwal, and K. Livescu. Pre-trained text embeddings for enhanced text-to-speech synthesis. Interspeech 2019.

- [Hsu19] W.-N.Hsu, Y.Zhang, R.J.Weiss, H.Zen, Y.Wu, Y.Wang, Y.Cao, Y.Jia, Z.Chen, J.Shen, P.Nguyen, R.Pang. Hierarchical generative modeling for controllable speech synthesis. ICLR 2019.

- [Jia19] Y.Jia, R.J.Weiss, F.Biadsy, W.Macherey, M.Johnson, Z.Chen, Y.Wu. Direct speech-to-speech translation with a sequence-to-sequence model. Interspeech 2019.

- [Juvela19] L.Juvela, B.Bollepalli, J.Yamagishi, P.Alku. Gelp: Gan-excited linear prediction for speech synthesis from mel-spectrogram. Interspeech 2019.

- [Kim19] S.Kim, S.Lee, J.Song, J.Kim, S.Yoon. FloWaveNet: A Generative flow for raw audio. ICML 2019.

- [Kenter19] T.Kenter, V.Wan, C.-A.Chan, R.Clark, J.Vit. Chive: Varying prosody in speech synthesis with a linguistically driven dynamic hierarchical conditional variational network. ICML 2019.

- [Klimkov19] V.Klimkov, S.Ronanki, J.Rohnke, T.Drugman. Fine-grained robust prosody transfer for single-speaker neural text-to-speech. Interspeech 2019.

- [Kons19] Z.Kons, S.Shechtman, A.Sorin, C.Rabinovitz, R.Hoory. High quality, lightweight and adaptable TTS using LPCNet. Interspeech 2019.

- [Kwon19] O.Kwon, E.Song, J.-M.Kim, H.-G.Kang. Effective parameter estimation methods for an excitnet model in generative text-to-speech systems. arXiv preprint arXiv:1905.08486, 2019.

- [Kumar19] K.Kumar, R.Kumar, T.de Boissiere, L.Gestin, W.Z.Teoh, J.Sotelo, A.de Brebisson, Y.Bengio, A. Courville. MelGAN: Generative adversarial networks for conditional waveform synthesis. NeurIPS 2019.

- [Lee19] Y.Lee, T.Kim. Robust and fine-grained prosody control of end-to-end speech synthesis. ICASSP 2019.

- [Li19a] N.Li, S.Liu, Y.Liu, S.Zhao, M.Liu, M.Zhou. Neural speech synthesis with transformer network. AAAI 2019.

- [Li19b] B. Li, Y. Zhang, T. Sainath, Y. Wu, W. Chan. Bytes are all you need: End-to-end multilingual speech recognition and synthesis with bytes. ICASSP, 2019.

- [Lorenzo-Trueba19] J.Lorenzo-Trueba, T.Drugman, J.Latorre, T.Merritt, B.Putrycz, R.Barra-Chicote, A.Moinet, V.Aggarwal. Towards achieving robust universal neural vocoding. Interspeech 2019.

- [Ma19] S.Ma, D.Mcduff, Y.Song. Neural TTS stylization with adversarial and collaborative games. ICLR 2019.

- [Ming19] H. Ming, L. He, H. Guo, and F. Soong. Feature reinforcement with word embedding and parsing information in neural TTS. arXiv preprint arXiv:1901.00707, 2019.

- [Nachmani19] E.Nachmani, L.Wolf. Unsupervised polyglot text to speech. ICASSP 2019.

- [Ping19] W.Ping, K.Peng, J.Chen. ClariNet: Parallel wave generation in end-to-end text-to-speech. ICLR 2019.

- [Prenger19] R.Prenger, R.Valle, B.Catanzaro. WaveGlow: A flow-based generative network for speech synthesis. ICASSP 2019.

- [Ren19a] Y.Ren, Y.Ruan, X.Tan, T.Qin, S.Zhao, Z.Zhao, T.Y.Liu. FastSpeech: Fast, robust and controllable text to speech. NeurIPS 2019.

- [Ren19b] Y.Ren, X.Tan, T.Qin, S.Zhao, Z.Zhao, T.-Y.Liu. Almost unsupervised text to speech and automatic speech recognition. ICML 2019.

- [Song19] E.Song, K.Byun, H.-G.Kang. ExcitNet vocoder: A neural excitation model for parametric speech synthesis systems. EUSIPCO, 2019.

- [Tits19a] N.Tits, K.E.Haddad, T.Dutoit. Exploring transfer learning for low resource emotional TTS. SAI Intelligent Systems Conference. Springer 2019.

- [Tits19b] N.Tits, F.Wang, K.E.Haddad, V.Pagel, T.Dutoit. Visualization and interpretation of latent spaces for controlling expressive speech synthesis through audio analysis,. arXiv preprint arXiv:1903.11570, 2019.

- [Tjandra19] A.Tjandra, B.Sisman, M.Zhang, S.Sakti, H.Li, S.Nakamura. VQVAE unsupervised unit discovery and multi-scale code2spec inverter for zerospeech challenge 2019. Interspeech 2019.

- [Valin19] J.-M.Valin, J.Skoglund. LPCNet: Improving neural speech synthesis through linear prediction. ICASSP 2019.

- [Wang19a] X.Wang, S.Takaki, J.Yamagishi. Neural source-filter-based waveform model for statistical parametric speech synthesis. ICASSP 2019.

- [Wang19b] X.Wang, S.Takaki, J.Yamagishi. Neural harmonic-plus-noise waveform model with trainable maximum voice frequency for text-to-speech synthesis. ISCA Speech Synthesis Workshop 2019.

- [Yamamoto19] R.Yamamoto, E.Song, J.-M.Kim. Probability density distillation with generative adversarial networks for high-quality parallel waveform generation. Interspeech 2019.

- [Yang19] B.Yang, J.Zhong, S.Liu. Pre-trained text representations for improving front-end text processing in Mandarin text-to-speech synthesis. Interspeech 2019.

- [Zhang19a] Y.-J.Zhang, S.Pan, L.He, Z.-H.Ling. Learning latent representations for style control and transfer in end-to-end speech synthesis. ICASSP 2019.

- [Zhang19b] M.Zhang, X.Wang, F.Fang, H.Li, J.Yamagishi. Joint training framework for text-to-speech and voice conversion using multi-source tacotron and wavenet. Interspeech 2019.

- [Zhang19c] W.Zhang, H.Yang, X.Bu, L.Wang. Deep learning for mandarin-tibetan cross-lingual speech synthesis. IEEE Access 2019.

- [Zhang19d] Y.Zhang, R.J.Weiss, H.Zen, Y.Wu, Z.Chen, R.J.Skerry-Ryan, Y.Jia, A.Rosenberg, B.Ramabhadran. Learning to speak fluently in a foreign language: Multilingual speech synthesis and cross-language voice cloning. Interspeech 2019.

- [Azizah20] K.Azizah, M.Adriani, W.Jatmiko. Hierarchical transfer learning for multilingual, multi-speaker, and style transfer DNN-based TTS on low-resource languages. IEEE Access 2020.

- [Bae20] J.-S.Bae, H.Bae, Y.-S.Joo, J.Lee, G.-H.Lee, H.-Y.Cho. Speaking speed control of end-to-end speech synthesis using sentence-level conditioning. Interspeech 2020.

- [Binkowski20] M.Binkowski, J.Donahue, S.Dieleman, A.Clark, E.Elsen, N.Casagrande, L.C.Cobo, K.Simonyan. High fidelity speech synthesis with adversarial networks. ICLR 2020. [논문리뷰]

- [Chen20] M.Chen, X.Tan, Y.Ren, J.Xu, H.Sun, S.Zhao, T.Qin. MultiSpeech: Multi-speaker text to speech with transformer. Interspeech 2020.

- [Choi20] S.Choi, S.Han, D.Kim, S.Ha. Attentron: Few-shot text-to-speech utilizing attention-based variable-length embedding. Interspeech 2020.

- [Cooper20a] E.Cooper, C.-I.Lai, Y.Yasuda, F.Fang, X.Wang, N.Chen, J.Yamagishi. Zero-shot multi-speaker text-to-speech with state-of-the-art neural speaker embeddings. ICASSP 2020.

- [Cooper20b] E.Cooper, C.-I.Lai, Y.Yasuda, J.Yamagishi. Can speaker augmentation improve multi-speaker end-to-end TTS? Interspeech 2020.

- [Cui20] Y.Cui, X.Wang, L.He, F.K.Soong. An efficient subband linear prediction for lpcnet-based neural synthesis. Interspeech 2020.

- [deKorte20] M.de Korte, J.Kim, E.Klabbers. Efficient neural speech synthesis for low-resource languages through multilingual modeling. Interspeech 2020.

- [Engel20] J.Engel, L.Hantrakul, C.Gu, A.Roberts, DDSP: Differentiable digital signal processing. ICLR 2020.

- [Gritsenko20] A.Gritsenko, T.Salimans, R.van den Berg, J.Snoek, N.Kalchbrenner. A spectral energy distance for parallel speech synthesis. NeurIPS 2020.

- [Hemati20] H.Hemati, D.Borth. Using IPA-based tacotron for data efficient cross-lingual speaker adaptation and pronunciation enhancement. arXiv preprint arXiv:2011.06392, 2020.

- [Himawan20] I.Himawan, S.Aryal, I.Ouyang, S.Kang, P.Lanchantin, S.King. Speaker adaptation of a multilingual acoustic model for cross-language synthesis. ICASSP 2020.

- [Hsu20] P.-C.Hsu and H.-Y.Lee. WG-WaveNet: Real-time high-fidelity speech synthesis without GPU. Interspeech 2020.

- [Hwang20a] M.-J.Hwang, F.Soong, E.Song, X.Wang, H. ang, H.-G.Kang. LP-WaveNet: Linear prediction-based WaveNet speech synthesis. Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC) 2020.

- [Hwang20b] M.-J.Hwang, E.Song, R.Yamamoto, F.Soong, H.-G.Kang. Improving LPCNet-based text-to-speech with linear prediction-structured mixture density network. ICASSP 2020.

- [Jang20] W.Jang, D.Lim, J.Yoon. Universal MelGAN: A robust neural vocoder for high-fidelity waveform generation in multiple domains. arXiv preprint arXiv:2011.09631, 2020.

- [Kanagawa20] H.Kanagawa, Y.Ijima. Lightweight LPCNet-based neural vocoder with tensor decomposition. Interspeech 2020.

- [Kenter20] T. Kenter, M. K. Sharma, and R. Clark. Improving prosody of RNN-based english text-to-speech synthesis by incorporating a BERT model. Interspeech 2020.

- [Kim20] J.Kim, S.Kim, J.Kong, S.Yoon. Glow-TTS: A generative flow for text-to-speech via monotonic alignment search. NeurIPS 2020

- [Kong20] J.Kong, J.Kim, J.Bae. HiFi-GAN: Generative adversarial networks for efficient and high fidelity speech synthesis. NeurIPS 2020.

- [Li20] N.Li, Y.Liu, Y.Wu, S.Liu, S.Zhao, M.Liu. RobuTrans: A robust transformer-based text-to-speech model. AAAI 2020.

- [Lim20] D.Lim, W.Jang, G.O, H.Park, B.Kim, J.Yoon. JDI-T: Jointly trained duration informed transformer for text-to-speech without explicit alignment. Interspeech 2020.

- [Liu20a] A.H.Liu, T.Tu, H.-y.Lee, L.-s.Lee. Towards unsupervised speech recognition and synthesis with quantized speech representation learning. ICASSP 2020.

- [Liu20b] Z.Liu, K.Chen, K.Yu. Neural homomorphic vocoder. Interspeech 2020.

- [Luong20] H.-T.Luong, J.Yamagishi. NAUTILUS: a versatile voice cloning system. IEEE/ACM Transactions on Audio, Speech, and Language Processing 2020.

- [Maiti20] S.Maiti, E.Marchi, A.Conkie. Generating multilingual voices using speaker space translation based on bilingual speaker data. ICASSP 2020.

- [Miao20] C.Miao, S.Liang, M.Chen, J.Ma, S.Wang, J.Xiao. Flow-TTS: A non-autoregressive network for text to speech based on flow. ICASSP 2020.

- [Morrison20] M.Morrison, Z.Jin, J.Salamon, N.J.Bryan, G.J.Mysore. Controllable neural prosody synthesis. Interspeech 2020.

- [Moss20] H.B.Moss, V.Aggarwal, N.Prateek, J.González, R.Barra-Chicote. BOFFIN TTS: Few-shot speaker adaptation by bayesian optimization. ICASSP 2020.

- [Nekvinda20] T.Nekvinda, O.Dušek. One model, many languages: Meta-learning for multilingual text-to-speech. Interspeech 2020.

- [Park20] K.Park, S.Lee. G2PM: A neural grapheme-to-phoneme conversion package for mandarin chinese based on a new open benchmark dataset. Interspeech 2020.

- [Paul20a] D.Paul, Y.Pantazis, Y.Stylianou. Speaker Conditional WaveRNN: Towards universal neural vocoder for unseen speaker and recording conditions. Interspeech 2020.

- [Paul20b] D.Paul, M.P.V.Shifas, Y.Pantazis, Y.Stylianou. Enhancing speech intelligibility in text-to-speech synthesis using speaking style conversion. Interspeech 2020.

- [Peng20] K.Peng, W.Ping, Z.Song, K.Zhao. Non-autoregressive neural text-to-speech. ICML 2020. [논문리뷰]

- [Ping20] W.Ping, Ka.Peng, K.Zhao, Z.Song. WaveFlow: A compact flow-based model for raw audio. ICML 2020. [논문리뷰]

- [Popov20a] V.Popov, M.Kudinov, T.Sadekova. Gaussian LPCNet for multisample speech synthesis. ICASSP 2020.

- [Popov20b] V.Popov, S.Kamenev, M.Kudinov, S.Repyevsky, T.Sadekova, V.Bushaev, V.Kryzhanovskiy, D.Parkhomenko. Fast and lightweight on-device tts with Tacotron2 and LPCNet. Interspeech 2020.

- [Shen20] J.Shen, Y.Jia, M.Chrzanowski, Y.Zhang, I.Elias, H.Zen, Y.Wu. Non-Attentive Tacotron: Robust and controllable neural TTS synthesis including unsupervised duration modeling. arXiv preprint arXiv:2010.04301, 2020.

- [Song20] E.Song, M.-J.Hwang, R.Yamamoto, J.-S.Kim, O.Kwon, J.- M.Kim. Neural text-to-speech with a modeling-by-generation excitation vocoder. Interspeech 2020.

- [Staib20] M.Staib, T.H.Teh, A.Torresquintero, D.S.R.Mohan, L.Foglianti, R.Lenain, J.Gao. Phonological features for 0-shot multilingual speech synthesis. Interspeech 2020.

- [Sun20a] G.Sun, Y.Zhang, R.J.Weiss, Y.Cao, H.Zen, A.Rosenberg, B.Ramabhadran, Y.Wu. Generating diverse and natural text-to-speech samples using a quantized fine-grained VAE and autoregressive prosody prior. ICASSP 2020.

- [Sun20b] G.Sun, Y.Zhang, R.J.Weiss, Y.Cao, H.Zen, Y.Wu. Fully-hierarchical fine-grained prosody modeling for interpretable speech synthesis. ICASSP 2020.

- [Tian20] Q.Tian, Z.Zhang, L.Heng, L.Chen, S.Liu. FeatherWave: An efficient high-fidelity neural vocoder with multiband linear prediction. Interspeech 2020.

- [Tu20] T.Tu, Y.-J.Chen, A.H.Liu, H.-y.Lee. Semi-supervised learning for multi-speaker text-to-speech synthesis using discrete speech representation. Interspeech 2020.

- [Um20] S.-Y.Um, S.Oh, K.Byun, I.Jang, C.H.Ahn, H.-G.Kang. Emotional speech synthesis with rich and granularized control. ICASSP 2020.

- [Valle20a] R.Valle, K.Shih, R.Prenger, B.Catanzaro. Flowtron: an autoregressive flow-based generative network for text-to-speech synthesis. arXiv preprint arXiv:2005.05957, 2020.

- [Valle20b] R.Valle, J.Li, R.Prenger, B.Catanzaro. Mellotron: Multispeaker expressive voice synthesis by conditioning on rhythm, pitch and global style tokens. ICASSP 2020.

- [Vipperla20] R.Vipperla, S.Park, K.Choo, S.Ishtiaq, K.Min, S.Bhattacharya, A.Mehrotra, A.G.C.P.Ramos, N.D.Lane. Bunched LPCNet: Vocoder for low-cost neural text-to-speech systems. Interspeech 2020.

- [Wu20] Y.-C.Wu, T.Hayashi, T.Okamoto, H.Kawai, T.Toda. Quasi-periodic Parallel WaveGAN vocoder: A non-autoregressive pitch-dependent dilated convolution model for parametric speech generation. Interspeech 2020.

- [Xiao20] Y.Xiao, L.He, H.Ming, F.K.Soong. Improving prosody with linguistic and BERT derived features in multi-speaker based Mandarin Chinese neural TTS. ICASSP 2020.

- [Xu20] J.Xu, X.Tan, Y.Ren, T.Qin, J.Li, S.Zhao, T.-Y.Liu. LRSpeech: Extremely low-resource speech synthesis and recognition. ACM SIGKDD International Conference on Knowledge Discovery & Data Mining 2020.

- [Yamamoto20] R.Yamamoto, E.Song, and J.M.Kim. Parallel WaveGAN: A fast waveform generation model based on generative adversarial networks with multi-resolution spectrogram. ICASSP 2020.

- [Yang20a] J.Yang, J.Lee, Y.Kim, H.-Y.Cho, I.Kim. VocGAN: A high-fidelity real-time vocoder with a hierarchically-nested adversarial network. Interspeech 2020.

- [Yang20b] J.Yang, L.He. Towards universal text-to-speech. Interspeech 2020.

- [Yu20] C.Yu, H.Lu, N.Hu, M.Yu, C.Weng, K.Xu, P.Liu, D.Tuo, S.Kang, G.Lei, D.Su, D.Yu. DurIAN: Duration informed attention network for speech synthesis. Interspeech 2020.

- [Zhang20a] H.Zhang, Y.Lin. Unsupervised learning for sequence-to-sequence text-to-speech for low-resource languages. Interspeech 2020.

- [Zhang20b] Z.Zhang, Q.Tian, H.Lu, L.-H.Chen, S.Liu. AdaDurIAN: Few-shot adaptation for neural text-to-speech with durian. arXiv preprint arXiv:2005.05642, 2020.

- [Zhai20] B.Zhai, T.Gao, F.Xue, D.Rothchild, B.Wu, J.E.Gonzalez, K.Keutzer. SqueezeWave: Extremely lightweight vocoders for on-device speech synthesis. arXiv preprint arXiv:2001.05685, 2020.

- [Zhao20] S.Zhao, T.H.Nguyen, H.Wang, B.Ma. Towards natural bilingual and code-switched speech synthesis based on mix of monolingual recordings and cross-lingual voice conversion. Interspeech 2020.

- [Zeng20] Zhen Zeng, Jianzong Wang, Ning Cheng, Tian Xia, and Jing Xiao. AlignTTS: Efficient feed-forward text-to-speech system without explicit alignment. ICASSP 2020.

- [Zhou20] X.Zhou, X.Tian, G.Lee, R.K.Das, H.Li. End-to-end code-switching TTS with cross-lingual language model. ICASSP 2020.

- [Achanta21] S.Achanta, A.Antony, L.Golipour, J.Li, T.Raitio, R.Rasipuram, F.Rossi, J.Shi, J.Upadhyay, D.Winarsky, H.Zhang. On-device neural speech synthesis. IEEE Workshop on Automatic Speech Recongnition and Understanding 2021.

- [Bak21] T.Bak, J.-S.Bae, H.Bae, Y.-I.Kim, H.-Y.Cho. FastPitchFormant: Source-filter based decomposed modeling for speech syntehsis. Interspeech 2021.

- [Bae21] J.-S.Bae, T.-J.Bak, Y.-S.Joo, H.-Y.Cho. Hierarchical context-aware transformers for non-autoregressive text to speech. Interspeech 2021.

- [Casanova21] E.Casanova, C.Shulby, E.Gölge, N.M.Müller,F.S.de Oliveira, A.C.Junior, A.d.Soares, S.M.Aluisio, M.A.Ponti. SC-GlowTTS: an efficient zero-shot multi-speaker text-to-speech model. Interspeech 2021.

- [Chen21a] N.Chen, Y.Zhang, H.Zen, R.J.Weiss, M.Norouzi, W.Chan. WaveGrad: Estimating gradients for waveform generation. ICLR 2021.

- [Chen21b] M.Chen, X.Tan, B.Li, Y.Liu, T.Qin, S.Zhao, T.-Y.Liu. AdaSpeech: Adaptive text to speech for custom voice. ICLR 2021.

- [Chien21] C.-M.Chien, J.-H.Lin, C.-y.Huang, P.-c.Hsu, H.-y.Lee. Investigating on incorporating pretrained and learnable speaker representations for multi-speaker multi-style text-to-speech. ICASSP 2021.

- [Christidou21] M.Christidou, A.Vioni, N.Ellinas, G.Vamvoukakis, K.Markopoulos, P.Kakoulidis, J.S.Sung, H.Park, A.Chalamandaris, P.Tsiakoulis. Improved Prosodic Clustering for Multispeaker and Speaker-Independent Phoneme-Level Prosody Control. SPECOM 2021.

- [Donahue21] J.Donahue, S.Dieleman, M.Binkowski, E.Elsen, K.Simonyan. End-to-end adversarial text-to-speech. ICLR 2021.

- [Du21] Chenpeng Du and Kai Yu. Rich prosody diversity modelling with phone-level mixture density network. Interspeech 2021.

- [Elias21a] I.Elias, H.Zen, J.Shen, Y.Zhang, Y.Jia, R.Weiss, Y.Wu. Parallel Tacotron: Non-autoregressive and controllable TTS. ICASSP 2021.

- [Elias21b] I.Elias, H.Zen, J.Shen, Y.Zhang, Y.Jia, R.J.Skerry-Ryan, Y.Wu. Parallel Tacotron 2: A non-autoregressive neural tts model with differentiable duration modeling. Interspeech 2021.

- [Hu21] Q.Hu, T.Bleisch, P.Petkov, T.Raitio, E.Marchi, V.Lakshminarasimhan. Whispered and lombard neural speech synthesis. IEEE Spoken Language Technology Workshop (SLT) 2021.

- [Huang21] Z.Huang, H.Li, M.Lei. DeviceTTS: A small-footprint, fast, stable network for on-device text-to-speech. ICASSP 2021.

- [Huybrechts21] G.Huybrechts, T.Merritt, G.Comini, B.Perz, R.Shah, J.Lorenzo-Trueba. Low-resource expressive text-to-speech using data augmentation. ICASSP 2021.

- [Hwang21a] M.-J.Hwang, R.Yamamoto, E.Song, J.-M.Kim. TTS-by-TTS: Tts-driven data augmentation for fast and high-quality speech synthesis. ICASSP 2021.

- [Hwang21b] M.-J.Hwang, R.Yamamoto, E.Song, J.-M.Kim. High-fidelity Parallel WaveGAN with multi-band harmonic-plus-noise model. Interspeech 2021.

- [Jang21] W.Jang, D.Lim, J.Yoon, B.Kim, J.Kim. UnivNet: A neural vocoder with multi-resolution spectrogram discriminators for high-fidelity waveform generation. Interspeech 2021.

- [Jeong21] M.Jeong, H.Kim, S.J.Cheon, B.J.Choi, N.S.Kim. Diff-TTS: A Denoising diffusion model for text-to-speech. Interspeech 2021.

- [Jia21] Y.Jia, H.Zen, J.Shen, Y.Zhang, Y.Wu. PnG BERT: Augmented bert on phonemes and graphemes for neural TTS. arXiv preprint arXiv:2103.15060, 2021.

- [Kang21] M.Kang, J.Lee, S.Kim, I.Kim. Fast DCTTS: Efficient deep convolutional text-to-speech. ICASSP 2021.

- [Kim21a] J.Kim, J.Kong, J.Son. Conditional variational autoencoder with adversarial learning for end-to-end text-to-speech. ICML 2021.

- [Kim21b] J.-H.Kim, S.-H.Lee, J.-H.Lee, S.-W.Lee. Fre-GAN: Adversarial frequency-consistent audio synthesis. Interspeech 2021.

- [Kim21c] M.Kim, S.J.Cheon, B.J.Choi, J.J.Kim, N.S.Kim. Expressive text-to-speech using style tag. Interspeech 2021.

- [Kim21d] H.-Y.Kim, J.-H.Kim, J.-M.Kim. NN-KOG2P: A novel grapheme-to-phoneme model for Korean language. ICASSP 2021.

- [Kong21] Z.Kong, W.Ping, J.Huang, K.Zhao, B.Catanzaro. DiffWave: A versatile diffusion model for audio synthesis. ICLR 2021.

- [Łancucki21] A.Łancucki. FastPitch: Parallel text-to-speech with pitch prediction. ICASSP 2021.

- [Lee21a] Y.Lee, J.Shin, K.Jung. Bidirectional variational inference for non-autoregressive text-to-speech. ICLR 2021.

- [Lee21b] S.-H.Lee, H.-W.Yoon, H.-R.Noh, J.-H. Kim, S.-W.Lee. Multi-SpectroGAN: High-diversity and high-fidelity spectrogram generation with adversarial style combination for speech synthesis. AAAI 2021.

- [Lee21c] K.Lee, K.Park, D.Kim. Styler: Style modeling with rapidity and robustness via speech decomposition for expressive and controllable neural text to speech. Interspeech 2021.

- [Li21a] T.Li, S.Yang, L.Xue, L.Xie. Controllable emotion transfer for end-to-end speech synthesis. International Symposium on Chinese Spoken Language Processing (ISCSLP) 2021.

- [Li21b] X.Li, C.Song, J.Li, Z.Wu, J.Jia, H.Meng. Towards multiscale style control for expressive speech synthesis. Interspeech, 2021.

- [Liu21] Y.Liu, Z.Xu, G.Wang, K.Chen, B.Li, X.Tan, J.Li, L.He, S.Zhao. DelightfulTTS: The Microsoft speech synthesis system for Blizzard challenge 2021. arXiv preprint arXiv:2110.12612, 2021.

- [Luo21] R.Luo, X.Tan, R.Wang, T.Qin, J.Li, S.Zhao, E.Chen, T.-Y.Liu. LightSpeech: Lightweight and fast text to speech with neural architecture search. ICASSP 2021.

- [Miao21] C.Miao, S.Liang, Z.Liu, M.Chen, J.Ma, S.Wang, J.Xiao. EfficientTTS: An efficient and high-quality text-to-speech architecture. ICML 2021.

- [Min21] D.Min, D.B.Lee, E.Yang, S.J.Hwang. Meta-StyleSpeech: Multi-speaker adaptive text-to-speech generation. ICML 2021.

- [Morisson21] M.Morrison, Z.Jin, N.J.Bryan, J.-P.Caceres, B.Pardo. Neural pitch-shifting and time-stretching with controllable LPCNet. arXiv preprint arXiv:2110.02360, 2021.

- [Nguyen21] H.-K.Nguyen, K.Jeong, S.Um, M.-J.Hwang, E.Song, H.-G.Kang. LiteTTS: A lightweight mel-spectrogram-free text-to-wave synthesizer based on generative adversarial networks. Interspeech 2021.

- [Pan21] S.Pan, L.He. Cross-speaker style transfer with prosody bottleneck in neural speech synthesis. Interspeech 2021.

- [Popov21] C.Popov, I.Vovk, V.Gogoryan, T.Sadekova, M.Kudinov. Grad-TTS: A diffusion probabilistic model for text-to-speech. ICML 2021.

- [Ren21a] Y.Ren, C,Hu, X.Tan, T.Qin, S.Zhao, Z.Zhao, T.-Y.Liu. FastSpeech 2: Fast and high-quality end-to-end text to speech. ICLR 2021.

- [Ren21b] Y.Ren, J.Liu, Z.Zhao. PortaSpeech: Portable and high-quality generative text-to-speech. NeurIPS 2021.

- [Sivaprasad21] S.Sivaprasad, S.Kosgi, V.Gandhi. Emotional prosody control for speech generation. Interspeech 2021.

- [Song21] E.Song, R.Yamamoto, M.-J.Hwang, J.-S.Kim, O.Kwon, J.- M.Kim. Improved Parallel WaveGAN vocoder with perceptually weighted spectrogram loss. IEEE Spoken Language Technology Workshop (SLT) 2021.

- [Tan21] X.Tan, T.Qin, F.Soong, T.-Y. Liu. A survey on neural speech synthesis. arXiv: 2106.15561v3.

- [Wang21] D.Wang, L.Deng, Y.Zhang, N.Zheng, Y.T.Yeung, X.Chen, X.Liu, H.Meng. FCL-Taco2: Towards fast, controllable and lightweight text-to-speech synthesis. ICASSP 2021.

- [Weiss21] R.J.Weiss, R.J.Skerry-Ryan, E.Battenberg, S.Mariooryad, D.P.Kingma. Wave-Tacotron: Spectrogram-free end-to-end text-to-speech synthesis. ICASSP 2021.

- [Xu21] G.Xu, W.Song, Z.Zhang, C.Zhang, X.He, B.Zhou. Improving prosody modelling with cross-utterance BERT embeddings for end-to-end speech synthesis. ICASSP 2021.

- [Yamamoto21] R.Yamamoto, E.Song, M.-J.Hwang, J.-M.Kim. Parallel waveform synthesis based on generative adversarial networks with voicing-aware conditional discriminators. ICASSP 2021.

- [Yan21a] Y.Yan, X.Tan, B.Li, T.Qin, S.Zhao, Y.Shen, T.-Y.Liu. AdaSpeech 2: Adaptive text to speech with untranscribed data. ICASSP 2021.

- [Yan21b] Y.Yan, X.Tan, B.Li, G.Zhang, T.Qin, S.Zhao, Y.Shen, W.-Q.Zhang, T.-Y.Liu. AdaSpeech 3: Adaptive text to speech for spontaneous style. Interspeech 2021.

- [Yang21a] G.Yang, S.Yang, K.Liu, P.Fang, W.Chen, L.Xie. Multi-Band MelGAN: Faster waveform generation for high-quality text-to-speech. IEEE Spoken Language Technology Workshop (SLT) 2021.

- [Yang21b] J.Yang, J.-S.Bae, T.Bak, Y.Kim, H.-Y.Cho. GANSpeech: Adversarial training for high-fidelity multi-speaker speech synthesis. Interspeech 2021.

- [Yoneyama21] R.Yoneyama, Y.-C.Wu, T.Toda. Unified source-filter GAN: Unified source-filter network based on factorization of quasi-periodic Parallel WaveGAN. Interspeech 2021.

- [You21] J.You, D.Kim, G.Nam, G.Hwang, G.Chae. GAN Vocoder: Multi-resolution discriminator is all you need. Interspeech 2021.

- [Yue21] F.Yue, Y.Deng, L.He, T.Ko. Exploring machine speech chain for domain adaptation and few-shot speaker adaptation. arXiv preprint arXiv:2104.03815, 2021.

- [Zaidi21] J.Zaidi, H.Seute, B.van Niekerk, M.-A.Carbonneau. Daft-Exprt: Cross-speaker prosody transfer on any text for expressive speech synthesis. arXiv preprint arXiv:2108.02271, 2021.

- [Zhang21a] C.Zhang, X.Tan, Y.Ren, T.Qin, K.Zhang, T.-Y.Liu. UWSpeech: Speech to speech translation for unwritten languages. AAAI 2021.

- [Zhang21b] G.Zhang, Y.Qin, D.Tan, T.Lee. Applying the information bottleneck principle to prosodic representation learning. arXiv preprint arXiv:2108.02821, 2021.

- [Zeng21] Z.Zeng, J.Wang, N.Cheng, J.Xiao. LVCNet: Efficient condition-dependent modeling network for waveform generation. ICASSP 2021.

- [Bae22] J.-S.Bae, J.Yang, T.-J.Bak, Y.-S.Joo. Hierarchical and multi-scale variational autoencoder for diverse and natural non-autoregressive text-to-speech. Interspeech 2022.

- [Cho22] H.Cho, W.Jung, J.Lee, S.H.Woo. SANE-TTS: Stable and natural end-to-end multilingual text-to-speech. Interspeech 2022.

- [Comini22] G.Comini, G.Huybrechts, M.S.Ribeiro, A.Gabrys, J.Lorenzo-Trueba. Low-data? No problem: low-resource, language-agnostic conversational text-to-speech via F0-conditioned data augmentation. Interspeech 2022.

- [Dai22] Z.Dai, J.Yu, Y.Wang, N.Chen, Y.Bian, G.Li, D.Cai, D.Yu. Automatic prosody annotation with pre-trained text-speech model. Interspeech 2022.

- [Hsu22] P.-C.Hsu, D.-R.Liu, A.T.Liu, H.-y.Lee. Parallel synthesis for autoregressive speech generation. arXiv preprint arXiv:2204.11806, 2022.

- [Huang22a] R.Huang, M.W.Y.Lam, J.Wang, D.Su, D.Yu, Y.Ren, Z.Zhao. FastDiff: A fast conditional diffusion model for high-quality speech synthesis. International Joint Conference on Artificial Intelligence 2022.

- [Huang22b] R.Huang, Y.Ren, J.Liu, C.Cui, Z.Zhao. GenerSpeech: Towards style transfer for generalizable out-of-domain TTS synthesis. arXiv preprint arXiv:2205.07211, 2022.

- [Kharitonov22] E.Kharitonov, A.Lee, A.Polyak, Y.Adi, J.Copet, K.Lakhotia, T.-A.Nguyen, M.Riviere, A.Mohamed, E.Dupoux, W.-N.Hsu. Text-free prosody-aware generative spoken language modeling. Annual Meeting of the Association for Computational Linguistics (ACL) 2022.

- [Kim22a] H.Kim, S.Kim, S.Yoon. Guided-TTS: A diffusion model for text-to-speech via classifier guidance. ICML 2022.

- [Kim22b] S.Kim, H.Kim, S.Yoon. Guided-TTS 2: A diffusion model for high-quality adaptive text-to-speech with untranscribed data. arXiv preprint arXiv:2205.15370, 2022.

- [Koch22] J.Koch, F.Lux, N.Schauffler, T.Bernhart, F.Dieterle, J.Kuhn, S.Richter, G.Viehhauser, N.T.Vu. PoeticTTS: Controllable poetry reading for literary studies. Interspeech 2022.

- [Lam22] M.W.Y.Lam, J.Wang, D.Su, D.Yu. BDDM: Bilateral denoising diffusion models for fast and high-quality speech synthesis. ICLR 2022.

- [Lee22a] S.-G.Lee, H.Kim, C.Shin, X.Tan, C.Liu, Q.Meng, T.Qin, W.Chen, S.Yoon, T.-Y.Liu. PriorGrad: Improving conditional denoising diffusion models with data-driven adaptive prior. ICLR 2022.

- [Lee22b] S.-G.Lee, W.Ping, B.Ginsburg, B.Catanzaro, S.Yoon. BigVGAN: A universal neural vocoder with large-scale training. arXiv preprint arXiv:2206.04658, 2022.

- [Lei22] Y.Lei, S.Yang, X.Wang, MsEmoTTS: Multi-scale emotion transfer, prediction, and control for emotional speech synthesis. IEEE/ACM Transactions on Audio, Speech and Language Process Vol.30, 2022.

- [Li22a] Y.A.Li, C.Han, N.Mesgarani. StyleTTS: A style-based generative model for natural and diverse text-to-speech synthesis. arXiv preprint arXiv:2205.15439, 2022.

- [Li22b] T.Li, X.Wang, Q.Xie, Z.Wang, M.Jiang, L.Xie. Cross-speaker emotion transfer based on prosody compensation for end-to-end speech synthesis. arXiv preprint arXiv:2207.01198, 2022.

- [Li22c] X.Li, C.Song, X.Wei, Z.Wu, J.Jia, H.Meng. Towards cross-speaker reading style transfer on audiobook dataset. Interspeech 2022.

- [Lian22] J.Lian, C.Zhang ,G.K.Anumanchipalli, D.Yu. UTTS: Unsupervised TTS with conditional disentangled sequential variational auto-encoder. arXiv preprint arXiv:2206.02512, 2022.

- [Lim22] D.Lim, S.Jung, E.Kim. JETS: Jointly training FastSpeech2 and HiFi-GAN for end-to-end text-to-speech. Interspeech 2022.

- [Liu22a] S.Liu, D.Su, D.Yu. DiffGAN-TTS: High-fidelity and efficient text-to-speech with denoising diffusion GANs. arXiv preprint arXiv:2201.11972, 2022.

- [Liu22b] Y.Liu, R.Xue, L.He, X.Tan, S.Zhao. DelightfulTTS 2: End-to-end speech synthesis with adversarial vector-quantized auto-encoders. Interspeech 2022.

- [Lu22] Z.Lu, M.He, R.Zhang, C.Gong. A post auto-regressive GAN vocoder focused on spectrum fracture. arXiv preprint arXiv:2204.06086, 2022.

- [Lux22] F.Lux, J.Koch, N.T.Vu. Prosody cloning in zero-shot multispeaker text-to-speech. arXiv preprint arXiv:2206.12229, 2022.

- [Mehta22] S.Mehta, E.Szekely, J.Beskow, G.E.Henter. Neural HMMs are all you need (for high-quality attention-free TTS). ICASSP 2022.

- [Mitsui22] K.Mitsui, T.Zhao, K.Sawada, Y.Hono, Y.Nankaku, K.Tokuda. End-to-end text-to-speech based on latent representation of speaking styles using spontaneous dialogue. Interspeech 2022.

- [Morrison22] M.Morrison, R.Kumar, K.Kumar, P.Seetharaman, A.Courville, Y.Bengio. Chunked autoregressive GAN for conditional waveform synthesis. ICLR 2022.

- [Nishimura22] Y.Nishimura, Y.Saito, S.Takamichi, K.Tachibana, H.Saruwatari. Acoustic modeling for end-to-end empathetic dialogue speech synthesis using linguistic and prosodic contexts of dialogue history. Interspeech 2022.

- [Raitio22] T.Raitio, J.Li, S.Seshadri. Hierarchical prosody modeling and control in non-autoregressive parallel neural TTS. ICASSP 2022.

- [Ren22] Y.Ren, M.Lei, Z.Huang, S.Zhang, Q.Chen, Z.Yan, Z.Zhao. ProsoSpeech: Enhancing prosody with quantized vector pre-training in TTS. ICASSP 2022.

- [Ribeiro22] M.S.Ribeiro, J.Roth, G.Comini, G.Huybrechts, A.Gabrys, J.Lorenzo-Trueba. Cross-speaker style transfer for text-to-speech using data augmentation. ICASSP 2022.

- [Saeki22] T.Saeki, K.Tachibana, R.Yamamoto. DRSpeech: Degradation-robust text-to-speech synthesis with frame-level and utterance-level acoustic representation learning. Interspeech 2022.

- [Shin22] Y.Shin, Y.Lee, S.Jo, Y.Hwang, T.Kim. Text-driven emotional style control and cross-speaker style transfer in neural TTS. Interspeech 2022.

- [Song22] E.Song, R.Yamamoto, O.Kwon, C.-H.Song, M.-J.Hwang, S.Oh, H.-W.Yoon, J.-S.Kim, J.-M.Kim. TTS-by-TTS 2: Data-selective augmentation for neural speech synthesis using ranking Support Vector Machine with variational autoencoder. Interspeech 2022.

- [Tan22] X.Tan, J.Chen, H.Liu, J.Cong, C.Zhang, Y.Liu, X.Wang, Y.Leng, Y.Yi, L.He, F.Soong, T.Qin, S.Zhao, T.-Y.Liu. NaturalSpeech: End-to-end text to speech synthesis with human-level quality. arXiv preprint arXiv:2205.04421, 2022.

- [Terashima22] R.Terashima, R.Yamamoto, E.Song, Y.Shirahata, H.-W.Yoon, J.-M.Kim, K.Tachibana. Cross-speaker emotion transfer for low-resource text-to-speech using non-parallel voice conversion with pitch-shift data augmentation. Interspeech 2022.

- [Valin22] J.-M.Valin, U.Isik, P.Smaragdis, A.Krishnaswamy. Neural speech synthesis on a shoestring: Improving the efficiency of LPCNET. ICASSP 2022.

- [Wang22] Y.Wang, Y.Xie, K.Zhao, H.Wang, Q.Zhang. Unsupervised quantized prosody representation for controllable speech synthesis. IEEE International Conference on Multimedia and Expo (ICME) 2022.

- [Wu22a] Y.Wu, X.Tan, B.Li, L.He, S.Zhao, R.Song, T.Qin, T.-Y.Liu. AdaSpeech 4: Adaptive text to speech in zero-shot scenarios. arXiv preprint arXiv:2204.00436, 2022.

- [Wu22b] S.Wu, Z.Shi. ItoWave: Ito stochastic differential equation is all you need for wave generation. ICASSP 2022.

- [Xie22] Q.Xie, T.Li, X.Wang, Z.Wang, L.Xie, G.Yu, G.Wan. Multi-speaker multi-style text-to-speech synthesis with single-speaker single-style training data scenarios. ICASSP 2022.

- [Yang22] J.Yang, L.He. Cross-lingual TTS using multi-task learning and speaker classifier joint training. arXiv preprint arXiv:2201.08124, 2022.

- [Ye22] Z.Ye, Z.Zhao, Y.Ren, F.Wu. SyntaSpeech: Syntax-aware generative adversarial text-to-speech. International Joint Conference on Artificial Intelligence 2022.

- [Yoon22] H.-W.Yoon, O.Kwon, H.Lee, R.Yamamoto, E.Song, J.-M.Kim, M.-J.Hwang. Language model-based emotion prediction methods for emotional speech synthesis systems. Interspeech 2022.

- [Zhang22] G.Zhang, Y.Qin, W.Zhang, J.Wu, M.Li, Y.Gai, F.Jiang, T.Lee. iEmoTTS: Toward robust cross-speaker emotion transfer and control for speech synthesis based on disentanglement between prosody and timbre. arXiv preprint arXiv:2206.14866, 2022.

![buuctf_练[网鼎杯 2018]Fakebook](https://img-blog.csdnimg.cn/img_convert/1a5f64a4e5dd37ddb8c4fcd6498e6ef0.png)