【Transformer】医学分割领域的应用与扩展(论文阅读)(二) || DETR

news2026/2/15 16:00:41

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/112501.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

【python圣诞树的实现】

🤵♂️ 个人主页老虎也淘气 个人主页 ✍🏻作者简介:Python学习者 🐋 希望大家多多支持我们一起进步!😄 如果文章对你有帮助的话, 欢迎评论 💬点赞👍🏻 收藏…

拒不外传,阿里内部耗重金找人总结出这份并发编程手册(全彩版)

并发世界很有趣,不要错过

前言:

时间飞逝,转眼间毕业七年多,从事 Java 开发也六年了。我在想,也是时候将自己的 Java 整理成一套体系。 这一次的知识体系面试题涉及到 Java 知识部分、性能优化、微服务、并发编程、开…

python常用模块

time模块

常用操作 1.直接获取时间

time.time() #获取结果是秒数,即从1970年1月1日8:00起计#1671856010.9592516 2.获取结构化时间 time.localtime() #获取本地时间,中国为东八区,为上海时间 time.gmtime() …

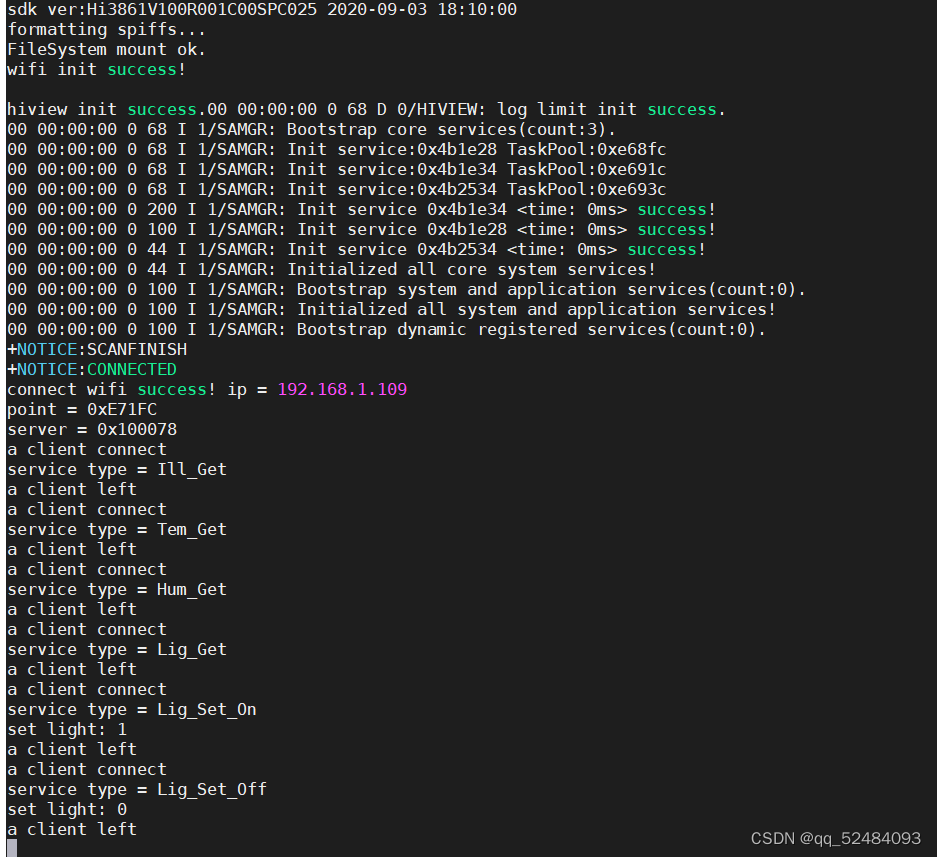

客户端服务端交互实现

问题

客户端业务逻辑如何实现?

与服务设备具体交互细节如何设计? 客户端业务逻辑实现

用户输入处理

字符串空格处理,分割获取命令与参数

服务信息处理

字符串预处理,分割获取服务命令存储服务命令与设备地址之间的映射(命令字…

Java Socket实现NIO通信

文章目录一.简单介绍通道(Channel)多路复用器(Selector)二.代码实现.客户端服务端运行结果一.简单介绍 NIO 很多人也称之为 Non-block I/O,即非阻塞 I/O,因为这样叫,更能体现它的特点。

为什么…

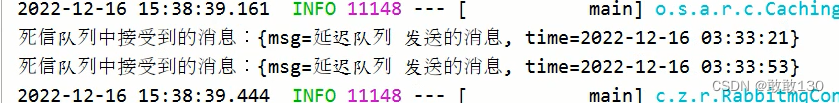

RabbitMQ——延迟队列

目录 一、延迟队列的应用场景

1. 场景:"订单下单成功后,15分钟未支付自动取消"

① 传统处理超时订单

② RabbitMQ延时队列方案

二、延迟队列中的消息投递和消息消费

1.TTL 和 DLX ① TTL

② DLX和死信队列

③ 延迟队列

④ 开发步骤 …

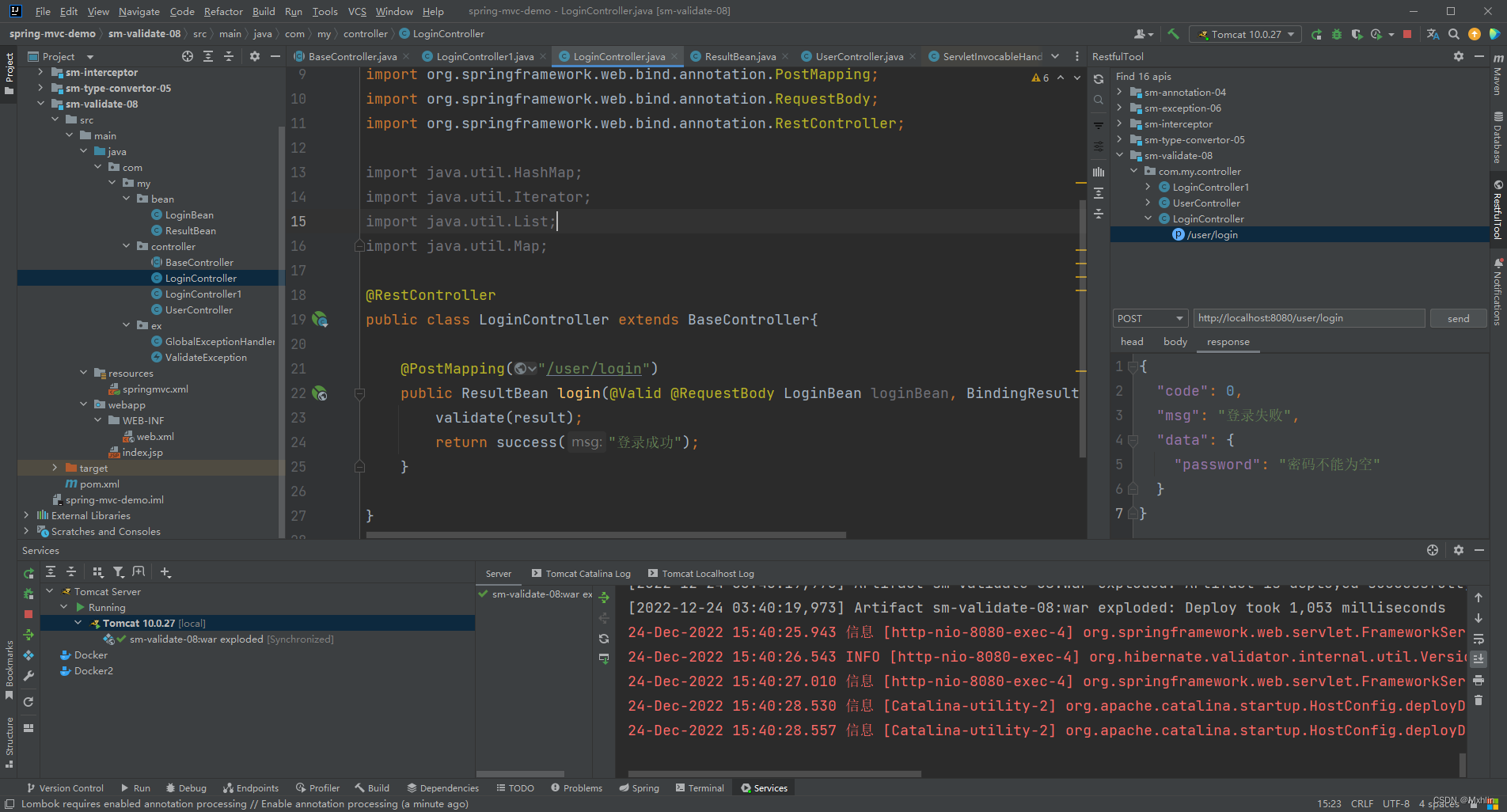

spring mvc 通过异常封装 验证 方法

正常情况 我们先演示一下正常情况下我们验证的方法。 首先定义一个LoginBean

Data

public class LoginBean {// Blank 不允许保存空格,空格不算内容NotBlank(message "用户名不能为空")String username;// Empty 允许保留空格,是空格也算内容…

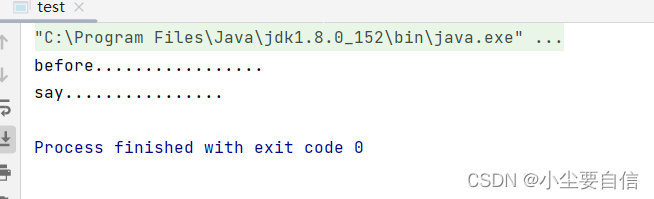

【Spring】核心部分之AOP:通过列举代码例子,从底层刨析,深入源码,轻轻松松理解Spring的核心AOP,AOP有这一篇足以

AOP基本概念基本原理专业术语案例演示基于注解(重点)基于配置文件基本概念

面向切面编程,也叫面向方面编程,利用aop可以对业务逻辑的各个部分进行隔离,从而使得业务逻辑各个部分之间降低耦合,提高程序的可…

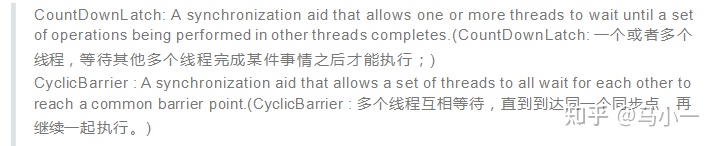

AQS 对资源的共享方式

AQS 定义两种资源共享方式

1) Exclusive(独占)

只有一个线程能执行,如 ReentrantLock。又可分为公平锁和非公平锁,ReentrantLock 同时支持两种锁,下面以 ReentrantLock 对这两种锁的定义做介绍: 下面来看 ReentrantLock 中相关的…

概要设计说明书(GB8567——88)基于协同的在线表格forture-sheet

概要设计说明书

1引言

1.1编写目的

为了帮助用户更好的了解和使用本在线表格,提高用户与软件的亲和度。 用户手册描述配置和使用改在线表格,以及该软件使用过程中应该注意的一下问题。

1.2背景

说明:

本用户手册所描述的软件系统的名称…

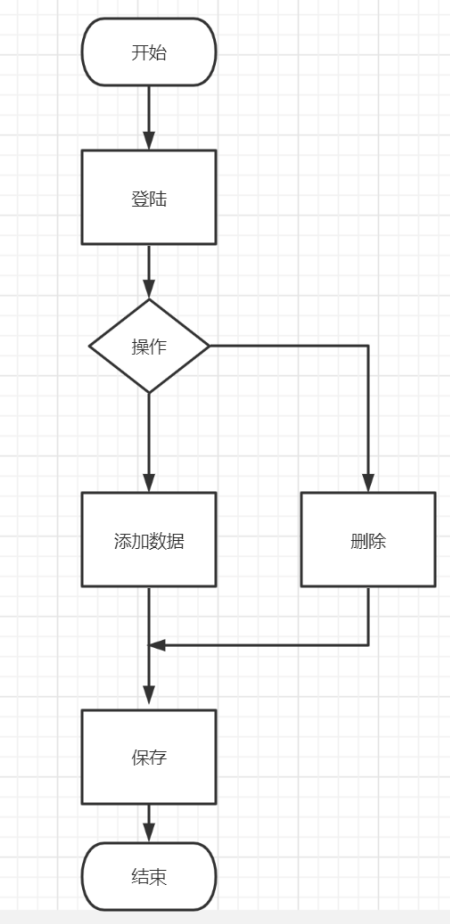

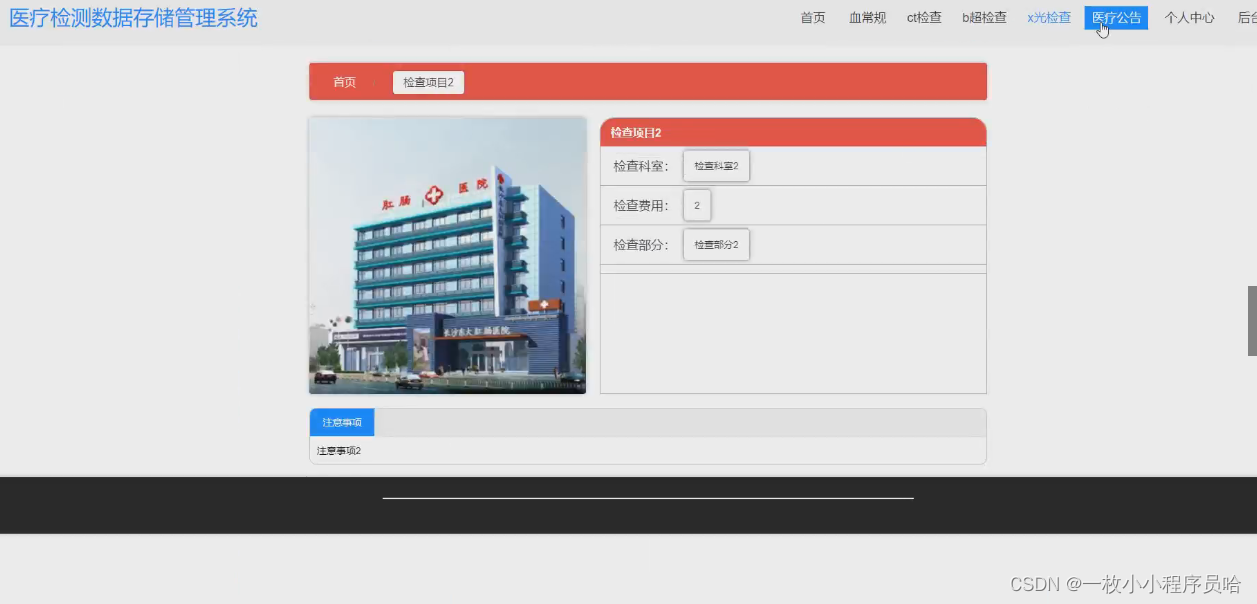

医疗检测数据存储管理系统

摘要 医疗信息化的迅速发展导致了医疗数据的指数型增长,医疗检测数据存储管理系统给医院现有信息系统带了巨大的压力。一方面,随着各种非结构化数据的不断涌现,现有的医疗信息系统在存储空间,存储速度、存储结构上达不到医疗检测数据的要求,不…

Github惊现神作,这份算法宝典让你横扫各大厂算法面试题

时间飞逝,转眼间毕业七年多,从事 Java 开发也六年了。我在想,也是时候将自己的 Java 整理成一套体系。 这一次的知识体系面试题涉及到 Java 知识部分、性能优化、微服务、并发编程、开源框架、分布式等多个方面的知识点。

写这一套 Java 面试…

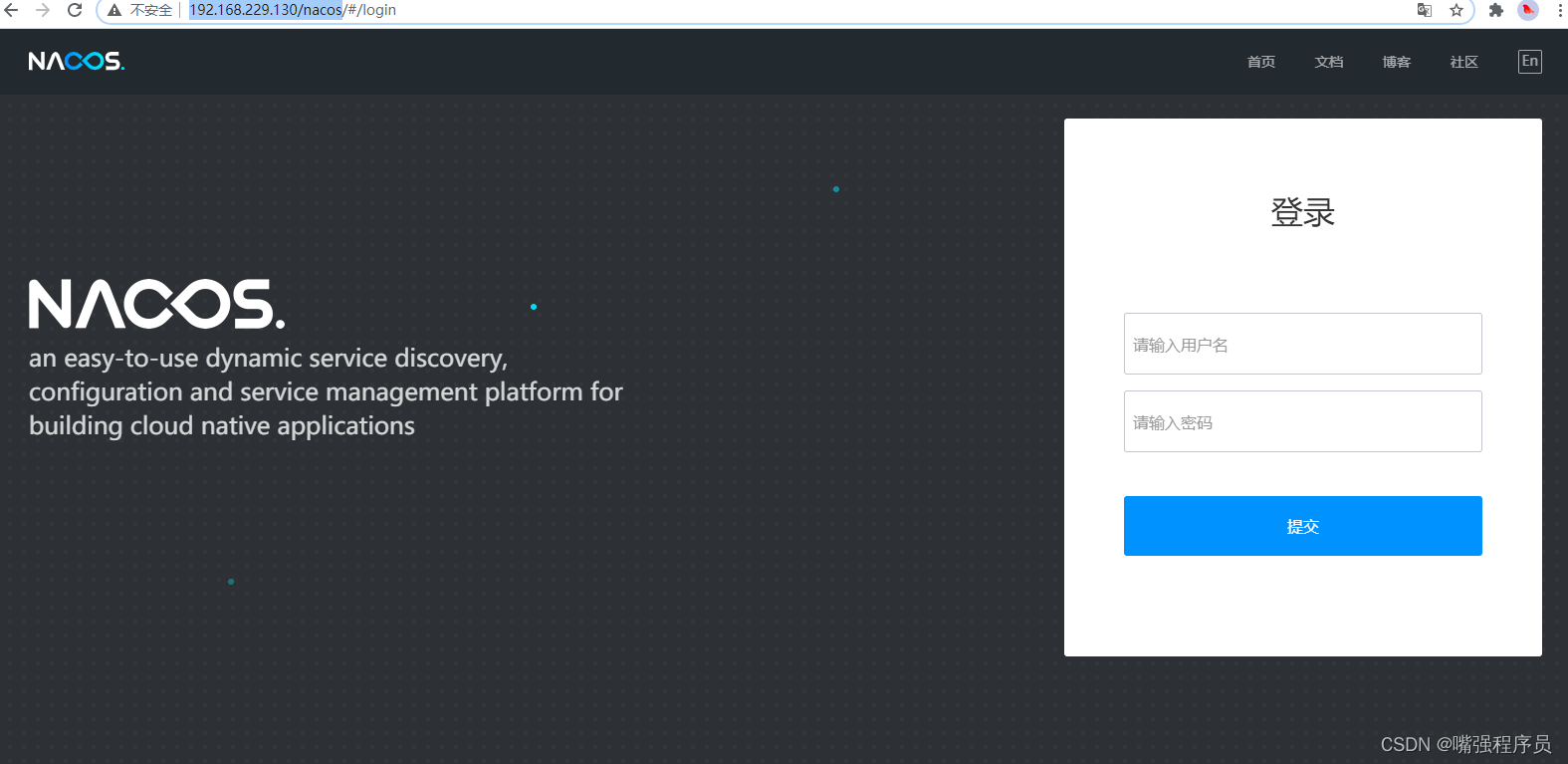

使用Docker搭建Nacos的持久化和集群部署

1. 准备

1.1 mysql安装

下载镜像

docker pull mysql/mysql-server:5.7

在宿主机中相关目录,用于挂载容器的相关数据

mkdir -p /data/mysql/{conf,data}

编写my.cnf配置文件,在/data/mysql/conf目录中 (或下载 直接上传即可)

my.cnf.txt - 蓝奏云 / …

【考研加油】所有上岸的考研人都有一个共同的特点,就是他们都参加考试了。2023考研加油。

声明:为 2023考研的朋友加油!

2023考研加油

今明两天,将是大部分2023考研人,真正“上战场”的时候。

我想,只有经历过的人,才能对这一历程,感同身受吧!

为你们加油!

以下是在QQ空间看到的一组图,与你们共勉。 距考研还有____天! 确定目标院校中…跨考又能如何?…

阿里人在Github分享的Spring Cloud全栈笔记,你想象不到有多全

微服务到底是什么

微服务到底是什么,一直众说纷纭,我们只知道各大企业纷纷追捧和实践微服务架构,有的项目可能使用了Spring Cloud就算是使用微服务了,然后说微服务就是Spring Cloud,有的系统可能越做越像SOAÿ…

RV1126笔记十六:吸烟行为检测及部署<四>

若该文为原创文章,转载请注明原文出处。 转换成onnx模型(windows)

一、查看pt文件

准备好训练好的pt文件,可以用Netron打开看看大概长啥样: 二、模型转换

主要的目的是想把训练好的pt文件转成onnx模型,为后面RV1126的部署做铺垫。

我们是在py38的con…

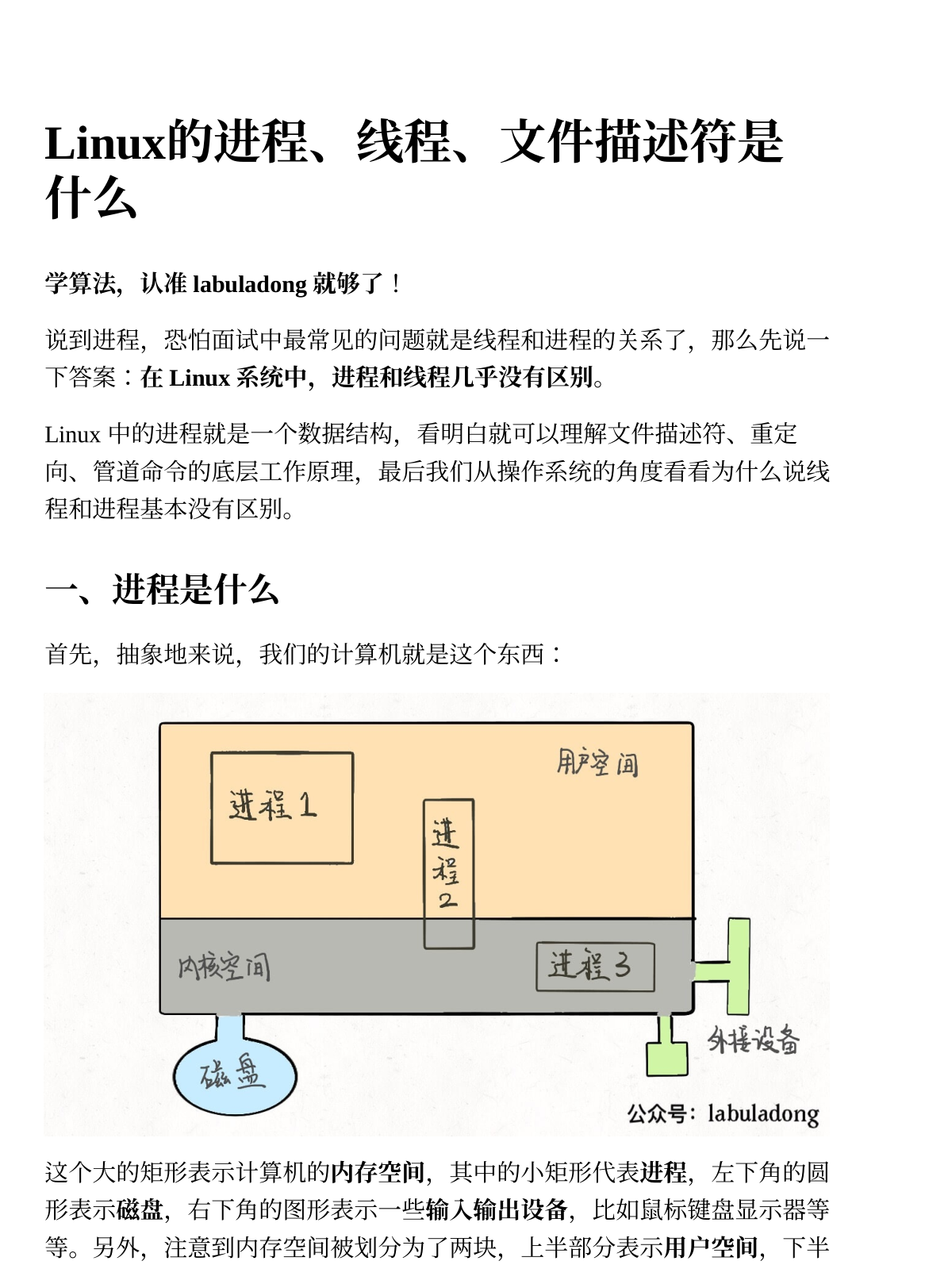

java之多线程的三种不同创建方式and通过多线程模拟龟兔赛跑

Process与Thread:

程序是指令和数据的有序集合,其本身没有任何运行的含义,是一个静态的概念,而进程则是执行程序的一次执行过程,它是一个动态的概念,是系统资源分配的单位,通常在一个进程中可以…

视频素材网,视频剪辑必备。

视频剪辑没素材,推荐6个网站帮你解决,免费可商用,建议收藏! 1、菜鸟图库

视频素材下载_mp4视频大全 - 菜鸟图库 网站有超多视频素材,全部都是高清无水印,各种类型都有,像自然、城市、动物、科技…