目录

一、requests库

二、BeautifulSoup库

三、Scrapy框架

四、selenium库

五、Pyppeteer库

六、Scrapy-Splash库

总结

在当今的大数据时代,爬虫技术已经成为了收集和处理大量数据的重要手段。而选择合适的库可以大大提高爬虫的效率和准确性。本文将介绍一些常用的爬虫库,并分析它们的优缺点,帮助您选择最适合您的爬虫项目的库。

一、requests库

requests库是Python中最常用的HTTP请求库之一,可以轻松地发送各种类型的HTTP请求,包括GET、POST等。它的优点是简单易用、支持异步请求、可以处理HTTP响应等。在爬虫中,requests库可以用来发送HTTP请求并获取网页内容。

import requests

url = 'http://example.com'

response = requests.get(url)

html_content = response.text二、BeautifulSoup库

BeautifulSoup库是一个用于解析HTML和XML文件的库,它提供了简单易用的API来提取HTML或XML文件中的数据。它支持CSS选择器、链式调用等方法,使得网页解析更加方便和高效。

from bs4 import BeautifulSoup

import requests

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.select_one('title').text三、Scrapy框架

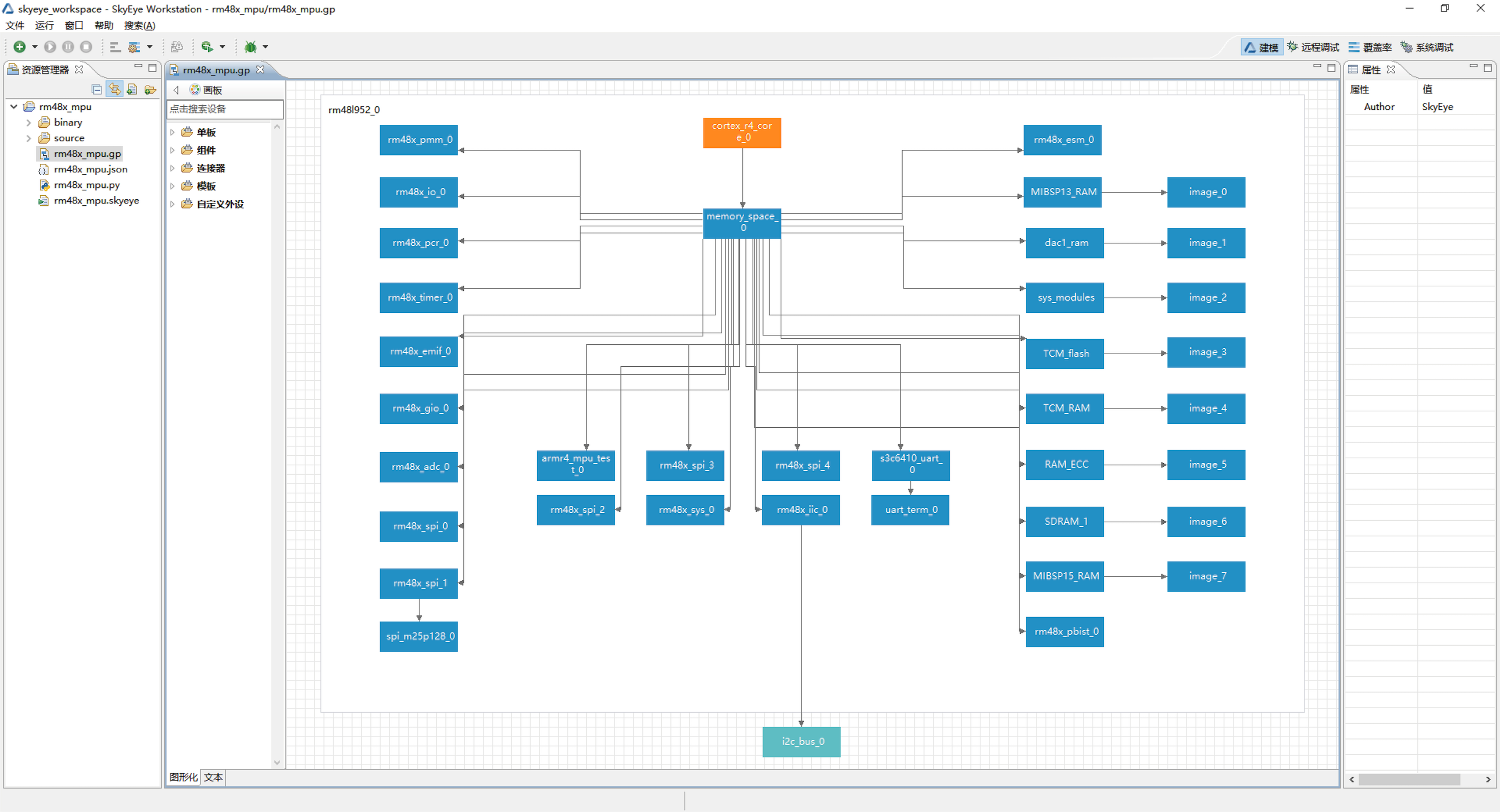

Scrapy框架是一个用于爬取网站并提取结构化数据的库。它提供了丰富的特性,包括跟踪链接、提取数据、存储数据等。Scrapy框架还支持异步请求和响应,可以大大提高爬虫的效率。

import scrapy

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['http://example.com']

def parse(self, response):

title = response.css('title::text').get()

yield {'title': title}四、selenium库

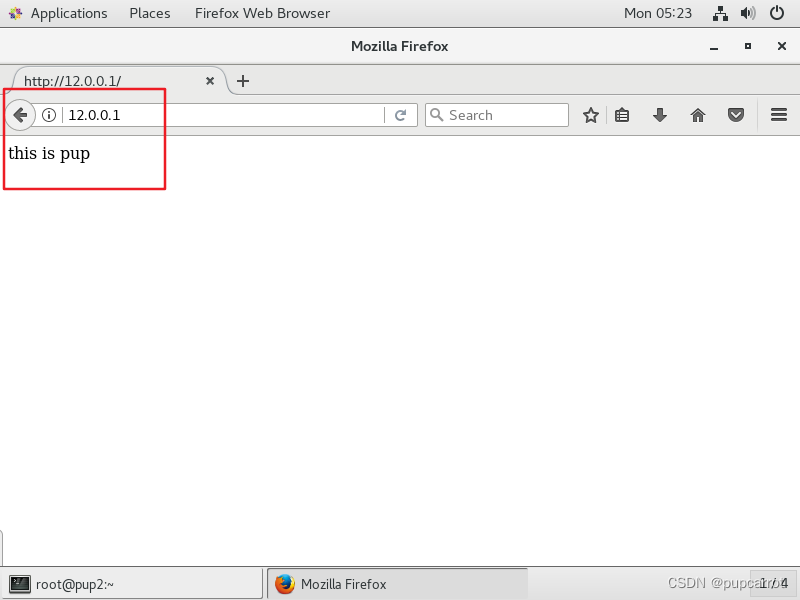

selenium库是一个用于模拟用户操作的库,可以模拟鼠标点击、键盘输入等操作。在爬虫中,selenium库可以用来模拟用户行为,如点击链接、输入表单等。但需要注意的是,由于selenium需要运行浏览器进程,因此在处理大量数据时可能会降低效率。

示例代码:

from selenium import webdriver

import time

driver = webdriver.Chrome()

driver.get('http://example.com')

time.sleep(2) # 等待页面加载完毕

links = driver.find_elements_by_css_selector('a') # 查找所有链接

for link in links: # 遍历链接并打印链接文本

print(link.text)五、Pyppeteer库

Pyppeteer库是一个用于控制Headless Chrome或Chromium浏览器的库。它提供了类似puppeteer的功能,但使用Python接口进行控制。Pyppeteer可以模拟用户行为,如点击链接、输入表单等,并且可以轻松地获取网页截图和页面源代码等。

示例代码:

import asyncio

from pyppeteer import launch

async def main():

browser = await launch()

page = await browser.newPage()

await page.goto('http://example.com')

await page.screenshot({'path': 'example.png'}) # 保存网页截图

await browser.close()

asyncio.get_event_loop().run_until_complete(main())六、Scrapy-Splash库

Scrapy-Splash库是一个用于整合Scrapy框架和Splash渲染引擎的库。Splash是一个基于Qt的渲染引擎,可以渲染出与实际浏览器一致的网页结果。Scrapy-Splash库可以将Splash渲染引擎集成到Scrapy项目中,并支持异步请求和响应。

示例代码:

import scrapy

from scrapy_splash import SplashRequest

class MySpider(scrapy.Spider):

name = 'myspider'

start_urls = ['http://example.com']

def parse(self, response):

yield SplashRequest(url, self.parse_page, args={'wait': 2}) # 等待2秒以加载页面

def parse_page(self, response):

title = response.css('title::text').get()

yield {'title': title}总结

以上是常用的爬虫库及其示例代码。在选择爬虫库时,需要根据具体的需求和场景进行选择。如果需要简单易用的HTTP请求和网页解析功能,requests库和BeautifulSoup库已经足够使用;如果需要处理复杂的爬虫任务,Scrapy框架和Pyppeteer库可以提供更强大的支持;如果需要模拟用户行为或获取网页截图等特殊需求,selenium库和Pyppeteer库可以满足要求。无论选择哪个库,都需要根据实际情况进行选择和调整。