文章目录

- 一、前言

- 二、准备工作

- 三、安装工具与数据迁移Demo

- 安装工具与数据迁移

- 三、使用Datax抽取移动云上的gauss数据库

- 四、Datax工具逻辑说明

- 整体框架

- 核心模板介绍

- 流程调度

- 数据库类型插件读、写说明

- 五、Datax工具参数说明

- Setting

- Reader& writer

- jdbcUrl

- username

- password

- table

- colum

- splitPk

- where

- querySql

- fetchSize

- session

- preSql

- postSql

- writeMode

- batchSize

- 总结

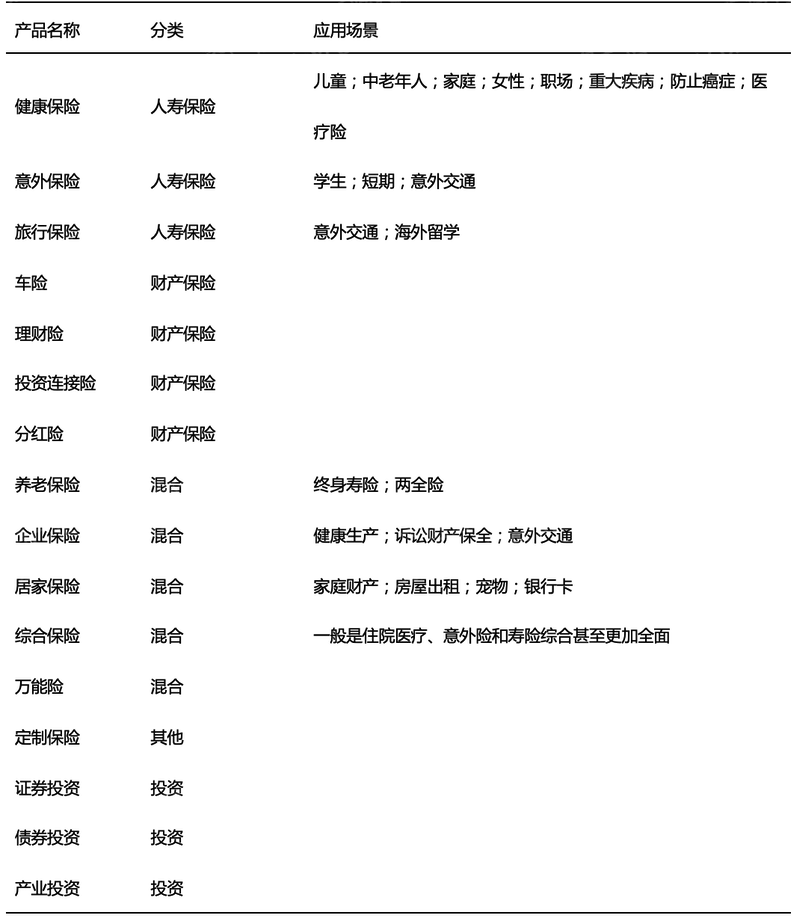

一、前言

在做系统重构时,我们无法避免数据迁移,对于可以直接复制的数据,我们通常会考虑性能稳定的DataX作为迁移工具。

DataX 作为阿里开源的一个异构数据源离线同步工具,能够支持各种异构数据源之间稳定高效的数据同步功能。

本期就来跟大家分享一下DataX数据迁移在实践中的应用。

二、准备工作

项目地址:https://github.com/alibaba/DataX

环境准备:Linux操作系统机器、Java环境(1.8以上,推荐1.8)、python(2或3都可以)

三、安装工具与数据迁移Demo

安装工具与数据迁移

Step1:下载

使用wget工具下载

https://datax-opensource.oss-cn-hangzhou.aliyuncs.com/202210/datax.tar.gz

Step2:解压

使用tar命令解压 tar -zxvf datax.tar.gz

Step3:使用docker命令分别启动一个MySQL容器和OpenGauss容器

1. 启动MySQL容器

docker run -d --name mysql -v /mysql/data:/var/lib/mysql -e MYSQL_ROOT_PASSWORD=123456 -p 3306:3306 mysql:5.7.37

2. 启动OpenGauss容器

docker run --name opengauss --privileged=true -d -e GS_PASSWORD=Enmo@123 -p 15432:5432 enmotech/opengauss:latest

Step4:使用数据库连接工具连接数据库并创建数据表

1. 连接MySQL

2. 连接OpenGauss

Step5:在MySQL中生成demo数据

1. 创建test数据库

create datebase test;

如果数据库中表存在,则删除表:

DROP TABLE IF EXISTS user;

如果存储过程存在,则删除存储过程:

DROP PROCEDURE IF EXISTS prc_crt_user;

2. 创建MySQL表

CREATE TABLE test.user (

uid int(11) NOT NULL auto_increment,

mobile char(11) DEFAULT NULL,

passwd varchar(50) DEFAULT NULL,

name varchar(50) DEFAULT NULL,

sex tinyint DEFAULT NULL,

birthday datetime DEFAULT NULL,

updated_time datetime DEFAULT NULL,

PRIMARY KEY (uid)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

3. 创建存储过程

CREATE PROCEDURE prc_crt_user(l_cnt int)

BEGIN

-- 定义两个变量,一个整型的x默认值为0,另一个char类型的p

DECLARE x INT DEFAULT 0;

DECLARE p char(11);

-- 开始进入循环体,目的是为了生成够输入参数的条数数据

WHILE x < l_cnt

-- 开始执行内容

DO

-- 行数的自增控制标志

SET x = x + 1;

-- 生成手机号 ,如果看不懂的话,多查查这几个函数,太多了解释不过来,下边用到的会在下面解释

SET p =

concat('1',

substring(cast(3 + (rand() * 10) % 7 AS char(50)), 1, 1),

right(left(trim(cast(rand() AS char(50))), 11), 9));

-- 执行插入user表动作 ,因为uid是自增

INSERT INTO user(mobile,

passwd,

name,

sex,

birthday,

updated_time)

VALUES (

p,

-- rand()会生成一个小于1的随机小数 ,ceiling()向上取整,md5()求这个随机整数的md5值当作密码

md5(ceiling(rand() * 1000000)),

-- concat()函数就是拼接函数,它会将里面的参数拼接成一个字符串

concat(

-- substring()求子串,这里是将第一个参数字符串在第二个参数值的位置截取一位

substring(

'赵钱孙李周吴郑王冯陈诸卫蒋沈韩杨朱秦尤许何吕施张孔曹严华金魏陶姜戚谢邹喻柏水窦章云苏潘葛奚范彭郎鲁韦昌马苗凤花方俞任袁柳酆鲍史唐费廉岑薛雷贺倪汤滕殷罗毕郝邬安常乐于时傅皮齐康伍余元卜顾孟平黄和穆萧尹姚邵堪汪祁毛禹狄米贝明臧计伏成戴谈宋茅庞熊纪舒屈项祝董粱杜阮蓝闵席季麻强贾路娄危江童颜郭梅盛林刁钟徐邱骆高夏蔡田樊胡凌霍虞万支柯咎管卢莫经房裘干解应宗丁宣单杭洪包诸左石崔吉钮龚兴位零',

-- 总共有190个字符,为了避免越界需要用190相乘,floor()函数是向下取整

floor(1 + 190 * rand()),

1),

substring(

'明国华建文平志伟东海强晓生光林小民永杰军金健一忠洪江福祥中正振勇耀春大宁亮宇兴宝少剑云学仁涛瑞飞鹏安亚泽世汉达卫利胜敏群波成荣新峰刚家龙德庆斌辉良玉俊立浩天宏子松克清长嘉红山贤阳乐锋智青跃元武广思雄锦威启昌铭维义宗英凯鸿森超坚旭政传康继翔栋仲权奇礼楠炜友年震鑫雷兵万星骏伦绍麟雨行才希彦兆贵源有景升惠臣慧开章润高佳虎根远力进泉茂毅富博霖顺信凡豪树和恩向道川彬柏磊敬书鸣芳培全炳基冠晖京欣廷哲保秋君劲轩帆若连勋祖锡吉崇钧田石奕发洲彪钢运伯满庭申湘皓承梓雪孟其潮冰怀鲁裕翰征谦航士尧标洁城寿枫革纯风化逸腾岳银鹤琳显焕来心凤睿勤延凌昊西羽百捷定琦圣佩麒虹如靖日咏会久昕黎桂玮燕可越彤雁孝宪萌颖艺夏桐月瑜沛诚夫声冬奎扬双坤镇楚水铁喜之迪泰方同滨邦先聪朝善非恒晋汝丹为晨乃秀岩辰洋然厚灿卓杨钰兰怡灵淇美琪亦晶舒菁真涵爽雅爱依静棋宜男蔚芝菲露娜珊雯淑曼萍珠诗璇琴素梅玲蕾艳紫珍丽仪梦倩伊茜妍碧芬儿岚婷菊妮媛莲娟一',

floor(1 + 400 * rand()),

1),

substring(

'明国华建文平志伟东海强晓生光林小民永杰军金健一忠洪江福祥中正振勇耀春大宁亮宇兴宝少剑云学仁涛瑞飞鹏安亚泽世汉达卫利胜敏群波成荣新峰刚家龙德庆斌辉良玉俊立浩天宏子松克清长嘉红山贤阳乐锋智青跃元武广思雄锦威启昌铭维义宗英凯鸿森超坚旭政传康继翔栋仲权奇礼楠炜友年震鑫雷兵万星骏伦绍麟雨行才希彦兆贵源有景升惠臣慧开章润高佳虎根远力进泉茂毅富博霖顺信凡豪树和恩向道川彬柏磊敬书鸣芳培全炳基冠晖京欣廷哲保秋君劲轩帆若连勋祖锡吉崇钧田石奕发洲彪钢运伯满庭申湘皓承梓雪孟其潮冰怀鲁裕翰征谦航士尧标洁城寿枫革纯风化逸腾岳银鹤琳显焕来心凤睿勤延凌昊西羽百捷定琦圣佩麒虹如靖日咏会久昕黎桂玮燕可越彤雁孝宪萌颖艺夏桐月瑜沛诚夫声冬奎扬双坤镇楚水铁喜之迪泰方同滨邦先聪朝善非恒晋汝丹为晨乃秀岩辰洋然厚灿卓杨钰兰怡灵淇美琪亦晶舒菁真涵爽雅爱依静棋宜男蔚芝菲露娜珊雯淑曼萍珠诗璇琴素梅玲蕾艳紫珍丽仪梦倩伊茜妍碧芬儿岚婷菊妮媛莲娟一',

floor(1 + 400 * rand()),

1)),

-- %的意思是取余,很明显值要么是1,要么是0

ceiling(rand() * 10) % 2,

-- 这个是拿现在时间减去 一个随机的年份(20至60之间),再获取日期

date(

now()

- INTERVAL (20 + ceiling(rand() * 100) % 40) YEAR),

concat('2018-',

-- 月份 1至12

1 + ceiling(rand() * 100) % 12,

'-',

-- 天数 ,%28 这个值就只能从一号到28号

1 + ceiling(rand() * 100) % 28))

-- 更新时间取现在时间

ON DUPLICATE KEY UPDATE updated_time = now();

-- 与上面的while对应

END WHILE;

END;

4. 调用存储过程

call prc_crt_user(18535);

5. 查询生成数据

Step6:在gauss数据库中创建目标表

CREATE TABLE "user" (

uid int8 NOT NULL,

mobile char(11) DEFAULT NULL,

passwd varchar(50) DEFAULT NULL,

"name" varchar(50) DEFAULT NULL,

sex int2 DEFAULT NULL,

birthday date DEFAULT NULL,

updated_time date DEFAULT NULL,

PRIMARY KEY (uid)

)

Step7:生成任务模板

python datax.py -r {YOUR_READER} -w {YOUR_WRITER}

这里生成数据源为MySQL,写入为postgresql的模板。

修改其中的reader和writer的配置项,将jdbc串以及数据库用户名密码写入。

执行datax.py脚本,开始抽取。

可以观察到记录的条数和源数据库的条数相同,通过SQL查询:

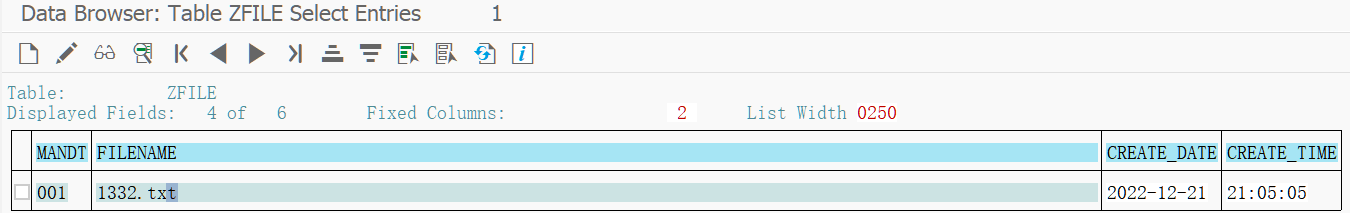

三、使用Datax抽取移动云上的gauss数据库

根据数据源以及gauss(postgresql)为目标端的模板,写入源端和目标端的参数。

这里,由于移动云网络问题,可能会导致写入速度为0。

所以这里仅为了实验工具可行性,只读取一条数据:

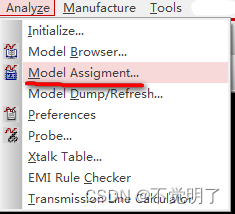

四、Datax工具逻辑说明

整体框架

DataX本身作为离线数据同步框架,采用Framework + plugin架构构建。将数据源读取和写入抽象成为Reader/Writer插件,纳入到整个同步框架中。

1、Reader:Reader为数据采集模块,负责采集数据源的数据,将数据发送给Framework。

2、Writer: Writer为数据写入模块,负责不断向Framework取数据,并将数据写入到目的端。

3、Framework:Framework用于连接reader和writer,作为两者的数据传输通道,并处理缓冲,流控,并发,数据转换等核心技术问题。

核心模板介绍

1、DataX完成单个数据同步的作业,我们称之为Job,DataX接受到一个Job之后,将启动一个进程来完成整个作业同步过程。DataX Job模块是单个作业的中枢管理节点,承担了数据清理、子任务切分(将单一作业计算转化为多个子Task)、TaskGroup管理等功能。

2、DataXJob启动后,会根据不同的源端切分策略,将Job切分成多个小的Task(子任务),以便于并发执行。Task便是DataX作业的最小单元,每一个Task都会负责一部分数据的同步工作。

3、切分多个Task之后,DataX Job会调用Scheduler模块,根据配置的并发数据量,将拆分成的Task重新组合,组装成TaskGroup(任务组)。每一个TaskGroup负责以一定的并发运行完毕分配好的所有Task,默认单个任务组的并发数量为5。

4、每一个Task都由TaskGroup负责启动,Task启动后,会固定启动Reader—>Channel—>Writer的线程来完成任务同步工作。

5、DataX作业运行起来之后, Job监控并等待多个TaskGroup模块任务完成,等待所有TaskGroup任务完成后Job成功退出。否则,异常退出,进程退出值非0。

流程调度

1、DataXJob根据分库分表切分成了100个Task。

2、根据20个并发,DataX计算共需要分配4个TaskGroup。

3、4个TaskGroup平分切分好的100个Task,每一个TaskGroup负责以5个并发共计运行25个Task。

数据库类型插件读、写说明

数据库类型插件,实际是使用jdbc来进行数据的读取插入。

可以看到,在数据写入时,实际是通过一条条的SQl来进行插入的。而读取数据的部分,实际也是通过具体的SQL来进行执行的,可以同过MySQL的日志来查看。

所以,实际的使用过程中,可以将配置文件当作一个SQL来进行编写即可。

如对具体字段的去特殊字符操作,可使用replace函数,以及限制只迁移某个时间段的数据,则可以在where条件中,限制具体的业务字段在某个时间段。

同时,任务要求读写的字段应该一致,通过字段的顺序来达到字段映射的作用。

因此在实际使用的过程中,可以构建一些指定字段,如在多表迁移到一张表的情况下,每张表代表的是某一天的数据。

但是字段中并没有时间字段,则可以构建静态值为字段插入到配置中,来达成多表合一时,做到数据的时序性。

五、Datax工具参数说明

Setting

Setting参数设置的是整体的任务执行的一些配置,如启动几个channel来运行,或者限制具体的速度等。如下:

"speed": {

"channel": 5,

"byte": 1048576,

"record": 10000

}

speed参数为设置具体的速度;

Channel为运行的并发数(最好根据运行机器的物理限制配置,最好不超过32);

Byte为字节流(数据大小);

Record为记录流(即条数);

"errorLimit": {

"record": 0,

"percentage": 0.02

}

errorLimit参数为容错率;

record为允许的错误条数;

percentage为允许的错误率,即整体的任务在出现错误的条数或者错误率超过预设是进行中断报错;

Reader& writer

这里仅介绍通用的字段,如果需要详细的参数配置可以参考

*https://github.com/alibaba/DataX#support-data-channels中的具体文档

jdbcUrl

· 描述:描述的是到对端数据库的JDBC连接信息,使用JSON的数组描述,并支持一个库填写多个连接地址。

之所以使用JSON数组描述连接信息,是因为阿里集团内部支持多个IP探测,如果配置了多个,PostgresqlReader可以依次探测ip的可连接性,直到选择一个合法的IP。如果全部连接失败,PostgresqlReader报错。

注意:jdbcUrl必须包含在connection配置单元中。对于阿里集团外部使用情况,JSON数组填写一个JDBC连接即可。jdbcUrl按照PostgreSQL官方规范,并可以填写连接附件控制信息。

· 必选:是;

· 默认值:无;

username

· 描述:数据源的用户名;

· 必选:是;

· 默认值:无;

password

· 描述:数据源指定用户名的密码;

· 必选:是;

· 默认值:无;

table

· 描述:所选取的需要同步的表。使用JSON的数组描述,因此支持多张表同时抽取。当配置为多张表时,用户自己需保证多张表是同一schema结构,PostgresqlReader不予检查表是否同一逻辑表。注意,table必须包含在connection配置单元中。

· 必选:是

· 默认值:无

colum

· 描述:所配置的表中需要同步的列名集合,使用JSON的数组描述字段信息。用户使用代表默认使用所有列配置,例如['']。

支持列裁剪,即列可以挑选部分列进行导出。支持列换序,即列可以不按照表schema信息进行导出。支持常量配置,用户需要按照PostgreSQL语法格式:

[“id”, “‘hello’::varchar”, “true”, “2.5::real”, “power(2,3)”] id为普通列名,

‘hello’::varchar为字符串常量,true为布尔值,2.5为浮点数, power(2,3)为函数。

注意:column必须用户显示指定同步的列集合,不允许为空!

· 必选:是;

· 默认值:无;

splitPk

· 描述:PostgresqlReader进行数据抽取时,如果指定splitPk,表示用户希望使用splitPk代表的字段进行数据分片。DataX因此会启动并发任务进行数据同步,这样可以大大提供数据同步的效能。推荐splitPk用户使用表主键,因为表主键通常情况下比较均匀,因此切分出来的分片也不容易出现数据热点。

目前splitPk仅支持整形数据切分,不支持浮点、字符串型、日期等其他类型。如果用户指定其他非支持类型,PostgresqlReader将报错!splitPk设置为空,底层将视作用户不允许对单表进行切分,因此使用单通道进行抽取

· 必选:否;

· 默认值:空;

where

· 描述:筛选条件,MysqlReader根据指定的column、table、where条件拼接SQL,并根据这个SQL进行数据抽取。在实际业务场景中,往往会选择当天的数据进行同步,可以将where条件指定为gmt_create > $bizdate 。

注意:不可以将where条件指定为limit 10,limit不是SQL的合法where子句。

· 必选:否

· 默认值:无

querySql

where条件可以有效地进行业务增量同步。where条件不配置或者为空,视作全表同步数据。

· 描述:在有些业务场景下,where这一配置项不足以描述所筛选的条件,用户可以通过该配置型来自定义筛选SQL。当用户配置了这一项之后,DataX系统就会忽略table,column这些配置型,直接使用这个配置项的内容对数据进行筛选。例如需要进行多表join后同步数据,使用select a,b from table_a join table_b on table_a.id = table_b.id

当用户配置querySql时,PostgresqlReader直接忽略table、column、where条件的配置。

· 必选:否;

· 默认值:无;

fetchSize

· 描述:该配置项定义了插件和数据库服务器端,每次批量数据获取条数,该值决定了DataX和服务器端的网络交互次数,能够较大的提升数据抽取性能。

注意,该值过大(>2048)可能造成DataX进程OOM。

· 必选:否;

· 默认值:1024;

session

· 描述: DataX在获取Mysql连接时,执行session指定的SQL语句,修改当前connection session属性

· 必须: 否

· 默认值: 空

preSql

· 描述:写入数据到目的表前,会先执行这里的标准语句。如果 Sql 中有你需要操作到的表名称,请使用 @table 表示,这样在实际执行 Sql 语句时,会对变量按照实际表名称进行替换。

比如你的任务是要写入到目的端的100个同构分表(表名称为:datax_00,datax01, … datax_98,datax_99),并且你希望导入数据前,先对表中数据进行删除操作。那么你可以这样配置:“preSql”:[“delete from 表名”],效果是:在执行到每个表写入数据前,会先执行对应的 delete from 对应表名称。

必选:否;

默认值:无;

postSql

· 描述:写入数据到目的表后,会执行这里的标准语句。(原理同 preSql );

· 必选:否;

· 默认值:无;

writeMode

· 描述:控制写入数据到目标表采用 insert into 或者 replace into 或者 ON DUPLICATE KEY UPDATE 语句;

· 必选:是,所有选项:insert/replace/update;

· 默认值:insert;

batchSize

· 描述:一次性批量提交的记录数大小,该值可以极大减少DataX与Mysql的网络交互次数,并提升整体吞吐量。但是该值设置过大可能会造成DataX运行进程OOM情况。

· 必选:否;

· 默认值:1024;

综上介绍,我们来看一段配置样例:

{

"job": {

"setting": {

"speed": {

"channel": 1

}

},

"content": [

{

"reader": {

"name": "streamreader",

"parameter": {

"column" : [

{

"value": "DataX",

"type": "string"

},

{

"value": 19880808,

"type": "long"

},

{

"value": "1988-08-08 08:08:08",

"type": "date"

},

{

"value": true,

"type": "bool"

},

{

"value": "test",

"type": "bytes"

}

],

"sliceRecordCount": 1000

}

},

"writer": {

"name": "mysqlwriter",

"parameter": {

"writeMode": "insert",

"username": "root",

"password": "root",

"column": [

"id",

"name"

],

"session": [

"set session sql_mode='ANSI'"

],

"preSql": [

"delete from test"

],

"connection": [

{

"jdbcUrl": "jdbc:mysql://127.0.0.1:3306/datax?useUnicode=true&characterEncoding=gbk",

"table": [

"test"

]

}

]

}

}

}

]

}

}

}

总结

今天的分享就到这儿了,希望通过本期全面的介绍后,往后在进行DataX数据迁移的时候,可以参考上述方式,根据实际情况进行操作~!