文章链接: https://arxiv.org/abs/2308.07241

2023年,大型语言模型(LLMs)以及AI Agents的蓬勃发展为整个机器智能领域带来了全新的发展机遇。一直以来,研究者们对具身智能(Embodied Artificial Intelligence)的要求就是通过创建软硬件结合的智能体(例如不同形态的机器人),使其在各种真实物理环境中来执行各种各样的复杂任务,完成人工智能的进化过程。依靠LLMs强大的语言理解和推理能力,可以极大的提升具身智能机器人的工作效率。

本文介绍一篇被计算机视觉顶会ICCV 2023录用的论文,针对现有机器人在环境导航以及与环境目标交互时经常犯错的问题,提出了一种上下文感知规划和环境感知记忆(Context-Aware Planning and Environment-Aware Memory)的具身智能框架CAPEAM,CAPEAM通过设计一系列的代理来将语义上下文(语言指令、交互的对象信息等)纳入机器人的规划序列中,同时考虑交互物体的空间布局和状态变化(例如,物体已移动到的位置),以推断后续行动。基于这样的设计,CAPEAM的代理程序可以在标准的机器人交互指令基准上达到SOTA性能。

01. 介绍

具身智能机器人在工业制造、快递物流、智能家居、高危环境救援等多种场景中都具有良好的应用前景,为了进一步提高工作效率,研究者们开始思考能否制造一种可以精确理解人类语言指令,同时具有自我路径规划和动作执行能力的具身智能机器人呢。为了完成用户指定的各种特定任务,机器人代理首先需要对任务指令进行拆分,并规划出完整的行动序列,其中涉及到与任务特定的相关对象进行交互。然而难点在于,简单的代理程序可能会规划出一些错误行动,例如与任务无关的对象进行交互。例如,如果用户指定任务“把苹果切片放在桌子上”,普通的代理可能会驱动机器人拿起面包片放到桌子上,本文作者认为,出现这种现象的主要原因是这种代理缺乏对任务指令以及当前环境的上下文记忆。

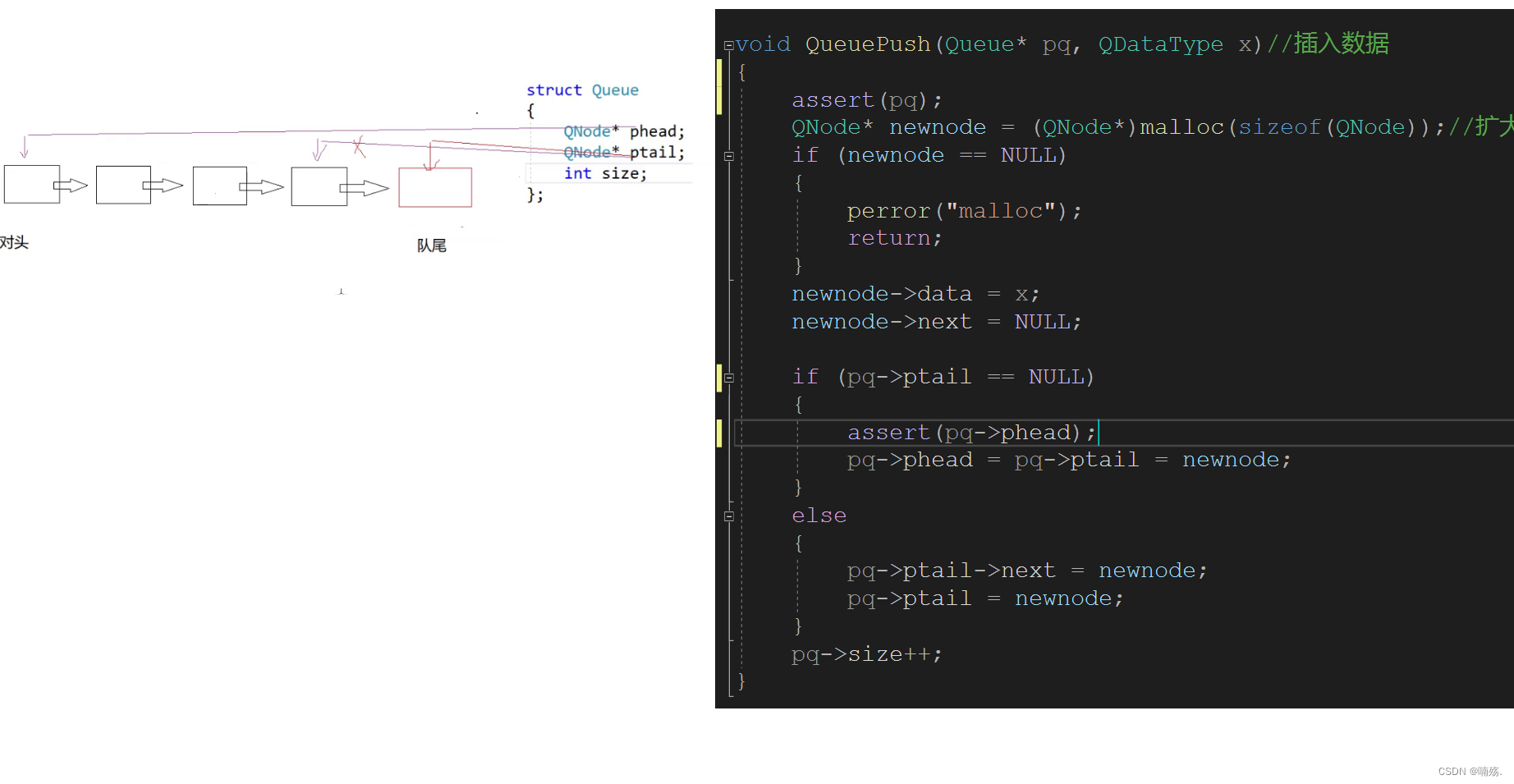

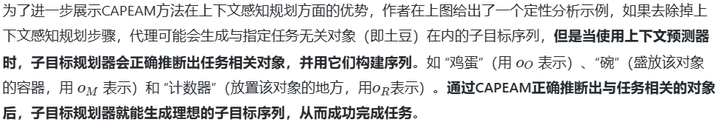

为了解决这个问题,本文作者提出了一种新的CAPEAM方法,将任务规划过程分为两个不同的阶段,首先对任务指令进行拆解并构建上下文信息(指令中涉及到需要交互的对象),随后再根据上下文记忆进行详细行动规划。如上图所示,CAPEAM首先提取任务指令中的上下文对象,随后以这些对象为中心组合出各种可能的子行动目标,再根据细节规划器(Detailed Planners)得到最终的行动序列。

此外作者还考虑到交互对象的状态变化对于任务的正确完成也至关重要,如果代理程序不能及时的跟踪目标的状态(例如,对象是否已被移动),就会导致后续错误的交互。例如上图所示的“将苹果和盘子放在柜子里”任务中,如果代理首先移动了苹果,但是没有记录苹果的新位置信息,在移动盘子时有可能将盘子直接放在苹果上而导致任务失败。因此作者引入了一个环境感知存储器来存储有关对象状态的信息,这种方法允许代理随着时间的推移与处于适当状态的对象进行交互。通过跟踪对象状态和外观,代理可以确保与正确的对象进行交互并执行适当的操作,最终成功地完成任务。

02. 本文方法

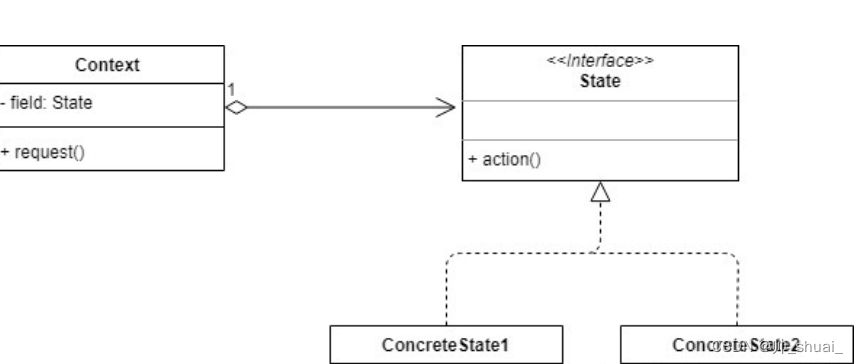

本文提出的CAPEAM框架主要由两个关键模块构成,其整体框架如下图所示,作者分别引入了上下文感知规划模块和环境感知记忆模块,前者可以根据用户指令对任务有关的对象进行上下文建模,后者通过将目标对象状态和环境信息存储在对象掩码和空间记忆池中,实现更加高效的场景导航和物体交互。

2.1 上下文感知规划模块

在接收到用户指定的自然语言指令后,代理程序需要快速的理解和推断出给定任务的要求(例如抓取用户感兴趣的目标对象),随后制定出一个完整的动作序列。为此,作者提出了一种新颖的规划方案,即先将指令拆分成多个“子目标”集合,再在每个子目标的基础上扩展成可以执行的“详细动作序列”。为了保证最终动作序列的合理性,作者在拆分子目标时加入了纠错机制。例如通过上下文预测器(Context Prediction)预测得到当前任务共享的一组任务相关对象,随后与指令拆解得到的上下文信息联合生成子目标集合。随后再通过细节规划器为每个子目标制定结束动作和交互对象。

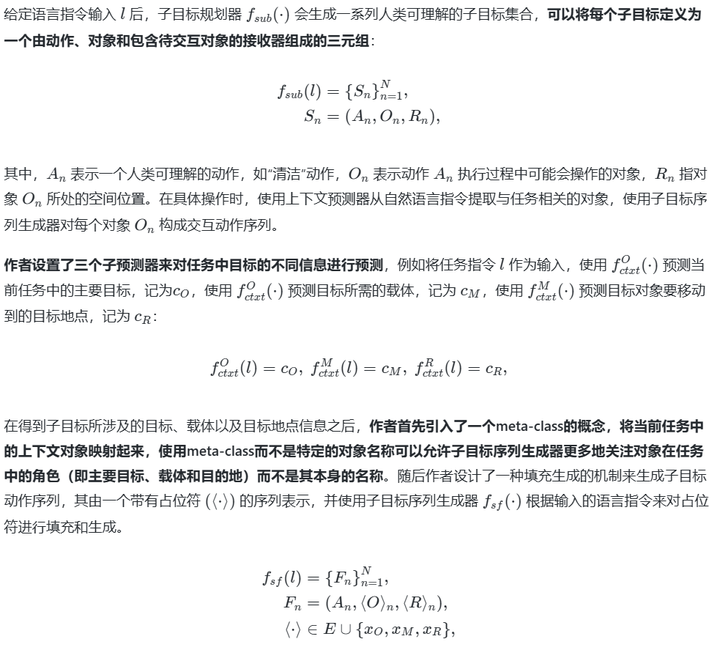

2.1.1 子目标规划器

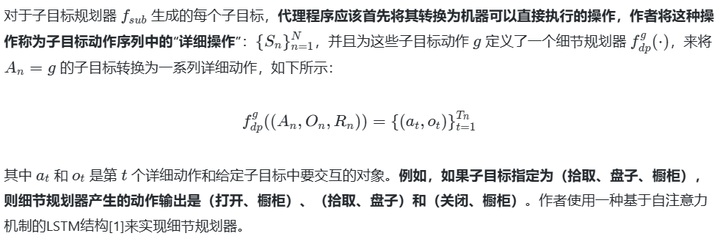

2.1.2 细节规划器

2.2 环境感知记忆模块

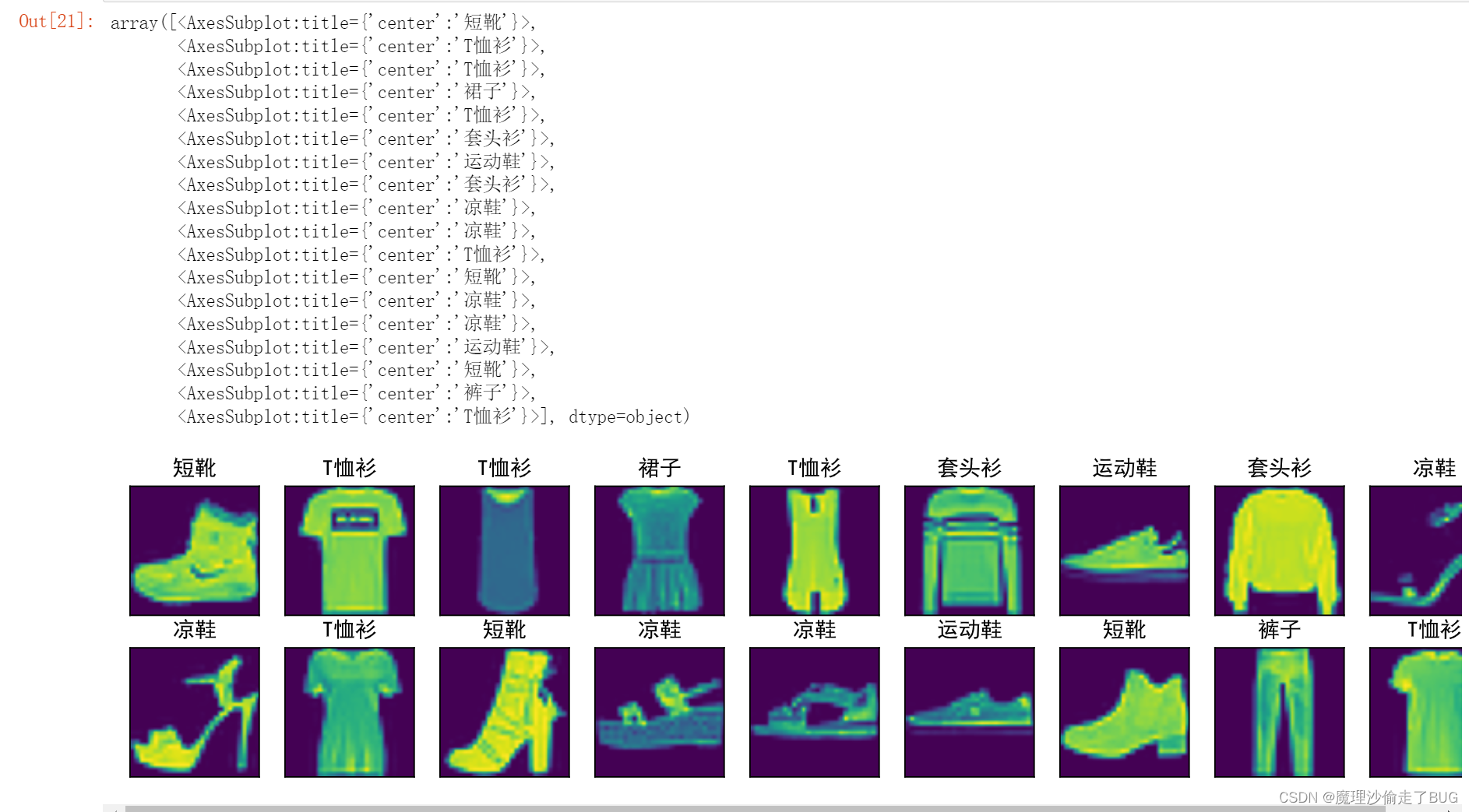

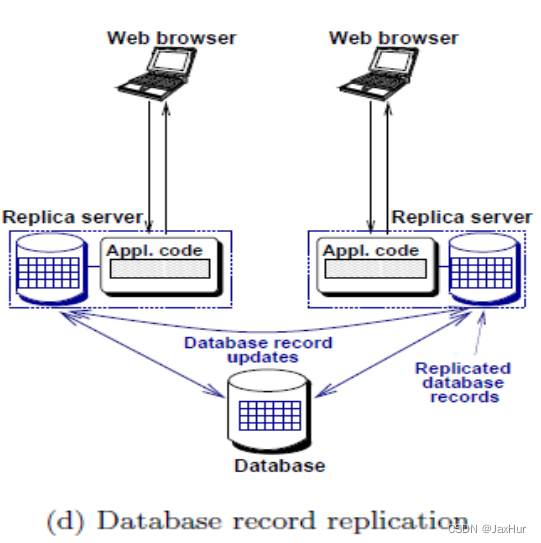

下图展示了环境感知记忆模块的构成细节,代理程序首先根据输入的RGB图像预测得到的深度图像和语义分割图像来构建语义空间图(Semantic Spatial Map),使用深度信息可以更全面的探索周围环境状态,例如障碍物区域、物体位置和类别等。

在一些任务中,机器人可能需要在多个不同的时间步中与同一对象进行交互,在这期间,对象的视觉外观可能由于各种原因(例如遮挡)而改变,因此作者设计了物体回顾识别操作(Retrospective Object Recognition)来对每一时刻的物体mask进行更新,保证多次交互顺利进行。与该操作协同工作的还有对象重定位跟踪(Object Relocation Tracking)操作,其对每个已被移动的目标坐标进行动态更新,这保证代理程序不会对同一目标做出重复的子目标规划。为了减少代理程序对周围环境执行全局扫描的次数,作者使用对象位置缓存操作(Object Location Caching)对每个发生状态变化的对象都进行了空间信息缓存,这使得代理可以记忆每个目标的实际位置,从而实现更加高效的导航和交互。

03. 实验效果

本文的实验在一个极具挑战性的交互式指令基准ALFRED[2]上进行,ALFRED分为训练集、验证集和测试集三部分,为了评估本文方法的泛化能力,作者将验证集和测试集进一步划分为两个部分:可见环境(seen)和不可见环境(unseen)。模型的评价指标遵循ALFRED的标准评估协议。主要指标是成功率,用SR表示,主要衡量模型完成任务的百分比,另一个指标是目标条件成功率,用GC表示,用于衡量满足目标条件的百分比。

作者首先将本文提出的CAPEAM方法与现有的SOTA方法进行对比,对比结果如下表所示,为了对比公平,作者选取了一些同样构建语义空间表征和进行深度估计的方法,其中一些方法使用了高级的任务指令(✗ Low Inst.),并且使用了环境的先验信息和动作模板(✓ Tem. Act.)来生成动作序列。

从上表可以看出,CAPEAM方法在unseen测试中的成功率优于其他所有对比方法,这表明本文方法具有更强的新环境适应能力。在seen测试中,CAPEAM的表现略逊色于Prompter方法[3],作者认为,这是由于Prompter方法中加入了更加精确的空间感知模型来对每个目标的姿态进行了精确估计,这使得模型在训练可见的场景中有更好的表现能力。但是这一现象也侧面展示了本文方法在seen和unseen测试环境之间具有更小的性能差距,表示本文方法可以更好地泛化到未见环境中。

04. 总结

本文提出了一种新型的具身智能代理框架CAPEAM,其中设置了上下文感知规划模块和环境感知记忆模块来将语言任务指令中涉及到的上下文对象纳入动作规划操作中,并且对关键的目标对象进行外观、空间位置等信息的动态更新。通过这些操作,CAPEAM有效的避免了不必要的空间搜索,并且设计了一种从粗到细的子目标动作序列生成机制来改进机器人的整体导航和交互效果。作者通过一系列的实验表明,CAPEAM方法可以有效地提升具身智能代理在不同环境中的快速适应能力,这应该是当前具身智能领域所关注的研究热点。

参考

[1] Alexander Katrompas and Vangelis Metsis. Enhancing lstm models with self-attention and stateful training. In IntelliSys, 2022.

[2] Mohit Shridhar, Jesse Thomason, Daniel Gordon, Yonatan Bisk, Winson Han, Roozbeh Mottaghi, Luke Zettlemoyer, and Dieter Fox. Alfred: A benchmark for interpreting grounded instructions for everyday tasks. In CVPR, 2020.

关于TechBeat人工智能社区

▼

TechBeat(www.techbeat.net)隶属于将门创投,是一个荟聚全球华人AI精英的成长社区。

我们希望为AI人才打造更专业的服务和体验,加速并陪伴其学习成长。

期待这里可以成为你学习AI前沿知识的高地,分享自己最新工作的沃土,在AI进阶之路上的升级打怪的根据地!

更多详细介绍>>TechBeat,一个荟聚全球华人AI精英的学习成长社区